Багато SEO-фахівці в своїй практиці стикалися з небажанням пошукових систем індексувати ті чи інші сторінки сайту, при цьому в 90% випадків причини цих проблем бувають банальні: випадкове закриття сторінок в robots.txt, заборона індексації через meta robots, некоректні канонікли і тому подібні варіанти.

Однак, мало тільки лише знайти і усунути причину некоректної індексації. Після її усунення необхідно якомога швидше відправити на переіндексацію важливий контент і упевнитися в тому, що сайт і сторінки, що цікавлять стали індексуватися.

У цій статті ми поділимося всіма знайденими варіантами індексації сторінок в пошуковій системі Google.

Способи прискорення індексації в Google

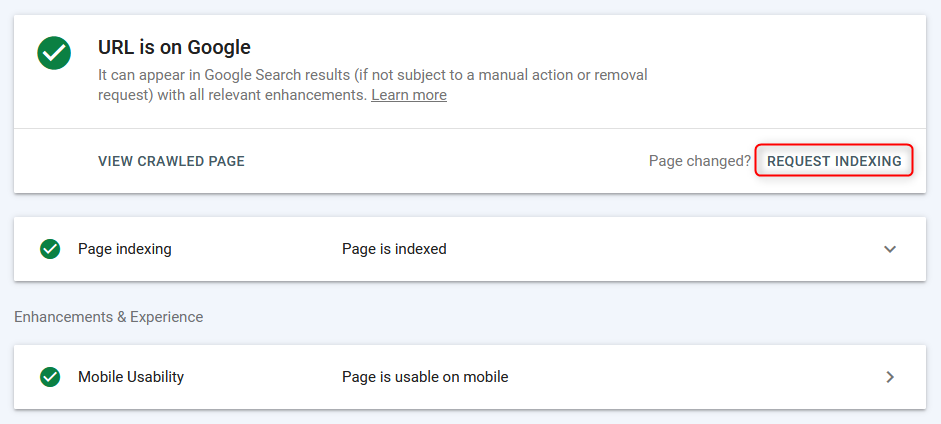

1. Google Search Console (GSC)

Найпоширеніший спосіб індексації / переіндексації сторінок в "ручному" режимі через панель вебмастера Google.

Сторінки індексуються швидко (від декількох секунд до появи в пошуку), однак, робота відбувається в посторінковому режимі + необхідний час на сканування сторінки пошуковим ботом, тому даний спосіб є ефективним, але не найзручнішим, так як не можна завантажити відразу список з групи URL і відправити на масову індексацію.

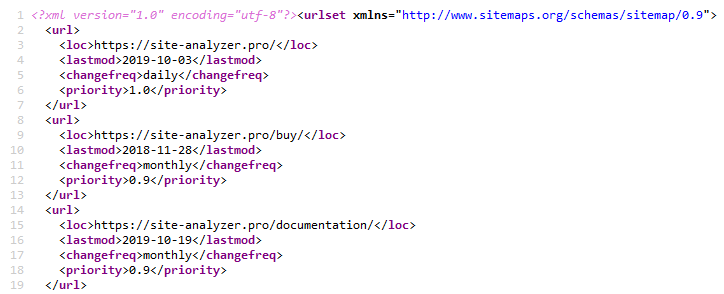

2. Sitemap.xml

Використання XML карти сайту є класичним методом прискорення індексації нових сторінок. Реалізується це через вказівку гіперпосилання на файл карти сайту sitemap.xml у файлі Robots.txt (само собою, перед цим необхідно створити сам файл Sitemap.xml).. Sitemap.xml »

Зазвичай цього буває цілком достатньо для будь-якого типу сайту.

Для створення карти сайту існує безліч різних плагінів на популярних CMS, також її можна створити за допомогою одного з веб - або десктопних краулеров, наприклад, через безкоштовний SiteAnalyzer.. SiteAnalyzer »

3. Пінгування Sitemap.xml

Пінгування змушує пошукового робота зробити оперативний переобхід Вашого Sitemap.xml. Це своєрідний аналог додавання сайтмап в Google Search Console. Таким чином, ми відправляємо Google додатковий сигнал про необхідність переобходу карти сайту, що, тим самим, прискорює ймовірність індексації сторінок (однак, не факт, що бот їх відразу рвонеться обходити).

Посилання для пінгування сайтмап в Google і Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Встановлення 301 редиректу зі сторінок трафікового сайту

Дане рішення дозволяє частково перенести статичну вагу і трафік з якісного сайту на сайт, для якого потрібна більша увага пошукових ботів, або є проблеми з його індексацією.

Я ставив редирект зі сторінки "Новини" сайту з хорошим трафіком на аналогічну сторінку сайту, у якого були проблеми з індексацією. Редирект був "врахований" Google вже на другий день і сторінка сайту-донора зникла з індексу гугла.

Після того, як сторінка сайту-акцептора буде проіндексована, редирект можна прибирати.

5. Видалення сайту з вебмайстра Google і додавання сайту заново

Ідея була в тому, щоб пошуковик звернув «увагу» на сайт і, тим самим, знову пройшовся по сторінках.

Експеримент не спрацював, так як при повторному додаванні проекту в ньому відразу відображався robots.txt і інші раніше застосовані настройки - мабуть при видаленні сайт просто зник зі списку, а потім при повторному «додаванні» його відобразили знову.

6. Повне закриття сайту від індексації

Закриваємо сайт від Google в robots.txt для повної деіндексації.

На момент тестування в індексі бовталася» перша " версія сторінки з WWW і без збереженої копії (молодий сайт). На виявлення оновленої версії robots.txt Google знадобилося 1-2 години. Через 2 дні єдина раніше проіндексована сторінка зникла з індексу. У сайту залишилося 0 сторінок в пошуку гугла.

Після повної деіндексації було відкрито robots.txt для бота Google.

Однак, судячи з логам, бот як заходив один раз в день, так один раз в день заходити і продовжив. За великим рахунком частота відвідувань сайту ботом Google не змінилася.

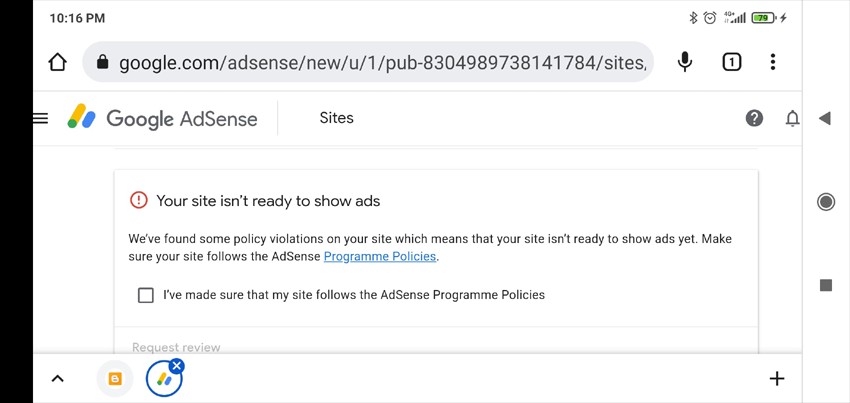

7. Додавання реклами в Google AdSense

Зазвичай, якщо сайт не проходить модерацію в Google AdSense, то в особистому кабінеті з'являється список можливих причин, чому не прийняли сайт (перевірка займає до двох тижнів, у мене це зайняло півтори). Дана інформація може допомогти з визначенням причин, що не так з сайтом.

Що взагалі-то і сталося-сайт не прийняли з позначкою «малокорисний контент».

Не думаю, що низький рівень індексації сайту був пов'язаний саме з цим. Але, принаймні, ми отримали більш-менш розумну відповідь, яка може стати в нагоді іншим разом (наприклад, для визначення санкцій, накладених на сайт).

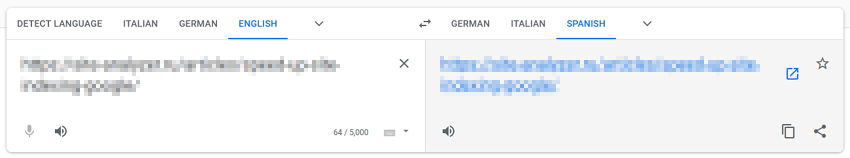

8. Переобход через Google Translate

Даний метод заснований на припущенні про те, що «проганяючи» сторінки через сервіси Google, ми звертаємо на них додаткову увагу пошукових ботів.

Вставляємо URL сайту в Google Перекладач, переходимо за посиланням з перекладом сторінки, схрещуємо пальці і сподіваємося на диво.

У моєму випадку дива не сталося.

9. Направляємо трафік з соцмереж і Телеграм

Для прискорення індексації сайту можна ділитися публікаціями в соціальних мережах (Twitter, Facebook, Linkedin і т.п.), або шляхом розміщення постів в Telegram (по суті, це те ж саме, що і залучення трафіку з соцмереж, проте відбувається шляхом розміщення посилань на сайт з рекламних постів на тематичних каналах).

На поточний момент посилання з соцмереж не індексуються пошуковими системами і не враховуються в ранжируванні, тому даний варіант прискорення індексації сайту швидше за все буде не ефективний, однак, це може залучити на сайт «живий» трафік, за рахунок якого пошукові боти стануть заходити на нього частіше і індексувати більше контенту.

10. Трафік з контексту

Створюємо рекламні кампанії в Google AdWords і направляємо трафік на посадочні сторінки для більш швидкої їх індексації, щоб пошукові боти частіше відвідували сторінки сайту, збільшуючи, тим самим, ймовірність їх індексації.

11. Перевірка оптимізації для мобільних в Google Search Console

Використовуємо сторінку тестування мобільної версії сайту для вказівки боту про нові сторінки: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Знову ж таки, гіпотеза про те, що посилаючи Google додатковий сигнал для переобходу сторінок сайту через інструмент тестування мобільної версії, він зверне на сайт більш пильну увагу. Однак не впевнений, що це дає хоч якийсь відчутний результат.

12. Трафік з Pinterest

Pinterest є популярним контентним майданчиком на заході, що робить його привабливим не тільки для відвідувачів, але і для ботів пошукових систем. На ньому постійно «мешкають» пошукові боти, особливо Бот Google, тому шляхом нескладного створення пінів, можна направити бота Google на цікаві сторінки сайту.

У моєму випадку це не дало результатів.

13. Прогін через масові індексатори, засновані на вкладках браузера Google Chrome

На скільки я знаю, якщо ця тема колись і працювала (сервіс IndexGator і його аналоги), то зараз вона абсолютно мертва.

Та й за логами сервера - після подібної індексації робот на сайт не заходив.

14. Створення Sitemap.txt

Файл Sitemap.txt є спрощеним варіантом карти сайту Sitemap.xml. По суті, це все той же список URL сайту, але без вказівки додаткових атрибутів (lastmod, priority, frequency).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Даний варіант менш поширений, ніж звичайний sitemap.xml, але, тим не менш, при додаванні посилання на нього в robots.txt, боти починають його сканувати не менш охоче, ніж звичайний Sitemap.

15. Внутрішня перелинковка

Прискорення індексації за рахунок проставлення посилань на нові сторінки сайту з «хабових» сторінок (сторінки з великим трафіком / вагою).

Зазвичай для цього пишеться скрипт, який бере пачки непроіндексованих посилань із заздалегідь підготовленого списку і розміщує їх на особливо відвідуваних сторінках. Після індексації сторінок розміщується наступний блок посилань, і так далі. Індексація перевіряється через різні сервіси або через API Google Webmaster Tools.

16. Нарощування зовнішньої посилальної маси

Google визнає, що сторінки заслуговують довіри, якщо на них ведуть посилання з авторитетних сайтів.

Наявність зворотних посилань говорить Google про те, що сторінки є важливими і їх слід проіндексувати.

Таким чином, нарощуючи якісну зовнішню посилальну масу на сторінки, що просуваються і на сайт в цілому можна сигналізувати Google про те, що даному сайту необхідно більше приділяти уваги і частіше краулить контент.

17. Креативний метод за допомогою Flickr (кейс Viktor Karpenko)

Створюємо аккаунт на фотохостингу Flickr, завантажуємо туди багато фотографій (тисячі, а краще десятки тисяч) - фото беремо не важливо звідки, можна навіть використовувати інші фотохостинги, Instagram і т. п.

Під кожним фото пишемо, що при використанні фото потрібно ставити зворотне посилання на просувається Вами сайт (не забуваємо згадати його URL).

В результаті можна безкоштовно отримувати трафік і десятки посилань щомісяця з хороших сайтів і ЗМІ.

Примітка. Приклад більше відноситься до лінкбілдінгу, але також і дозволяє направити трафік на певні сторінки вашого сайту і тим самим поліпшити їх індексацію.

18. Індексація за допомогою Google Indexing API

Вичавка інструкції для PHP від користувача Махмуд:

- Реєструємо сервісний аккаунт в Google Cloud, отримуємо ключ доступу (файл json), даємо права сервісного аккаунта на серчконсоль, включаємо API в Google Cloud.

- Створюємо скрипт на PHP, з якого будуть додаватися URL в індекс.

- Качаємо з GitHub клієнт для роботи з апі: https://github.com/googleapis/google-api-php-client

- Код для пакетного додавання запитів:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- У відповідь $batch->execute() надсилає масив за кількістю посилань у запиті (якщо у відповіді є \Google\Service\Exception, то код 429 - перевищення ліміту, 403 - проблеми з ключем доступу або включенням api, 400 - криві дані).

- Посилання на опис помилок: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- Не забуваємо зв'язати аккаунт API з консоллю гугла + виставити себе власником (Owner), інакше скрипт не буде працювати (в масиві буде приходити помилка 404, що немає доступу для індексації сайту - Permission denied. Failed to verify the URL ownership).

Примітка: на написання скрипта у мене пішло ~40 хвилин, включаючи час на дрібні «затики» і гугление помилок.

19. Блокування доступу боту Google (кейс Vladimir Vershinin)

Помітив, що погано додаються на одному з проектів документи в індекс Google. Крутили, крутили - все без толку.

За непрямими ознаками виникла гіпотеза, що боти не можуть отримати щось з ресурсів, так як відсікаються на рівні сервісу по захисту від DDoS.

Ми додали перелік / ipranges / в вайтлист сервісу захисту від DDoS 26 числа, і вже 27-го отримали +50к документів в індексі, а на поточний момент за 15 днів вже +300к документів в індексі.

Велика частина» влетіли "документів лежала в GSC як»Проскановано, але поки не проіндексовано".

Посилання на діапазон IP-адрес ботів Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Написати Джону Мюллеру

Написати в Твіттер Джону Мюллеру, описати свою проблему, схрестити пальці і чекати відповіді. Twitter »

У моєму випадку це не спрацювало, мені ніхто не відповів, нових сторінок в індексі не з'явилося. Дивно, звичайно, ну і добре.

Але, хто знає, можливо вам пощастить )

***

Схоже, більше не залишилося відомих варіантів прискорення індексації як нових, так і старих сторінок. Однак, якщо раптом я щось упустив, прошу поділитися власними кейсами і прикладами в коментарях - із задоволенням доповню ними статтю.

P.S. IndexNow. Для повного охоплення теми варто згадати відносно нову можливість масової індексації сторінок через IndexNow (відкрите API з можливістю додавання в індекс пошукових систем до 10 000 сторінок в день). В даний час підтримуються пошукові системи Яндекс і Bing. Можливо, що приєднання пошукової системи Google до даної технології не за горами, хоча, якщо вже зараз у технології виникла невелика армія критиків, хто знає, чи отримає вона розвиток в майбутньому.

Iнші статті

949

949