Muitos especialistas em SEO em sua prática enfrentaram a relutância dos mecanismos de busca em indexar certas páginas do site, enquanto em 90% dos casos as causas desses problemas são banais: fechamento acidental de páginas em robots.txt, proibição de indexação via meta robots, canonicles incorretos e opções semelhantes.

No entanto, não basta apenas encontrar e eliminar a causa da indexação incorreta. Depois de eliminá-lo, você deve re-indexar o conteúdo importante o mais rápido possível e garantir que o site e as páginas de interesse sejam indexadas.

Neste artigo, compartilharemos todas as opções de indexação de páginas encontradas no mecanismo de pesquisa do Google.

Como acelerar a indexação no Google

1. Google Search Console (GSC)

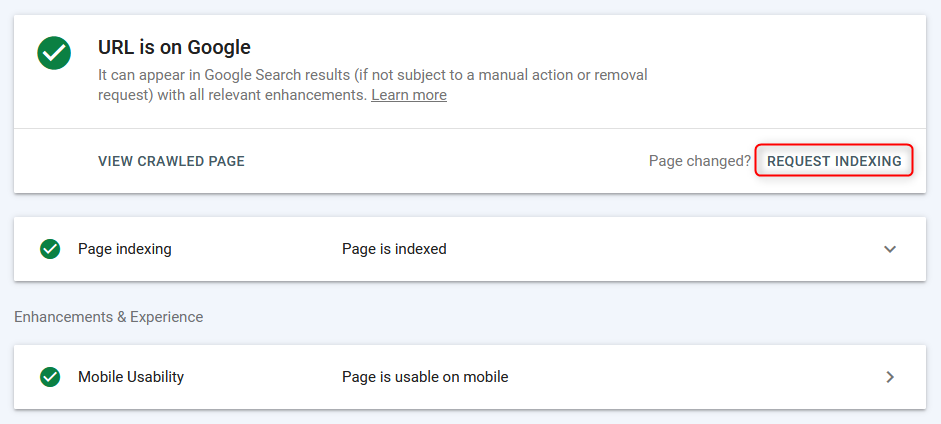

A maneira mais comum de indexar / reindexar páginas no modo "manual" é através do painel do webmaster do Google.

As páginas são indexadas rapidamente (a partir de alguns segundos antes de aparecer na pesquisa), no entanto, o trabalho ocorre no modo de página + leva tempo para o bot de pesquisa rastrear a página, portanto, esse método é eficaz, mas não o mais conveniente, pois você não pode baixar imediatamente a lista do grupo URL e enviá-la para indexação em massa.

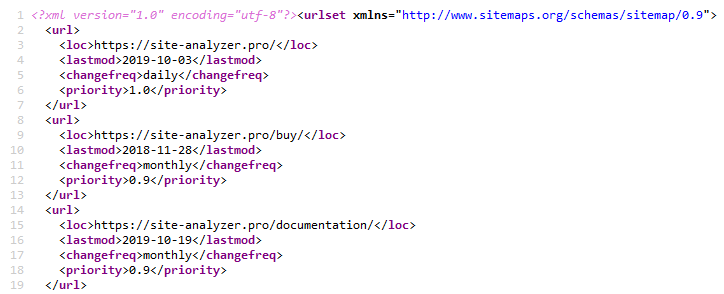

2. Sitemap.xml

O uso de um Sitemap XML é um método clássico para acelerar a indexação de novas páginas. Isso é implementado especificando um hiperlink para o arquivo de Sitemap do Sitemap.xml no arquivo Robots.txt (é claro que você precisa criar o próprio Sitemap antes disso.xml).. Sitemap.xml »

Isso geralmente é suficiente para qualquer tipo de site.

Para criar um mapa do site, existem muitos plugins diferentes no CMS popular, também pode ser criado usando um dos crawlers da Web ou desktop, por exemplo, através do SiteAnalyzer gratuito.. SiteAnalyzer »

3. Ping Sitemap.xml

O ping faz com que o robô de busca faça uma transição rápida do seu Sitemap.xml. Esta é uma espécie de análogo da adição de sitemap no Google Search Console. Assim, enviamos ao Google um sinal adicional de que o sitemap precisa ser revisado, o que acelera a probabilidade de indexação das páginas (no entanto, não é um fato que o bot corra para contorná-las imediatamente).

Links para sites de pingmap no Google e Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Instalando redirecionamentos 301 das páginas do site de tráfego

Essa solução permite que você transfira parcialmente o peso estático e o tráfego de um site de qualidade para um site que exija mais atenção dos bots de pesquisa ou tenha problemas para indexá-lo.

Eu coloquei um redirecionamento da Página "notícias" de um site com bom tráfego para uma página semelhante de um site que tinha problemas de indexação. O redirecionamento foi "contabilizado" pelo Google no segundo dia e a página do site doador desapareceu do índice do Google.

Depois que a página do site de Aceitação for indexada, o redirecionamento poderá ser removido.

5. Remover o site do Google Webmaster e adicionar o site novamente

A ideia era que o mecanismo de busca prestasse "atenção" ao site e, assim, passeasse pelas Páginas novamente.

O experimento não funcionou porque, ao adicionar o projeto novamente, ele exibia imediatamente robots.txt e outras configurações aplicadas anteriormente-aparentemente, ao excluir o site simplesmente desapareceu da lista e, em seguida, ao "adicionar" novamente, ele foi exibido novamente.

6. Fechamento completo do site da indexação

Fechar o site do Google em robots.txt para desindexação completa.

No momento do teste, o índice exibia a "primeira" versão da página com WWW e sem uma cópia salva (site jovem). Para encontrar uma versão atualizada de robots.o txt do Google levou de 1 A 2 horas. Após 2 dias, a única página indexada anteriormente desapareceu do Índice. O site tem 0 páginas na pesquisa do Google.

Após a desindexação completa, robots foi aberto.txt para o bot do Google.

No entanto, a julgar pelos registros, o bot costumava entrar uma vez por dia, então uma vez por dia ele voltava e continuava. Em geral, a frequência de visitas ao site pelo bot do Google não mudou.

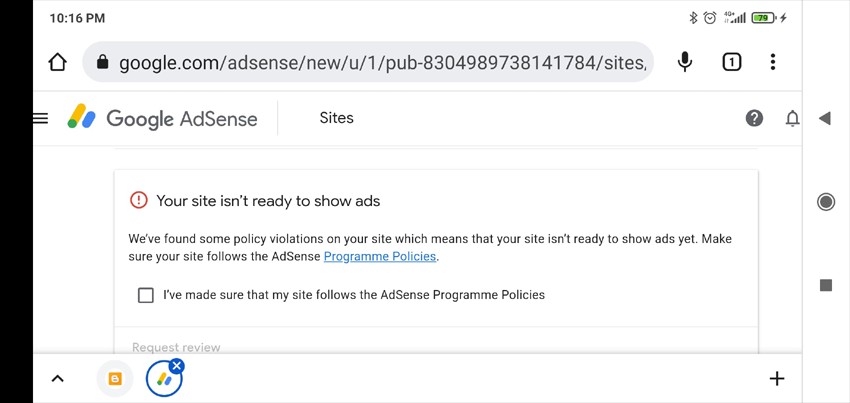

7. Adicionar anúncios ao Google AdSense

Normalmente, se o site não for moderado no Google AdSense, uma lista de possíveis razões pelas quais o site não foi aceito aparece na minha conta pessoal (a verificação leva até duas semanas, levei uma e meia). Essas informações podem ajudar a identificar as causas do que está errado com o site.

O que aconteceu foi que o site não foi aceito com a etiqueta "conteúdo pouco útil".

Eu não acho que o baixo nível de indexação do site tenha sido relacionado a isso. Mas, pelo menos, recebemos uma resposta mais ou menos sensata, que pode ser útil em outro momento (por exemplo, para determinar as sanções impostas ao site).

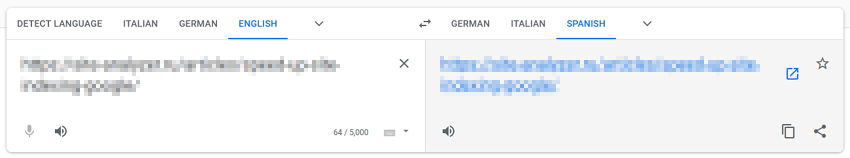

8. Usando o Google Translate

Este método baseia-se na suposição de que, ao "dirigir" páginas através dos serviços do Google, prestamos atenção adicional aos bots de pesquisa.

Inserimos o URL do site no Google Tradutor, clicamos no link com a tradução da página, cruzamos os dedos e esperamos por um milagre.

No meu caso, o milagre não aconteceu.

9. Direcionamos o tráfego de redes sociais e Telegram

Para acelerar a indexação do site, você pode compartilhar publicações em redes sociais (Twitter, Facebook, Linkedin, etc.) ou postando postagens no Telegram (na verdade, isso é o mesmo que atrair tráfego de redes sociais, mas ocorre colocando links para o site de postagens publicitárias em canais temáticos).

No momento, os links de redes sociais não são indexados pelos mecanismos de pesquisa e não são levados em consideração na classificação, portanto, essa opção para acelerar a indexação do site provavelmente não será eficaz, no entanto, isso pode atrair tráfego "ao vivo" para o site, devido ao qual os bots de pesquisa entrarão nele com mais frequência e indexarão mais conteúdo.

10. Tráfego do contexto

Criamos campanhas publicitárias no Google AdWords e direcionamos o tráfego para as páginas de destino para indexá-las mais rapidamente, para que os bots de pesquisa visitem as páginas do site com mais frequência, aumentando assim a probabilidade de indexação.

11. Verificação de otimização para dispositivos móveis no Google Search Console

Usamos a página de teste da versão móvel do site para informar ao bot sobre novas páginas: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Mais uma vez, a hipótese de que, ao enviar um sinal adicional ao Google para navegar pelas Páginas do site por meio de uma ferramenta de teste móvel, ele prestará mais atenção ao site. No entanto, Não tenho certeza se isso dá pelo menos algum resultado tangível.

12. Tráfego do Pinterest

O Pinterest é um site de conteúdo popular no Ocidente, o que o torna atraente não apenas para os visitantes, mas também para os bots dos mecanismos de pesquisa. Os bots de pesquisa, especialmente o bot do Google, são constantemente "hospedados", por isso, com a criação simples de pins, você pode direcionar o bot do Google para as páginas de interesse do seu site.

No meu caso, não deu resultado.

13. Executar através de indexadores em massa baseados em guias do navegador Google Chrome

Tanto quanto eu sei, se esse tópico já funcionou (o serviço IndexGator e seus análogos), agora está absolutamente morto.

E de acordo com os logs do servidor - após tal indexação, o robô não visitou o site.

14. Criação De Sitemaps.txt

Arquivo Sitemap.txt é uma versão simplificada do sitemap.xml. Basicamente, esta é a mesma lista de URLs do site, mas sem especificar atributos adicionais (lastmod, priority, frequency).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Esta opção é menos comum do que o Sitemap normal.xml, mas, no entanto, quando você adiciona uma referência a ele em robots.txt, os bots começam a digitalizá-lo não menos prontamente do que um Sitemap normal.

15. Ligação interna

Acelerar a indexação, colocando links para novas páginas do site a partir de páginas" centrais " (páginas com alto tráfego / peso).

Normalmente, um script é escrito para isso, que pega pacotes de links não indexados de uma lista pré-preparada e os coloca em páginas especialmente visitadas. Depois que as páginas são indexadas, o próximo bloco de links é colocado, e assim por diante. A indexação é verificada através de vários serviços ou através da API do Google Webmaster Tools.

16. Aumento da massa de referência externa

O Google reconhece que as páginas são confiáveis se tiverem links de sites respeitáveis.

Ter backlinks diz ao Google que as páginas são importantes e devem ser indexadas.

Assim, ao construir uma massa de links externos de alta qualidade para as páginas promovidas e para o site como um todo, você pode sinalizar ao Google que esse site precisa prestar mais atenção e roubar conteúdo com mais frequência.

17. Método criativo com o Flickr (caso Viktor Karpenko)

Criamos uma conta no Flickr, carregamos muitas fotos (milhares, ou melhor, dezenas de milhares) - não importa de onde, você pode até usar outros sites de compartilhamento de fotos, Instagram, etc.

Abaixo de cada foto, escrevemos que, ao usar a foto, você precisa colocar um link de volta para o site promovido (não esqueça de mencionar sua URL).

Como resultado, é possível obter tráfego e dezenas de links mensalmente de bons sites e mídia.

Observação. O exemplo refere-se mais ao link building, mas também permite direcionar o tráfego para determinadas páginas do seu site e, assim, melhorar sua indexação.

18. Indexação com a API de indexação do Google

Instruções de aperto para PHP do Usuário Mahmoud:

- Registramos uma conta de serviço no Google Cloud, obtemos uma chave de acesso (arquivo json), damos direitos à conta de serviço no Console do rastreamento, incluímos a API no Google Cloud.

- Criamos um script em PHP a partir do qual o URL será adicionado ao índice.

- Baixar com Github cliente para trabalhar com API: https://github.com/googleapis/google-api-php-client

- Código para adicionar pedidos em lote:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- Em resposta, $batch->execute() envia uma matriz pelo número de links por solicitação (se a resposta tiver \Google\Service\Exception, então o código 429 é sobre o limite, 403 é sobre problemas com a chave de acesso ou inclusão da api, 400 é dados de curvas).

- Link para a descrição dos erros: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- Não se esqueça de vincular a conta da API ao console do Google + para se apresentar como proprietário (Owner), caso contrário, o script não funcionará (o erro 404 chegará à matriz, que não tem acesso para indexar o site - Permissão negada. Failed to verify the URL ownership).

Nota: eu levei ~40 minutos para escrever o script, incluindo tempo para pequenos "engates" e erros no Google.

19. Bloqueio de acesso ao bot do Google (caso Vladimir Vershinin)

Notei que os documentos são mal adicionados em um dos projetos ao índice do Google. Rodopiavam, rodopiavam, tudo em vão.

Por razões indiretas, surgiu a hipótese de que os bots não podem obter algo dos recursos, pois são cortados no nível do serviço de proteção contra DDoS.

Adicionamos a lista/ ipranges / à lista de permissões do serviço de proteção contra DDoS no dia 26, e já no dia 27 recebemos +50K documentos no índice, e no momento em 15 dias já +300k documentos no índice.

A maioria dos documentos" vazados "estava no GSC como"escaneados, mas ainda não indexados".

Link para o intervalo de endereços IP dos bots do Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Escreva Para John Mueller

Escreva para John Mueller no Twitter, descreva seu problema, cruze os dedos e espere por uma resposta. Twitter »

No meu caso, isso não funcionou, ninguém me respondeu, Não houve novas páginas no índice. Estranho, Claro, mas tudo bem.

Mas, quem sabe, você pode ter sorte )

***

Parece que não há mais opções conhecidas para acelerar a indexação de páginas novas e antigas. No entanto, se de repente eu perdi alguma coisa, por favor, compartilhe seus próprios casos e exemplos nos comentários-com prazer adicioná - los ao artigo.

P.S. IndexNow. Para cobrir completamente o tópico, vale a pena mencionar a relativamente nova capacidade de indexação de páginas em massa via IndexNow (uma API aberta com a capacidade de adicionar até 10.000 páginas por dia ao índice dos mecanismos de pesquisa). Atualmente, os motores de busca Yandex e Bing são suportados. É possível que a adesão do mecanismo de pesquisa do Google a essa tecnologia não esteja longe, embora, se a tecnologia já tenha um pequeno exército de críticos, quem sabe se ela será desenvolvida no futuro.

Outros artigos

1,194

1,194