Viele SEO-Experten sind in ihrer Praxis mit der Zurückhaltung von Suchmaschinen konfrontiert, bestimmte Seiten der Website zu indizieren, und in 90% der Fälle sind die Gründe für diese Probleme banal: das versehentliche Schließen von Seiten in robots.txt, Verbot der Indizierung durch Meta-Roboter, falsche Kanoniken und ähnliche Optionen.

Es ist jedoch nicht genug, um nur die Ursache für die falsche Indizierung zu finden und zu beseitigen. Sobald diese entfernt wurde, müssen Sie wichtige Inhalte so schnell wie möglich zur Neuindizierung einreichen und sicherstellen, dass die Website und die Seiten von Interesse indiziert wurden.

In diesem Artikel teilen wir alle gefundenen Optionen für die Indizierung von Seiten in der Google-Suchmaschine.

Möglichkeiten, die Indizierung in Google zu beschleunigen

1. Google Search Console (GSC)

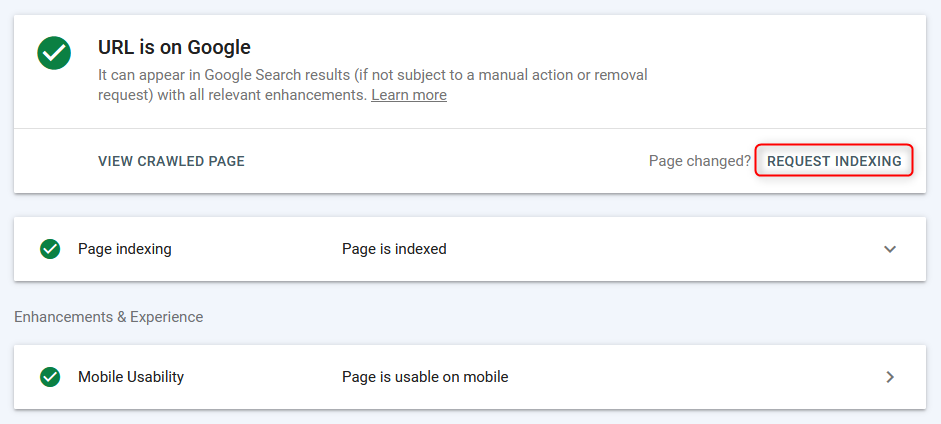

Die gebräuchlichste Methode zum Indizieren / Neuindizieren von Seiten im «manuellen" Modus ist das Google Webmaster-Dashboard.

Die Seiten werden schnell indiziert (einige Sekunden vor dem Erscheinen in der Suche), die Arbeit erfolgt jedoch seitenweise + Es wird Zeit benötigt, um die Seite vom Suchbots zu scannen, daher ist diese Methode effektiv, aber nicht die bequemste, da Sie die Liste nicht sofort aus der URL-Gruppe laden und zur Massenindizierung senden können.

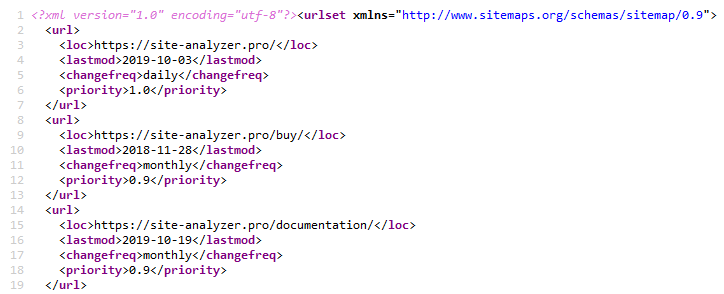

2. Sitemap.xml

Die Verwendung einer XML-Sitemap ist eine klassische Methode, um die Indizierung neuer Seiten zu beschleunigen. Dies wird durch Angabe eines Hyperlinks zu einer Sitemap-Sitemap-Datei implementiert.xml in der Robots-Datei.txt (natürlich müssen Sie vorher eine Sitemap selbst erstellen.xml).. Sitemap.xml »

Dies ist normalerweise für jede Art von Website ausreichend.

Es gibt viele verschiedene Plugins auf beliebten CMS, um eine Sitemap zu erstellen, und Sie können sie auch mit einem der Web- oder Desktop-Crowler erstellen, zum Beispiel über den kostenlosen SiteAnalyzer.. SiteAnalyzer »

3. Pingen der Sitemap.xml

Das Ping-Verhalten bewirkt, dass der Suchroboter Ihre Sitemap schnell umbringt.xml. Dies ist eine Art Analogon des Hinzufügens eines Sitemaps zur Google Search Console. Daher senden wir Google ein zusätzliches Signal, dass die Sitemap erneut überprüft werden muss, wodurch die Wahrscheinlichkeit einer Indexierung der Seiten beschleunigt wird (es ist jedoch nicht die Tatsache, dass der Bot sie sofort umgehen wird).

Google- und Bing-Sitemap-Ping-Links:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Einrichten einer 301-Weiterleitung von den Seiten einer Verkehrswebsite

Diese Lösung ermöglicht es Ihnen, statisches Gewicht und Traffic teilweise von einer qualitativ hochwertigen Website auf eine Website zu übertragen, die mehr Aufmerksamkeit von Suchmaschinen erfordert oder Probleme mit der Indizierung hat.

Ich habe eine Umleitung von der News-Seite einer Website mit gutem Traffic auf eine ähnliche Seite einer Website mit Indizierungsproblemen gestellt. Die Umleitung wurde bereits am zweiten Tag von Google «berücksichtigt» und die Seite der Spenderwebsite ist aus dem Google-Index verschwunden.

Nachdem die Seite der Akzeptor-Website indiziert wurde, kann die Umleitung entfernt werden.

5. Entfernen einer Website aus dem Google-Publisher und erneutes Hinzufügen einer Website

Die Idee war, dass die Suchmaschine «Aufmerksamkeit» auf die Website lenkte und dadurch wieder durch die Seiten ging.

Das Experiment hat nicht funktioniert, da beim erneuten Hinzufügen des Projekts sofort Robots angezeigt wurden.txt und andere zuvor angewendete Einstellungen - anscheinend ist die Website beim Löschen einfach aus der Liste verschwunden, und dann wurde sie beim erneuten Hinzufügen erneut angezeigt.

6. Vollständige Schließung der Website durch Indizierung

Wir schließen die Website von Google in robots.txt für die vollständige Dekodierung.

Zum Zeitpunkt des Tests war die «erste» Version der Seite mit WWW und ohne gespeicherte Kopie im Index (junge Seite). Um eine aktualisierte Version von robots zu erkennen.Google txt dauerte 1-2 Stunden. Nach 2 Tagen ist die einzige zuvor indizierte Seite aus dem Index verschwunden. Die Website hat noch 0 Seiten bei der Google-Suche.

Nach vollständiger Dekodierung wurde robots geöffnet.txt für den Google-Bot.

Nach den Protokollen ging der Bot jedoch einmal am Tag ein, also ging er einmal am Tag ein und fuhr fort. Im Großen und Ganzen hat sich die Häufigkeit der Besuche der Website durch den Google-Bot nicht geändert.

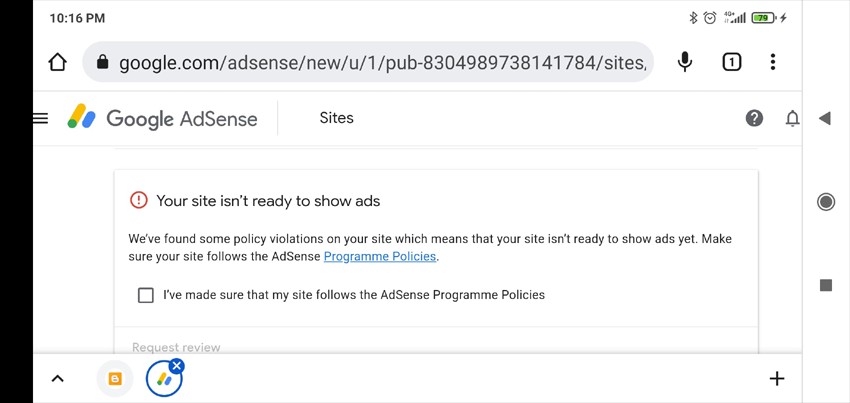

7. Hinzufügen von Anzeigen zu Google AdSense

Wenn eine Website in Google AdSense nicht moderiert wird, wird in der Regel eine Liste möglicher Gründe angezeigt, warum sie die Website nicht akzeptiert haben (die Überprüfung dauert bis zu zwei Wochen, es hat anderthalb Jahre gedauert). Diese Informationen können helfen, die Gründe zu identifizieren, die mit der Website nicht stimmen.

Was im Allgemeinen passiert ist - die Website wurde nicht mit der Aufschrift «wenig nützlicher Inhalt» akzeptiert.

Ich glaube nicht, dass das niedrige Indexierungsniveau der Website damit verbunden war. Aber zumindest haben wir eine mehr oder weniger vernünftige Antwort erhalten, die ein anderes Mal nützlich sein könnte (zum Beispiel, um die auf der Website verhängten Sanktionen zu bestimmen).

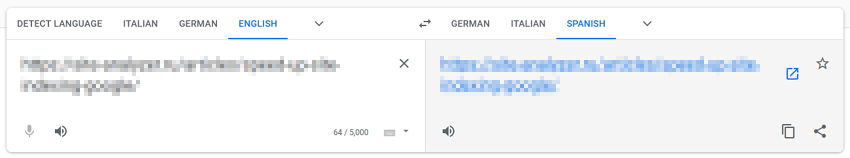

8. Umrüsten über Google Translate

Diese Methode basiert auf der Annahme, dass wir durch das «Durchlaufen» von Seiten durch Google-Dienste zusätzliche Aufmerksamkeit von Suchbots auf sie lenken.

Wir fügen die URL der Website in Google Übersetzer ein, klicken auf den Link mit der Übersetzung der Seite, drücken die Daumen und hoffen auf ein Wunder.

In meinem Fall ist kein Wunder passiert.

9. Wir leiten den Verkehr aus sozialen Netzwerken und Telegrammen

Um die Indexierung der Website zu beschleunigen, können Sie Beiträge in sozialen Netzwerken (Twitter, Facebook, Linkedin usw.) teilen oder Beiträge in Telegram posten (dies ist im Wesentlichen dasselbe wie die Anziehung von Traffic aus sozialen Netzwerken, geschieht jedoch durch die Platzierung von Links zu einer Website aus Werbeeinträgen auf thematischen Kanälen).

Derzeit werden Links von sozialen Netzwerken nicht von Suchmaschinen indiziert und nicht in Rankings berücksichtigt, daher wird diese Option zur Beschleunigung der Indizierung der Website wahrscheinlich nicht wirksam sein, dies kann jedoch zu «Live» -Traffic führen, wodurch die Suchbots häufiger darauf zugreifen und mehr Inhalte indizieren.

10. Verkehr aus dem Kontext

Wir erstellen Werbekampagnen in Google AdWords und leiten den Traffic auf die Landungsseiten weiter, um sie schneller zu indizieren, sodass Suchbots die Seiten der Website häufiger besuchen und dadurch die Wahrscheinlichkeit erhöhen, dass sie indiziert werden.

11. Überprüfen der mobilen Optimierung in der Google Search Console

Wir verwenden die Testseite für die mobile Version der Website, um den Bot über die neuen Seiten zu informieren: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Auch hier wird die Hypothese, dass Google ein zusätzliches Signal sendet, um die Seiten der Website über ein Testwerkzeug für die mobile Version zu wechseln, die Website genauer unter die Lupe nehmen wird. Ich bin mir jedoch nicht sicher, ob dies zu einem greifbaren Ergebnis führt.

12. Traffic von Pinterest

Pinterest ist eine beliebte Content-Plattform im Westen, die es nicht nur für Besucher, sondern auch für Suchmaschinen-Bots attraktiv macht. Es wird ständig von Suchbots «bewohnt», insbesondere von Google-Bots, sodass Sie den Google-Bot einfach auf die Seiten der Website verweisen können, die Sie interessieren.

In meinem Fall hat es keine Ergebnisse gebracht.

13. Durchlaufen Sie massive Indexer basierend auf den Tabs des Google Chrome-Browsers

Soweit ich weiß, wenn dieses Thema einmal funktioniert hat (der IndexGator-Dienst und seine Analoga), ist es jetzt absolut tot.

Ja, und nach den Protokollen des Servers - nach einer solchen Indizierung kam der Roboter nicht auf die Website.

14. Erstellen einer Sitemap.txt

Eine Sitemap-Datei.txt ist eine vereinfachte Sitemap-Sitemap.xml. Im Wesentlichen ist dies immer noch die gleiche Liste von Site-URLs, aber ohne zusätzliche Attribute (lastmod, priority, frequency) anzugeben.

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Diese Option ist weniger häufig als eine normale Sitemap.xml, aber trotzdem, wenn Sie in robots einen Verweis darauf hinzufügen.txt, Bots fangen an, es nicht weniger bereitwillig zu scannen als eine normale Sitemap.

15. Inneres Überbrücken

Beschleunigung der Indizierung durch das Anbringen von Links zu neuen Seiten der Website von "Hubs" -Seiten (Seiten mit hohem Traffic / Gewicht).

Normalerweise wird dafür ein Skript geschrieben, das Pakete von nicht indizierten Links aus einer vorgefertigten Liste nimmt und sie auf besonders besuchten Seiten platziert. Nach dem Indizieren der Seiten wird der nächste Linkblock platziert und so weiter. Die Indizierung wird über verschiedene Dienste oder über die Google Webmaster Tools API überprüft.

16. Aufbau der externen Referenzmasse

Google erkennt an, dass Seiten vertrauenswürdig sind, wenn sie von seriösen Websites verlinkt werden.

Die Verfügbarkeit von Backlinks weist Google an, dass die Seiten wichtig sind und indiziert werden sollten.

Daher kann Google durch den Aufbau einer qualitativ hochwertigen externen Referenzmasse zu den Promoted-Seiten und zur Website als Ganzes signalisieren, dass diese Website mehr Aufmerksamkeit schenken und Inhalte häufiger kraulen muss.

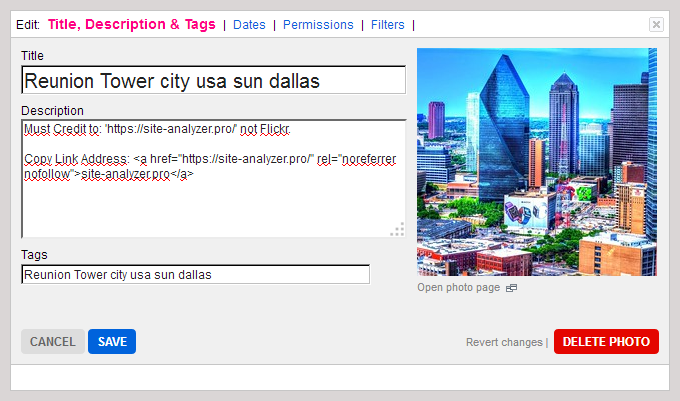

17. Kreative Methode mit Flickr (Viktor Karpenko Case)

Wir erstellen ein Konto auf Flickr-Foto-Hosting, wir laden viele Fotos hoch (Tausende, aber besser Zehntausende) - wir nehmen das Foto, egal wo es herkommt, Sie können sogar andere Foto-Hosting, Instagram usw. verwenden.

Unter jedem Foto schreiben wir, dass Sie bei der Verwendung des Fotos einen Backlink zu der von Ihnen beworbenen Website einfügen müssen (vergessen Sie nicht, die URL zu erwähnen).

Als Ergebnis ist es möglich, jeden Monat Traffic und Dutzende von Links von guten Websites und Medien kostenlos zu erhalten.

Anmerkung. Das Beispiel bezieht sich eher auf Linkbuilding, aber es ermöglicht Ihnen auch, Traffic auf bestimmte Seiten Ihrer Website zu lenken und dadurch ihre Indizierung zu verbessern.

18. Indizierung mit der Google Indexing API

Squeeze-Anweisungen für PHP vom Benutzer Mahmoud:

- Wir registrieren ein Servicekonto bei Google Cloud, wir erhalten einen Zugangsschlüssel (JSON-Datei), wir geben die Rechte des Servicekontos an der Serchkonsole, wir aktivieren die API in Google Cloud.

- Wir erstellen ein PHP-Skript, aus dem die URL zum Index hinzugefügt wird.

- Wir laden den Client von Github herunter, um mit API zu arbeiten: https://github.com/googleapis/google-api-php-client

- Code zum Hinzufügen von Abfragen in Stapeln:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- Als Antwort sendet $batch->execute() ein Array nach der Anzahl der Verweise in der Anfrage (wenn die Antwort \Google\Service\Exception enthält, dann Code 429 - Überschreitung des Limits, 403 - Probleme mit dem Zugriffs- oder API-Schlüssel, 400 - Datenkurven).

- Link zur Fehlerbeschreibung: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- Vergessen Sie nicht, das API-Konto mit der Google + Konsole zu verknüpfen, um sich selbst als Besitzer auszuweisen, sonst funktioniert das Skript nicht (der Fehler 404 wird im Array angezeigt, es gibt keinen Zugriff auf die Indizierung der Website - Permission denied. Failed to verify the URL ownership).

Hinweis: Es dauerte ~40 Minuten, um das Skript zu schreiben, einschließlich der Zeit für kleine «Stopfen» und das Googeln von Fehlern.

19. Blockieren des Zugangs zum Google-Bot (Vladimir Vershinin Case)

Ich habe festgestellt, dass Dokumente in einem der Projekte schlecht in den Google-Index aufgenommen werden. Wir drehten, drehten - alles nutzlos.

Aus indirekten Gründen entstand die Hypothese, dass Bots nichts von Ressourcen erhalten können, da sie auf der DDoS-Schutz-Service-Ebene abgeschnitten werden.

Wir haben die Liste / ipranges/ am 26. zur Liste des DDoS-Schutzdienstes hinzugefügt, und am 27. haben wir +50k Dokumente im Index erhalten, und im Moment sind in 15 Tagen bereits 300k Dokumente im Index vorhanden.

Ein Großteil der »eingereichten« Dokumente lag bei GSC als »Gescannt, aber noch nicht indiziert".

Link zum IP-Adressbereich von Google-Bots: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Schreiben an John Mueller

Schreiben Sie John Mueller auf Twitter, beschreiben Sie Ihr Problem, drücken Sie die Daumen und warten Sie auf eine Antwort. Twitter »

In meinem Fall hat es nicht funktioniert, niemand hat mir geantwortet, es wurden keine neuen Seiten im Index angezeigt. Seltsam, natürlich, okay.

Aber wer weiß, vielleicht haben Sie Glück )

***

Es scheint, dass es keine bekannten Optionen mehr gibt, um die Indizierung sowohl neuer als auch alter Seiten zu beschleunigen. Wenn ich jedoch etwas übersehen habe, bitte ich Sie, Ihre eigenen Fälle und Beispiele in den Kommentaren zu teilen - ich werde sie gerne mit dem Artikel ergänzen.

P.S. IndexNow. Um das Thema vollständig zu erfassen, ist es erwähnenswert, dass die relativ neue Möglichkeit zur Massenindizierung von Seiten über IndexNow (eine offene API mit der Möglichkeit, bis zu 10.000 Seiten pro Tag zum Index von Suchmaschinen hinzuzufügen) erwähnt wird. Derzeit werden die Suchmaschinen Yandex und Bing unterstützt. Es ist möglich, dass der Beitritt der Google-Suchmaschine zu dieser Technologie gleich um die Ecke ist, obwohl die Technologie bereits jetzt eine kleine Armee von Kritikern hat, wer weiß, ob sie in Zukunft weiterentwickelt wird.

Andere Artikel

225

225