Zweck des Programms

Das Programm SiteAnalyzer ist für die Analyse der Website und erkennen von technischen Fehlern (Suche defekte Links, doppelte Seiten, fehlerhafte Antworten des Servers), sowie Fehler und Mängel in der SEO-Optimierung ("blanko" - meta-Tags, der überschuss oder das völlige fehlen Seitenüberschriften h1, Analyse der Inhalte der Seite, die Qualität der Verlinkung und viele andere SEO-Parameter).

Key Features

- Scannen aller Seiten der Webseite, sowie Bilder, Skripte und Dokumente

- Abrufen der Antwort-Codes des Servers für jede Seite der Website (200, 301, 302, 404, 500, 503 usw.)

- Feststellung der Anwesenheit und der Inhalt von Title, Keywords, Description, H1-H6

- Suche und Anzeige der "doppelten" Seiten, meta-Tags und überschriften

- Bestimmen, ob das Attribut rel="canonical" für jede Seite der Website

- Folgen Sie den Anweisungen der Datei "robots.txt", dem Meta-Tag "Robots" oder X-Robots-Tag

- Accounting "noindex" und "nofollow" beim Crawlen der Seiten der Site

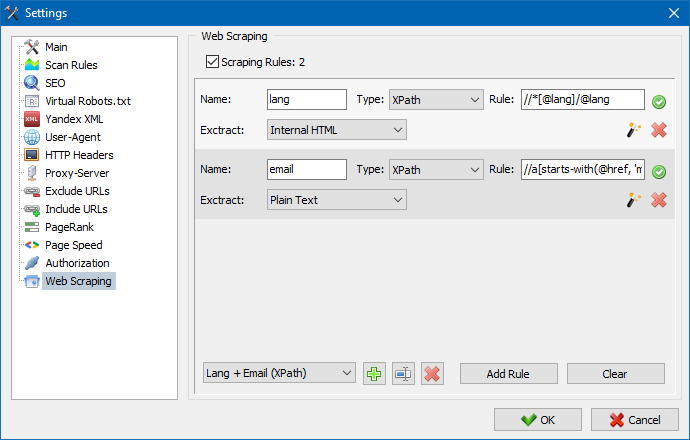

- Scraping von Daten mit XPath, CSS, XQuery, RegEx

- Überprüfung der Einzigartigkeit des Inhalts innerhalb der Website

- Überprüfung der Seitenladegeschwindigkeit von Google PageSpeed

- Referenzanalyse: Definition interner und externer Links für jede Seite der Site

- Berechnung des internen PageRank für jede Seite der Site

- Visualisierung der Struktur der Site in der Grafik

- Bestimmen der Anzahl der Weiterleitungen von der Seite (Weiterleitungen)

- Scannen Sie beliebige URLs und externe Sitemap.xml

- Sitemap "sitemap.xml" Generierung (mit der Möglichkeit der Aufteilung in mehrere Dateien)

- Filtern von Daten nach beliebigen Parametern (flexible Konfiguration von Filtern beliebiger Komplexität)

- Suche nach beliebigen Inhalten auf der Website

- Exportieren von berichten in CSV, Excel und PDF

Unterschiede von Gleichaltrigen

- Geringe Anforderungen an Computer-Ressourcen, kleiner RAM Verbrauch

- Scannen von Websites nahezu allen Formaten aufgrund der geringen Anforderungen an die Ressourcen des Computers

- Portable-Format (funktioniert ohne Installation auf dem PC oder direkt auf dem Medium)

Abschnitte der Dokumentation

- Erste Schritte

- Programmeinstellungen

- Grundeinstellungen

- Scannen

- SEO

- Virtuelle Roboter.txt new

- Yandex XML

- User-Agent

- Beliebige HTTP-Header new

- Proxy-Server

- URL ausschließen

- Folgen Sie der URL

- PageRank

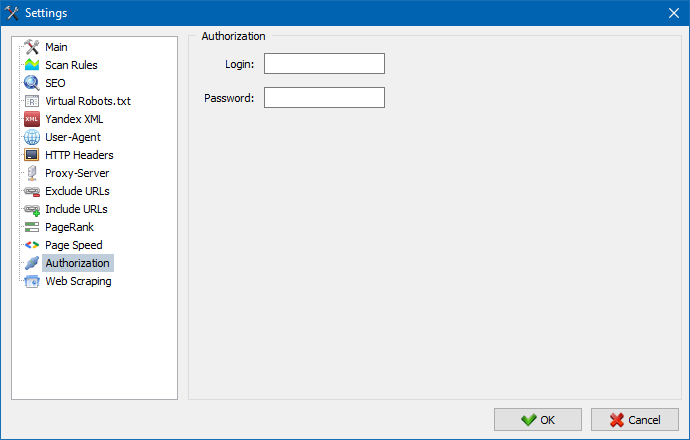

- Autorisation

- Die Arbeit mit dem Programm

- Anpassen von Spalten und Tabs

- Filtern von Daten

- Technische Site-Statistiken

- SEO-Statistiken

- Custom Filters

- Custom Search

- Daten-Scraping

- Eindeutigkeitsprüfung des Inhalts

- Überprüfen der Seitenladegeschwindigkeit

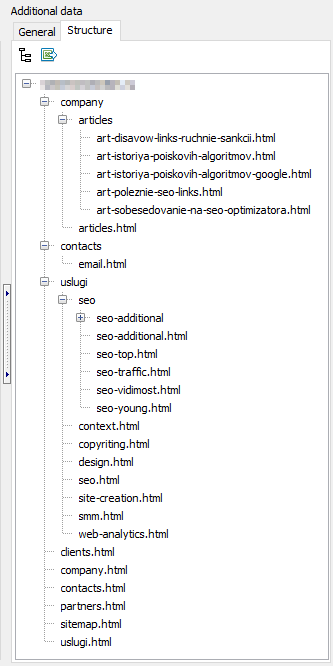

- Die Struktur der Website

- Das Kontextmenü der Projektliste

- Website-Strukturvisualisierung

- Verteilungsdiagramm für interne Links

- Geschwindigkeitsdiagramm zum Laden von Seiten

- Generieren Sitemap.xml

- Scannen Sie beliebige URL

- Dashboard

- Exportieren von Daten

- Mehrsprachigkeit

- Datenbankkomprimierung

Erste Schritte

Beim Start des Programms den Benutzer verfügbar Adressleiste zur Eingabe der URL des zu analysierenden Website (man kann einen beliebigen Seite der Website, so wie der crawler, indem Sie auf die Links, um die ursprüngliche Seite wird die gesamte Website, einschließlich der Homepage, vorausgesetzt, dass alle Links aus HTML und nicht Javascript verwenden).

Nach einem Klick auf "Start", der crawler beginnt Durchforstung aller Seiten durch interne Links (auf externe Ressourcen es geht nicht, auch nicht auf Links klickt, die auf Javascript).

Nachdem der Roboter werden alle Seiten der Website verfügbar ist ein Bericht, ausgeführt in Form einer Tabelle und zeigt die erhaltenen Daten, gruppiert nach Themenbereichen Tab.

Alle analysierten Projekte befinden sich im linken Teil des Programms und werden automatisch in der Datenbank des Programms zusammen mit den erhaltenen Daten. Um unerwünschte Websites verwenden Sie das Kontextmenü der Projektliste.

Anmerkung:

- wenn Sie auf die Schaltfläche "Pause" scan-Projekt angehalten, parallel zu den aktuellen Fortschritt der scan in der Datenbank gespeichert, sodass Sie zum Beispiel das Programm schließen und den Scanvorgang fortzusetzen Projekt nach einem Neustart des Programms vom letzten Stopp

- "Stop" - Taste unterbricht die scan des aktuellen Projekts, ohne die Möglichkeit der Fortsetzung seiner scan

Programmeinstellungen

Im Hauptmenü "Einstellungen" dient zur Feinabstimmung der Arbeit des Programms mit externen Seiten und enthält 7 Registerkarten:

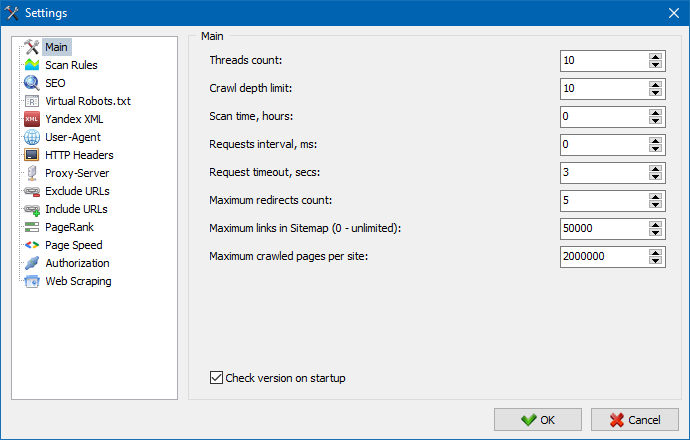

Abschnitt Grundeinstellungen dient dazu, das Programm von benutzerdefinierten Richtlinien, die Sie beim Crawlen Ihrer Website.

Beschreibung der Parameter:

- Die Anzahl der Threads

- Je mehr die Anzahl der Threads, desto mehr URLS behandeln kann in einer Zeiteinheit. Dabei ist zu berücksichtigen, dass eine größere Anzahl von Threads führt zu einer größeren Anzahl von PC-Ressourcen verwendet. Es wird empfohlen, die Anzahl der Threads im Bereich 5-10.

- Scan-Zeit

- Dient zur Einstellung Informationen zu Einschränkungen beim Scannen der Website nach der Zeit. Wird in Stunden gemessen.

- Maximale Tiefe

- Diese Option dient zur Angabe der scan-Tiefe der Website. Die Homepage hat Verschachtelungstiefe = 0. Zum Beispiel, wenn Sie Seiten Ihrer Website gecrawlt Art "somedomain.ru/catalog.html" und "somedomain.ru/catalog/tovar.html" in diesem Fall müssen Sie setzen die maximale Tiefe = 2.

- Verzögerung zwischen den Abfragen

- Dient zur Einstellung der Pausen bei den Anreden Scanner auf den Webseiten. Es ist notwendig für Websites, auf "schwachen" Hostings, nicht standhalten schwere Lasten und häufige Anrufe.

- Zeitüberschreitung der Anforderung

- Festlegen des Zeitlimits Antwort würden auf die Anfrage des Programms. Wenn einige dieser Seiten reagieren langsam (lange geladen), das Scannen der Website kann ziemlich lange dauern. Solche Seiten getrimmt werden kann, indem der Wert, nach dem der Scanner wechselt zum Scannen der restlichen Seiten auf der Website und dadurch nicht zu verzögern den Fortschritt.

- Die Anzahl der gescannten Seiten

- Die Beschränkung auf die maximale Anzahl der zu scannenden Seiten. Manchmal ist es hilfreich, wenn, zum Beispiel, müssen Sie Scannen die ersten N Seiten (dabei nicht berücksichtigt Bild-Dateien, Stylesheets, Skripte und andere Arten von Dateien).

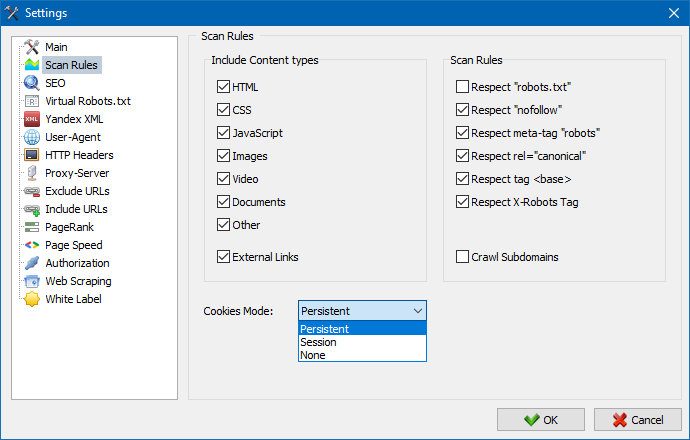

Berücksichtigen der Inhalt

- In diesem Abschnitt können Sie festlegen, welche Arten von Daten berücksichtigt werden-Parser beim durchforsten der Seiten (Bilder, Videos, styles, Skripte), oder ausschließen zusätzliche Informationen beim Parsen.

Regeln für das Scannen

- Diese Einstellungen verbunden mit den Einstellungen von Ausnahmen beim Crawlen der Website Scanner unter Verwendung der Datei "robots.txt" durch die Verknüpfung des Typs "nofollow", sowie die unter Verwendung der Richtlinie "meta name=robots" direkt im Code der Seiten.

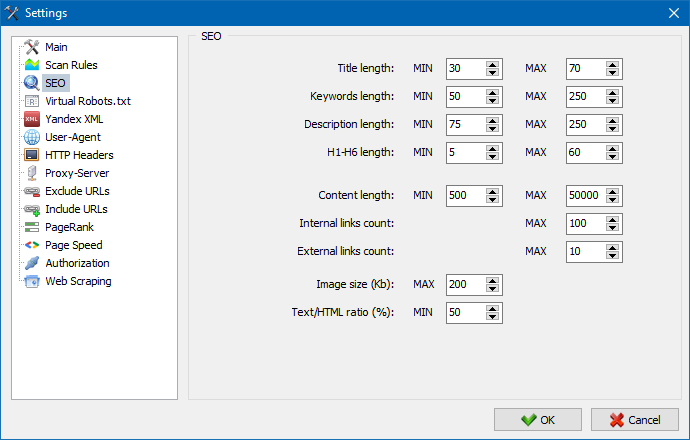

Dieser Abschnitt dient dazu, die wichtigsten untersuchten SEO-Einstellungen, die im folgenden auf Ihre Gültigkeit überprüft werden beim Parsen der Seiten, Wonach die resultierende Statistik wird angezeigt auf der Registerkarte "Statistik SEO" im rechten Bereich des Hauptfensters des Programms.

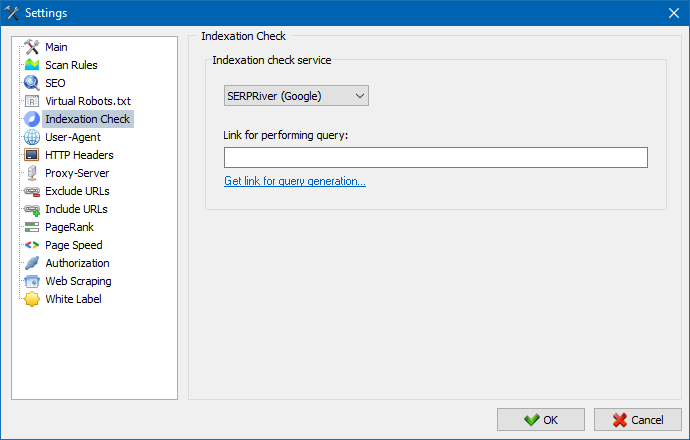

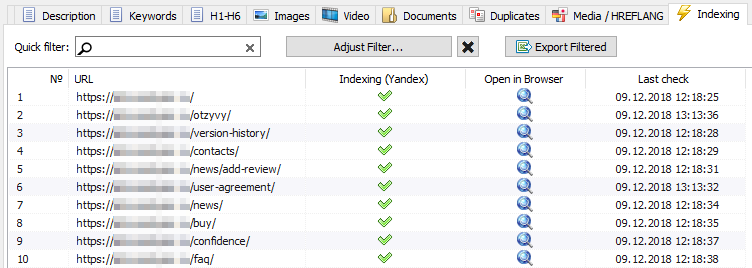

Mit Hilfe dieser Einstellungen können Sie einen Dienst auswählen, über den Sie die Indexierung der Seiten in der Suchmaschine Yandex überprüfen. Es gibt zwei Optionen zum Überprüfen der Indexierung: Verwenden des Yandex-XML-Dienstes oder des Majento.ru-Dienstes.

Bei der Auswahl des Yandex XML-Dienstes müssen Sie mögliche Einschränkungen (stündlich oder täglich) berücksichtigen, die bei der Überprüfung der Indexierung von Seiten in Bezug auf die bestehenden Beschränkungen Ihres Yandex-Kontos angewendet werden können. Infolgedessen kann es Situationen geben, in denen Ihre Kontolimits nicht ausreichen, um alle zu überprüfen Seiten auf einmal und dafür müssen Sie die nächste Stunde warten.

Bei der Verwendung des Majento.ru-Dienstes gibt es praktisch keine stündlichen oder täglichen Einschränkungen, da Ihr Limit buchstäblich in den allgemeinen Pool von Limits übergeht, der an sich nicht klein ist, aber bei stündlichen Einschränkungen ein erheblich größeres Limit aufweist als bei den einzelnen Benutzerkonten auf Yandex XML.

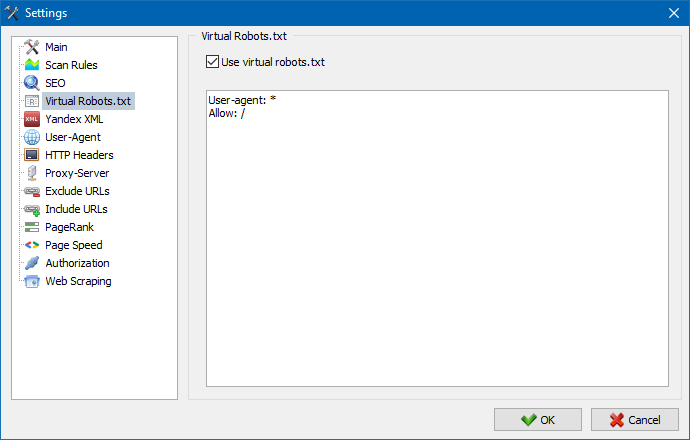

Anstelle der auf der Site gehosteten echten robots.txt kann virtuelle robots.txt verwendet werden.

Dies ist nützlich, wenn Sie eine Site testen, wenn Sie beispielsweise bestimmte Abschnitte der Site, die von der Indexierung geschlossen wurden, crawlen müssen (oder umgekehrt - beim Crawlen nicht berücksichtigen), während Sie dies nicht physisch machen müssen Änderungen an der echten robots.txt und verbringen die Zeit des Entwicklers damit.

Hinweis: Beim Importieren einer URL-Liste werden die Anweisungen der virtuellen robots.txt berücksichtigt (sofern diese Option aktiviert ist), ansonsten wird keine robots.txt für die URL-Liste berücksichtigt.

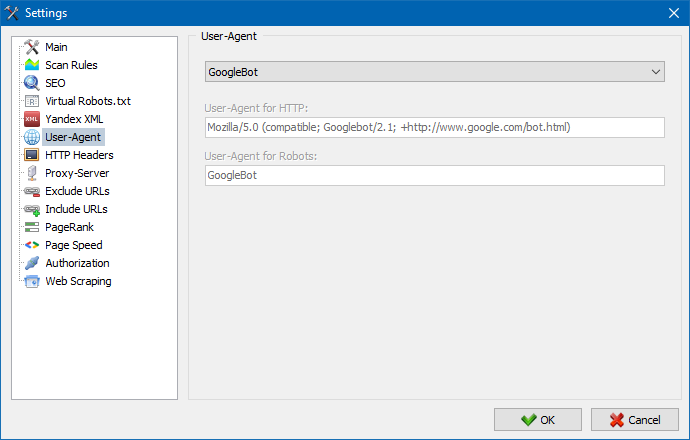

Unter User-Agent können Sie angeben, welchen user-Agent eingereicht werden das Programm beim Zugriff auf externe Websites während des Scans. Per default installiert eine benutzerdefinierte user-Agent, aber bei Bedarf können Sie eine der Standard-Agents, die am häufigsten im Internet. Unter Ihnen gibt es solche, wie: Suchmaschinen Bots YandexBot, GoogleBot, MicrosoftEdge, Bots Browsern wie Chrome, Firefox, IE8, sowie Mobile Geräte iPhone, Android und viele andere.

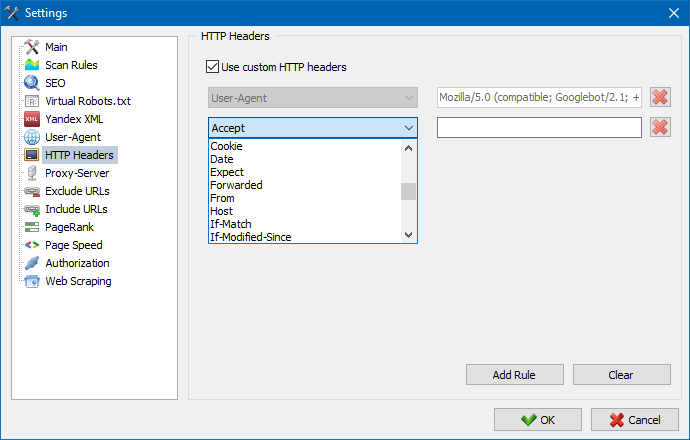

Mit dieser Option können Sie die Reaktion der Site und der Seiten auf verschiedene Anfragen analysieren. Zum Beispiel muss jemand in einer Anfrage möglicherweise einen Referer senden, Besitzer mehrsprachiger Sites möchten Accept-Language | Charset | Encoding übertragen und jemand muss ungewöhnliche Daten in den Accept-Encoding-, Cache-Control-, Pragma-Headern übertragen , usw. NS.

Mit dieser Option können Sie die Reaktion der Site und der Seiten auf verschiedene Anfragen analysieren. Zum Beispiel muss jemand in einer Anfrage möglicherweise einen Referer senden, Besitzer mehrsprachiger Sites möchten Accept-Language | Charset | Encoding übertragen und jemand muss ungewöhnliche Daten in den Accept-Encoding-, Cache-Control-, Pragma-Headern übertragen , usw. NS.

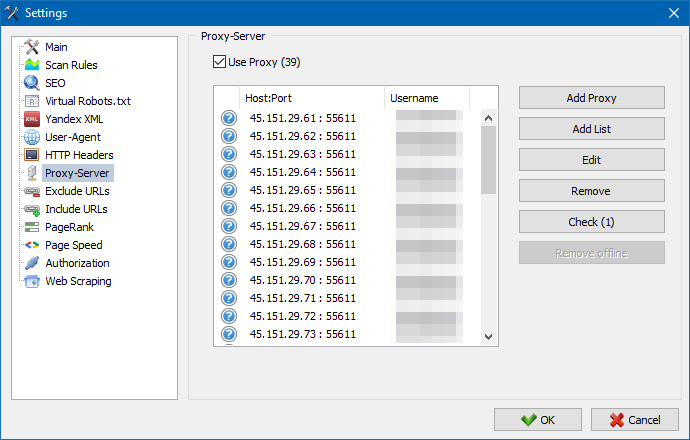

Wenn es notwendig ist, über einen Proxy zu arbeiten, wird in diesem Abschnitt können Sie die Liste von Proxy-Servern, über die das Programm greift auf externe Ressourcen. Zusätzlich gibt es auch die Möglichkeit der überprüfung der Proxy auf die Arbeitsfähigkeit, sondern auch die Funktion der Entfernung von inaktiven Proxy-Server.

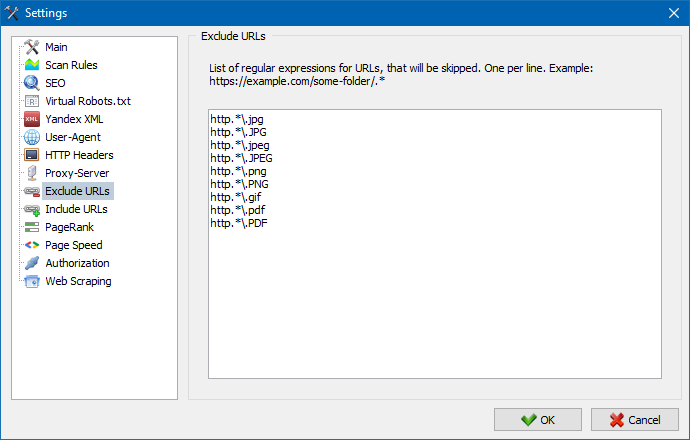

Diese Sektion ist für die Ausnahmen Crawlen bestimmter Seiten und Abschnitte beim Parsen der Webseite.

Verwenden der Suchmuster * und ? sie können angeben, welche Abschnitte der Site vom Crawler nicht gecrawlt und dementsprechend nicht in die Programmdatenbank aufgenommen werden sollen. Diese Liste ist eine lokale Liste von Ausnahmen während der scan-site (bezüglich seiner "globalen" Liste ist eine Datei "robots.txt" in der Wurzel der Website).

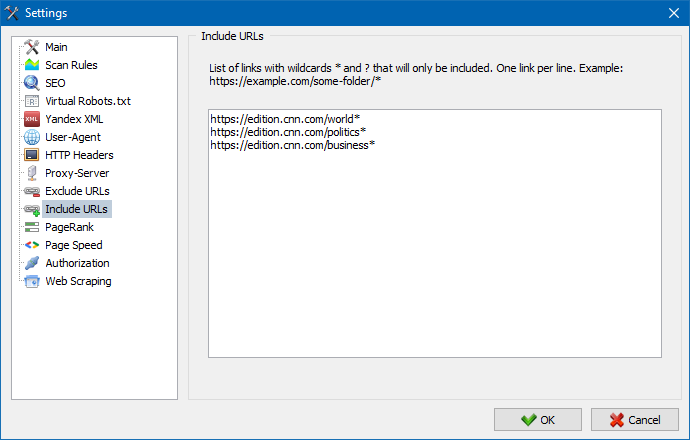

Ebenso können Sie URLs hinzufügen, die gecrawlt werden müssen. In diesem Fall werden alle anderen URLs außerhalb dieser Ordner während des Scanvorgangs ignoriert. Diese Option funktioniert auch mit Suchmustern * und ?

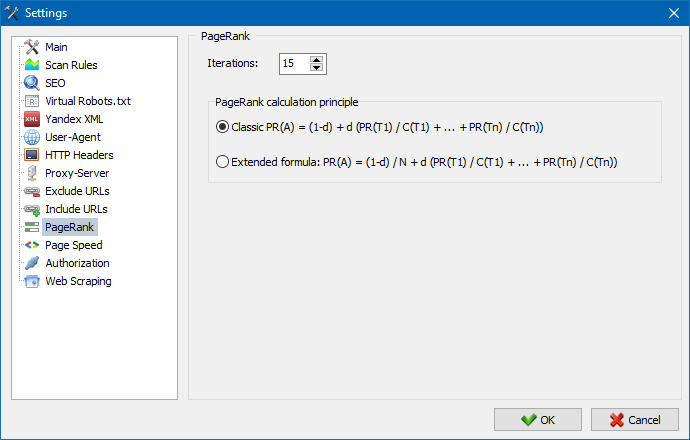

Mit dem Parameter PageRank können Sie die Navigationsstruktur Ihrer Websites analysieren und das System interner Links einer Webressource optimieren, um das Referenzgewicht auf die wichtigsten Seiten zu übertragen.

Das Programm hat zwei Möglichkeiten, den PageRank zu berechnen: den klassischen Algorithmus und seinen moderneren Gegenwert. Im Allgemeinen besteht für die Analyse der internen Verlinkung der Site kein großer Unterschied bei der Verwendung des ersten oder des zweiten Algorithmus. Sie können also einen der beiden Algorithmen verwenden.

Eine detaillierte Beschreibung des Algorithmus und der Grundsätze für die Berechnung des PageRank finden Sie im Artikel "Berechnung des internen PageRank": >>

Geben Sie den Login und das Passwort für die automatische Autorisierung auf Seiten ein, die über .htpasswd geschlossen und durch die BASIC-Serverautorisierung geschützt sind.

Die Arbeit mit dem Programm

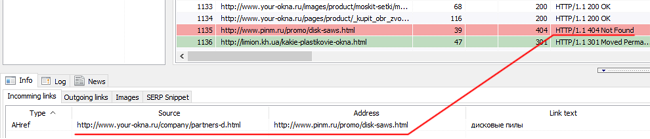

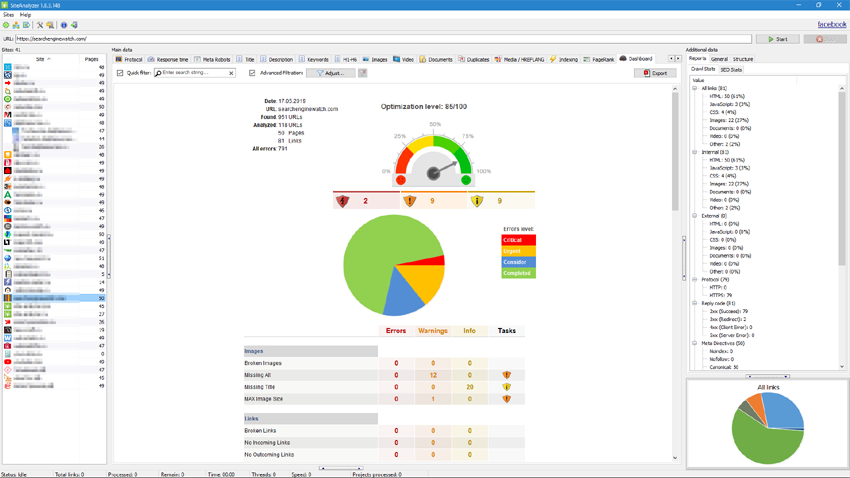

Nach Abschluss des Scanvorgangs der Benutzer verfügbar ist die Information im Block "Stammdaten". Jede Registerkarte enthält Daten, gruppiert in Bezug auf Ihre Namen (Z. B. Registerkarte "Title" enthält den Inhalt Seitentitel <title></title> Registerkarte "Bild" enthält eine Liste aller Bilder der Website und so weiter). Mit Hilfe dieser Daten kann eine Analyse des Inhalts der Website, zu finden "tote" Links oder nicht richtig ausgefüllte meta-Tags.

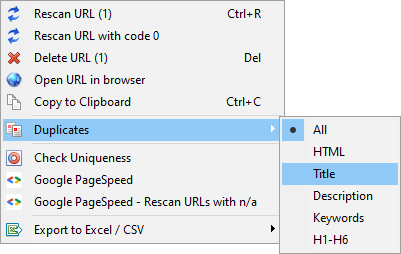

Bei Bedarf (Z. B. nach änderungen auf der Website) über das Kontextmenü besteht die Möglichkeit, neue überprüfung einzelner URL zur Anzeige von änderungen im Programm.

Mit diesem Menü können Sie auch Duplikate anzeigen von Seiten auf die entsprechenden Parameter (doubles title, description, keywords, h1, h2, content-Seiten).

Das Element "URL mit Code 0 erneut scannen" überprüft automatisch alle Seiten, die einen Antwortcode 0 (Read Timeout) enthalten. Dieser Antwortcode wird normalerweise angegeben, wenn der Server keine Zeit zum Bereitstellen von Inhalten hat und die Verbindung durch Zeitüberschreitung geschlossen wird. Die Seite kann nicht geladen und Informationen daraus können nicht extrahiert werden.

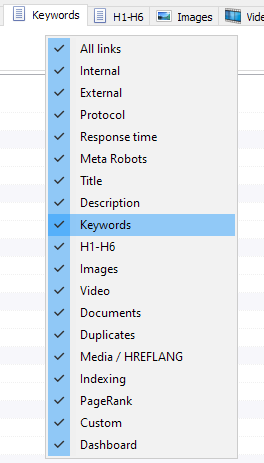

Nun können Sie auswählen, welche Registerkarte angezeigt werden sollen im Backend Stammdaten (schließlich wurde es möglich, Abschied von der veralteten Meta Keywords Tab). Dies ist hilfreich, wenn Tabs nicht auf dem Bildschirm passen, oder die Sie selten verwenden.

Die Spalten können auch ausblenden oder verschieben an die gewünschte Stelle ziehen.

Die Anzeige von Registerkarten und Spalten können über ein Kontextmenü im Bereich Stammdaten. Die übertragung der Spalten erfolgt über die Maus.

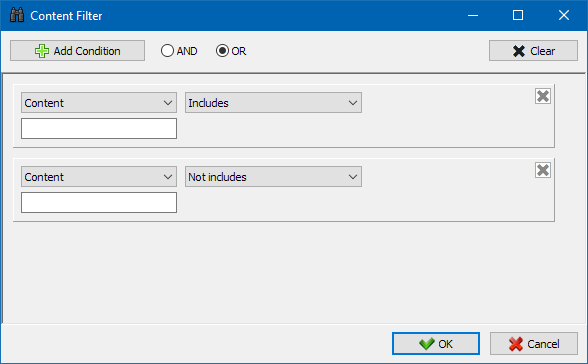

Zur besseren Analyse der Website-Statistiken im Programm filtern von Daten zur Verfügung. Filtern ist in zwei Varianten möglich:

- auf allen Feldern, die mit dem "schnellen" Filter

- mit dem benutzerdefinierten Filter (mit erweiterten Einstellungen Beispieldaten)

Quick-Filter

Dient zum schnellen filtern von Daten und gilt gleichzeitig für alle Felder der aktuellen Registerkarte.

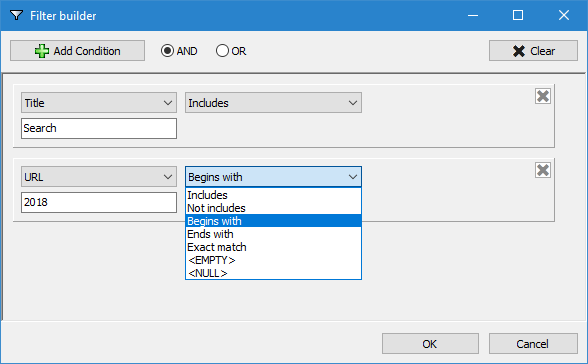

Anpassbare Filter

Konzipiert für detaillierte Filterung und kann gleichzeitig mehrere Bedingungen. Z. B. für meta-Tags "Titel" gehen Sie Seiten herausfiltern nach Ihrer Länge, dass Sie nicht mehr als 70 Zeichen und gleichzeitig enthielt den Text "News". Dann wird dieser Filter wird so Aussehen:

Deshalb ist die Anwendung anpassbare Filter auf jeder der Registerkarten erhalten Sie die Beispieldaten von beliebiger Komplexität.

Die Registerkarte mit den technischen Statistiken der Site befindet sich im Fenster "Zusätzliche Daten" und enthält eine Reihe grundlegender technischer Parameter für die Site: Statistiken zu Links, Meta-Tags, Antwortcodes für Seiten, Parameter zur Indexierung der Seite, Inhaltstypen usw. Parameter.

Wenn Sie auf einen der Parameter klicken, werden diese automatisch in der entsprechenden Registerkarte der Site-Stammdaten gefiltert. Gleichzeitig werden im Diagramm am unteren Rand der Seite Statistiken angezeigt.

Die Registerkarte "SEO-Statistiken" ist für die Durchführung vollständiger Site-Audits vorgesehen. Sie enthält mehr als 50 SEO-Hauptparameter und identifiziert über 60 wichtige interne Optimierungsfehler! Die Fehlerzuordnung ist in Gruppen unterteilt, die wiederum Gruppen analysierter Parameter und Filter enthalten, die Fehler auf der Site erkennen.

Eine detaillierte Beschreibung aller überprüften Parameter finden Sie in diesem Artikel. >>

Für alle Filterergebnisse ist es möglich, sie ohne zusätzliche Dialoge (der Bericht wird im Programmordner gespeichert) schnell nach Excel exportiert.

Auf dieser Registerkarte befinden sich vordefinierte Filter, die Sie bei der Erstellung der Stichprobe auf alle externen Links, Fehler 404, Bildern und anderen Parametern in der alle Seiten, auf denen Sie vorhanden sind. So, jetzt können Sie einfach und schnell eine Liste von externen Links und Seiten, auf denen Sie platziert sind, oder wählen Sie alle defekte Links und sofort sehen, auf welchen Seiten Sie sich befinden.

Alle Berichte sind im Programm Online und zeigen Sie auf dem Tab "Custom" - Panel-Stammdaten. Zusätzlich besteht die Möglichkeit von deren Export in Excel über das Hauptmenü.

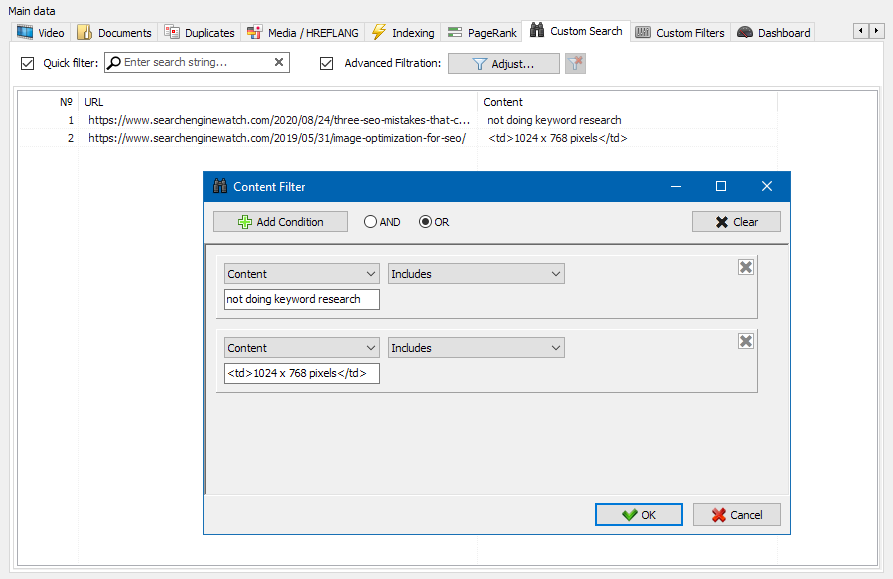

Mit der Funktion zum Suchen von Website-Inhalten können Sie den Quellcode durchsuchen und Webseiten anzeigen, die den gewünschten Inhalt enthalten.

Mit dem Modul für benutzerdefinierte Filter können Sie das Vorhandensein von Mikro-Markups, Meta-Tags, Analysesystemen, Fragmenten von freiem Text oder HTML-Code auf der Site überprüfen.

Im Filterkonfigurationsfenster gibt es verschiedene Parameter zum Suchen nach bestimmten Textfragmenten auf Websiteseiten oder umgekehrt zum Ausschließen von Seiten, die bestimmte Text- oder HTML-Codefragmente aus den Suchergebnissen enthalten (diese Funktion ähnelt der Suche nach Inhalten im Quellcode einer Seite mit Strg-F)...

Typischerweise wird Scraping verwendet, um Aufgaben zu lösen, die manuell schwierig zu handhaben sind. Dies kann das Extrahieren von Produktbeschreibungen sein, um einen neuen Online-Shop zu erstellen, das Scraping in der Marktforschung, um Preise zu überwachen, oder um Anzeigen zu überwachen.

In SiteAnalyzer wird das Scraping auf der Registerkarte Datenextraktion konfiguriert, auf der Extraktionsregeln konfiguriert werden. Regeln können gespeichert und bei Bedarf bearbeitet werden.

Es gibt auch ein Regeltestmodul. Mit dem integrierten Regel-Debugger können Sie schnell und einfach den HTML-Inhalt jeder Seite der Site abrufen und die Arbeit von Abfragen testen und dann die debuggten Regeln zum Analysieren von Daten in SiteAnalyzer verwenden.

Nach Abschluss der Datenextraktion können alle gesammelten Informationen nach Excel exportiert werden.

Eine detailliertere Untersuchung der Funktionsweise des Moduls und eine Liste der gebräuchlichsten Regeln und regulären Ausdrücke finden Sie im Artikel

Eindeutigkeitsprüfung des Inhalts

Mit diesem Tool können Sie nach doppelten Seiten suchen und die Einzigartigkeit von Texten innerhalb der Site überprüfen. Mit anderen Worten, dies ist eine Batch-Prüfung einer Gruppe von URLs auf Eindeutigkeit untereinander.

Dies kann in folgenden Fällen nützlich sein:

- Um nach vollständigen doppelten Seiten zu suchen (z. B. eine Seite mit Parametern und derselben Seite, jedoch in der CNC-Ansicht).

- Um nach teilweisen Inhaltsübereinstimmungen zu suchen (z. B. zwei Borschtsch-Rezepte in einem kulinarischen Blog, die sich zu 96% ähneln, was darauf hindeutet, dass einer der Artikel gelöscht werden sollte, um eine mögliche Traffic-Kannibalisierung zu beseitigen).

- Wenn Sie auf einer Artikelseite versehentlich einen Artikel zu einem Thema geschrieben haben, das Sie bereits vor 10 Jahren geschrieben haben. In diesem Fall erkennt unser Tool auch ein Duplikat eines solchen Artikels.

Das Prinzip des Tools zur Überprüfung der Eindeutigkeit von Inhalten ist einfach: Das Programm lädt deren Inhalt aus der Liste der Website-URLs herunter, empfängt den Textinhalt der Seite (ohne HEAD-Block und ohne HTML-Tags) und vergleicht sie dann mit jedem. andere mit dem Schindel-Algorithmus.

So ermitteln wir mit Hilfe von Schindeln die Eindeutigkeit von Seiten und können sowohl Vollduplikate von Seiten mit 0% Eindeutigkeit als auch Teildubletten mit unterschiedlichen Eindeutigkeitsgraden des Textinhalts berechnen. Das Programm arbeitet mit einer Schindellänge von 5.

In diesem Artikel erfahren Sie mehr über die Funktionsweise des Moduls.: >>

Überprüfen der Seitenladegeschwindigkeit

Das PageSpeed Insights-Tool des Google-Suchgiganten ermöglicht es Ihnen, die Ladegeschwindigkeit bestimmter Seitenelemente zu überprüfen und zeigt auch den Gesamtwert der Ladegeschwindigkeit der interessierenden URLs für die Desktop- und mobilen Versionen des Browsers an.

Das Tool von Google ist für alle gut, es hat jedoch einen wesentlichen Nachteil - es erlaubt Ihnen keine Gruppen-URL-Überprüfungen zu erstellen, was beim Überprüfen vieler Seiten Ihrer Website zu Unannehmlichkeiten führt: Stimmen Sie zu, dass die Download-Geschwindigkeit für 100 oder mehr URLs manuell überprüft wird Eine Seite ist mühsam und kann viel Zeit in Anspruch nehmen.

Aus diesem Grund haben wir ein Modul erstellt, mit dem Sie über eine spezielle API im Google PageSpeed Insights-Tool kostenlos Gruppenprüfungen der Seitenladegeschwindigkeit erstellen können.

Die wichtigsten analysierten Parameter:

- FCP (First Contentful Paint) – Zeit, um den ersten Inhalt anzuzeigen.

- SI (Speed Index) – ein Indikator dafür, wie schnell Inhalte auf einer Seite angezeigt werden.

- LCP (Largest Contentful Paint) – Anzeigezeit für das größte Element auf der Seite.

- TTI (Time to Interactive) – die Zeit, in der die Seite vollständig für die Benutzerinteraktion bereit ist.

- TBT (Total Blocking Time) – Zeit vom ersten Rendern des Inhalts bis zu seiner Bereitschaft für die Benutzerinteraktion.

- CLS (Cumulative Layout Shift) – kumulative Layoutverschiebung. Dient zur Messung der visuellen Stabilität der Seite.

Gleichzeitig erfolgt die Analyse der URL selbst mit wenigen Klicks, wonach ein Bericht heruntergeladen werden kann, der die wichtigsten Merkmale der Prüfungen in bequemer Form in Excel enthält.

Alles, was Sie für den Anfang benötigen, ist einen API-Schlüssel zu erhalten.

Wie das geht, wird in diesem Artikel beschrieben. >>

Diese Funktionalität ist für die Erstellung der Struktur der Webseite auf der Grundlage der gewonnenen Daten. Die Struktur der Website generiert auf der Grundlage der Verschachtelung URL der Seiten. Nach der Erzeugung der Struktur ist Ihr Export im CSV-Format (Excel).

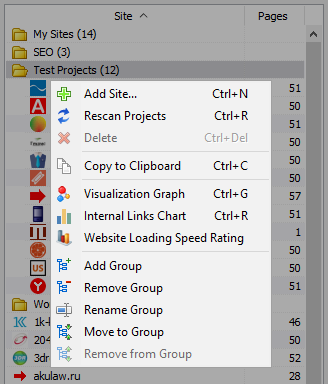

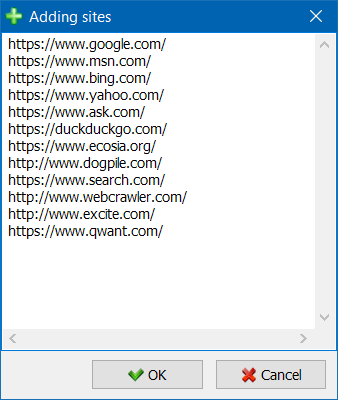

Das Kontextmenü der Projektliste

- In der Liste der Projekte verfügbar massenhafte Scannen durch die Bereitstellung der erforderlichen Seiten und auf die Schaltfläche "Rescan". Danach alle Seiten werden in eine Warteschlange gescannt und nacheinander in den Standard-Modus.

- Auch für die Bequemlichkeit der Arbeit mit dem Programm, die massenhafte löschen von ausgewählten Websites, auch wird mit der Schaltfläche "Löschen".

- Neben den einzelnen scan-Websites, es gibt die Möglichkeit der Zugabe von Websites in die Liste der Projekte mit Hilfe eines speziellen Formulars, dann kann der Benutzer Scannen Ihre Projekte komplett.

- Für eine bequemere Navigation durch die Projektliste ist es möglich, Sites nach Ordnern zu gruppieren und die Projektliste nach Namen zu filtern.

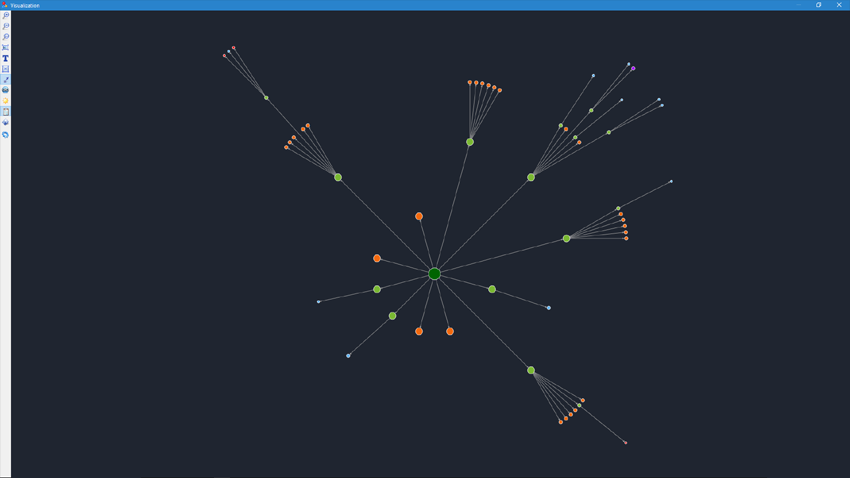

Website-Strukturvisualisierung

Rendering-Modus referenziellen Beziehungen auf der Rubrik Hilfe von einem SEO-Spezialisten zu bewerten interne Verteilung des PageRank auf den Seiten der Webseite, sowie zu verstehen, welche Seiten erhalten Sie einen großen Referenzgewicht (und dementsprechend größere interne Link-Saft in den Augen der Suchmaschinen) und welche Seiten und Teile der Website nicht genügend interne Links.

Mit Hilfe des Modus der Visualisierung der Struktur der Webseite SEO-Experte in der Lage, visuell zu bewerten, wie organisiert die interne Verlinkung auf der Website, sowie durch die visuelle Darstellung der Masse der PageRank, zugeordnet dem einen oder anderen Seiten, zeitnah Anpassungen an die aktuelle Verlinkung der Website und erhöhen die Relevanz der relevanten Seiten.

Im linken Teil des Fensters der Visualisierung sind die wichtigsten Werkzeuge für die Arbeit mit graph:

- zoomen in einem Diagramm

- drehung des grafen in beliebigem Winkel

- wechseln Sie den Graphen im Fenster in den Vollbildmodus (funktioniert auch mit der Taste F11)

- anzeigen / ausblenden von Signaturen zu Knoten (Ctrl-T)

- anzeigen / ausblenden der Pfeile an den Linien

- einblenden / ausblenden von Links zu externen Ressourcen (Ctrl-E)

- umschalten des Farbschemas Tag / Nacht (Ctrl-D)

- einblenden / ausblenden der Legende und Statistik des Grafen (Ctrl-L)

- speichern des Graphen im PNG-Format (Ctrl-S)

- das Einstellungsfenster der Visualisierung (Ctrl-O)

Im Abschnitt "Ansicht" dient zum ändern des ANZEIGEFORMATS von Knoten auf Graphen. Im Zeichenmodus Knoten "PageRank", Maße Knoten werden in Bezug auf Ihre zuvor berechneten PageRank Metrik, was auf der Grafik können Sie deutlich sehen, welche Seite eine bessere Link-Saft, und was geht an den wenigsten Links.

Im Classic-Modus Abmessungen-Knoten werden relativ zu der ausgewählten Skala des Graphen visualisieren.

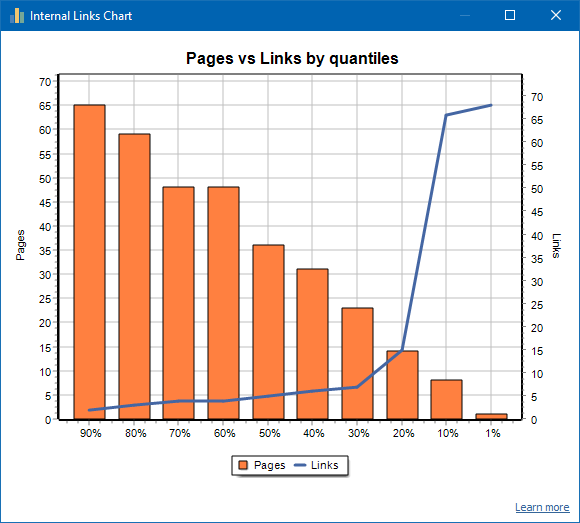

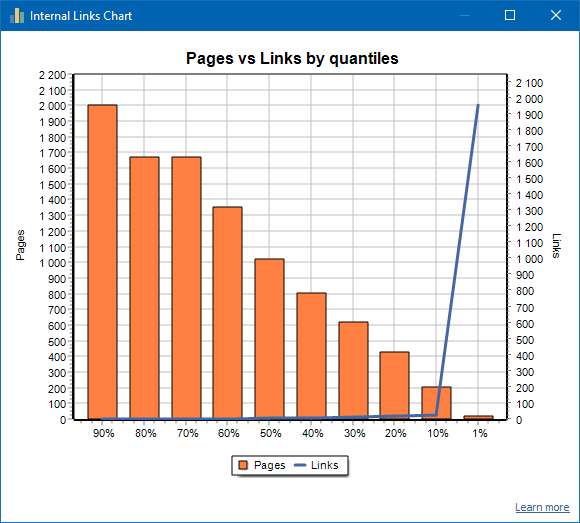

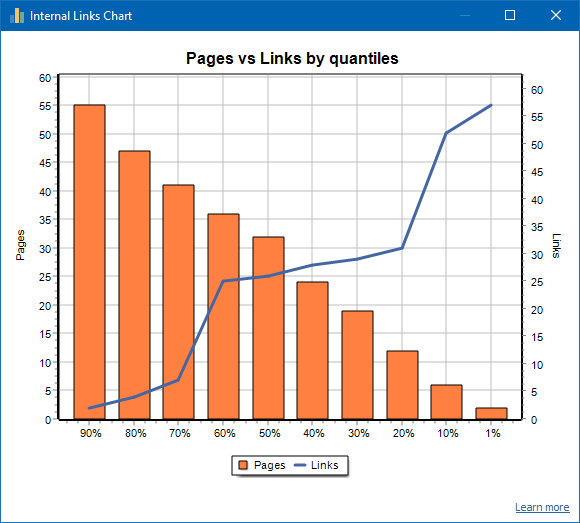

Verteilungsdiagramm für interne Links

Dieses Diagramm zeigt die Verteilung der internen Linkmasse auf den Websiteseiten (wir können sagen, dass dies eine Visualisierung des Links in visueller Form ist und nicht im Visualisierungsdiagramm dargestellt wird). Lesen Sie mehr >>

Links ist die Anzahl der Seiten, rechts ist die Anzahl der Links. Unten finden Sie die prozentualen Quantile pro Seite. Beim Erstellen eines Diagramms werden doppelte Links verworfen (wenn es 3 Links von Seite A zu Seite B gibt, zählen wir sie als einen).

Beispiel: Basierend auf dem obigen Screenshot für eine Site mit etwa 70 Seiten:

- 1% Seiten haben ~68 eingehende Links.

- 10% Seiten haben ~66 eingehende Links.

- 20% Seiten haben ~15 eingehende Links.

- 30% Seiten haben ~8 eingehende Links.

- 40% Seiten haben ~7 eingehende Links.

- 50% Seiten haben ~6 eingehende Links.

- 60% Seiten haben ~5 eingehende Links.

- 70% Seiten haben ~5 eingehende Links.

- 80% Seiten haben ~3 eingehende Links.

- 90% Seiten haben ~2 eingehende Links.

Das heißt, wenn wir sehen, dass wir Seiten haben, zu denen weniger als 10 eingehende Links führen, können wir solche Seiten als schwach verlinkt betrachten, und wir haben 60% der Seiten, die normalerweise verlinkt sind. Auf dieser Grundlage können wir entweder mehr interne Links zu diesen schwach verknüpften Seiten einfügen (wenn die Seiten für die Werbung wichtig sind) oder sie unverändert lassen, wenn solche Seiten von geringer Bedeutung und niedriger Priorität sind.

In der Regel werden Seiten mit weniger als 10 internen Links von Suchrobotern, insbesondere Google-Bots, schlechter gecrawlt.

Wenn Sie also eine Site sehen, auf der normalerweise nur 20 bis 30% der Seiten von der Gesamtzahl der Seiten auf der Site verlinkt sind, ist es sinnvoll, sich mit der Verknüpfungseinstellung zu befassen oder darüber nachzudenken, wie mit diesen 80 bis 70% der schwach verknüpften Seiten umgegangen werden soll (Löschen, Ausblenden vor Indizierung, Weiterleitungen setzen).

Ein Beispiel für eine schwach verknüpfte Site:

Ein Beispiel für eine gut verknüpfte Site:

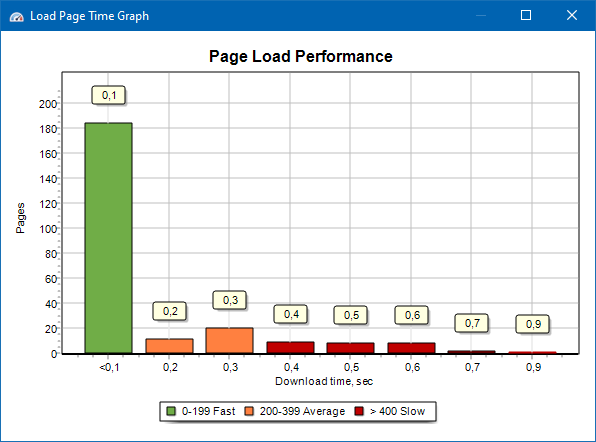

Geschwindigkeitsdiagramm zum Laden von Seiten

Mit dem Diagramm zur Geschwindigkeit beim Laden von Seiten können Sie die Leistung der Site bewerten. Aus Gründen der Übersichtlichkeit sind die Seiten in Gruppen und Zeitintervallen mit einem Schritt von 100 Millisekunden unterteilt.

Anhand des Diagramms können Sie also bestimmen, welcher Anteil der Websiteseiten schnell (innerhalb von 0 bis 100 Millisekunden) geladen wird, welche mit einer Durchschnittsgeschwindigkeit (100 bis 200 Millisekunden) und welche Seiten lange genug (400 Millisekunden oder mehr) geladen werden.

Hinweis: Die angezeigte Zeit ist die Zeit zum Laden des HTML-Quellcodes und nicht die Zeit zum vollständigen Laden der Seiten (das Rendern von Seiten sowie das Laden von Seitenelementen wie Bildern und Stilen werden nicht berücksichtigt).

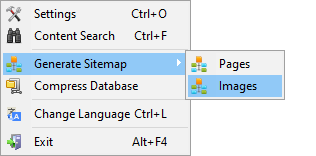

Generieren Sitemap.xml

Die Sitemap wird basierend auf gecrawlten Seiten oder Site-Bildern generiert.

- Beim Generieren einer aus Seiten bestehenden Sitemap werden Seiten im Format "text / html" hinzugefügt.

- Beim Generieren einer Sitemap aus Bildern werden JPG, PNG, GIF und ähnliche Bilder hinzugefügt.

Generieren einer Sitemap können Sie sofort nach dem Scannen der Website, über das Hauptmenü: Menüpunkt "Projekte -> Sitemap Generieren".

Für Websites von großen Mengen von 50 000 Seiten, ein Feature für die automatische Gruppenwechsel "sitemap.xml" auf mehrere Dateien (in diesem Fall die primäre Datei enthält Verweise auf weitere, die direkt Links zu den Seiten). Dies hängt mit den Anforderungen der Suchmaschinen für die Behandlung von Sitemaps großen Größen.

Bei Bedarf, das Volumen der Seiten in der Datei "sitemap.xml" können Sie variieren, indem Sie den Wert 50 000 (Standardeinstellung) auf den gewünschten Wert in den Grundeinstellungen des Programms.

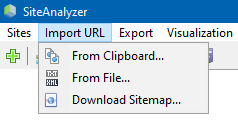

Scannen Sie beliebige URL

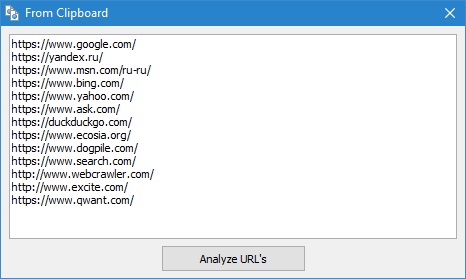

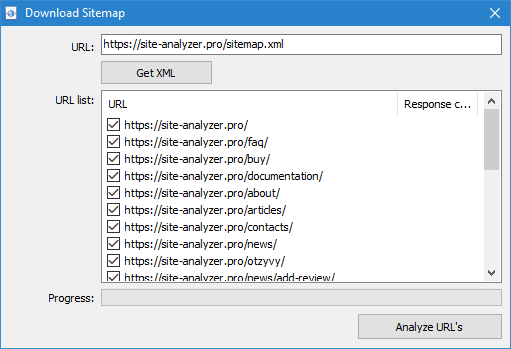

Der Menüpunkt "Import URL" dient zum Scannen von beliebigen URL-Listen, sondern auch XML-Sitemaps Sitemap.xml (einschließlich index) für Ihre spätere Analyse.

Scannen Sie beliebige URL gibt es drei Möglichkeiten:

- durch einfügen einer Liste von URLS aus der Zwischenablage

- der Start von der Festplatte Datei-Format *.txt und *.xml, die Listen mit URLS

- durch das herunterladen der Datei Sitemap.xml direkt von der Website

Die Besonderheit dieses Modus ist, dass beim Scannen von beliebigen URL selbst "Projekt" nicht im Programm gespeichert und die Daten darauf nicht Hinzugefügt. Ebenfalls nicht verfügbar sind in den Abschnitten "Struktur der Website" und "Armaturenbrett".

Mehr vertraut mit der Arbeit der Punkt "Import-URL" können Sie in diesem Artikel: Überblick über die neue Version SiteAnalyzer 1.9.

Dashboard

Registerkarte "Dashboard" zeigt einen ausführlichen Bericht über die aktuelle Qualität der Optimierung des Angebotes. Der Bericht wird generiert auf der Grundlage der Daten der Registerkarte "Statistik SEO". Zusätzlich zu diesen Daten im Bericht vorhanden Angabe der Allgemeinen Website-Optimierung des Qualitätsfaktors, berechnet nach der 100-Punkte-Skala relativ zum aktuellen Grad der Optimierung. Besteht die Möglichkeit des datenexports der Registerkarte "Dashboard" in einem handlichen PDF-Bericht.

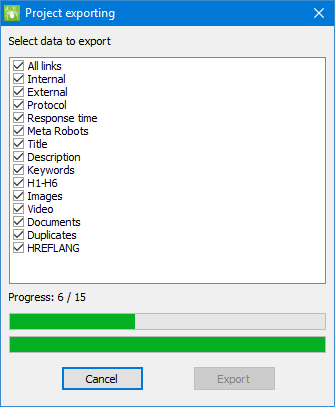

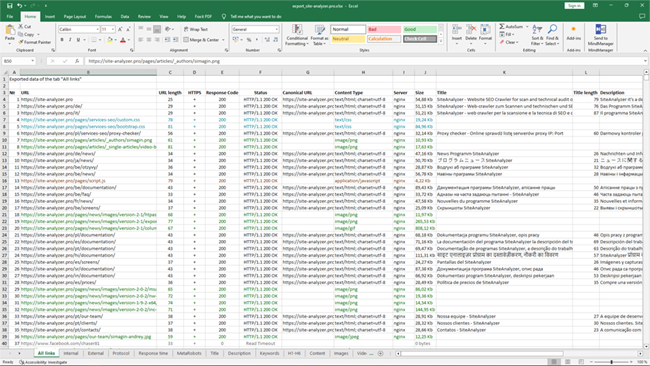

Exportieren von Daten

Für flexiblere Analysen der gewonnenen Daten besteht die Möglichkeit Ihre Upload im CSV-Format (exportiert das aktuelle aktive Registerkarte), sowie die Erzeugung der volle Bericht in Microsoft Excel mit allen Registerkarten in einer einzigen Datei.

Beim exportieren von Daten in Excel erscheint ein spezielles Fenster, in dem der Benutzer wählen Sie die gewünschten Spalten und dann einen Bericht mit den gewünschten Daten.

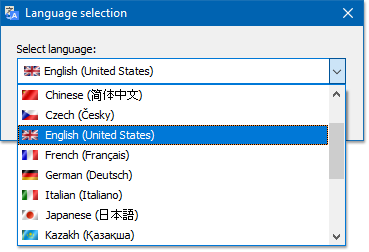

Mehrsprachigkeit

Das Programm hat die Möglichkeit zur Auswahl der bevorzugten Sprache, in der Sie arbeiten möchten.

Die wichtigsten unterstützten Sprachen: Russisch, Englisch, Deutsch, Italienisch, Spanisch, Französisch... im Moment ist das Programm übersetzt mehr als fünfzehn (15) die beliebtesten Sprachen.

Wenn Sie übersetzen das Programm in Ihre Muttersprache, dann ist es genug, zu übersetzen jede Datei "*.lng" auf der gewünschten Sprache, dann übersetzte Sie die Datei, senden an die Adresse "support@site-analyzer.pro" (Kommentar zum Brief sollte geschrieben werden auf Deutsch oder Englisch) und Ihre übersetzung wird in die neue Version des Programms.

Detaillierte Anleitung für die übersetzung des Programms in andere Sprachen liegt in der Distribution (Datei "lcids.txt").

P.S. Wenn Sie irgendwelche Kommentare über die Qualität der übersetzung - senden Sie Kommentare und Korrekturen an "support@site-analyzer.ru".

Datenbankkomprimierung

Der Hauptmenüpunkt "Datenbank Komprimieren" ist für die Durchführung der Operation Verpackungs-Datenbank (Reinigung Basis von zuvor gelöschten Projekte sowie organisieren von Daten (Analog Defragmentierung von Daten auf PCs)).

Dieses Verfahren ist wirksam in dem Fall, wenn Z. B. aus dem Programm entfernt wurde ein großes Projekt enthält eine große Anzahl von Datensätzen. In der Regel wird empfohlen, eine periodische Kompression von Daten für die Befreiung von redundanten Daten und eine Reduzierung der Basis.

Mit den Antworten auf die übrigen Fragen finden Sie unter FAQ >>