Wielu specjalistów SEO w swojej praktyce spotkało się z niechęcią wyszukiwarek do indeksowania niektórych stron witryny, podczas gdy w 90% przypadków przyczyny tych problemów są banalne: przypadkowe zamknięcie stron w robotach.txt, zakaz indeksowania przez meta robots, wadliwe kanoniki i tym podobne opcje.

Jednak nie wystarczy znaleźć i wyeliminować przyczynę nieprawidłowego indeksowania. Po jego wyeliminowaniu konieczne jest jak najszybsze przesłanie ważnych treści do ponownego indeksowania i upewnienie się, że witryna i interesujące strony zaczęły być indeksowane.

W tym artykule udostępnimy wszystkie znalezione Opcje indeksowania stron w wyszukiwarce Google.

Sposoby przyspieszenia indeksowania w Google

1. Google Search Console (GSC)

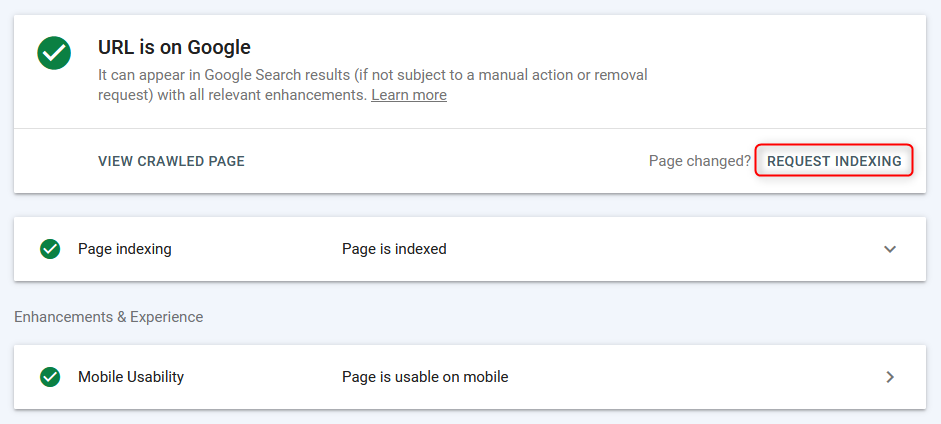

Najczęstszym sposobem indeksowania / ponownego indeksowania stron w trybie "ręcznym" jest panel webmastera Google.

Strony są indeksowane szybko (od kilku sekund do pojawienia się w wyszukiwaniu), jednak praca odbywa się w trybie paginacji + Bot wyszukiwania potrzebuje czasu na zindeksowanie strony, więc ta metoda jest skuteczna, ale nie najwygodniejsza, ponieważ nie można natychmiast załadować listy z grupy adresów URL i wysłać do indeksowania zbiorczego.

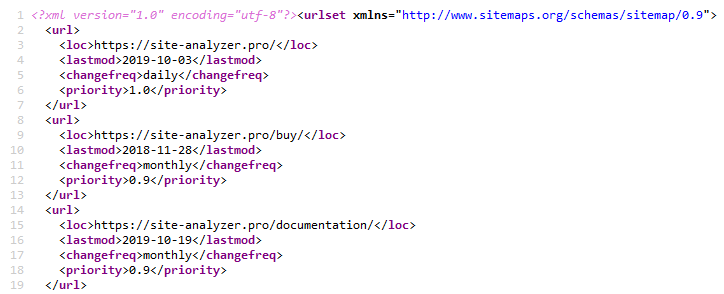

2. Sitemap.xml

Korzystanie z mapy witryny XML to klasyczna metoda przyspieszania indeksowania nowych stron. Jest to realizowane poprzez wskazanie hiperłącza do pliku mapy witryny Sitemap.xml w pliku Robots.txt (oczywiście wcześniej musisz utworzyć sam plik mapy witryny.xml).. Sitemap.xml »

Zwykle jest to wystarczające dla każdego rodzaju witryny.

Aby utworzyć mapę witryny, istnieje wiele różnych wtyczek do popularnego CMS, można ją również utworzyć za pomocą jednego z robotów internetowych lub stacjonarnych, na przykład za pośrednictwem bezpłatnego siteanalyzer.. SiteAnalyzer »

3. Pingowanie Mapy Witryny.xml

Pingowanie powoduje, że robot indeksujący dokonuje szybkiego przekierowania mapy witryny.xml. Jest to rodzaj analogu dodawania mapy witryny do Google Search Console. W ten sposób wysyłamy do Google dodatkowy sygnał o konieczności ponownego indeksowania mapy witryny, co w ten sposób przyspiesza prawdopodobieństwo indeksowania stron (nie jest to jednak fakt, że bot od razu chce je ominąć).

Linki do pingowania mapy witryny w Google i Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Ustawianie przekierowań 301 ze stron witryny o ruchu

To rozwiązanie pozwala częściowo przenieść statyczną wagę i ruch z wysokiej jakości witryny do witryny, która wymaga większej uwagi botów wyszukiwania lub ma problemy z jej indeksowaniem.

Przekierowywałem ze strony "Wiadomości" witryny o dobrym ruchu do podobnej strony witryny, która miała problemy z indeksowaniem. Przekierowanie zostało" uwzględnione " przez Google drugiego dnia, a strona witryny dawcy zniknęła z indeksu Google.

Po zindeksowaniu strony akceptora witryny przekierowanie można usunąć.

5. Usunięcie strony z webmastera Google i ponowne dodanie strony

Pomysł polegał na tym, aby wyszukiwarka zwróciła "uwagę" na stronę, a tym samym ponownie przeszła przez strony.

Eksperyment nie zadziałał, ponieważ po ponownym dodaniu projektu robots natychmiast się w nim wyświetlał.txt i inne wcześniej zastosowane ustawienia-najwyraźniej po usunięciu strona po prostu zniknęła z listy, a następnie po ponownym "dodaniu" została ponownie wyświetlona.

6. Całkowite zamknięcie witryny przed indeksowaniem

Zamykamy witrynę od Google w robots.txt do całkowitego deindeksowania.

W czasie testów w indeksie wisi "pierwsza" wersja strony z WWW i bez zapisanej kopii (młoda strona). Na odkrycie zaktualizowanej wersji robots.txt Google zajęło 1-2 godziny. Po 2 dniach jedyna wcześniej zindeksowana strona zniknęła z indeksu. Strona ma 0 stron w wyszukiwarce Google.

Po całkowitym deindeksowaniu otwarto roboty.txt dla bota Google.

Jednak sądząc po logach, Bot wchodził raz dziennie, więc wchodził raz dziennie i kontynuował. Ogólnie rzecz biorąc, częstotliwość odwiedzania strony przez bota Google nie zmieniła się.

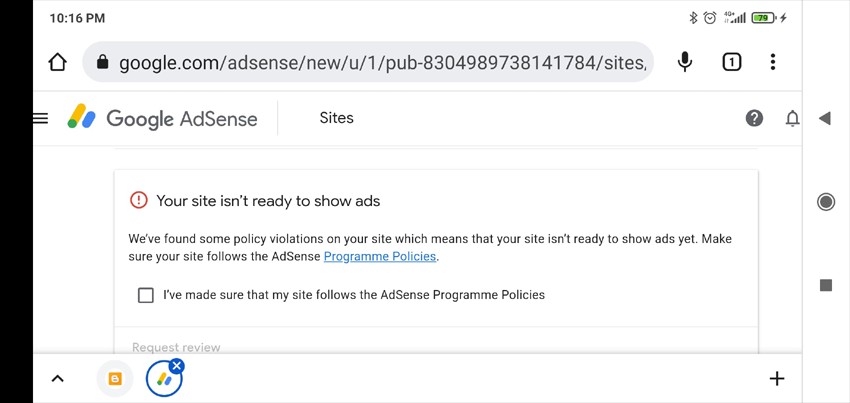

7. Dodawanie reklam do Google AdSense

Zwykle, jeśli witryna nie jest moderowana w Google AdSense, na koncie osobistym pojawia się lista możliwych powodów, dla których witryna nie została zaakceptowana (weryfikacja trwa do dwóch tygodni, Zajęło mi to półtora). Informacje te mogą pomóc w ustaleniu przyczyn, co jest nie tak z witryną.

Co w ogóle się stało-strona nie została przyjęta z adnotacją "mało przydatna treść".

Nie sądzę, aby niski poziom indeksowania witryny był z tym związany. Ale przynajmniej otrzymaliśmy mniej lub bardziej sensowną odpowiedź, która może się przydać innym razem (na przykład w celu ustalenia sankcji nałożonych na witrynę).

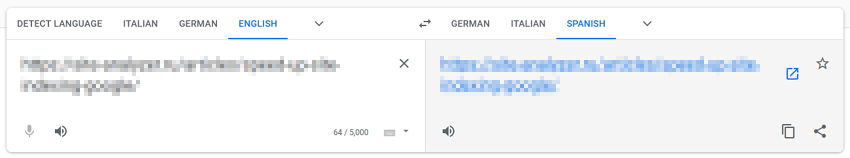

8. Przekierowanie za pośrednictwem tłumacza Google

Ta metoda opiera się na założeniu, że "uruchamiając" strony za pośrednictwem usług Google, zwracamy na nie dodatkową uwagę botów wyszukiwania.

Wklejamy adres URL witryny do Tłumacza Google, klikamy link z tłumaczeniem strony, trzymamy kciuki i mamy nadzieję na cud.

W moim przypadku cud się nie wydarzył.

9. Kierujemy ruch z sieci społecznościowych i telegramów

Aby przyspieszyć indeksowanie witryny, możesz udostępniać posty w sieciach społecznościowych (Twitter, Facebook, Linkedin itp.) lub publikując posty w Telegramie (w rzeczywistości jest to to samo, co przyciąganie ruchu z sieci społecznościowych, ale odbywa się poprzez umieszczanie linków do witryny z postów reklamowych na kanałach tematycznych).

W tej chwili linki z sieci społecznościowych nie są indeksowane przez wyszukiwarki i nie są brane pod uwagę w rankingach, więc ta opcja przyspieszenia indeksowania witryny najprawdopodobniej nie będzie skuteczna, jednak może przyciągnąć ruch "na żywo" do witryny, dzięki czemu boty Wyszukiwarek będą odwiedzać ją częściej i indeksować więcej treści.

10. Ruch z kontekstu

Tworzymy kampanie reklamowe w Google AdWords i kierujemy ruch na strony docelowe, aby szybciej je indeksować, aby boty Wyszukiwarek częściej odwiedzały strony witryny, zwiększając w ten sposób prawdopodobieństwo ich indeksowania.

11. Sprawdzanie optymalizacji mobilnej w Google Search Console

Używamy strony testowej mobilnej wersji witryny, aby wskazać botowi nowe strony: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Ponownie, hipoteza, że wysyłając Google dodatkowy sygnał do przekierowania stron witryny za pomocą narzędzia do testowania wersji mobilnej, zwróci większą uwagę na witrynę. Nie jestem jednak pewien, czy daje to jakikolwiek namacalny rezultat.

12. Ruch z Pinteresta

Pinterest jest popularnym rynkiem treści na Zachodzie, co czyni go atrakcyjnym nie tylko dla odwiedzających, ale także dla botów wyszukiwarek. Jest stale "zamieszkany" przez boty wyszukiwania, zwłaszcza boty Google, więc poprzez proste tworzenie pinów możesz skierować bota Google na interesujące strony witryny.

W moim przypadku nie przyniosło to rezultatów.

13. Uruchom za pomocą masowych indeksatorów opartych na kartach przeglądarki Google Chrome

O ile wiem, Jeśli ten temat kiedyś działał (usługa IndexGator i jej odpowiedniki), to teraz jest absolutnie martwy.

I zgodnie z logami serwera-po takiej indeksacji robot nie wszedł na stronę.

14. Tworzenie Mapy Witryny.txt

Plik Sitemap.txt jest uproszczoną wersją mapy witryny Sitemap.xml. Zasadniczo jest to ta sama lista adresów URL witryny, ale bez określania dodatkowych atrybutów (lastmod, priority, frequency).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Ta opcja jest mniej powszechna niż zwykła Mapa witryny.xml, ale mimo to podczas dodawania odwołania do niego w robotach.txt, boty zaczynają go skanować nie mniej chętnie niż zwykła Mapa witryny.

15. Połączenie wewnętrzne

Przyspieszenie indeksowania poprzez umieszczanie linków do nowych stron witryny ze stron "hubowych" (strony o dużym ruchu / wadze).

Zwykle w tym celu pisze się skrypt, który pobiera wiązki niezindeksowanych linków z wcześniej przygotowanej listy i umieszcza je na szczególnie odwiedzanych stronach. Po zindeksowaniu stron umieszczany jest następny blok linków i tak dalej. Indeksowanie jest sprawdzane za pośrednictwem różnych usług lub za pośrednictwem interfejsu API Google Webmaster Tools.

16. Budowanie zewnętrznej masy referencyjnej

Google uznaje, że strony są godne zaufania, jeśli prowadzą do nich linki z renomowanych witryn.

Obecność linków zwrotnych informuje Google, że strony są ważne i powinny być indeksowane.

W ten sposób, budując wysokiej jakości zewnętrzną masę linków do promowanych stron i całej witryny, można zasygnalizować Google, że dana witryna musi zwracać większą uwagę i częściej przeszukiwać treść.

17. Kreatywna metoda z Flickr (Case Viktor Karpenko)

Utwórz konto w serwisie fotograficznym Flickr, prześlij tam wiele zdjęć (tysiące, a najlepiej dziesiątki tysięcy) - nie ma znaczenia, skąd bierzemy zdjęcie, możesz nawet użyć innych hostingów zdjęć, Instagramów itp.

Pod każdym zdjęciem piszemy, że używając zdjęcia, musisz umieścić link zwrotny do promowanej witryny (nie zapomnij wspomnieć o jej adresie URL).

W rezultacie można uzyskać bezpłatny ruch i dziesiątki linków miesięcznie z dobrych witryn i mediów.

Uwaga. Przykład dotyczy bardziej budowania linków, ale pozwala także kierować ruch na określone strony w Twojej witrynie, a tym samym poprawiać ich indeksowanie.

18. Indeksowanie za pomocą Google Indexing API

Wyciskanie instrukcji dla PHP od użytkownika Mahmood:

- Rejestrujemy konto usługi w Google Cloud, otrzymujemy klucz dostępu (plik json), nadajemy uprawnienia konta usługi do konsoli Serch, włączamy API w Google Cloud.

- Utwórz skrypt PHP, z którego adres URL zostanie dodany do indeksu.

- Pobierz z Github klienta do pracy z API: https://github.com/googleapis/google-api-php-client

- Kod do wsadowego dodawania żądań:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- W odpowiedzi $batch->execute() wysyła tablicę według liczby linków w żądaniu (jeśli odpowiedź Zawiera\Google \ Service \ Exception, to kod 429 to przekroczenie limitu, 403 to problemy z kluczem dostępu lub włączeniem api, 400 to krzywe dane).

- Link do opisu błędów: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- Nie zapomnij powiązać konta API z konsolą Google + ustawić się jako właściciel (właściciel), w przeciwnym razie skrypt nie będzie działał (w tablicy pojawi się błąd 404, że nie ma dostępu do indeksowania witryny - Odmowa uprawnień. Failed to verify the URL ownership).

Uwaga: napisanie skryptu zajęło mi ~40 minut, w tym czas na drobne "wtyczki" i błędy w Google.

19. Blokowanie dostępu do bota Google (sprawa Vladimir Verhinin)

Zauważyłem, że słabo dodaje się na jednym z projektów dokumentów do indeksu Google. Kręcili, kręcili-wszystko bez sensu.

Pośrednio pojawiła się hipoteza, że boty nie mogą uzyskać czegoś z zasobów, ponieważ są odcinane w warstwie usług ochrony DDoS.

Dodaliśmy listę / ipranges / do białej listy Usługi Ochrony DDoS 26, a już 27-go otrzymaliśmy +50k dokumentów w indeksie, a obecnie w ciągu 15 dni mamy już +300K dokumentów w indeksie.

Większość" latających "dokumentów leżała w GSC jako" zeskanowane, ale jeszcze nie zindeksowane".

Odniesienie do zakresu adresów IP botów Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Napisz Do Johna Muellera

Tweetuj do Johna Muellera, opisz swój problem, trzymaj kciuki i czekaj na odpowiedź. Twitter »

W moim przypadku to nie zadziałało, nikt mi nie odpowiedział, w indeksie nie pojawiły się żadne nowe strony. Dziwne, oczywiście, no cóż.

Ale kto wie, możesz mieć szczęście )

***

Wydaje się, że nie ma już znanych opcji przyspieszenia indeksowania zarówno nowych, jak i starych stron. Jeśli jednak nagle coś przeoczyłem, proszę o podzielenie się własnymi przypadkami i przykładami w komentarzach - chętnie uzupełnię je artykułem.

P.S. IndexNow. Aby uzyskać pełny zakres tematu, warto wspomnieć o stosunkowo nowej możliwości masowego indeksowania stron za pośrednictwem IndexNow (otwarty interfejs API z możliwością dodawania do indeksu wyszukiwarek do 10 000 stron dziennie). Obecnie obsługiwane są wyszukiwarki Yandex i Bing. Możliwe, że dołączenie wyszukiwarki Google do tej technologii jest tuż za rogiem, chociaż jeśli technologia ma teraz małą armię krytyków, kto wie, czy w przyszłości się rozwinie.

Inne artykuły

1,287

1,287