Banyak spesialis SEO dalam praktiknya telah menghadapi keengganan mesin pencari untuk mengindeks halaman tertentu dari situs, sementara dalam 90% kasus penyebab masalah ini dangkal: penutupan halaman yang tidak disengaja dalam robot.txt, larangan pengindeksan melalui robot meta, kanon yang salah, dan opsi serupa.

Namun, tidak cukup hanya menemukan dan menghilangkan penyebab pengindeksan yang salah. Setelah eliminasi, perlu untuk mengirim konten penting untuk pengindeksan ulang sesegera mungkin dan memastikan bahwa situs dan halaman yang menarik telah diindeks.

Pada artikel ini, kami akan membagikan semua opsi yang ditemukan untuk mengindeks halaman di mesin pencari Google.

Cara mempercepat pengindeksan di Google

1. Google Search Console (GSC)

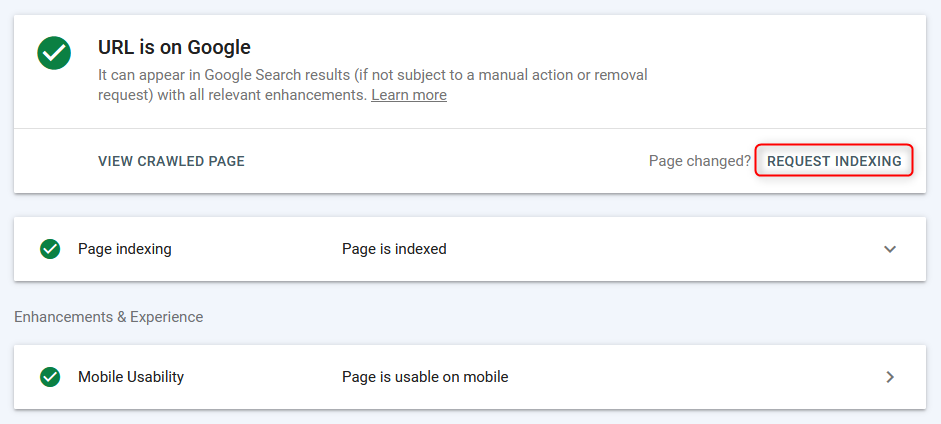

Cara paling umum untuk mengindeks / mengindeks ulang halaman dalam mode "manual" adalah melalui panel webmaster Google.

Halaman diindeks dengan cepat (dari beberapa detik sebelum muncul dalam pencarian), namun, pekerjaan berlangsung dalam mode halaman demi halaman + butuh waktu bagi bot pencarian untuk memindai halaman, jadi metode ini efektif, tetapi bukan yang paling nyaman, karena Anda tidak dapat segera mengunduh daftar dari sekelompok URL dan mengirimkannya untuk pengindeksan massal.

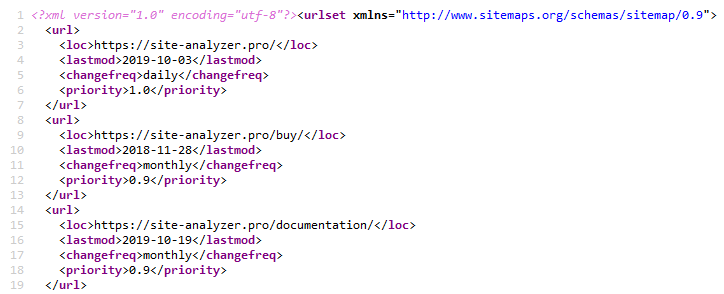

2. Sitemap.xml

Menggunakan peta situs XML adalah metode klasik untuk mempercepat pengindeksan halaman baru. Ini diimplementasikan dengan menentukan hyperlink ke peta situs File Peta situs.xml dalam file Robot.txt (tentu saja, sebelum melakukan ini, Anda perlu membuat file itu sendiri Sitemap.xml ).. Sitemap.xml »

Ini biasanya cukup untuk semua jenis situs.

Untuk membuat peta situs, ada banyak plugin berbeda pada CMS populer, itu juga dapat dibuat menggunakan salah satu perayap web atau desktop, misalnya, melalui SiteAnalyzer gratis.. SiteAnalyzer »

3. Ping Sitemap.xml

Ping memaksa robot pencarian untuk membuat reindex operasional Sitemap Anda.xml . Ini adalah semacam analog menambahkan peta situs ke Google Search Console. Jadi, kami mengirim Google sinyal tambahan tentang perlunya mengindeks ulang peta situs, yang dengan demikian mempercepat kemungkinan pengindeksan halaman (namun, bukan fakta bahwa bot akan segera terburu-buru untuk melewatinya).

Tautan untuk ping peta situs di Google dan Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Instalasi 301 pengalihan dari halaman situs lalu lintas

Solusi ini memungkinkan Anda untuk mentransfer sebagian bobot statis dan lalu lintas dari situs berkualitas tinggi ke situs yang membutuhkan lebih banyak perhatian dari Bot pencarian, atau ada masalah dengan pengindeksannya.

Saya mengarahkan ulang dari halaman" Berita " Situs dengan lalu lintas yang baik ke halaman serupa dari situs yang memiliki masalah dengan pengindeksan. Pengalihan itu" diperhitungkan " oleh Google pada hari kedua dan halaman situs donor menghilang dari indeks Google.

Setelah halaman situs akseptor diindeks, pengalihan dapat dihapus.

5. Menghapus situs dari Google Webmaster dan menambahkan situs lagi

Idenya adalah agar mesin pencari membayar" perhatian " ke situs dan, dengan demikian, menelusuri halaman lagi.

Eksperimen tidak berhasil, karena ketika proyek ditambahkan lagi, ia segera menampilkan robot.txt dan pengaturan lain yang diterapkan sebelumnya - tampaknya, ketika situs dihapus, itu menghilang begitu saja dari daftar, dan kemudian ketika "ditambahkan" lagi, itu ditampilkan lagi.

6. Penutupan lengkap situs dari pengindeksan

Menutup situs dari Google di robot.txt untuk lengkap De-pengindeksan.

Pada saat pengujian, versi "pertama" dari halaman dengan WWW dan tanpa salinan yang disimpan menggantung di indeks (situs muda). Untuk Mendeteksi Robot versi terbaru.txt butuh Google 1-2 jam. Setelah 2 hari, satu-satunya halaman yang diindeks sebelumnya menghilang dari indeks. Situs ini memiliki 0 halaman tersisa di pencarian Google.

Setelah selesai de-pengindeksan , itu dibuka robot.txt untuk bot Google.

Namun, dilihat dari lognya, bot masuk sekali sehari, dan terus masuk sekali sehari. Pada umumnya, frekuensi kunjungan ke situs oleh bot Google tidak berubah.

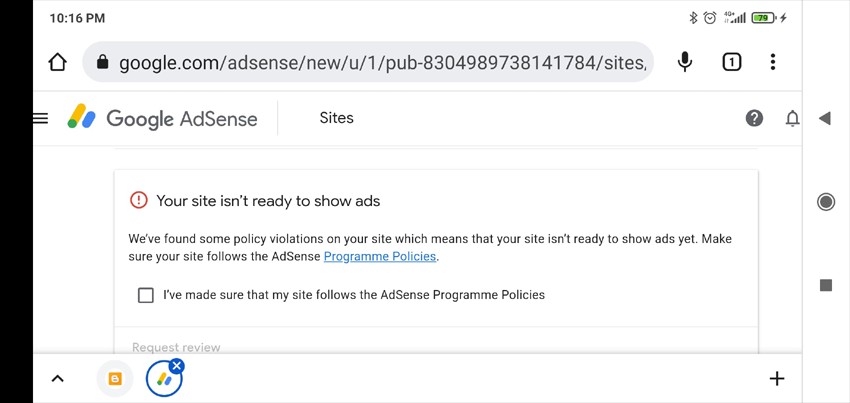

7. Menambahkan iklan ke Google AdSense

Biasanya, jika sebuah situs tidak lulus moderasi di Google AdSense, maka daftar kemungkinan alasan mengapa situs itu tidak diterima muncul di akun pribadi (verifikasi memakan waktu hingga dua minggu, saya butuh satu setengah). Informasi ini dapat membantu menentukan alasan apa yang salah dengan situs.

Yang, secara umum, terjadi - situs itu tidak diterima dengan tanda "konten tidak berguna".

Saya tidak berpikir bahwa tingkat pengindeksan situs yang rendah dikaitkan dengan ini. Tetapi setidaknya kami mendapat jawaban yang kurang lebih masuk akal, yang mungkin berguna di lain waktu (misalnya, untuk menentukan sanksi yang dikenakan di situs).

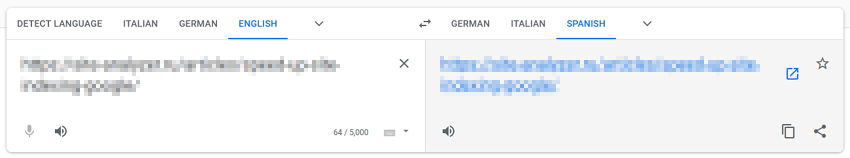

8. Mengindeks ulang melalui Google Terjemahan

Metode ini didasarkan pada asumsi bahwa dengan "menjalankan" halaman melalui Layanan Google, kami memberikan perhatian tambahan kepada mereka dengan Bot pencarian.

Kami memasukkan URL situs ke Penerjemah Google, mengikuti tautan dengan terjemahan halaman, menyilangkan jari dan berharap keajaiban.

Dalam kasus saya, keajaiban tidak terjadi.

9. Kami mengarahkan lalu lintas dari jejaring sosial dan Telegram

Untuk mempercepat pengindeksan situs, Anda dapat berbagi publikasi di jejaring sosial (Twitter, Facebook, Linkedin, dll.), atau dengan memposting posting di Telegram (sebenarnya, ini sama dengan menarik lalu lintas dari jejaring sosial, tetapi itu terjadi dengan menempatkan tautan ke situs dari posting iklan di saluran tematik).

Saat ini, tautan dari jejaring sosial tidak diindeks oleh mesin pencari dan tidak diperhitungkan dalam peringkat, jadi opsi untuk mempercepat pengindeksan situs ini kemungkinan besar tidak efektif, namun dapat menarik lalu lintas "langsung" ke situs, karena bot pencarian akan mengunjunginya lebih sering dan mengindeks lebih banyak konten.

10. Lalu lintas dari konteks

Kami membuat kampanye iklan di Google AdWords dan mengarahkan lalu lintas ke halaman arahan untuk pengindeksan yang lebih cepat, sehingga Bot pencarian mengunjungi halaman situs lebih sering, sehingga meningkatkan kemungkinan pengindeksan mereka.

11. Memeriksa pengoptimalan seluler di Google Search Console

Kami menggunakan halaman pengujian versi seluler situs untuk memberi tahu bot tentang halaman baru: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Sekali lagi, hipotesisnya adalah bahwa dengan mengirimkan sinyal tambahan kepada Google untuk mengindeks ulang halaman situs melalui alat pengujian versi seluler, itu akan lebih memperhatikan situs tersebut. Namun, saya tidak yakin bahwa ini memberikan setidaknya beberapa hasil nyata.

12. Lalu lintas dari Pinterest

Pinterest adalah platform konten populer di Barat, yang membuatnya menarik tidak hanya bagi pengunjung, tetapi juga untuk bot mesin pencari. Itu terus-menerus" dihuni " oleh bot pencarian, terutama bot Google, jadi hanya dengan membuat PIN, Anda dapat mengarahkan bot Google ke halaman situs yang menarik.

Dalam kasus saya, itu tidak memberikan hasil.

13. Jalankan melalui pengindeks massal berdasarkan tab browser Google Chrome

Sejauh yang saya tahu, jika topik ini pernah berhasil (layanan IndexGator dan analognya), sekarang sudah benar-benar mati.

Dan menurut log server-setelah pengindeksan seperti itu, robot tidak memasuki Situs.

14. Pembuatan Sitemap.txt

Peta Situs Berkas.txt ini adalah versi sederhana dari peta situs Sitemap.xml. Sebenarnya, ini masih daftar URL situs yang sama, tetapi tanpa menentukan atribut tambahan (lastmod, prioritas, frekuensi).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Opsi ini kurang umum daripada yang biasa peta situs.xml, tetapi, bagaimanapun, ketika menambahkan tautan ke robot.bot txt mulai memindainya tidak kurang dari peta situs biasa.

15. Tautan Internal

Percepatan pengindeksan dengan menempatkan link ke halaman situs baru dari "hub" halaman (halaman dengan lalu lintas tinggi / berat).

Biasanya, skrip ditulis untuk ini, yang mengambil kumpulan tautan yang tidak diindeks dari daftar yang telah disiapkan sebelumnya dan menempatkannya di halaman yang dikunjungi secara khusus. Setelah mengindeks halaman, blok tautan berikutnya ditempatkan, dan seterusnya. Pengindeksan diperiksa melalui berbagai layanan atau melalui Google Webmaster Tools API.

16. Membangun massa referensi eksternal

Google mengakui bahwa halaman dapat dipercaya jika ditautkan dari situs terkemuka.

Kehadiran backlink memberi tahu Google bahwa halaman itu penting dan harus diindeks.

Jadi, dengan meningkatkan massa tautan eksternal berkualitas tinggi ke halaman yang dipromosikan dan ke situs secara keseluruhan, Anda dapat memberi sinyal kepada Google bahwa situs ini perlu lebih memperhatikan dan mencuri konten lebih sering.

17. Metode kreatif menggunakan Flickr (kasus Viktor Karpenko)

Kami membuat akun di Hosting Foto Flickr, mengunggah banyak foto di sana (ribuan, atau lebih baik Puluhan Ribu) - Kami mengambil foto di mana pun, Anda bahkan dapat menggunakan situs hosting foto lain, Instagram, dll.

Di bawah setiap foto, kami menulis bahwa saat menggunakan foto, Anda perlu memasang tautan balik ke situs yang Anda promosikan (jangan lupa sebutkan URL-nya).

Hasilnya, Anda bisa mendapatkan lalu lintas gratis dan lusinan tautan setiap bulan dari situs dan media yang bagus.

Catatan. Contohnya lebih terkait dengan Pembuatan Tautan, tetapi juga memungkinkan Anda mengarahkan lalu lintas ke halaman tertentu di situs Anda dan dengan demikian meningkatkan pengindeksannya.

18. Pengindeksan Menggunakan Google Indexing API

Squeeze instruksi untuk PHP dari pengguna Mahmud:

- Kami mendaftarkan akun layanan di Google Cloud, mendapatkan kunci akses (file json), memberikan hak akun layanan ke konsol layanan, mengaktifkan API di Google Cloud.

- Membuat skrip PHP dari mana URL akan ditambahkan ke indeks.

- Unduh klien dari Github untuk bekerja dengan api: https://github.com/googleapis/google-api-php-client

- Kode untuk permintaan penambahan batch:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- Sebagai tanggapan, $batch->execute() mengirimkan array dengan jumlah tautan dalam permintaan (jika ada \Google\Service dalam respons\Exception, maka kode 429 - melebihi batas, 403 - masalah dengan kunci akses atau mengaktifkan api, 400-kurva data).

- Tautan ke deskripsi kesalahan: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- Jangan lupa untuk menautkan akun API ke Konsol Google + mengekspos diri Anda sebagai pemilik, jika tidak skrip tidak akan berfungsi (kesalahan 404 akan datang dalam array bahwa tidak ada akses untuk mengindeks situs - Izin ditolak. Gagal memverifikasi kepemilikan URL).

Catatan: Saya butuh ~40 menit untuk menulis skrip, termasuk waktu untuk kesalahan "plugging" dan googling kecil.

19. Memblokir akses ke bot Google (kasus Vladimir Vershinin)

Saya perhatikan bahwa dokumen ditambahkan dengan buruk ke indeks Google di salah satu proyek. Memutar, memutar - mutar-semuanya sia-sia.

Menurut tanda-tanda tidak langsung, hipotesis telah muncul bahwa bot tidak dapat memperoleh sesuatu dari sumber daya, karena mereka terputus pada tingkat layanan perlindungan DDoS.

Kami menambahkan daftar/ ipranges / ke daftar putih Layanan Perlindungan DDoS pada tanggal 26, dan sudah pada tanggal 27 Kami menerima +50 ribu dokumen dalam indeks, dan saat ini dalam 15 hari +300 ribu dokumen dalam indeks.

Sebagian besar dokumen " diterbangkan "berada di GSC sebagai"dipindai, tetapi belum diindeks".

Tautan ke kisaran alamat IP bot Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Menulis untuk John Mueller

Tweet John Mueller, jelaskan masalah Anda, silangkan jari Anda dan tunggu jawaban. Twitter »

Dalam kasus saya, itu tidak berhasil, tidak ada yang menjawab saya, tidak ada halaman baru yang muncul di indeks. Aneh, tentu saja, tapi oke.

Tapi, siapa tahu, mungkin Anda akan beruntung )

***

Tampaknya tidak ada lagi opsi yang diketahui untuk mempercepat pengindeksan halaman baru dan lama. Namun, jika saya tiba - tiba melewatkan sesuatu, saya meminta Anda untuk membagikan kasus dan contoh Anda sendiri di komentar-saya akan dengan senang hati menambahkannya ke artikel.

P.S. IndexNow. Untuk sepenuhnya membahas topik, perlu disebutkan kemungkinan pengindeksan massal halaman yang relatif baru melalui IndexNow (API terbuka dengan kemampuan untuk menambahkan hingga 10.000 halaman per hari ke indeks mesin pencari). Saat ini, mesin pencari Yandex dan Bing didukung. Ada kemungkinan bahwa penggabungan mesin pencari Google dengan teknologi ini tidak jauh, meskipun jika teknologi tersebut sudah memiliki sedikit kritik, siapa yang tahu apakah itu akan dikembangkan di masa depan.

Artikel lainnya

878

878