Tujuan program

Program SiteAnalyzer dirancang untuk menganalisis situs dan mengidentifikasi kesalahan teknis (mencari tautan yang rusak, halaman duplikat, tanggapan server yang salah), serta kesalahan dan kekurangan dalam pengoptimalan SEO (tag meta kosong, kelebihan atau kekurangan judul halaman h1, analisis konten halaman, kualitas tautan, dan banyak parameter SEO lainnya).

Fitur utama

- Memindai semua halaman situs, serta gambar, skrip, dan dokumen

- Mendapatkan kode respons server untuk setiap halaman situs (200, 301, 302, 404, 500, 503, dll.)

- Menentukan keberadaan dan isi Judul, Kata Kunci, Deskripsi, H1-H6

- Menemukan dan menampilkan halaman "duplikat", tag meta, dan judul

- Menentukan keberadaan atribut rel="canonical" untuk setiap halaman situs

- Mengikuti arahan dari file "robots.txt", tag meta "robots", atau X-Robots-Tag

- Akuntansi untuk "noindex" dan "nofollow" saat merayapi halaman situs

- Pengikisan data dengan XPath, CSS, XQuery, RegEx

- Memeriksa keunikan konten dalam situs

- Google PageSpeed Memeriksa Kecepatan Pemuatan Halaman

- Analisis tautan: penentuan tautan internal dan eksternal untuk halaman situs mana pun

- Perhitungan PageRank internal untuk setiap halaman situs

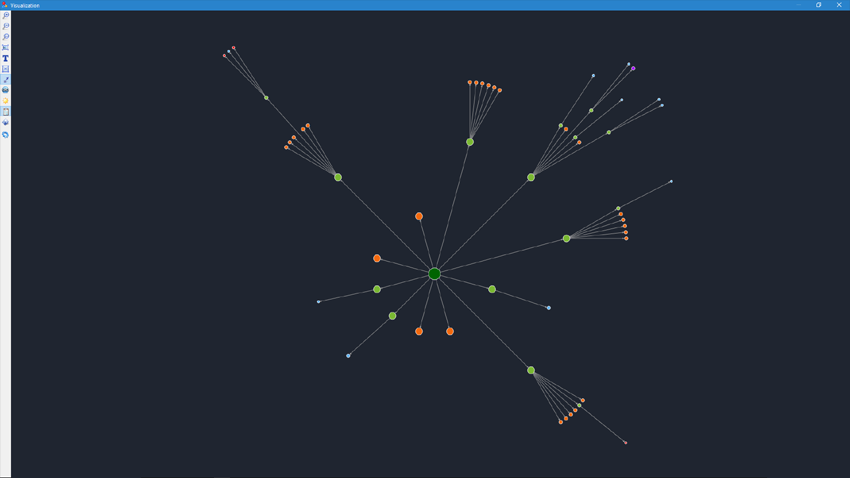

- Visualisasi struktur situs pada grafik

- Menentukan jumlah redirect dari halaman (redirect)

- Merangkak URL arbitrer dan Sitemap.xml eksternal

- Pembuatan peta situs "sitemap.xml" (dengan kemungkinan dipecah menjadi beberapa file)

- Memfilter data dengan parameter apa pun (pengaturan filter yang fleksibel dengan kompleksitas apa pun)

- Cari konten sewenang-wenang di situs

- Ekspor laporan ke format CSV, Excel, dan PDF

Perbedaan dari analog

- Persyaratan rendah untuk sumber daya komputer, konsumsi RAM rendah

- Memindai situs dengan volume apa pun karena persyaratan sumber daya komputer yang rendah

- Format portabel (berfungsi tanpa instalasi pada PC atau langsung dari media yang dapat dipindahkan)

Bagian dokumentasi

- Awal kerja

- Pengaturan program

- pengaturan dasar

- Memindai

- SEO

- Robots.txt Virtual new

- Yandex XML

- Agen pengguna

- Header HTTP sewenang-wenang new

- Server proxy

- Kecualikan URL

- Ikuti URL

- PageRank

- Otorisasi

- Bekerja dengan program

- Menyesuaikan kolom dan tab

- Penyaringan data

- Statistik teknis situs web

- Statistik SEO

- Custom Filters

- Custom Search

- Pengikisan data

- Memeriksa keunikan konten

- Memeriksa kecepatan pemuatan halaman

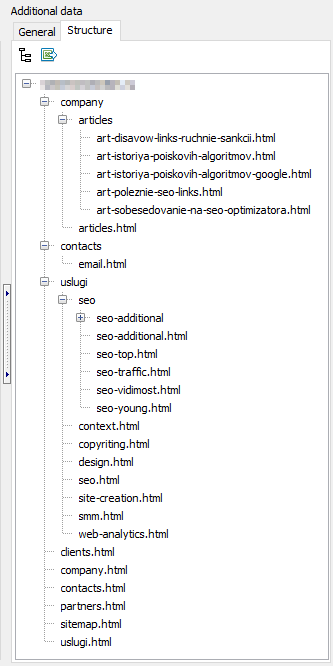

- Struktur situs

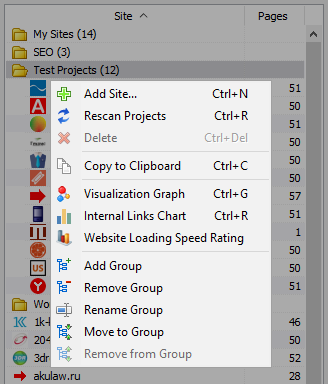

- Menu konteks daftar proyek

- Visualisasi struktur situs

- Tautan Bagan Distribusi

- Bagan kecepatan pemuatan halaman

- Pembuatan peta situs.xml

- Merangkak URL arbitrer

- Dashboard

- Ekspor data

- Multibahasa

- Kompresi basis data

Awal kerja

Saat program diluncurkan, pengguna memiliki akses ke bilah alamat untuk memasukkan URL situs yang sedang dianalisis (Anda dapat memasuki halaman situs mana pun, karena robot pencari, mengikuti tautan halaman sumber, akan melewati seluruh situs, termasuk halaman utama, dengan syarat semua tautan dibuat dalam HTML dan tidak menggunakan Javascript).

Setelah menekan tombol "Mulai", robot pencari mulai merayapi semua halaman situs menggunakan tautan internal (tidak menuju ke sumber daya eksternal, juga tidak mengikuti tautan yang dibuat dalam Javascript).

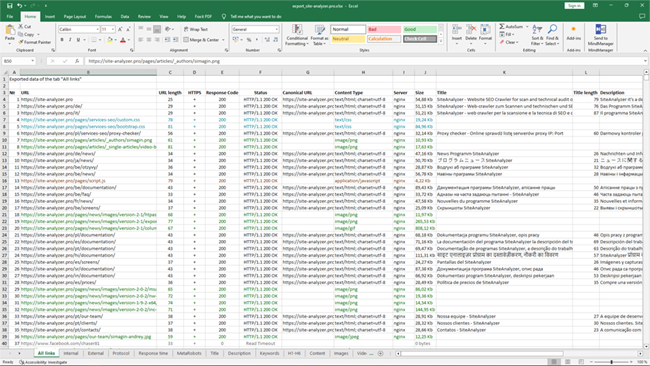

Setelah robot menelusuri semua halaman situs, tersedia laporan, dibuat dalam bentuk tabel dan menampilkan data yang diterima, dikelompokkan berdasarkan tab tematik.

Semua proyek yang dianalisis ditampilkan di sisi kiri program dan secara otomatis disimpan dalam database program bersama dengan data yang diterima. Untuk menghapus situs yang tidak perlu, gunakan menu konteks dari daftar proyek.

Catatan:

- ketika Anda mengklik tombol "Jeda", pemindaian proyek ditangguhkan, secara paralel, kemajuan pemindaian saat ini disimpan ke database, yang memungkinkan, misalnya, untuk menutup program dan melanjutkan pemindaian proyek setelah memulai ulang program dari titik berhenti

- tombol "Stop" menginterupsi pemindaian proyek saat ini tanpa kemungkinan melanjutkan pemindaiannya

Pengaturan program

Bagian "Pengaturan" dari menu utama dimaksudkan untuk menyempurnakan operasi program dengan situs eksternal dan berisi 7 tab:

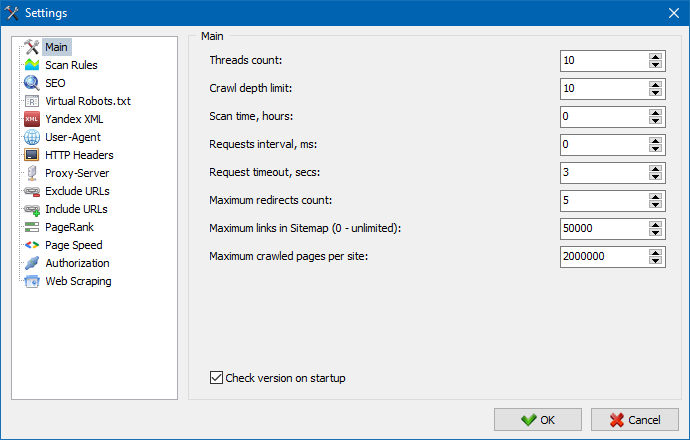

Bagian pengaturan utama digunakan untuk menentukan arahan pengguna program yang digunakan saat memindai situs.

Deskripsi parameter:

- Jumlah utas

- Semakin besar jumlah utas, semakin banyak URL yang dapat diproses per unit waktu. Harus diperhitungkan bahwa lebih banyak utas mengarah ke lebih banyak sumber daya PC yang digunakan. Disarankan untuk mengatur jumlah utas di kisaran 5-10.

- Waktu pemindaian

- Ini digunakan untuk menetapkan batas waktu perayapan situs. Diukur dalam jam.

- Kedalaman Maks

- Parameter ini digunakan untuk menentukan kedalaman perayapan situs. Halaman utama situs memiliki tingkat bersarang = 0. Misalnya, jika Anda perlu merayapi halaman situs seperti "somedomain.ru/catalog.html" dan "somedomain.ru/catalog/product.html", maka dalam hal ini jika Anda perlu mengatur nilai kedalaman maksimum = 2 .

- Keterlambatan antara permintaan

- Berfungsi untuk mengatur jeda saat pemindai mengakses halaman situs. Ini mungkin diperlukan untuk situs dengan hosting "lemah" yang tidak dapat menahan beban berat dan sering mengaksesnya.

- Minta batas waktu

- Atur waktu untuk menunggu respons situs terhadap permintaan program. Jika beberapa halaman situs merespons dengan lambat (membutuhkan waktu lama untuk memuat), maka pemindaian situs mungkin memakan waktu yang cukup lama. Halaman tersebut dapat dipotong dengan menentukan nilai, setelah itu crawler akan melanjutkan untuk menjelajah halaman situs yang tersisa dan dengan demikian tidak akan menunda kemajuan keseluruhan.

- Jumlah halaman situs yang dirayapi

- Batasi jumlah maksimum halaman yang dipindai. Ini dapat berguna jika, misalnya, Anda perlu merayapi N halaman pertama situs (ini tidak memperhitungkan gambar, file gaya, skrip, dan jenis file lainnya).

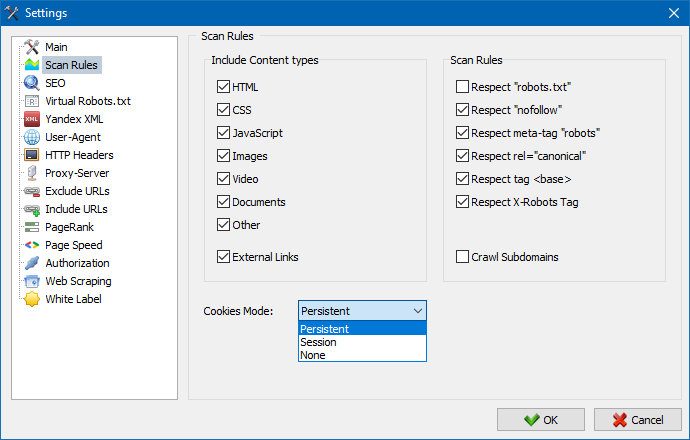

Pertimbangkan konten

- Di bagian ini, Anda dapat memilih jenis data yang akan diperhitungkan oleh pengurai saat merayapi halaman (gambar, video, gaya, skrip), atau mengecualikan informasi yang tidak perlu saat penguraian.

Aturan pemindaian

- Pengaturan ini terkait dengan pengaturan pengecualian saat merayapi situs oleh pemindai menggunakan file "robots.txt", menggunakan tautan jenis "nofollow", serta menggunakan arahan "meta name=robots" langsung di kode halaman situs.

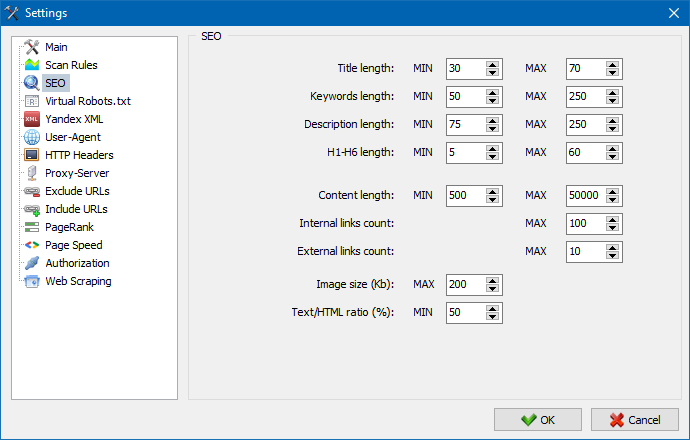

Bagian ini digunakan untuk menunjukkan parameter SEO utama yang dianalisis, yang nantinya akan diperiksa kebenarannya saat mem-parsing halaman, setelah itu statistik yang dihasilkan akan ditampilkan pada tab "Statistik SEO" di bagian kanan jendela program utama.

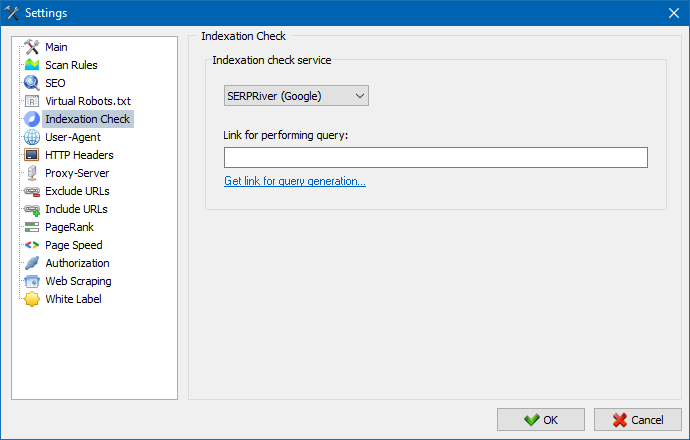

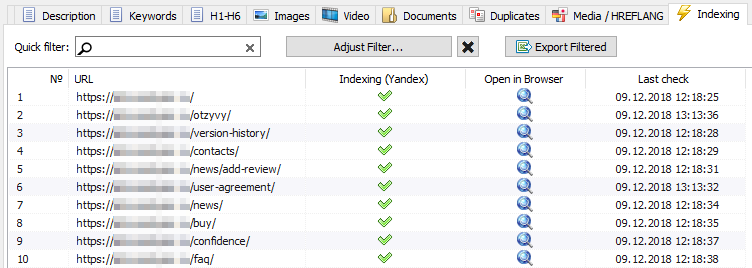

Dengan menggunakan pengaturan ini, Anda dapat memilih layanan di mana pengindeksan halaman akan diperiksa di mesin pencari Yandex. Ada dua opsi untuk memeriksa pengindeksan: menggunakan layanan «a href="https://xml.yandex.ru/settings/" target="_blank" rel="nofollow"»Yandex XML«/a» atau layanan «a href="http://www.majento.ru/index.php?page=account-tasks/xml_options_help" target="_blank" rel="nofollow"»Majento.ru«/a» .

Saat memilih layanan "Yandex XML", Anda perlu mempertimbangkan kemungkinan pembatasan (setiap jam atau setiap hari) yang dapat diterapkan saat memeriksa pengindeksan halaman, relatif terhadap batas yang ada pada akun Yandex Anda, sebagai akibat dari situasi yang sering muncul ketika batas akun Anda tidak akan cukup untuk memeriksa semua halaman sekaligus dan untuk ini Anda harus menunggu satu jam berikutnya.

Saat menggunakan layanan Majento.ru, praktis tidak ada batas per jam atau harian, karena batas Anda benar-benar mengalir ke kumpulan batas umum, yang tidak kecil dengan sendirinya, dan juga memiliki batas yang jauh lebih besar untuk batas per jam daripada yang mana pun. akun pengguna individu di Yandex. XML".

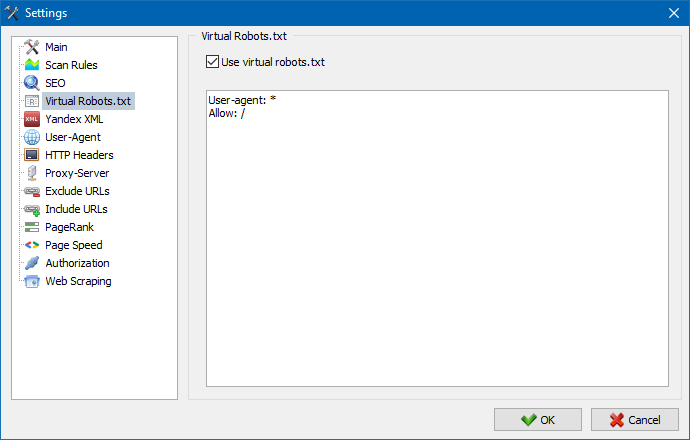

Robots.txt virtual dapat digunakan sebagai pengganti robots.txt asli yang dihosting di situs.

Ini bisa nyaman saat menguji situs, ketika, misalnya, Anda perlu merayapi bagian tertentu dari situs yang ditutup dari pengindeksan (atau sebaliknya - jangan memperhitungkannya saat merayapi), sementara Anda tidak perlu secara fisik buat perubahan pada robots.txt asli dan buang waktu pengembang untuk ini.

Catatan: saat mengimpor daftar URL, arahan robots.txt virtual diperhitungkan (jika opsi ini diaktifkan), jika tidak, tidak ada robots.txt untuk daftar URL yang diperhitungkan.

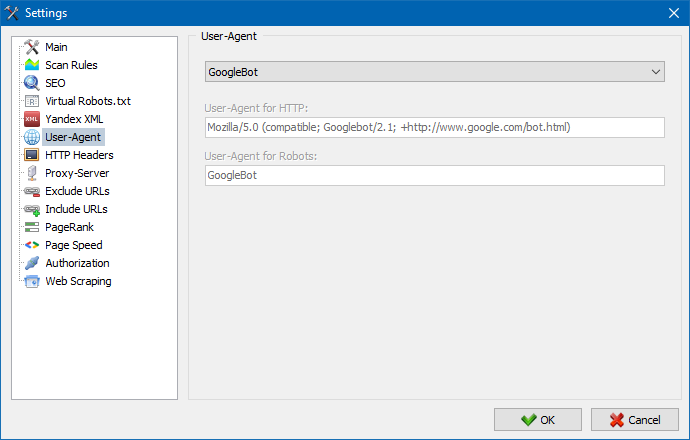

Di bagian Agen-Pengguna, Anda dapat menentukan agen pengguna mana yang akan diwakili oleh program saat mengakses situs eksternal selama pemindaian. Secara default, agen pengguna kustom diinstal, tetapi jika perlu, Anda dapat memilih salah satu agen standar yang paling umum ditemukan di Internet. Diantaranya adalah seperti: bot mesin pencari YandexBot, GoogleBot, MicrosoftEdge, bot browser Chrome, Firefox, IE8, serta perangkat seluler iPhone, Android dan banyak lainnya.

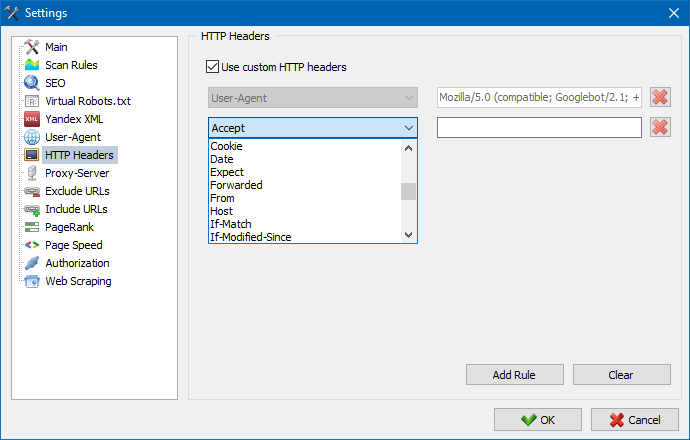

Dengan menggunakan opsi ini, Anda dapat menganalisis reaksi situs dan halaman terhadap permintaan yang berbeda. Misalnya, seseorang mungkin perlu mengirim Referer dalam permintaan, pemilik situs multibahasa ingin mengirim Accept-Language|Charset|Encoding, dan seseorang mungkin perlu mengirim data yang tidak biasa di header Accept-Encoding, Cache-Control, Pragma , dll. P.

Dengan menggunakan opsi ini, Anda dapat menganalisis reaksi situs dan halaman terhadap permintaan yang berbeda. Misalnya, seseorang mungkin perlu mengirim Referer dalam permintaan, pemilik situs multibahasa ingin mengirim Accept-Language|Charset|Encoding, dan seseorang mungkin perlu mengirim data yang tidak biasa di header Accept-Encoding, Cache-Control, Pragma , dll. P.

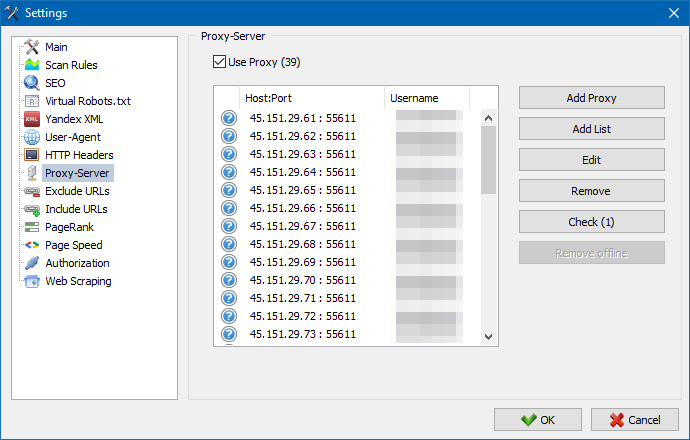

Jika ada kebutuhan untuk bekerja melalui proxy, maka di bagian ini Anda dapat menambahkan daftar server proxy yang melaluinya program akan mengakses sumber daya eksternal. Selain itu, dimungkinkan untuk memeriksa proxy untuk operabilitas, serta fungsi menghapus server proxy yang tidak aktif.

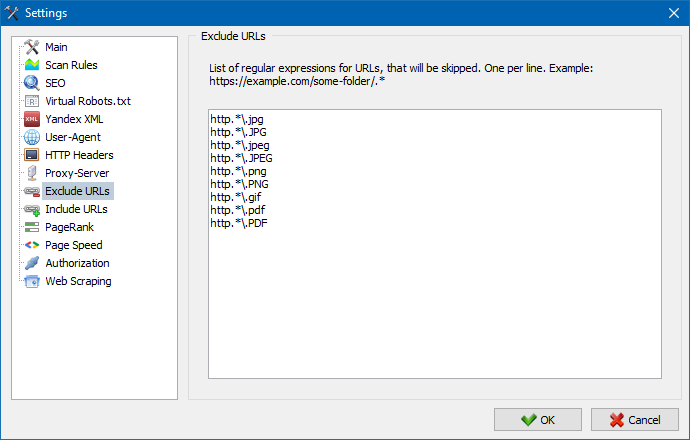

Bagian ini dirancang untuk menghindari melewati halaman dan bagian tertentu dari situs saat parsing.

Menggunakan pola pencarian * dan ? Anda dapat menentukan bagian situs mana yang tidak boleh dirayapi oleh pemindai dan, karenanya, tidak boleh disertakan dalam basis data program. Daftar ini adalah daftar pengecualian lokal untuk waktu pemindaian situs (relatif terhadapnya, daftar "global" adalah file "robots.txt" di root situs).

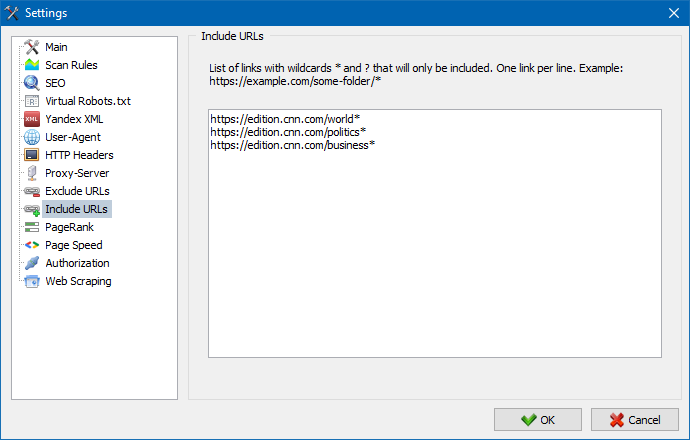

Demikian pula, ini memungkinkan Anda untuk menambahkan URL yang harus dirayapi. Dalam hal ini, semua URL lain di luar folder ini akan diabaikan selama pemindaian. Opsi ini juga berfungsi dengan pola pencarian * dan ?

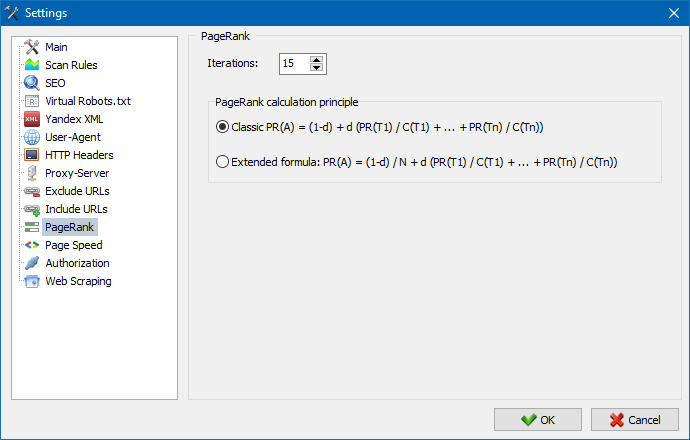

Dengan menggunakan parameter PageRank, Anda dapat menganalisis struktur navigasi situs Anda, serta mengoptimalkan sistem tautan internal sumber daya web untuk mentransfer jus tautan ke halaman yang paling penting.

Program ini memiliki dua opsi untuk menghitung PageRank: algoritme klasik dan padanannya yang lebih modern. Secara umum, untuk analisis tautan internal situs, tidak ada banyak perbedaan saat menggunakan algoritme pertama atau kedua, sehingga Anda dapat menggunakan salah satu dari dua algoritme yang diusulkan.

Untuk penjelasan rinci tentang algoritma dan prinsip untuk menghitung PageRank, baca artikel ini: >>

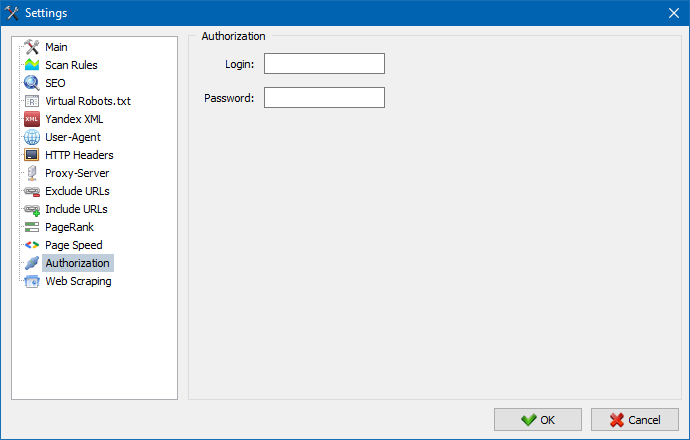

Memasukkan login dan kata sandi untuk otorisasi otomatis pada halaman yang ditutup melalui .htpasswd dan dilindungi oleh otorisasi server BASIC.

Bekerja dengan program

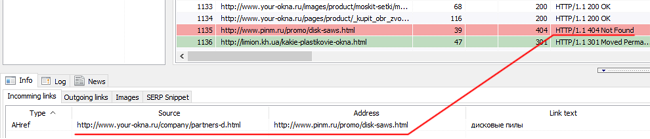

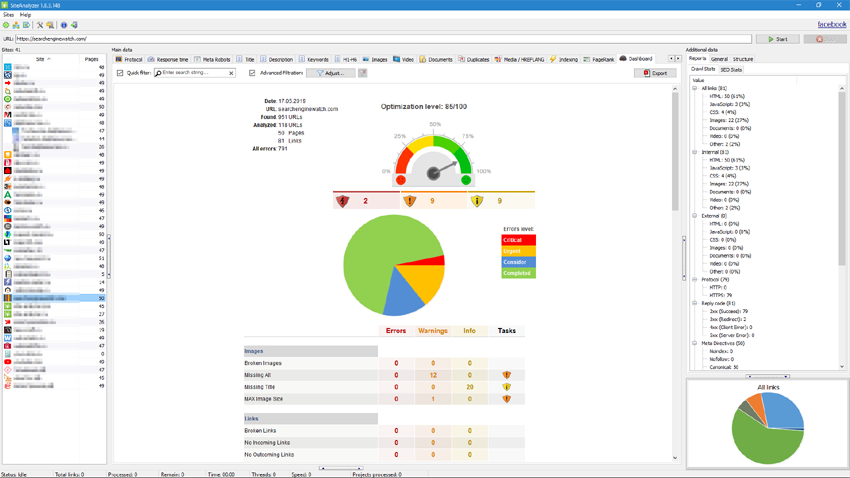

Setelah pemindaian selesai, informasi yang ditempatkan di blok "Data dasar" tersedia bagi pengguna. Setiap tab berisi data yang dikelompokkan berdasarkan judulnya (misalnya, tab "Judul" berisi konten judul halaman«title»«/title» , tab "Gambar" berisi daftar semua gambar situs, dan seterusnya). Dengan menggunakan data ini, Anda dapat menganalisis konten situs, menemukan tautan "rusak" atau tag meta yang salah diisi.

Jika perlu (misalnya, setelah membuat perubahan di situs), menggunakan menu konteks, Anda dapat memindai ulang setiap URL untuk menampilkan perubahan dalam program.

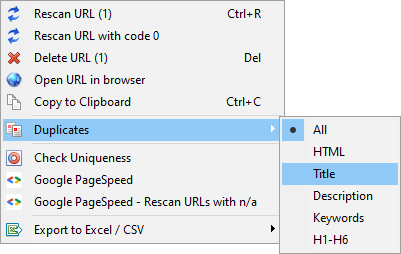

Menggunakan menu yang sama, Anda dapat menampilkan halaman duplikat sesuai dengan parameter yang relevan (judul duplikat, deskripsi, kata kunci, h1, h2, konten halaman).

Item "Perayapan ulang URL dengan kode 0" dirancang untuk secara otomatis memeriksa ulang semua halaman yang mengembalikan kode respons 0 (Baca Timeout). Kode respons ini biasanya diberikan ketika server tidak punya waktu untuk mengembalikan konten dan koneksi ditutup oleh batas waktu, masing-masing, halaman tidak dapat dimuat dan informasi tidak dapat diambil darinya.

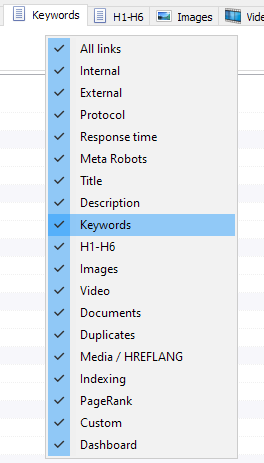

Sekarang Anda dapat memilih tab mana yang akan ditampilkan di antarmuka data utama (akhirnya, menjadi mungkin untuk mengucapkan selamat tinggal pada tab Kata Kunci Meta yang sudah usang). Ini berguna jika tab tidak muat di layar, atau Anda jarang menggunakannya.

Kolom juga dapat disembunyikan atau dipindahkan ke lokasi yang diinginkan dengan menyeret.

Tampilan tab dan kolom dapat dikonfigurasi dengan memanggil menu konteks pada panel data utama. Kolom dipindahkan menggunakan mouse.

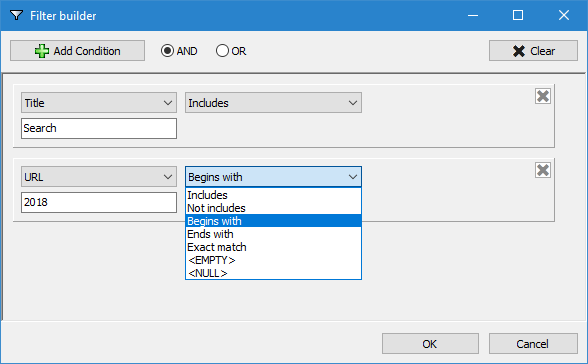

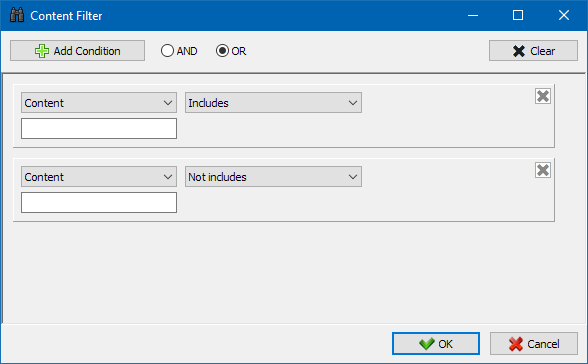

Untuk analisis statistik situs yang lebih nyaman, pemfilteran data tersedia dalam program. Filtrasi tersedia dalam dua versi:

- oleh bidang apa pun menggunakan filter "cepat"

- menggunakan filter khusus (menggunakan setelan pengambilan sampel data lanjutan)

Filter cepat

Digunakan untuk memfilter data dengan cepat dan menerapkan secara bersamaan ke semua bidang tab saat ini.

Filter khusus

Dirancang untuk pemfilteran terperinci dan dapat berisi beberapa kondisi pada saat yang bersamaan. Misalnya, untuk tag meta "judul", Anda ingin memfilter halaman menurut panjangnya sehingga tidak melebihi 70 karakter dan berisi teks "berita" pada saat yang bersamaan. Maka filternya akan terlihat seperti ini:

Jadi, dengan menerapkan filter khusus ke salah satu tab, Anda bisa mendapatkan sampel data dengan kerumitan apa pun.

Tab statistik teknis situs terletak di panel "Data tambahan" dan berisi serangkaian parameter teknis utama situs: statistik tautan, tag meta, kode respons halaman, parameter pengindeksan halaman, jenis konten, dll. parameter.

Dengan mengklik salah satu parameter, mereka secara otomatis disaring di tab yang sesuai dari data utama situs, dan statistik juga secara bersamaan ditampilkan pada diagram di bagian bawah halaman.

Tab statistik SEO dirancang untuk audit situs lengkap dan berisi 50+ parameter SEO dasar dan mengidentifikasi lebih dari 60 kesalahan pengoptimalan internal utama! Tampilan kesalahan dibagi menjadi beberapa kelompok, yang, pada gilirannya, berisi kumpulan parameter yang dianalisis dan filter yang mendeteksi kesalahan di situs.

Penjelasan rinci tentang semua parameter yang diperiksa dapat ditemukan di artikel ini: >>

Semua hasil pemfilteran dapat dengan cepat diekspor ke Excel tanpa dialog tambahan (laporan disimpan dalam folder dengan program).

Tab ini berisi filter prasetel yang memungkinkan Anda membuat pilihan untuk semua tautan eksternal, 404 kesalahan, gambar, dan parameter lain dengan semua halaman yang menampilkannya. Dengan demikian, sekarang Anda dapat dengan mudah dan cepat mendapatkan daftar tautan eksternal dan halaman di mana mereka berada, atau memilih semua tautan yang rusak dan segera melihat halaman mana mereka berada.

Semua laporan tersedia online dalam program dan ditampilkan pada tab "Kustom" pada panel data utama. Selain itu, dimungkinkan untuk mengekspornya ke Excel melalui menu utama.

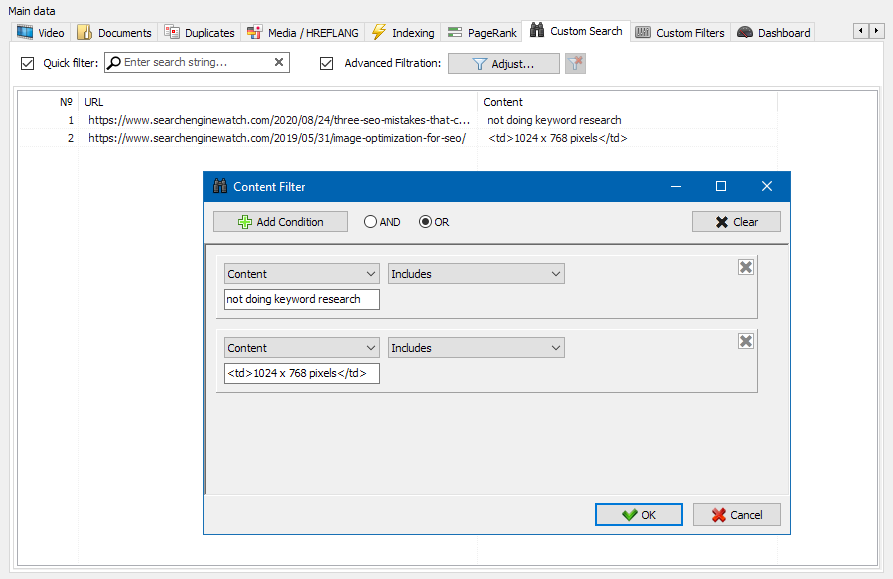

Fitur pencarian konten situs memungkinkan Anda untuk mencari melalui kode sumber dan menampilkan halaman web yang berisi konten yang Anda cari.

Modul filter khusus memungkinkan Anda memeriksa keberadaan markup mikro, tag meta, sistem analitik, fragmen teks arbitrer, atau kode HTML di situs.

Jendela konfigurasi filter memiliki beberapa opsi untuk mencari fragmen teks tertentu pada halaman situs, atau, sebaliknya, untuk mengecualikan halaman yang berisi teks tertentu atau fragmen kode HTML dari hasil pencarian (fungsi ini mirip dengan mencari konten di kode sumber halaman menggunakan Ctrl-F).

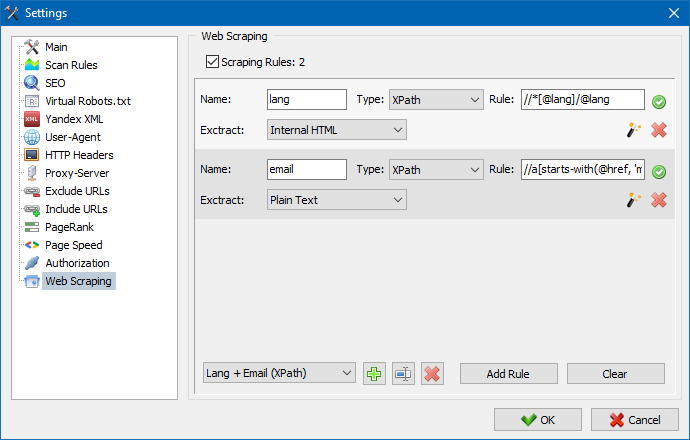

Scraping biasanya digunakan untuk menyelesaikan tugas-tugas yang sulit ditangani secara manual. Ini dapat berupa mengekstrak deskripsi produk untuk membuat toko online baru, menggali riset pemasaran untuk memantau harga, atau untuk memantau iklan.

Di SiteAnalyzer, tab "Ekstraksi Data" bertanggung jawab untuk menyiapkan pengikisan, di mana aturan ekstraksi dikonfigurasi. Aturan dapat disimpan dan, jika perlu, diedit.

Ada juga modul pengujian aturan. Dengan menggunakan debugger aturan bawaan, Anda dapat dengan cepat dan mudah mendapatkan konten HTML dari halaman mana pun di situs dan menguji pengoperasian permintaan, lalu menggunakan aturan yang di-debug untuk mengurai data di SiteAnalyzer.

Setelah ekstraksi data selesai, semua informasi yang dikumpulkan dapat diekspor ke Excel.

Anda dapat mempelajari lebih lanjut tentang pengoperasian modul dan berkenalan dengan daftar aturan paling umum dan ekspresi reguler di artikel

Alat ini memungkinkan Anda untuk mencari halaman duplikat dan memeriksa keunikan teks di dalam situs. Dengan kata lain, ini adalah pemeriksaan batch sekelompok URL untuk keunikan di antara mereka sendiri.

Ini dapat berguna dalam kasus:

- Untuk mencari duplikat halaman yang lengkap (misalnya halaman dengan parameter dan halaman yang sama, tetapi dalam bentuk CNC).

- Untuk mencari kecocokan sebagian konten (misalnya, dua resep borscht di blog makanan yang 96% mirip satu sama lain, yang menunjukkan bahwa salah satu artikel harus dihapus untuk menghilangkan kemungkinan kanibalisasi lalu lintas).

- Ketika di situs artikel Anda secara tidak sengaja menulis artikel tentang topik yang sudah Anda tulis 10 tahun yang lalu. Dalam hal ini, alat kami juga akan mendeteksi duplikat artikel semacam itu.

Prinsip pengoperasian alat pemeriksa keunikan konten sederhana: program mengunduh konten mereka dari daftar URL situs, menerima konten teks halaman (tanpa blok HEAD dan tanpa tag HTML), dan kemudian membandingkannya satu sama lain menggunakan algoritma shingle.

Jadi, dengan bantuan shingles, kami menentukan keunikan halaman dan dapat menghitung duplikat halaman penuh dengan keunikan 0%, dan duplikat parsial dengan tingkat keunikan konten teks yang berbeda. Program ini bekerja dengan panjang sirap 5.

Anda dapat mempelajari lebih lanjut tentang pengoperasian modul di artikel ini.: >>

Memeriksa kecepatan pemuatan halaman

Alat PageSpeed Insights dari raksasa pencarian Google memungkinkan Anda untuk memeriksa kecepatan pemuatan elemen halaman tertentu, dan juga menunjukkan skor kecepatan pemuatan keseluruhan dari URL yang menarik untuk versi desktop dan seluler dari browser.

Alat Google bagus untuk semua orang, namun memiliki satu kelemahan signifikan - tidak memungkinkan Anda membuat pemeriksaan URL grup, yang menciptakan ketidaknyamanan saat memeriksa banyak halaman situs Anda: Anda harus mengakui bahwa memeriksa kecepatan unduh secara manual untuk 100 atau lebih banyak URL pada satu halaman suram dan dapat memakan banyak waktu.

Oleh karena itu, kami telah membuat modul yang memungkinkan Anda membuat pemeriksaan grup gratis untuk kecepatan pemuatan halaman melalui API khusus di alat Google PageSpeed Insights.

Parameter utama yang dianalisis:

- FCP (First Contentful Paint) – waktu tampilan konten pertama.

- SI (Speed Index) – ukuran seberapa cepat konten dirender pada halaman.

- LCP (Largest Contentful Paint) – waktu tampilan elemen halaman terbesar.

- TTI (Time to Interactive) – waktu di mana halaman menjadi sepenuhnya siap untuk interaksi pengguna.

- TBT (Total Blocking Time) – waktu dari rendering pertama konten hingga kesiapannya untuk interaksi pengguna.

- CLS (Cumulative Layout Shift) – pergeseran tata letak kumulatif. Berfungsi untuk mengukur kestabilan visual suatu halaman.

Pada saat yang sama, analisis URL itu sendiri terjadi hanya dalam beberapa klik, setelah itu laporan tersedia yang mencakup karakteristik utama pemeriksaan dalam bentuk yang nyaman di Excel.

Yang Anda butuhkan untuk memulai adalah mendapatkan kunci API.

Cara melakukannya dijelaskan dalam artikel ini. >>

Fungsionalitas ini dirancang untuk membuat struktur situs berdasarkan data yang diterima. Struktur situs dibuat berdasarkan kumpulan URL halaman. Setelah struktur dibuat, ekspornya ke format CSV (Excel) tersedia.

- Pemindaian massal tersedia dalam daftar proyek dengan memilih situs yang diperlukan dan mengklik tombol "Pindai Ulang". Setelah itu, semua situs diantrekan dan dipindai satu per satu dalam mode standar.

- Juga, untuk kenyamanan bekerja dengan program, penghapusan massal situs yang dipilih juga tersedia dengan mengklik tombol "Hapus".

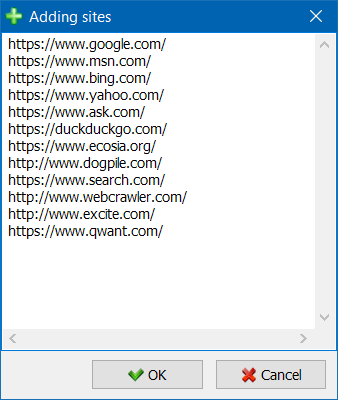

- Selain pemindaian situs tunggal, ada kemungkinan menambahkan situs secara massal ke daftar proyek menggunakan formulir khusus, setelah itu pengguna dapat memindai seluruh proyek yang diminati.

- Untuk navigasi yang lebih nyaman melalui daftar proyek, kemampuan untuk mengelompokkan situs ke dalam folder tersedia, serta memfilter daftar proyek berdasarkan nama.

Mode visualisasi tautan pada grafik akan membantu spesialis SEO mengevaluasi distribusi PageRank internal pada halaman situs, serta memahami halaman mana yang menerima massa tautan besar (dan, karenanya, lebih banyak bobot tautan internal di mata mesin telusur) , dan halaman serta bagian situs mana yang tidak kekurangan tautan internal.

Menggunakan mode visualisasi struktur situs, spesialis SEO akan dapat menilai secara visual bagaimana tautan internal diatur di situs, dan juga, karena representasi visual dari massa PageRank yang ditetapkan ke halaman tertentu, dengan cepat membuat penyesuaian pada tautan situs saat ini. dan dengan demikian meningkatkan relevansi halaman yang menarik.

Bagian kiri jendela visualisasi berisi alat utama untuk bekerja dengan grafik:

- mengubah skala pada grafik

- rotasi grafik dengan sudut sewenang-wenang

- mengalihkan jendela grafik ke mode layar penuh (juga berfungsi dengan tombol F11)

- tampilkan/sembunyikan label simpul (Ctrl-T)

- tampilkan/sembunyikan panah di dekat garis

- tampilkan/sembunyikan tautan ke sumber daya eksternal (Ctrl-E)

- beralih mode warna Siang / Malam (Ctrl-D)

- tampilkan/sembunyikan legenda dan statistik grafik (Ctrl-L)

- menyimpan grafik ke format PNG (Ctrl-S)

- jendela pengaturan visualisasi (Ctrl-O)

Bagian "Tampilan" dimaksudkan untuk mengubah format tampilan simpul pada grafik. Dalam mode menggambar simpul "PageRank", ukuran simpul diatur relatif terhadap PageRank yang dihitung sebelumnya, menghasilkan grafik yang menunjukkan halaman mana yang mendapatkan bobot tautan paling banyak dan mana yang mendapatkan tautan paling sedikit.

Dalam mode klasik, ukuran simpul diatur relatif terhadap skala grafik visualisasi yang dipilih.

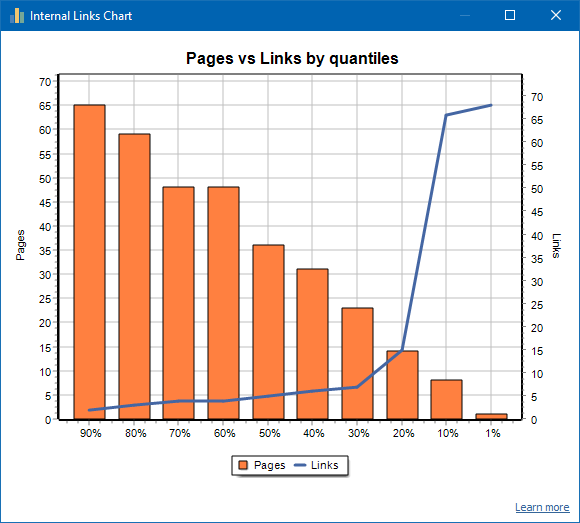

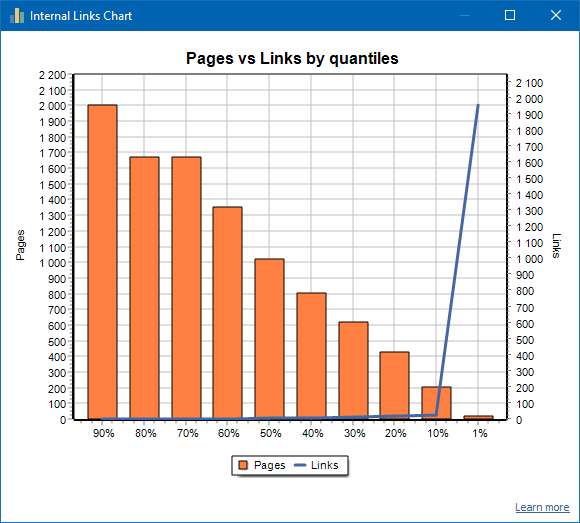

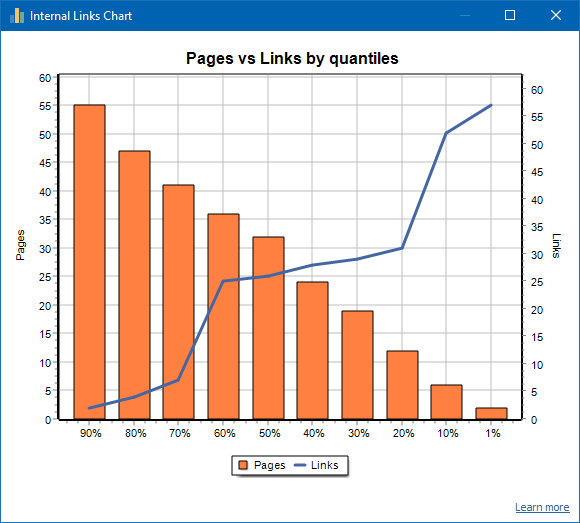

Grafik ini menunjukkan distribusi massa tautan internal pada halaman situs (kita dapat mengatakan bahwa ini adalah visualisasi tautan dalam bentuk visual, daripada disajikan pada Grafik Visualisasi). Baca lebih banyak >>

Jumlah halaman ditampilkan di sebelah kiri, jumlah tautan ditampilkan di sebelah kanan. Di bawah ini adalah kuantil persentase menurut halaman. Saat membuat grafik, tautan duplikat dibuang (jika ada 3 tautan dari halaman A ke halaman B, maka kami menghitungnya sebagai satu).

Misalnya, berdasarkan tangkapan layar di atas, untuk situs dengan sekitar 70 halaman:

- 1% halaman memiliki ~68 tautan masuk.

- 10% halaman memiliki ~66 tautan masuk.

- 20% halaman memiliki ~15 tautan masuk.

- 30% halaman memiliki ~8 tautan masuk.

- 40% halaman memiliki ~7 tautan masuk.

- 50% halaman memiliki ~6 tautan masuk.

- 60% halaman memiliki ~5 tautan masuk.

- 70% halaman memiliki ~5 tautan masuk.

- 80% halaman memiliki ~3 tautan masuk.

- 90% halaman memiliki ~2 tautan masuk.

Artinya, jika kita melihat bahwa kita memiliki halaman yang kurang dari 10 link masuk mengarah, maka kita dapat menganggap halaman tersebut sebagai link yang lemah, dan kita memiliki 60% dari halaman yang biasanya terhubung. Berdasarkan ini, kami dapat menempatkan lebih banyak tautan internal ke halaman-halaman yang tertaut lemah ini (jika halaman-halaman itu penting untuk promosi), atau membiarkannya apa adanya jika halaman-halaman tersebut tidak terlalu penting dan berprioritas rendah.

Dalam praktik umum, halaman dengan kurang dari 10 tautan internal cenderung tidak dirayapi oleh robot pencari, khususnya, bot Google.

Oleh karena itu, jika Anda melihat situs yang hanya memiliki 20-30% halaman yang biasanya ditautkan dari jumlah total halaman di situs tersebut, maka masuk akal untuk mempelajari pengaturan penautan atau memikirkan bagaimana menangani 80-70% ini. halaman yang tertaut dengan buruk (hapus, sembunyikan dari pengindeksan, alihkan).

Contoh situs yang tertaut dengan lemah:

Contoh situs yang tertaut dengan baik:

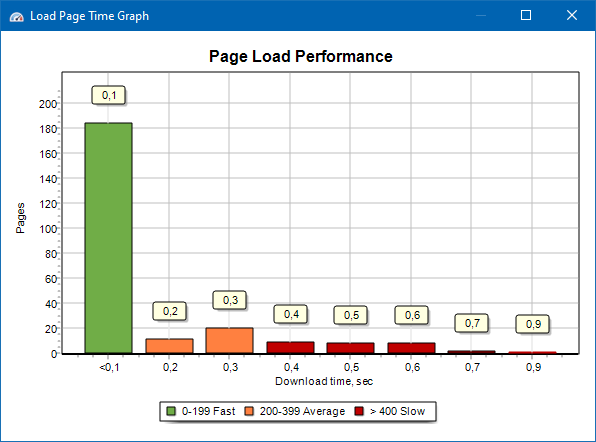

Bagan kecepatan pemuatan halaman

Grafik kecepatan pemuatan halaman memungkinkan Anda untuk mengevaluasi kinerja situs. Untuk kejelasan, halaman dibagi menjadi beberapa kelompok dan interval waktu dengan langkah 100 milidetik.

Jadi, berdasarkan grafik, dimungkinkan untuk menentukan berapa proporsi halaman situs yang dimuat dengan cepat (dalam 0-100 milidetik), mana yang dimuat dengan kecepatan rata-rata (100-200 milidetik), dan halaman mana yang memakan waktu lama. waktu untuk memuat (400 milidetik atau lebih).

Catatan: Waktu yang ditampilkan adalah waktu pemuatan kode sumber HTML, bukan waktu pemuatan halaman secara penuh (perenderan halaman, serta pemuatan elemen halaman seperti gambar dan gaya, tidak diperhitungkan).

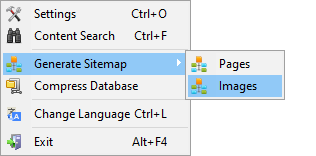

Pembuatan peta situs.xml

Peta situs dibuat berdasarkan halaman yang dipindai atau gambar situs.

- Saat membuat peta situs yang terdiri dari halaman, halaman dengan format "teks/html" ditambahkan ke dalamnya.

- Saat membuat peta situs yang terdiri dari gambar, gambar JPG, PNG, GIF, dan format serupa ditambahkan ke dalamnya.

Anda dapat membuat peta situs segera setelah memindai situs, melalui menu utama: item "Proyek -> Hasilkan Peta Situs".

Untuk situs dengan volume besar, dari 50.000 halaman, ada fungsi untuk secara otomatis membagi "sitemap.xml" menjadi beberapa file (dalam hal ini, file utama berisi tautan ke file tambahan yang berisi tautan langsung ke halaman situs). Ini karena persyaratan mesin pencari untuk memproses file peta situs yang besar.

Jika perlu, volume halaman dalam file "sitemap.xml" dapat divariasikan dengan mengubah nilai 50.000 (diatur secara default) ke nilai yang diinginkan dalam pengaturan program utama.

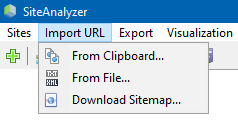

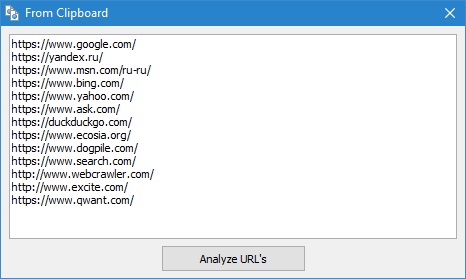

Merangkak URL arbitrer

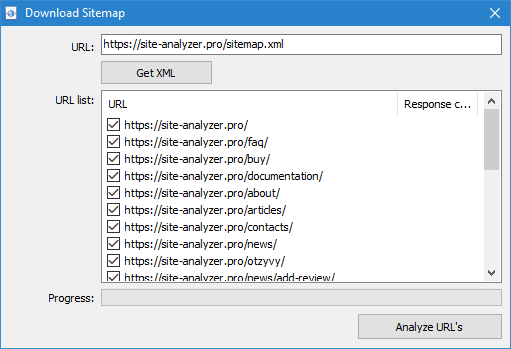

Item menu "Impor URL" dirancang untuk memindai daftar URL yang berubah-ubah, serta peta situs XML Sitemap.xml (termasuk yang indeks) untuk analisis selanjutnya.

Merangkak URL arbitrer dimungkinkan dengan tiga cara:

- dengan menempelkan daftar URL dari clipboard

- memuat file *.txt dan *.xml yang berisi daftar URL dari hard disk

- dengan mengunduh file Sitemap.xml langsung dari situs

Fitur dari mode ini adalah ketika memindai URL arbitrer, "proyek" itu sendiri tidak disimpan dalam program dan data di dalamnya tidak ditambahkan ke database. Bagian "Struktur situs" dan "Dasbor" juga tidak tersedia.

Anda dapat mempelajari lebih lanjut tentang pengoperasian item "Impor URL" di artikel ini: Ikhtisar versi baru SiteAnalyzer 1.9.

Dashboard

Tab "Dasbor" menampilkan laporan terperinci tentang kualitas pengoptimalan situs saat ini. Laporan dibuat berdasarkan data dari tab "Statistik SEO". Selain data ini, laporan berisi indikasi indeks kualitas pengoptimalan situs secara keseluruhan, yang dihitung pada skala 100 poin relatif terhadap tingkat pengoptimalannya saat ini. Dimungkinkan untuk mengekspor data dari tab "Dasbor" ke dalam laporan yang nyaman dalam format PDF.

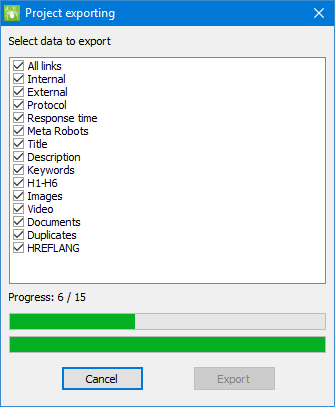

Ekspor data

Untuk analisis yang lebih fleksibel dari data yang diterima, dimungkinkan untuk mengunggahnya ke format CSV (tab aktif saat ini diekspor), serta menghasilkan laporan lengkap di Microsoft Excel dengan semua tab dalam satu file.

Saat mengekspor data ke Excel, jendela khusus muncul di mana pengguna dapat memilih kolom yang diinginkan dan kemudian membuat laporan dengan data yang diperlukan.

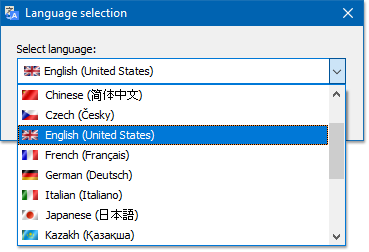

Multibahasa

Program ini memiliki kemampuan untuk memilih bahasa pilihan di mana pekerjaan akan dilakukan.

Bahasa utama yang didukung: Rusia, Inggris, Jerman, Italia, Spanyol, Prancis... Saat ini, program telah diterjemahkan ke lebih dari lima belas (15) bahasa paling populer.

Jika Anda ingin menerjemahkan program ke dalam bahasa asli Anda, maka cukup menerjemahkan file "*.lng" apa pun ke dalam bahasa yang diinginkan, setelah itu file yang diterjemahkan harus dikirim ke alamat "support@site-analyzer.pro " (komentar pada surat tersebut harus ditulis dalam bahasa Rusia atau Inggris) dan terjemahan Anda akan disertakan dalam rilis baru program.

Instruksi lebih rinci untuk menerjemahkan program ke dalam bahasa dapat ditemukan di kit distribusi (file "lcids.txt").

PS Jika Anda memiliki komentar tentang kualitas terjemahan, silakan kirim komentar dan koreksi ke "support@site-analyzer.ru".

Kompresi basis data

Item menu utama "Compress database" dirancang untuk melakukan operasi pengepakan database (membersihkan database dari proyek yang dihapus sebelumnya, serta memesan data (analog dengan defragmentasi data pada komputer pribadi)).

Prosedur ini efektif ketika, misalnya, sebuah proyek besar yang berisi sejumlah besar catatan telah dihapus dari program. Secara umum, disarankan untuk mengompresi data secara berkala untuk menghilangkan data yang berlebihan dan mengurangi ukuran database.

Jawaban atas pertanyaan lain dapat ditemukan di bagian FAQ. >>