Muchos expertos en SEO en su práctica se han encontrado con la renuencia de los motores de búsqueda a indexar ciertas páginas del sitio, y en el 90% de los casos, las causas de estos problemas son banales: el cierre accidental de páginas en robots.txt, prohibición de indexación a través de meta robots, canónicos incorrectos y opciones similares.

Sin embargo, no es suficiente encontrar y eliminar la causa de la indexación incorrecta. Después de eliminarlo, debe volver a indexar el contenido importante lo antes posible y asegurarse de que el sitio y las páginas de interés hayan comenzado a indexarse.

En este artículo, compartiremos todas las opciones encontradas para indexar páginas en el motor de búsqueda de Google.

Formas de acelerar la indexación en Google

1. Google Search Console (GSC)

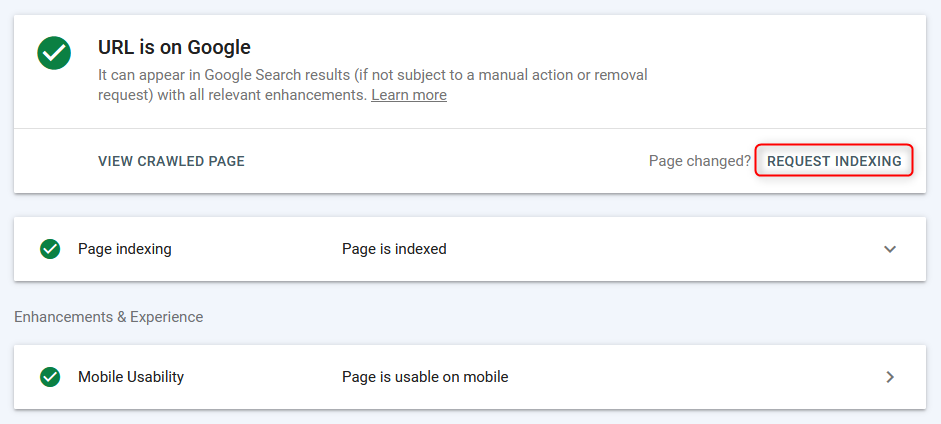

La forma más común de indexar / reindexar páginas en modo "manual" es a través del panel webmaster de Google.

Las páginas se indexan rápidamente (desde unos pocos segundos antes de aparecer en la búsqueda), sin embargo, el trabajo ocurre en el modo de página + necesita tiempo para escanear la página por el bot de búsqueda, por lo que este método es efectivo, pero no el más conveniente, ya que no puede cargar inmediatamente una lista del grupo de URL y enviarla a la indexación masiva.

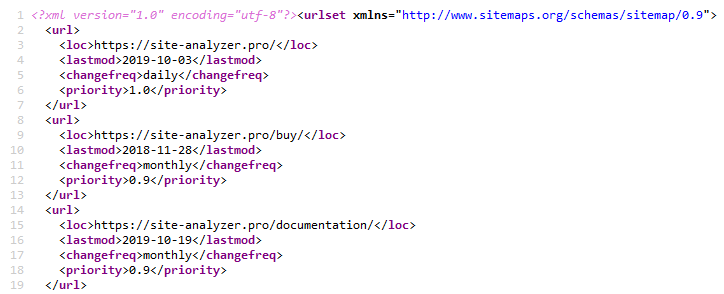

2. Sitemap.xml

El uso de un mapa del sitio XML es un método clásico para acelerar la indexación de nuevas páginas. Esto se realiza especificando un hipervínculo al archivo de mapa del sitio.xml en el archivo Robots.txt (por supuesto, antes de esto, debe crear el propio Sitemap.xml).. Sitemap.xml »

Esto suele ser suficiente para cualquier tipo de sitio web.

Para crear un mapa del sitio hay muchos plugins diferentes en los CMS populares, también se puede crear con la ayuda de uno de los rastreadores web o de Escritorio, por ejemplo, a través de Sit Priceanalyse. SiteAnalyzer »

3. Ping Sitemap.xml

El ping hace que el robot de búsqueda haga un repaso rápido de su mapa del sitio.xml. Este es un tipo de análogo de agregar un mapa del sitio a la consola de búsqueda de Google. Por lo tanto, enviamos a Google una señal adicional sobre la necesidad de volver a visitar el mapa del sitio, lo que acelera la probabilidad de indexar las páginas (sin embargo, no el hecho de que el bot se apresure a evitarlas de inmediato).

Enlaces para hacer ping a un Sitemap en Google y Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Instalación de redirecciones 301 desde páginas de sitios de tráfico

Esta solución le permite transferir parcialmente el peso estático y el tráfico de un sitio de calidad a un sitio que requiere más atención de los bots de búsqueda o tiene problemas con su indexación.

Estaba redirigiendo desde la página de noticias de un sitio con buen tráfico a una página similar de un sitio que tenía problemas de indexación. La redirección fue" contabilizada " por Google en el segundo día y la página del sitio donante desapareció del índice de Google.

Una vez que se indexa la página del sitio aceptador, se puede eliminar la redirección.

5. Eliminar un sitio de Google Webmaster y volver a agregarlo

La idea era que el motor de búsqueda prestara "atención" al sitio y, por lo tanto, volviera a recorrer las páginas.

El experimento no funcionó, ya que al volver a agregar el proyecto, los robots se mostraban inmediatamente en él.txt y otras configuraciones aplicadas anteriormente: aparentemente, al eliminar el sitio simplemente desapareció de la lista, y luego, al volver a "agregar", se volvió a Mostrar.

6. Cierre completo del sitio de indexación

Cerramos el sitio de Google en robots.txt para desindexación completa.

En el momento de la prueba, el índice colgaba la "primera" versión de la página con WWW y sin una copia guardada (sitio joven). En la detección de la versión actualizada de robots.txt Google tardó 1-2 horas. Después de 2 días, la única página previamente indexada desapareció del índice. El sitio tiene 0 páginas en la búsqueda de Google.

Después de la desindexación completa, se abrió robots.txt para el bot de Google.

Sin embargo, a juzgar por los registros, el bot entró una vez al día, por lo que una vez al día para entrar y continuó. En general, la frecuencia de las visitas al sitio por parte del bot de Google no ha cambiado.

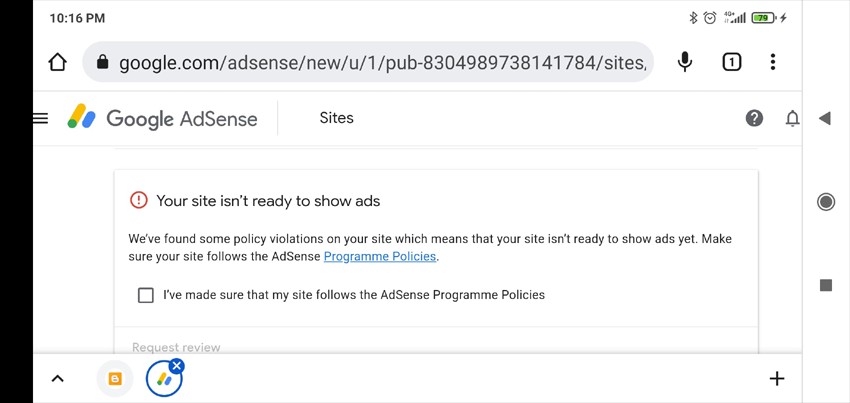

7. Agregar anuncios a Google AdSense

Por lo general, si el sitio no pasa la moderación en Google AdSense, entonces en mi cuenta aparece una lista de posibles razones por las que no aceptaron el sitio (la verificación lleva hasta dos semanas, me tomó una y media). Esta información puede ayudar a determinar las razones de lo que está mal con el sitio.

Lo que en general sucedió: el sitio no fue aceptado con la marca "contenido de poca utilidad".

No creo que el bajo nivel de indexación del sitio estuviera relacionado con esto. Pero, al menos, recibimos una respuesta más o menos sensata, que puede ser útil en otro momento (por ejemplo, para determinar las sanciones impuestas al sitio).

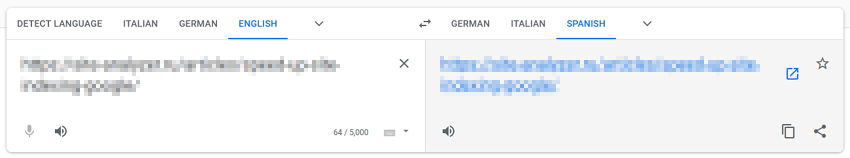

8. Conversión a través de Google Translate

Este método se basa en el supuesto de que al "pasar" páginas a través de los servicios de Google, prestamos atención adicional a los bots de búsqueda.

Pegamos la URL del sitio en el traductor de Google, seguimos el enlace con la traducción de la página, cruzamos los dedos y esperamos un milagro.

En mi caso, el milagro no sucedió.

9. Dirigir el tráfico de las redes sociales y Telegramas

Para acelerar la indexación del sitio, puede compartir publicaciones en redes sociales (Twitter, Facebook, Linkedin, etc.), o colocando publicaciones en Telegram (de hecho, esto es lo mismo que atraer tráfico de redes sociales, pero ocurre colocando enlaces al sitio desde publicaciones publicitarias en canales temáticos).

Por el momento, los enlaces de las redes sociales no están indexados por los motores de búsqueda y no se tienen en cuenta en el ranking, por lo que esta opción de acelerar la indexación del sitio probablemente no sea efectiva, sin embargo, puede atraer tráfico "en vivo" al sitio, debido a lo cual los bots de búsqueda lo visitarán con más frecuencia e indexarán más contenido.

10. Tráfico fuera de contexto

Creamos campañas publicitarias en Google AdWords y dirigimos el tráfico a las páginas de destino para indexarlas más rápidamente, de modo que los bots de búsqueda visiten las páginas del sitio con más frecuencia, lo que aumenta la probabilidad de indexarlas.

11. Comprobación de optimización para móviles en Google Search Console

Usamos la página de prueba de la versión móvil del sitio para indicar al bot sobre nuevas páginas: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Una vez más, la hipótesis de que el envío de Google una señal adicional para volver a visitar las páginas del sitio a través de la herramienta de prueba de la versión móvil, que va a llamar la atención sobre el sitio. Sin embargo, no estoy seguro de que esto dé al menos algún resultado tangible.

12. Tráfico de Pinterest

Pinterest es un mercado de contenido popular en Occidente, lo que lo hace atractivo no solo para los visitantes, sino también para los bots de los motores de búsqueda. Está constantemente "habitado" por los bots de búsqueda, especialmente el bot de Google, por lo que mediante la creación simple de pines, puede dirigir el bot de Google a las páginas de interés del sitio.

En mi caso, no dio resultados.

13. Ejecutar a través de indexadores masivos basados en pestañas del navegador Google Chrome

Por lo que sé, si este tema alguna vez funcionó (el Servicio IndexGator y sus análogos), ahora está absolutamente muerto.

Sí, y en los registros del servidor: después de dicha indexación, el robot no entró en el sitio.

14. Creación De Sitemap.txt

Sitemap.txt es una versión simplificada del Sitemap.xml. Básicamente, sigue siendo la misma lista de URL del sitio, pero sin especificar atributos adicionales (lastmod, priority, frequency).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Esta opción es menos común que un normal Sitemap.xml, pero sin embargo al agregar una referencia a él en robots.txt, los bots comienzan a escanearlo no menos dispuestos que un Sitemap normal.

15. Enlace interno

Aceleración de la indexación mediante la colocación de enlaces a nuevas páginas del sitio desde páginas "Hub" (páginas con mucho tráfico / peso).

Por lo general, para esto se escribe un script que toma paquetes de enlaces no indexados de una lista preparada previamente y los coloca en páginas particularmente visitadas. Después de indexar las páginas, se coloca el siguiente bloque de enlaces, y así sucesivamente. La indexación se verifica a través de varios servicios o a través de la API de Google Webmaster Tools.

16. Acumulación de masa de referencia externa

Google reconoce que las páginas son confiables si están enlazadas desde sitios de buena reputación.

Tener vínculos de retroceso le dice a Google que las páginas son importantes y deben indexarse.

Por lo tanto, al aumentar la masa de enlaces externos de alta calidad a las páginas promocionadas y al sitio en general, puede indicar a Google que este sitio debe prestar más atención y robar contenido con más frecuencia.

17. Método creativo con Flickr (caso Viktor Karpenko)

Creamos una cuenta en Flickr, subimos muchas fotos allí (miles, o mejor decenas de miles): tomamos fotos no importa de dónde, incluso puedes usar otros sitios de alojamiento de fotos, Instagram, Etc.

Debajo de cada foto, escribimos que al usar la foto, debe poner un vínculo de retroceso al sitio promocionado por usted (no olvide mencionar su URL).

Como resultado, es posible obtener tráfico y docenas de enlaces mensualmente de buenos sitios y medios de comunicación de forma gratuita.

Nota. El ejemplo se refiere más a la creación de enlaces, pero también le permite dirigir el tráfico a ciertas páginas de su sitio y, por lo tanto, mejorar su indexación.

18. Indexación con Google Indexing API

Apretón de instrucciones para PHP del usuario Mahmoud:

- Registramos una cuenta de Servicio en Google Cloud, obtenemos la clave de acceso (archivo json), otorgamos derechos de cuenta de Servicio a serchkonsol, incluimos la API en Google Cloud.

- Creamos un script en PHP, desde el cual se agregará la URL al índice.

- Descargar con Github cliente para trabajar con API: https://github.com/googleapis/google-api-php-client

- Código para agregar consultas por lotes:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- En respuesta, $batch->execute() envía una matriz por el número de referencias en la solicitud (si la respuesta tiene \Google\Service\Exception, entonces el código 429 es exceso del límite, 403 es problemas con la clave de acceso o la inclusión de la api, 400 es curvas de datos).

- Referencia a la descripción de los errores: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- No se olvide de vincular la cuenta API con la consola de Google + para exponerse como propietario (Propietario), de lo contrario el script no funcionará (en la matriz vendrá el error 404, que no hay acceso para indexar el sitio - permiso denegado. Failed to verify the URL ownership).

Nota: me tomó ~40 minutos escribir el script, incluido el tiempo para pequeños "atascos" y errores de Google.

19. Bloqueo de acceso al bot de Google (caso Vladimir Vershinin)

Noté que los documentos se agregan mal en uno de los proyectos al índice de Google. Giraban, giraban, todo en vano.

Por motivos indirectos, surgió la hipótesis de que los bots no pueden obtener algo de los recursos, ya que se cortan en el nivel de Servicio de protección DDoS.

Agregamos la lista / ipranges / a la lista blanca del Servicio de protección contra DDoS el día 26, y ya el día 27 recibimos +50K documentos en el índice, y en el momento actual de 15 días ya hay +300k documentos en el índice.

La mayoría de los documentos" volados "se encontraban en el GSC como"Escaneados, pero aún no indexados".

Enlace al rango de direcciones IP de los bots de Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Escribir A John Mueller

Tuitea a John Mueller, describe tu problema, cruza los dedos y espera una respuesta. Twitter »

En mi caso, no funcionó, nadie me respondió, no aparecieron nuevas páginas en el índice. Extraño, por supuesto, bueno.

Pero, quién sabe, tal vez tengas suerte )

***

Parece que ya no quedan opciones conocidas para acelerar la indexación de páginas nuevas y antiguas. Sin embargo, si de repente me perdí algo, le pido que comparta sus propios casos y ejemplos en los comentarios, con gusto los completaré con el artículo.

P.S. IndexNow. Para una cobertura completa del tema, vale la pena mencionar la capacidad relativamente nueva de indexar páginas en masa a través de IndexNow (una API abierta con la capacidad de agregar hasta 10, 000 páginas por día al índice de los motores de búsqueda). Actualmente, los motores de búsqueda Yandex y Bing son compatibles. Es posible que la incorporación del motor de búsqueda de Google a esta tecnología esté a la vuelta de la esquina, aunque si la tecnología ya tiene un pequeño ejército de críticos, quién sabe si se desarrollará en el futuro.

Otros articulos

1,171

1,171