De nombreux SEO-spécialistes dans leur pratique ont été confrontés à la réticence des moteurs de recherche à indexer certaines pages du site, alors que dans 90% des cas, les raisons de ces problèmes sont banales: fermeture accidentelle des pages dans robots.txt, interdiction de l'indexation via meta robots, canonicles incorrects et variantes similaires.

Cependant, il ne suffit pas de trouver et d'éliminer la cause de l'indexation incorrecte. Après l'avoir éliminé, vous devez dès que possible soumettre un contenu important à la réindexation et vous assurer que le site et les pages d'intérêt ont commencé à être indexés.

Dans cet article, nous partagerons toutes les options trouvées pour l'indexation des pages dans le moteur de recherche Google.

Façons d'accélérer l'indexation dans Google

1. Google Search Console (GSC)

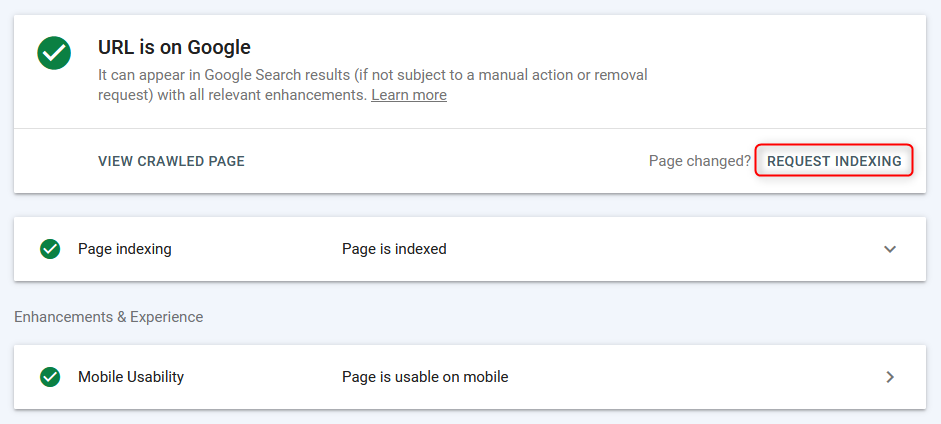

Le moyen le plus courant d'indexer / réindexer des pages en mode «manuel» est via le panneau webmaster de Google.

Les pages sont indexées rapidement (de quelques secondes à apparaître dans la recherche), cependant, le travail se déroule en mode page + il faut du temps pour analyser la page par le robot de recherche, donc cette méthode est efficace, mais pas la plus pratique, car vous ne pouvez pas charger immédiatement la liste du groupe d'URL et l'envoyer à l'indexation en masse.

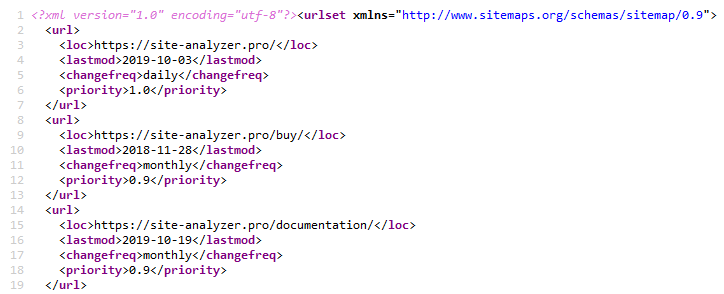

2. Sitemap.xml

L'utilisation du Sitemap XML est une méthode classique pour accélérer l'indexation de nouvelles pages. Ceci est implémenté en spécifiant un lien hypertexte vers le fichier Sitemap.xml dans le fichier Robots.txt (bien sûr, avant cela, vous devez créer le Sitemap lui-même.xml).. Sitemap.xml »

Cela est généralement suffisant pour tout type de site.

Pour créer un Sitemap, il existe de nombreux plugins différents sur les CMS populaires, vous pouvez également le créer à l'aide de l'un des crowlers Web ou de bureau, par exemple, via SiteAnalyzer gratuit.. SiteAnalyzer »

3. Ping Sitemap.xml

Le ping force le robot de recherche à effectuer une refonte rapide de votre Sitemap.xml. C'est une sorte d'analogue de l'ajout d'un sitmap dans Google Search Console. Ainsi, nous envoyons à Google un signal supplémentaire sur la nécessité de reconvertir le plan du site, ce qui accélère ainsi la probabilité d'indexation des pages (cependant, pas le fait que le bot se précipite immédiatement pour les contourner).

Liens pour ping sitmap dans Google et Bing:

- Google: http://google.com/webmasters/tools/ping?sitemap=https://site-analyzer.pro/sitemap.xml

- Bing: https://www.bing.com/ping?sitemap=https://site-analyzer.pro/sitemap.xml

4. Installation de 301 redirections à partir des pages du site de trafic

Cette solution vous permet de transférer partiellement le poids statique et le trafic d'un site de qualité vers un site qui nécessite une plus grande attention des robots de recherche ou qui a des problèmes avec son indexation.

J'ai mis une redirection de la page «nouvelles» d'un site avec un bon trafic vers une page similaire d'un site qui avait des problèmes d'indexation. La redirection a été «prise en compte " par Google dès le deuxième jour et la page du site du donneur a disparu de l'index de Google.

Une fois la page du site accepteur indexée, la redirection peut être supprimée.

5. Supprimer un site de Google Webmaster et l'ajouter à nouveau

L'idée était que le moteur de recherche a attiré l' «attention» sur le site et, ainsi, a parcouru à nouveau les pages.

L'expérience n'a pas fonctionné, car lors de l'ajout du projet à nouveau, robots s'y affichait immédiatement.txt et d'autres paramètres précédemment appliqués - apparemment, lors de la suppression du site, il a simplement disparu de la liste, puis lors de l'ajout répété, il a été affiché à nouveau.

6. Fermeture complète du site de l'indexation

Nous fermons le site de Google dans robots.txt pour une désindexation complète.

Au moment des tests, la «première» version de la page avec WWW et sans copie enregistrée (jeune site) traînait dans l'index. Sur la détection de la version mise à jour de robots.txt Google a pris 1-2 heures. Après 2 jours, la seule page précédemment indexée a disparu de l'index. Le site a laissé 0 pages dans la recherche Google.

Après une désindexation complète, robots a été ouvert.txt pour le bot Google.

Cependant, à en juger par les journaux, le bot est allé une fois par jour, donc une fois par jour pour aller et continuer. En gros, la fréquence des visites sur le site par le bot Google n'a pas changé.

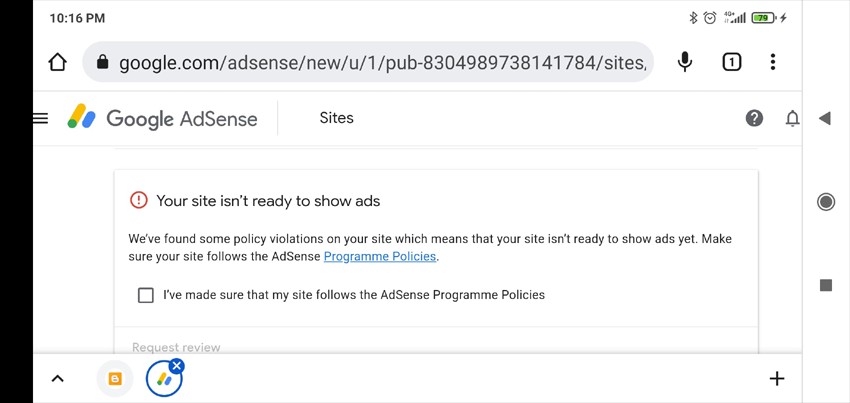

7. Ajouter des annonces à Google AdSense

Habituellement, si le site ne passe pas la modération dans Google AdSense, puis dans votre compte, il y a une liste des raisons possibles pour lesquelles vous n'avez pas accepté le site (la vérification prend jusqu'à deux semaines, cela m'a pris un an et demi). Ces informations peuvent aider à déterminer les raisons de ce qui ne va pas avec le site.

Ce qui s'est passé en général, c'est que le site n'a pas été accepté avec la mention «contenu peu utile».

Je ne pense pas que le faible niveau d'indexation du site était lié à cela. Mais au moins, nous avons reçu une réponse plus ou moins explicative qui pourrait être utile une autre fois (par exemple, pour déterminer les sanctions imposées sur le site).

8. Passage à travers Google Translate

Cette méthode est basée sur l'hypothèse que, en «chassant» les pages via les services Google, nous attirons une attention supplémentaire sur les robots des moteurs de recherche.

Nous collons l'URL du site dans Google Translator, suivons le lien avec la traduction de la page, croisons les doigts et espérons un miracle.

Dans mon cas, le miracle ne s'est pas produit.

9. Nous envoyons le trafic des réseaux sociaux et des Télégrammes

Pour accélérer l'indexation du site, vous pouvez partager des publications sur les réseaux sociaux (Twitter, Facebook, Linkedin, Etc.), ou en plaçant des messages dans Telegram (en fait, c'est la même chose que l'attraction du trafic des réseaux sociaux, mais cela se produit en plaçant des liens vers le site à partir de messages publicitaires sur des canaux thématiques).

À l'heure actuelle, les liens des réseaux sociaux ne sont pas indexés par les moteurs de recherche et ne sont pas pris en compte dans le classement, de sorte que cette option d'accélération de l'indexation du site ne sera probablement pas efficace, cependant, cela peut attirer le trafic «direct» sur le site, grâce auquel les robots de recherche vont

10. Trafic hors contexte

Nous créons des campagnes publicitaires dans Google AdWords et dirigeons le trafic vers les pages d'atterrissage pour les indexer plus rapidement, de sorte que les robots de recherche visitent plus souvent les pages du site, augmentant ainsi la probabilité de leur indexation.

11. Vérifier l'optimisation pour mobile dans Google Search Console

Nous utilisons la page de test de la version mobile du site pour indiquer au bot les nouvelles pages: https://search.google.com/test/mobile-friendly/result?id=28OJNYqIhMMT4grjojk-uw

Encore une fois, l'hypothèse selon laquelle en envoyant à Google un signal supplémentaire pour la redirection des pages du site via l'outil de test de la version mobile, il attirera plus d'attention sur le site. Cependant, je ne suis pas sûr que cela donne au moins un résultat tangible.

12. Trafic de Pinterest

Pinterest est un site de contenu populaire dans l'ouest, ce qui le rend attrayant non seulement pour les visiteurs, mais aussi pour les robots des moteurs de recherche. Il est constamment "habité" par des robots de recherche, en particulier le robot Google, donc en créant des épingles simples, vous pouvez diriger le robot Google vers les pages d'intérêt du site.

Dans mon cas, cela n'a donné aucun résultat.

13. Parcourir les indexeurs de masse basés sur les onglets du navigateur Google Chrome

Pour autant que je sache, si ce sujet a déjà fonctionné (service IndexGator et ses analogues), maintenant il est absolument mort.

Oui, et selon les journaux du serveur-après une telle indexation, le robot n'est pas allé sur le site.

14. Créer Un Sitemap.txt

Fichier Sitemap.txt est une version simplifiée du Sitemap.xml. Essentiellement, c'est toujours la même liste d'URL de site, mais sans spécifier d'attributs supplémentaires (lastmod, priority, frequency).

https://mysite.com/

https://mysite.com/page-1/

https://mysite.com/page-2/

https://mysite.com/page-3/

https://mysite.com/page-4/

https://mysite.com/page-5/

Cette option est moins courante qu'un ordinaire Sitemap.xml, mais néanmoins lors de l'ajout d'une référence à celui-ci dans robots.txt, les robots commencent à le scanner pas moins volontiers qu'un Sitemap normal.

15. Perelinkovka interne

Accélérer l'indexation en insérant des liens vers de nouvelles pages du site à partir de pages» hub " (pages avec un trafic élevé / poids).

Habituellement, pour ce faire, un script est écrit, qui prend des paquets de liens non indexés à partir d'une liste préparée à l'avance et les place sur les pages particulièrement visitées. Après l'indexation des pages, le bloc de liens suivant est placé,etc. L'indexation est vérifiée via différents services ou via l'API Google Webmaster Tools.

16. Renforcement de la masse référencelien externe

Google reconnaît que les pages sont dignes de confiance si elles sont référencées à partir de sites réputés.

La présence de backlinks indique à Google que les pages sont importantes et doivent être indexées.

Ainsi, en augmentant la masse de liens externes de qualité vers les pages promues et le site dans son ensemble, vous pouvez signaler à Google que ce site doit faire plus attention et voler plus souvent le contenu.

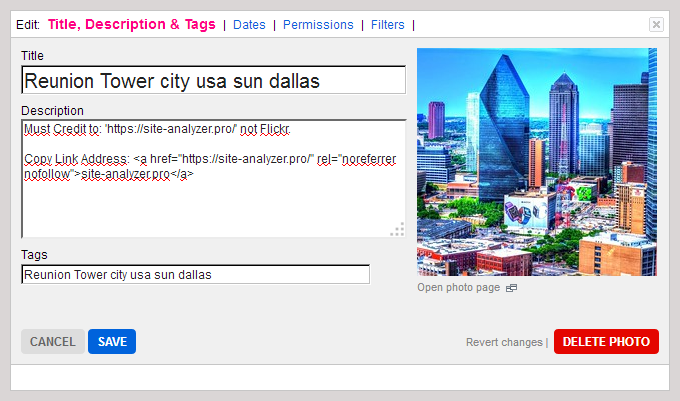

17. Méthode créative avec Flickr (affaire Viktor Karpenko)

Nous créons un compte sur l'hébergement photo Flickr, nous y téléchargeons beaucoup de photos (des milliers, et de préférence des dizaines de milliers) - nous prenons des photos peu importe où, vous pouvez même utiliser d'autres photos, Instagram, etc.

Sous chaque photo, nous écrivons que lorsque vous utilisez une photo, vous devez mettre un lien vers le site que vous avez promu (n'oubliez pas de mentionner son URL).

En conséquence, il est possible d'obtenir gratuitement du trafic et des dizaines de liens mensuels à partir de bons sites et médias.

Remarque. L'exemple concerne davantage le linkbuilding, mais vous permet également de diriger le trafic vers certaines pages de votre site et d'améliorer ainsi leur indexation.

18. Indexation avec Google Indexing API

Instructions squeeze pour PHP de l'utilisateur Mahmoud:

- Nous enregistrons le compte de service dans Google Cloud, obtenons la clé d'accès (fichier json), donnons les droits du compte de service sur cerchconsol, incluons l'API dans Google Cloud.

- Nous créons un script PHP à partir duquel l'URL sera ajoutée à l'index.

- Télécharger avec Github client pour travailler avec API: https://github.com/googleapis/google-api-php-client

- Code pour l'ajout de requêtes par lots:

require_once '/_google-api-php-client/vendor/autoload.php';

$client = new \Google_Client();

$client->setAuthConfig('/_google-api-php-client-php70/blablabla-777c77777777.json'); // path to json file received when creating a service account

$client->addScope('https://www.googleapis.com/auth/indexing');

$client->setUseBatch(true);

$service = new \Google_Service_Indexing($client);

$batch = $service->createBatch();

foreach ($links as $link) // URLs list

{

$postBody = new \Google_Service_Indexing_UrlNotification();

$postBody->setUrl($link);

$postBody->setType('URL_UPDATED');

$batch->add($service->urlNotifications->publish($postBody));

}

$results = $batch->execute();

print_r($results);

- En réponse, $batch->execute() envoie un tableau en fonction du nombre de références dans la requête (s'il y a \Google\Service\Exception dans la réponse, le code 429 est le dépassement de la limite, 403 est les problèmes de clé d'accès ou d'activation de l'api, 400 est les données courbes).

- Lien vers la Description des erreurs: https://developers.google.com/search/apis/indexing-api/v3/core-errors?hl=ru#api-errors

- N'oubliez pas de lier le compte API à la console Google + pour vous exposer au propriétaire (Owner), sinon le script ne fonctionnera pas (dans le tableau viendra l'erreur 404 qu'il n'y a pas d'accès pour l'indexation du site - Permission denied. Failed to verify the URL ownership).

Note: il m'a fallu ~40 minutes pour écrire le script, y compris le temps pour les petits «bâillements» et googler les erreurs.

19. Blocage de l'accès au bot Google (cas Vladimir Vershinin)

Remarqué que mal Ajouté sur l'un des documents de projet dans l'index de Google. Ils tournaient, tournaient-tout n'est pas utile.

Pour des raisons indirectes, l'hypothèse est apparue que les robots ne peuvent pas obtenir quelque chose de ressources, car ils sont coupés au niveau du service pour la protection contre DDoS.

Nous avons Ajouté la liste/ ipranges / à la liste blanche du service de protection contre DDoS le numéro 26, et déjà le 27, nous avons reçu +50k documents dans l'index, et pour le moment pour les jours 15 déjà +300K documents dans l'index.

La plupart des documents» volés «se trouvaient dans GSC comme»Scannés, mais pas encore indexés".

Lien vers la plage d'adresses IP des robots Google: https://developers.google.com/search/apis/ipranges/googlebot.json

20. Écrire À John Mueller

Tweetez à John Mueller, décrivez votre problème, croisez les doigts et attendez une réponse. Twitter »

Dans mon cas, cela n'a pas fonctionné, personne ne m'a répondu, aucune nouvelle page n'est apparue dans l'index. C'est bizarre, bien sûr.

Mais, qui sait, peut - être que vous aurez de la chance )

***

Il semble qu'il n'y ait plus d'options connues pour accélérer l'indexation des pages nouvelles et anciennes. Cependant, si soudainement je manque quelque chose, je vous demande de partager mes propres cas et exemples dans les commentaires - je les compléterai avec plaisir.

P.S. IndexNow. Pour une couverture complète du sujet, il convient de mentionner la possibilité relativement nouvelle d'indexer en masse les pages via IndexNow (une API ouverte avec la possibilité d'ajouter jusqu'à 10 000 pages par jour à l'index des moteurs de recherche). Actuellement, les moteurs de recherche Yandex et Bing sont pris en charge. Il est possible que l'adhésion du moteur de recherche Google à cette technologie ne soit pas loin, mais si la technologie a déjà une petite armée de critiques, qui sait si elle sera développée à l'avenir.

Autres articles

321

321