Призначення програми

Програма SiteAnalyzer призначена для аналізу сайту і виявлення технічних помилок (пошук битих посилань, дублікатів сторінок, некоректних відповідей сервера), а також помилок і недоробок в SEO-оптимізації (незаповнені мета-теги, надлишок або повна відсутність заголовків сторінок h1, аналіз контенту сторінки, якість перелінковки і безліч інших SEO-параметрів).

Основні можливості

- Сканування всіх сторінок сайту, а також зображень, скриптів і документів

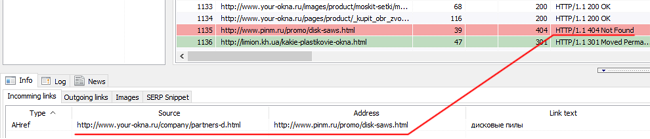

- Отримання кодів відповіді сервера для кожної сторінки сайту (200, 301, 302, 404, 500, 503 і т. д.)

- Визначення наявності та вмісту Title, Keywords, Description, H1-H6

- Пошук і відображення "дублікатів" сторінок, мета-тегів і заголовків

- Визначення наявності атрибуту rel="canonical" для кожної сторінки сайту

- Дотримання директивам файлу "robots.txt", мета-тега "robots", або X-Robots-Tag

- Облік "noindex" і "nofollow" при обході сторінок сайту

- Скрейпінг даних за допомогою XPath, CSS, XQuery, RegEx

- Перевірка унікальності контенту всередині сайту

- Перевірка швидкості завантаження сторінок по Google PageSpeed

- Нормативний аналіз: визначення внутрішніх і зовнішніх посилань для будь-якої сторінки сайту

- Розрахунок внутрішнього показника PageRank для кожної сторінки сайту

- Візуалізація структури сайту на графі

- Визначення кількості перенаправлень зі сторінки (редиректів)

- Сканування довільних URL і зовнішніх Sitemap.xml

- Генерація карти сайту "sitemap.xml" (з можливістю розбиття на кілька файлів)

- Фільтрація даних по будь-якому параметру (гнучке налаштування фільтрів будь-якої складності)

- Пошук довільного контенту на сайті

- Експорт звітів в CSV, Excel i PDF

Відмінності від аналогів

- Низькі вимоги до ресурсів комп'ютера, малий витрата оперативної пам'яті

- Сканування сайтів практично будь-яких обсягів за рахунок низьких вимог до ресурсів комп'ютера

- Портативний формат (працює без інсталяції на ПК або прямо зі змінного носія)

Розділи документації

- Початок роботи

- Налаштування програми

- Основні налаштування

- Сканування

- SEO

- Віртуальний Robots.txt new

- Yandex XML

- User-Agent

- Довільні HTTP-заголовки new

- Proxy-сервер

- Виключити URL

- Слідувати URL

- PageRank

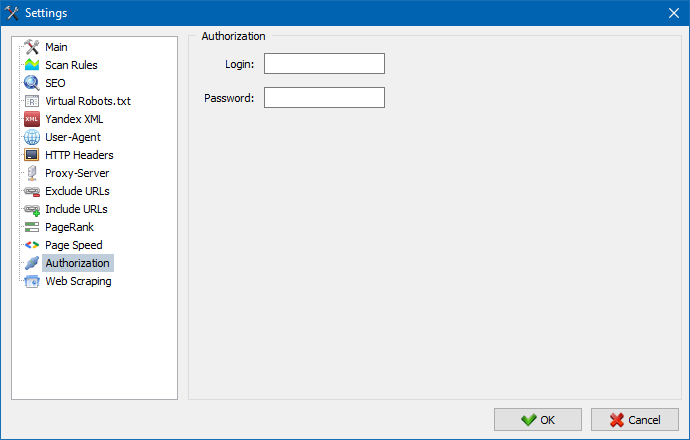

- Авторизація

- Робота з програмою

- Налаштування стовпців і вкладок

- Фільтрація даних

- Технічна статистика сайту

- Статистика SEO

- Custom Filters

- Custom Search

- Скрейпінг даних

- Перевірка унікальності контенту

- Перевірка швидкості завантаження сторінок

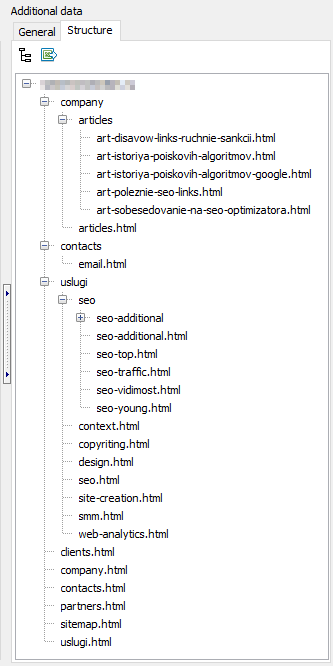

- Структура сайту

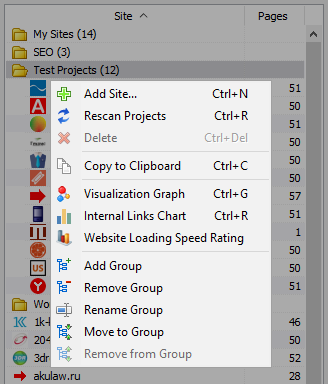

- Контекстне меню списку проектів

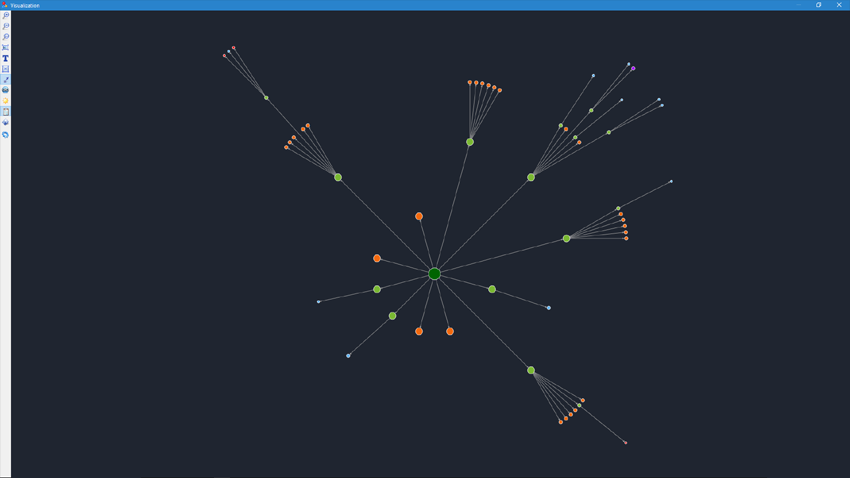

- Візуалізація структури сайту

- Графік розподілу внутрішніх посилань

- Графік швидкості завантаження сторінок

- Генерація Sitemap.xml

- Сканування довільних URL

- Dashboard

- Експорт даних

- Багатомовність

- Стиснення бази даних

Початок роботи

При запуску програми користувачу доступна адресний рядок для введення URL аналізованого сайту (можна ввести будь-яку сторінку сайту, так як пошуковий робот, пройшовши по посиланнях вихідної сторінки обійде весь сайт, в тому числі і головну сторінку, при умови що всі посилання виконані в HTML і не використовують Javascript).

Після натискання кнопки "Старт", пошуковий робот починає обхід всіх сторінок сайту за внутрішніми посиланнями (на зовнішні ресурси, він не переходить, також не переходить за посиланнями, виконаним на Javascript).

Після того, як робот обійде всі сторінки сайту стає доступним звіт, виконаний у вигляді таблиці і відображає отримані дані, згруповані за тематичним закладок.

Усі аналізовані проекти відображаються в лівій частині програми і автоматично зберігаються в базі програми разом з одержаними даними. Для видалення непотрібних сайтів скористайтеся контекстним меню списку проектів.

Примітка:

- при натисканні на кнопку "Пауза" сканування проекту призупиняється, паралельно поточний прогрес сканування зберігається в базу, що дозволяє, наприклад, закрити програму і продовжити сканування проекту після перезапуску програми з місця зупинки

- кнопка "Стоп" перериває сканування поточного проекту без можливості продовження його сканування

Налаштування програми

Розділ головного меню "Параметри" призначений для тонкого налаштування роботи програми із зовнішніми сайтами і містить 7 вкладок:

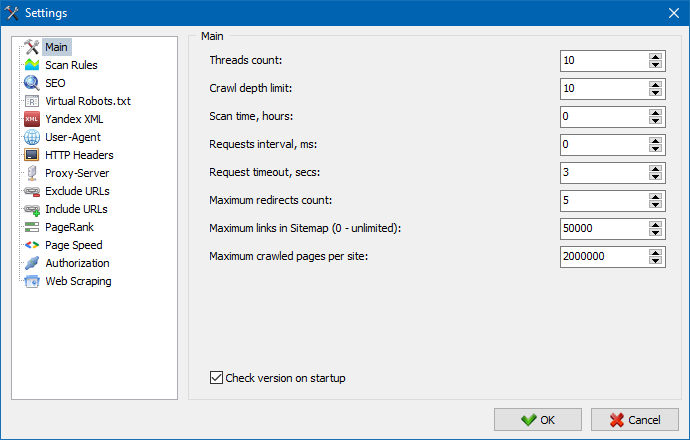

Розділ основних налаштувань служить для вказівки програмі користувача директив, використовуваних при скануванні сайту.

Опис параметрів:

- Кількість потоків

- Чим більше число потоків, тим більше URL зможе обробити в одиницю часу. При цьому потрібно враховувати, що більша кількість потоків веде до більшого числа використовуваних ресурсів ПК. Рекомендується встановлювати кількість потоків в діапазоні 5-10.

- Час сканування

- Служить для встановлення обмеження сканування сайту за часом. Вимірюється у годинах.

- Максимальна глибина

- Даний параметр служить для вказівки глибини сканування сайту. Головна сторінка сайту має рівень вкладеності = 0. Наприклад, якщо потрібно сканувати сторінки сайту виду "somedomain.ru/catalog.html" і "somedomain.ru/catalog/tovar.html", то в такому випадку необхідно виставити значення максимальної глибини = 2.

- Затримка між запитами

- Служить для установки пауз при зверненнях сканера до сторінок сайту. Це буває необхідно для сайтів на "слабких" хостингах, не витримують великих навантажень і частих до них звернень.

- Таймаут запиту

- Установка часу очікування відповіді сайту на запит програми. Якщо якісь із сторінок сайту відповідають повільно (довго вантажаться), то сканування сайту може зайняти досить тривалий час. Такі сторінки можна відсікти, вказавши значення, після якого сканер перейде до сканування решти сторінок сайту і тим самим не буде затримувати загальний прогрес.

- Число сканованих сторінок сайту

- Обмеження на максимальне число сканованих сторінок. Буває корисно, якщо, наприклад, вам потрібно просканувати перші N сторінок сайту (при цьому не враховуються зображення, файли стилів, скрипти і інші типи файлів).

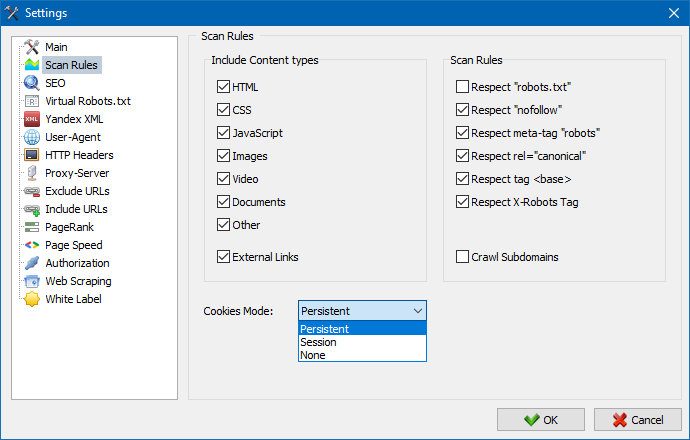

Враховувати контент

- У цьому розділі можна вибрати типи даних, які будуть враховуватися парсером при обході сторінок (зображення, відео, стилі, скрипти), або виключити зайву інформацію при парсингу.

Правила сканування

- Дані налаштування пов'язані з налаштуваннями винятків при обході сайту сканер використовуючи файл "robots.txt" за посиланнями типу "nofollow", а також використовуючи директиви "meta name=robots" безпосередньо в коді сторінок сайту.

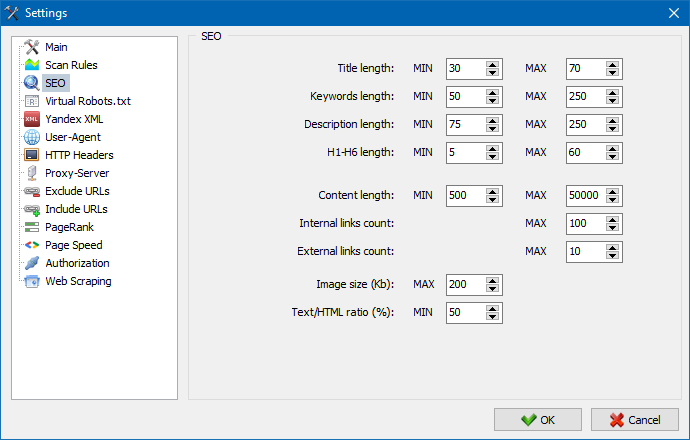

Даний розділ служить для вказівки основних аналізованих SEO-параметрів, які в подальшому будуть перевірятися на коректність при парсингу сторінок, після чого отримана статистика буде відображена на вкладці "Статистика SEO" в правій частині головного вікна програми.

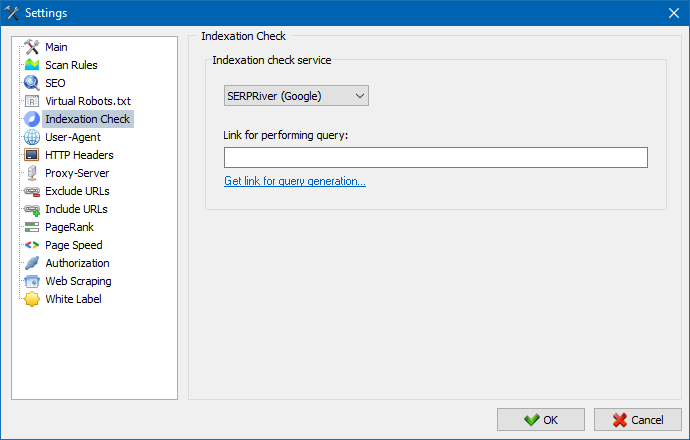

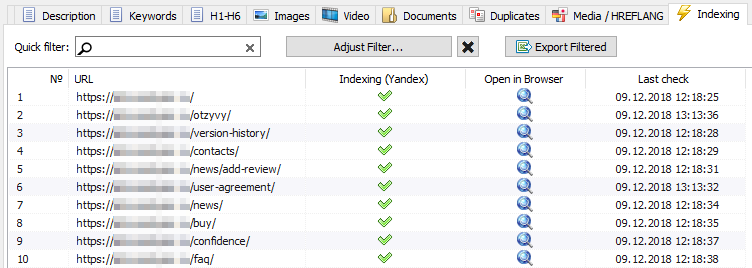

За допомогою даних налаштувань можна вибрати сервіс, за допомогою якого буде проводитися перевірка індексації сторінок в пошуковій системі Yandex. Є два варіанти перевірки індексації: за допомогою сервісу Yandex XML або сервісу Majento.ru.

При виборі сервісу Yandex XML потрібно враховувати можливі обмеження (погодинні або щоденні), які можуть бути застосовані при перевірці індексації сторінок, щодо наявних лімітів на ваш обліковий запис Yandex, в результаті чого часто можуть виникати ситуації, коли лімітів вашого облікового запису не буде вистачати для перевірки всіх сторінок за один раз і для цього доведеться чекати наступної години.

При використанні сервісу Majento.ru погодинні або щоденні обмеження практично відсутні, так як ваш ліміт буквально вливається в загальний пул лімітів, який сам по собі не малий, а також має значно більший ліміт при погодинних обмеженнях, ніж будь-який з окремих користувальницьких акаунтів на Yandex XML.

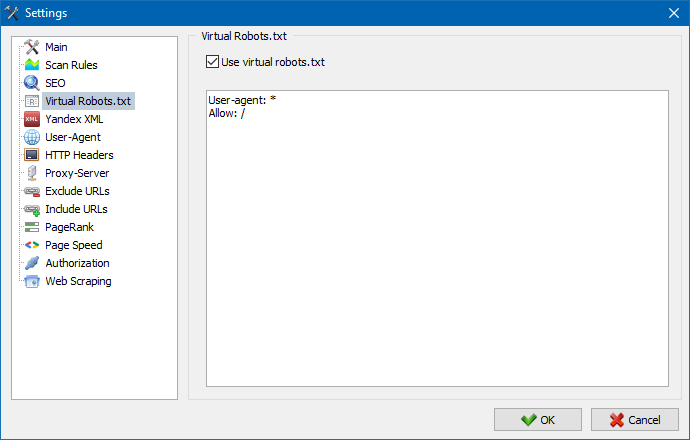

Віртуальний robots.txt можна використати замість реального robots.txt, розміщеного на сайті.

Це буває зручно при тестуванні сайту, коли, наприклад, потрібно просканувати певні розділи сайту, закриті від індексації (або навпаки - не враховувати їх при скануванні), при цьому не потрібно фізично вносити зміни до реального robots.txt і витрачати на цей час розробника.

Примітка: при імпорті списку URL враховуються директиви віртуального robots.txt (якщо ця опція активована), інакше ніякий robots.txt для списку URL не враховується.

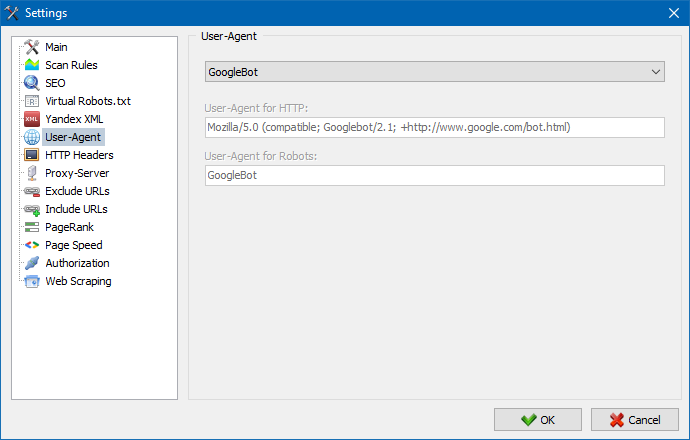

В розділі User-Agent можна вказати, яким юзер-агентом буде представлятися програма при зверненні до зовнішніх сайтів під час сканування. За умочанию, встановлений користувальницький юзер-агент, однак при необхідності можна вибрати один із стандартних агентів, найбільш часто зустрічаються в інтернет. Серед них є такі, як: боти пошукових систем YandexBot, GoogleBot, MicrosoftEdge, боти браузерів Chrome, Firefox, IE8, а також мобільних пристроїв iPhone, Android і багато інших.

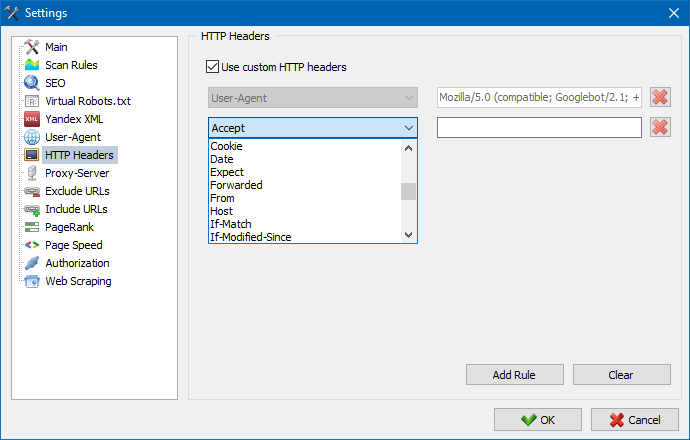

За допомогою цієї опції можна аналізувати реакцію сайту та сторінок на різні запити. Наприклад, комусь може знадобитися віддавати в запиті Referer, власникам мультимовних сайтів захочеться передавати Accept-Language|Charset|Encoding, а хтось має потребу в передачі незвичайних даних у заголовках Accept-Encoding, Cache-Control, Pragma і т.д. п.

За допомогою цієї опції можна аналізувати реакцію сайту та сторінок на різні запити. Наприклад, комусь може знадобитися віддавати в запиті Referer, власникам мультимовних сайтів захочеться передавати Accept-Language|Charset|Encoding, а хтось має потребу в передачі незвичайних даних у заголовках Accept-Encoding, Cache-Control, Pragma і т.д. п.

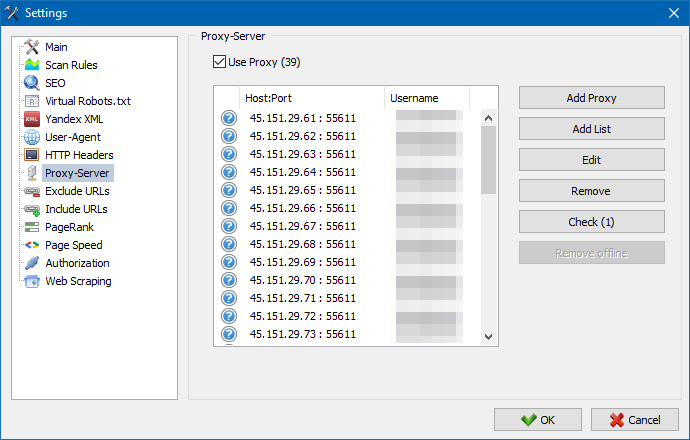

Якщо є необхідність працювати через проксі, то в даному розділі ви можете додати список проксі-серверів, через які програма буде звертатися до зовнішніх ресурсів. Додатково, є можливість перевірки проксі на працездатність, а також функція видалення неактивних проксі-серверів.

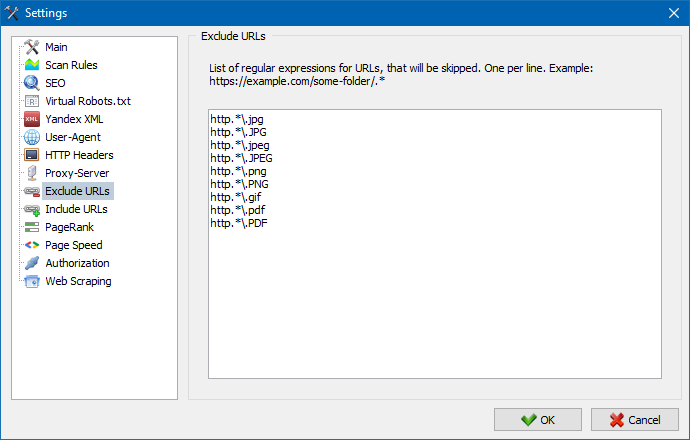

Даний розділ призначений для виключення обходу певних сторінок і розділів сайту при парсингу.

За допомогою шаблонів пошуку * і ? можна вказати, які розділи сайту не повинні обходитися краулер і, відповідно, не повинні потрапити в базу програми. Даний список є локальним списком винятків на час сканування сайту (щодо нього "глобальним" списком є файл "robots.txt" в корені сайту).

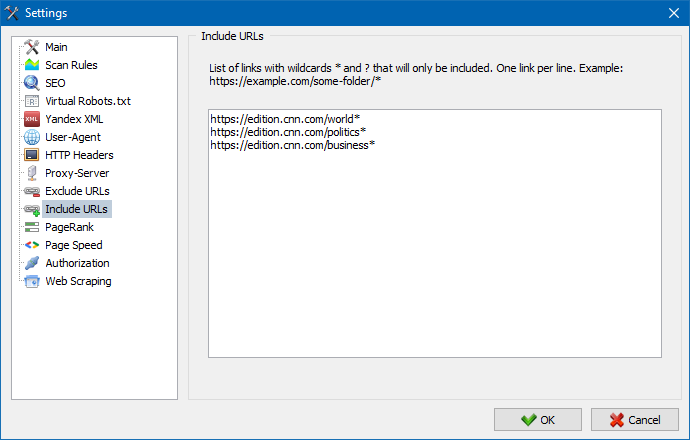

Аналогічно дозволяє додавати URL, які повинні бути обов'язково просканувати. При цьому всі інші URL, за межами цих папок, під час сканування будуть проігноровані. Дана опція також працює за допомогою шаблонів пошуку * і ?

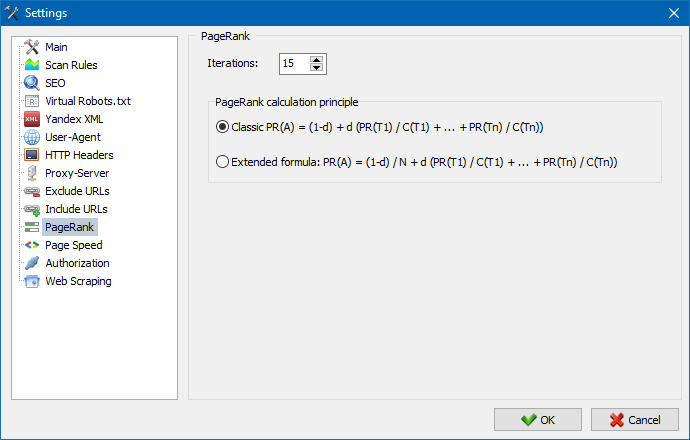

За допомогою параметра PageRank можна аналізувати навігаційну структуру ваших сайтів, а також оптимізувати систему внутрішніх посилань веб-ресурсу для передачі посилального ваги найбільш важливих сторінок.

У програмі є два варіанти розрахунку PageRank: класичний алгоритм і його більш сучасний аналог. В цілому, для аналізу внутрішньої перелинковки сайту немає великої різниці при використанні першого або другого алгоритмів, тому ви можете використовувати будь-який алгоритм з двох запропонованих.

Детальний опис алгоритму та принципи розрахунку PageRank читайте в статті "Розрахунок внутрішнього PageRank": >>

Введення логіна і пароля для автоматичної авторизації на сторінках, закритих через .htpasswd і захищених BASIC авторизацією сервера.

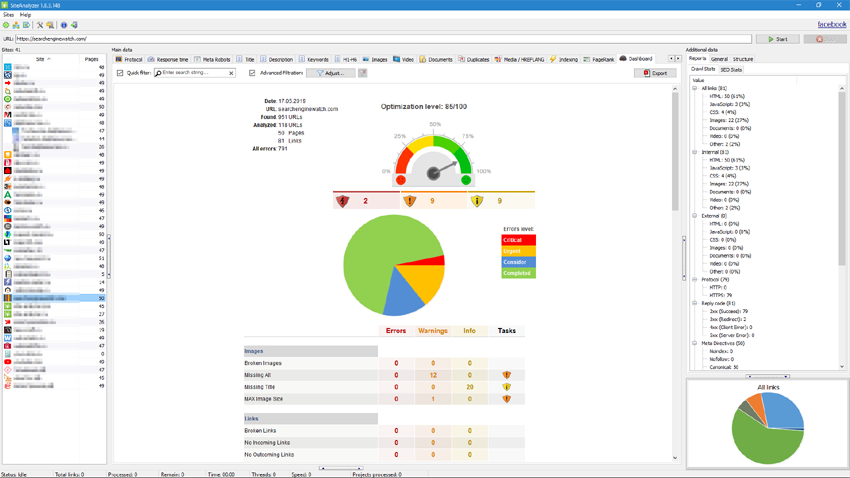

Робота з програмою

Після завершення сканування користувачеві стає доступна інформація, розміщена у блоці "Основні дані". Кожна вкладка містить дані, згруповані щодо їх назв (наприклад, вкладка "Title" містить вміст заголовків сторінок <title> < /title>, вкладка "Зображення" містить список всіх зображень сайту і так далі). З допомогою цих даних можна проводити аналіз вмісту сайту, знаходити "биті" посилання або некоректно заповнені мета-теги.

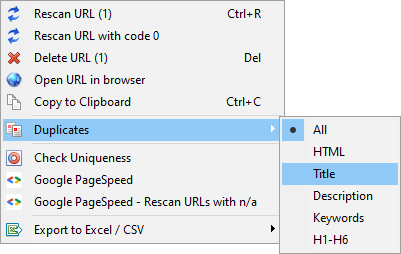

При необхідності (наприклад, після внесення змін на сайті) з допомогою контекстного меню є можливість нове сканування окремих URL для відображення змін у програмі.

З допомогою цього меню можна відображати дублікати сторінок за відповідними параметрами (дублі title, description, keywords, h1, h2, контент сторінок).

Пункт "Пересканіровать URL з кодом 0" призначений для автоматичної перевірки всіх сторінок, які віддають код відповіді 0 (Read Timeout). Даний код відповіді зазвичай віддається, коли сервер не встигає віддавати контент і з'єднання закривається з таймаут, відповідно, сторінка не може бути завантажена і інформація з неї не може бути вилучено.

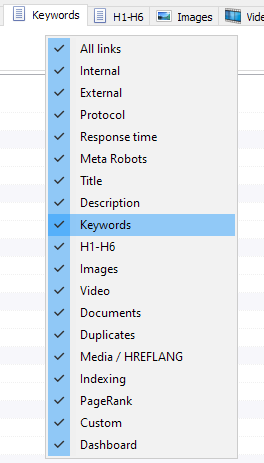

Налаштування стовпців і вкладок

Тепер можна вибрати, які вкладки будуть відображатися в інтерфейсі основних даних (нарешті, стало можливим попрощатися з морально застарілою вкладкою Meta Keywords). Це буває зручно, якщо таби не поміщаються на екрані, або ви рідко їх використовуєте.

Стовпці можна приховувати або переміщати в потрібне місце шляхом перетягування.

Відображення вкладок і стовпчиків можна налаштувати за допомогою виклику контекстного меню на панелі основних даних. Перенесення колонок здійснюється за допомогою миші.

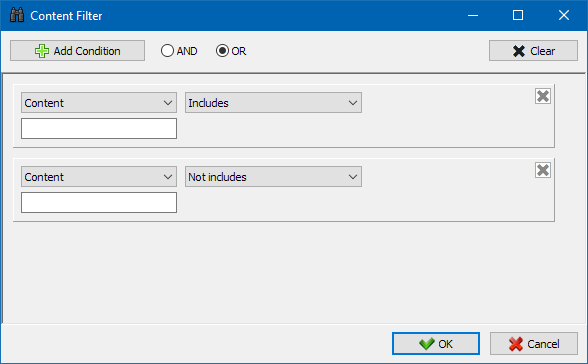

Для більш зручного аналізу статистики сайту в програмі доступна фільтрація даних. Фільтрація можлива у двох варіантах:

- по будь-яких полях за допомогою "швидкого" фільтра

- з використанням настроюваного фільтра (за допомогою розширених налаштувань вибірки даних)

Швидкий фільтр

Використовується для швидкого фільтрування даних і застосовується одночасно до всіх полів поточної вкладки.

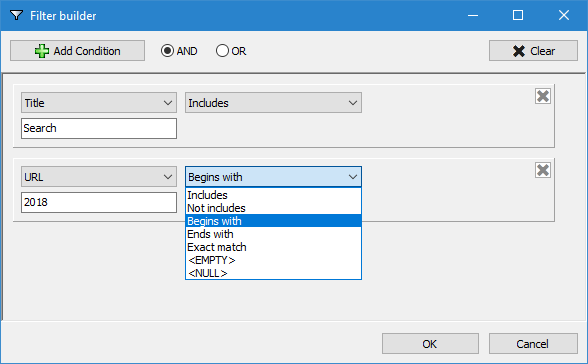

Настроюваний фільтр

Призначений для детальної фільтрації і може містити одночасно кілька умов. Наприклад, для мета-тегу "title" ви ходите відфільтрувати сторінки по їх довжині, щоб він не перевищував 70 символів і одночасно містив текст "новости". Тоді цей фільтр буде виглядати так:

Таким чином, застосовуючи настроюваний фільтр до будь-якої з вкладок ви можете отримувати вибірки даних будь-якої складності.

Вкладка технічної статистики сайту знаходиться на панелі "Додаткові дані" і містить набір основних технічних параметрів сайту: статистика по посиланнях, мета-тегами, кодами відповідей сторінок, параметрам індексації сторінок, типам контенту і т.п. параметрам.

Клікнувши по одному з параметрів вони автоматично фільтруються у відповідній вкладці основних даних сайту, а також одночасно відображається статистика на діаграмі в нижній частині сторінки.

Вкладка SEO-статистики призначена для проведення повноцінних аудитів сайту і містить 50+ основних SEO-параметрів і визначає більш 60 ключових помилок внутрішньої оптимізації! Відображення помилок ділиться на групи, які, в свою чергу, містять набори аналізованих параметрів і фільтри, що виявляють помилки на сайті.

Детальний опис усіх перевірених параметрів читайте в цій статті. >>

Для всіх результатів фільтрації є можливість їх швидкого експорту в Excel без додаткових діалогів (звіт зберігається в папці з програмою).

На цій вкладці розміщуються встановлені фільтри, що дозволяють створювати вибірки за всіма зовнішніми посиланнями, помилки 404, зображеннями та іншим параметрам з усіма сторінками, на яких вони присутні. Таким чином, тепер ви можете легко і швидко отримати список зовнішніх посилань і сторінок, на яких вони розміщені, або вибрати всі биті посилання і відразу побачити, на яких сторінках вони розташовані.

Всі звіти доступні в програмі в режимі онлайн і відображаються на вкладці "Custom" панелі основних даних. Додатково, є можливість їх експорту в Excel через головне меню.

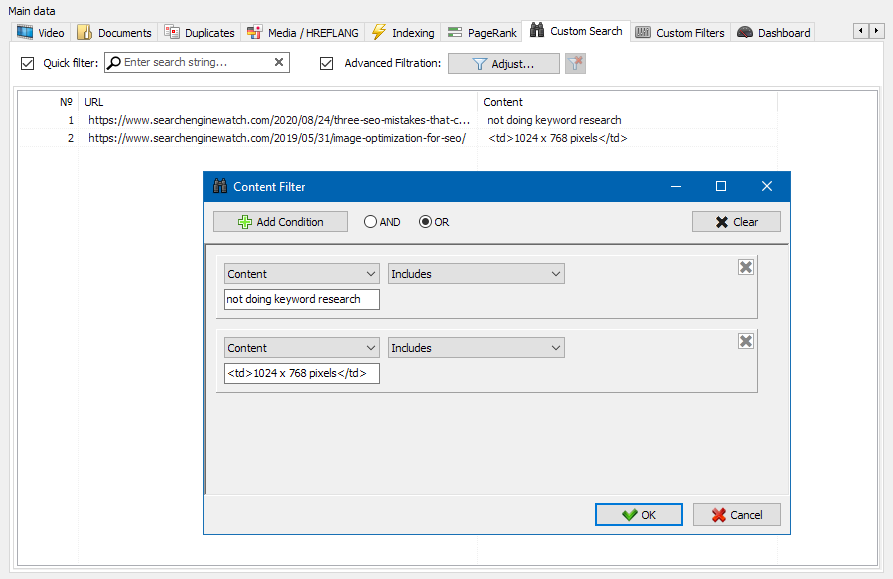

Функція пошуку контенту на сайті дозволяє здійснювати пошук по вихідного коду і відображати веб-сторінки, що містять шуканий контент.

Модуль настроюються фільтрів дозволяє перевірити наявність на сайті мікророзмітки, мета-тегів, систем аналітики, фрагментів довільного тексту або HTML-коду.

У вікні конфігурації фільтра є кілька параметрів для пошуку певних фрагментів тексту на сторінках сайту, або, навпаки, для виключення з результатів пошуку сторінок, що містять певний текст або фрагменти HTML-коду (дана функція аналогічна пошуку контенту в вихідному коді сторінки по Ctrl-F) .

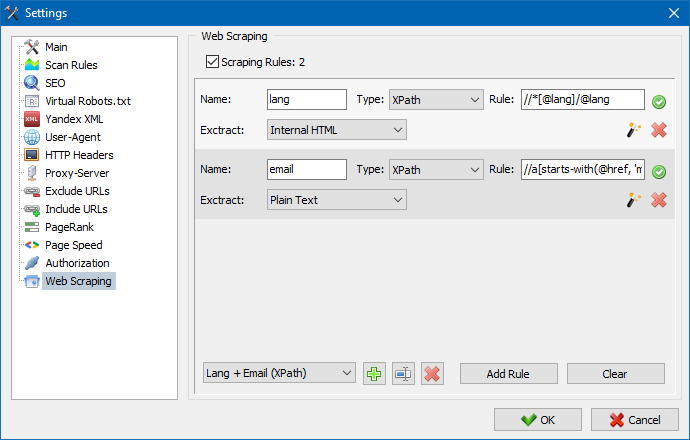

Зазвичай за допомогою скрейпінга вирішуються завдання, з якими складно впоратися вручну. Це може бути витяг описів товарів для створення нового інтернет-магазину, скрейпінг в маркетингових дослідженнях для моніторингу цін, або для моніторингу оголошень.

У SiteAnalyzer за настройку скрейпінга відповідає вкладка "Витяг даних", в якій настроюються правила вилучення. Правила можна зберігати і, при необхідності, редагувати.

Також присутній модуль тестування правил. За допомогою вбудованого відладчика правил можна швидко і просто отримати HTML-вміст будь-якої сторінки сайту і тестувати роботу запитів, після чого використовувати налагоджені правила для парсинга даних в SiteAnalyzer.

Після закінчення вилучення даних всю зібрану інформацію можна експортувати в Excel.

Більш детально вивчити роботу модуля і ознайомитися зі списком найбільш часто зустрічаються правил і регулярних виразів можна в статті

Перевірка унікальності контенту

Даний інструмент дозволяє провести пошук дублікатів сторінок і перевірити унікальність текстів всередині сайту. Іншими словами це пакетна перевірка групи URL на унікальність між собою.

Це може бути корисно у випадках:

- Для пошуку повних дублів сторінок (наприклад, сторінка з параметрами і та ж сама сторінка, але у вигляді ЧПУ).

- Для пошуку часткових збігів контенту (наприклад, два рецепта борщу в кулінарному блозі, які схожі між собою на 96%, що наводить на думку, що одну зі статей краще видалити, щоб позбутися від можливої канібалізації трафіку).

- Коли на статейному сайті ви випадково написали статтю по темі, яку вже писали раніше 10 років тому. У цьому випадку наш інструмент також виявить дублікат такої статті.

Принцип роботи інструменту перевірки унікальності контенту простий: за списком URL сайту програма завантажує їх вміст, отримує текстове вміст сторінки (без блоку HEAD і без HTML-тегів), а потім за допомогою алгоритму шинглів порівнює їх один з одним.

Таким чином, за допомогою шинглів ми визначаємо унікальність сторінок і можемо обчислити як повні дублі сторінок з 0% унікальністю, так і часткові дублі з різними ступенями унікальності текстового вмісту. Програма працює з довжиною шингли дорівнює 5.

Більш детально вивчити роботу модуля можна в даній статті: >>

Перевірка швидкості завантаження сторінок

Інструмент PageSpeed Insights пошукового гіганта Google дозволяє перевіряти швидкість завантаження тих чи інших елементів сторінок, а також показує загальний бал швидкості завантаження цікавлять URL для деськтопной і мобільної версії браузера.

Інструмент Google всім хороший, проте, має один істотний мінус - він не дозволяє створювати групові перевірки URL, що створює незручності при перевірці безлічі сторінок вашого сайту: погодьтеся, що вручну перевіряти швидкість завантаження для 100 і більше URL по одній сторінці клопітно і може зайняти чимало часу.

Тому, нами був створений модуль, що дозволяє безкоштовно створювати групові перевірки швидкості завантаження сторінок через спеціальний API в інструменті Google PageSpeed Insights.

Основні аналізовані параметри:

- FCP (First Contentful Paint) – час відображення першого контенту.

- SI (Speed Index) – показник того, як швидко відображається контент на сторінці.

- LCP (Largest Contentful Paint) – час відображення найбільшого за розміром елемента сторінки.

- TTI (Time to Interactive) – час, протягом якого сторінка стає повністю готова до взаємодії з користувачем.

- TBT (Total Blocking Time) – час від першої відтворення контенту до його готовності до взаємодії з користувачем.

- CLS (Cumulative Layout Shift) – накопичувальний зрушення макета. Служить для вимірювання візуальної стабільності сторінки.

При цьому, сам аналіз URL відбувається всього в пару кліків, після чого доступна вивантаження звіту, що включає основні характеристики перевірок в зручному вигляді в Excel.

Все що вам потрібно для початку роботи - отримати ключ API.

Як це зробити - описано в даній статті >>

Даний функціонал призначений для створення структури сайту на основі отриманих даних. Структура сайту генерується виходячи з вкладеності URL сторінок. Після генерації структури доступний її експорт в CSV формат (Excel).

Контекстне меню списку проектів

- У списку проектів доступно масове сканування шляхом виділення потрібних сайтів і натискання кнопки "Пересканувати". Після чого всі сайти стають в чергу і скануються по черзі в стандартному режимі.

- Також, для зручності роботи з програмою, масове видалення вибраних сайтів також доступно по кнопці "Видалити".

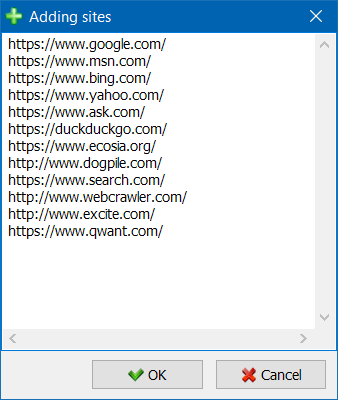

- Крім одиничного сканування сайтів, існує можливість масового додавання сайтів в список проектів за допомогою спеціальної форми, після чого користувач може просканувати цікавлять проекти цілком.

- Для більш зручної навігації по списку проектів доступна можливість угрупування сайтів по папках, а також фільтрація списку проектів за назвою.

Режим візуалізації посилальних зв'язків на графі допоможе SEO-фахівця оцінити розподіл внутрішнього PageRank на сторінках сайту, а також зрозуміти, які з сторінок отримують більшу посилальну масу (і відповідно, більший внутрішній посилальну вагу в очах пошукових систем), а яким сторінок і розділів сайту не вистачає внутрішніх посилань.

За допомогою режиму візуалізації структури сайту SEO-фахівець зможе наочно оцінити те, як організована внутрішня перелінковка на сайті, а також за рахунок візуального представлення маси PageRank, присвоєної тим чи іншим сторінок, оперативно вносити корективи в поточну перелінковку сайту і тим самим підвищувати релевантність цікавлять сторінок.

У лівій частині вікна візуалізації знаходяться основні інструменти для роботи з графом:

- зміна масштабу у графі

- поворот графа на довільний кут

- перемикання вікна графа в повноекранний режим (також працює по клавіші F11)

- відображення / приховання підписів до вузлів (Ctrl-T)

- відображення / приховання стрілок у ліній

- відображення / приховування посилань на зовнішні ресурси (Ctrl-E)

- перемикання режиму колірної схеми День / Ніч (Ctrl-D)

- відображення / приховування легенди і статистики графа (Ctrl-L)

- збереження графа у формат PNG (Ctrl-S)

- вікно налаштувань візуалізації (Ctrl-O)

Розділ "Вид" призначений для зміни формату відображення сайтів на графі. В режимі малювання вузлів "PageRank", розміри вузлів встановлюються щодо їх раніше розрахованого показника PageRank, в результаті чого на графі можна наочно побачити, які сторінки отримують більший посилальну вагу, а яким дістається менше всього посилань.

У класичному режимі розміри вузлів встановлюються щодо обраного масштабу графа візуалізації.

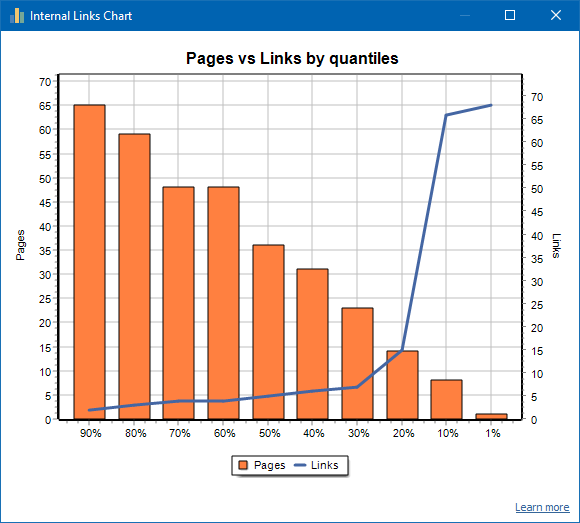

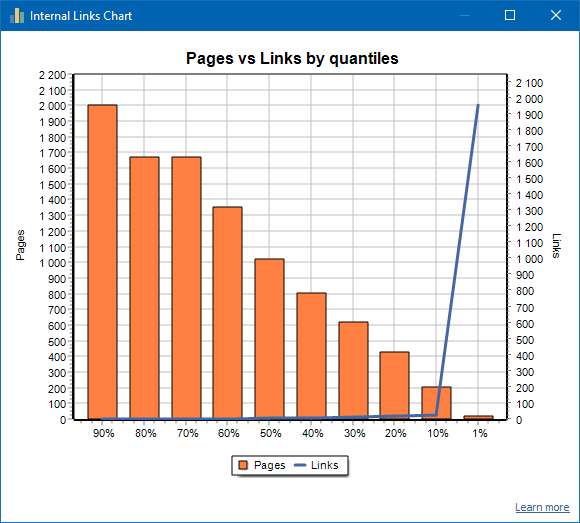

Графік розподілу внутрішніх посилань

Даний графік показує розподіл внутрішньої посилальної маси на сторінках сайту (можна сказати, що це візуалізація перелинковки в наочному вигляді, ніж вона представлена на Графі візуалізації). Читати більше >>

Зліва відображено число сторінок, праворуч - число посилань. Внизу - процентні квантилі по сторінках. При складанні графіка дублікати посилань відкидаються (якщо зі сторінки А на сторінку Б веде 3 посилання, то ми їх вважаємо за одну).

Наприклад, виходячи з скріншоту вище, для сайту з близько 70 сторінок:

- 1% сторінок мають ~68 вхідних посилань.

- 10% сторінок мають ~66 вхідних посилань.

- 20% сторінок мають ~15 вхідних посилань.

- 30% сторінок мають ~8 вхідних посилань.

- 40% сторінок мають ~7 вхідних посилань.

- 50% сторінок мають ~6 вхідних посилань.

- 60% сторінок мають ~5 вхідних посилань.

- 70% сторінок мають ~5 вхідних посилань.

- 80% сторінок мають ~3 вхідних посилань.

- 90% сторінок мають ~2 вхідних посилань.

Тобто, якщо ми бачимо, що у нас є сторінки, на які веде менше 10 вхідних посилань, то такі сторінки ми можемо вважати слабо залінкованнимі, а нормально залінкованних у нас 60% сторінок. Виходячи з цього, ми можемо або проставити більше внутрішніх посилань на ці слабо залінкованние сторінки (якщо сторінки важливі для просування), або залишити як є, якщо подібні сторінки мають мале значення і низький пріоритет.

На загальній практиці, сторінки, які мають менше 10 внутрішніх посилань гірше Краулі пошуковими роботами, зокрема, ботами Google.

Тому, якщо ви бачите сайт, у якого нормально залінкованних всього 20-30% сторінок від загального числа сторінок на сайті, то має сенс заглибитися в налаштування перелинковки або подумати, як вчинити з цими 80-70% слабо залінкованних сторінок (видалити, приховати від індексації, поставити редіректи).

Приклад слабо залінкованного сайту:

Приклад добре залінкованного сайту:

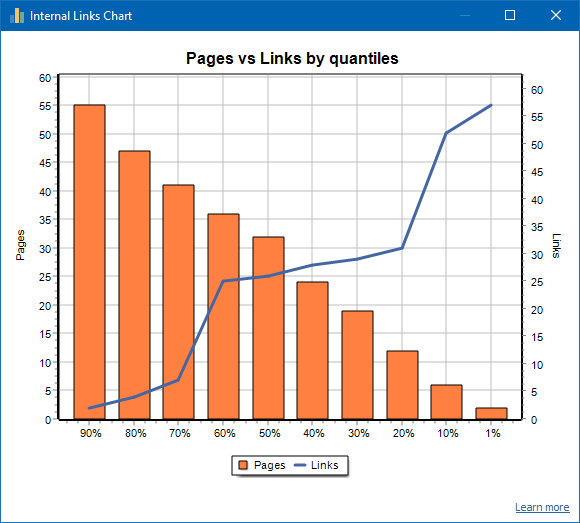

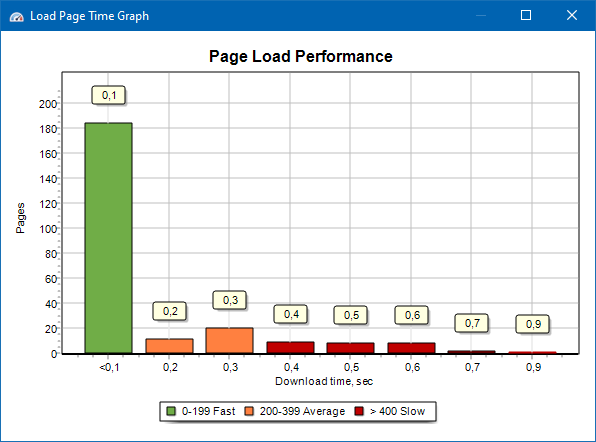

Графік швидкості завантаження сторінок

Графік швидкості завантаження сторінок дозволяє оцінити швидкодію сайту. Для наочності, сторінки розподілені по групах і тимчасових інтервалах з кроком в 100 мілісекунд.

Таким чином, виходячи з графіка можна визначити, яка частка сторінок сайту вантажиться швидко (в межах 0-100 мілісекунд), яка з середньою швидкістю (100-200 мілісекунд) і які сторінки завантажуються досить довго (400 мілісекунд і більше).

Примітка: зазначений час є часом завантаження вихідного коду HTML, а не часом повного завантаження сторінок (рендеринг сторінки, а також подгрузка елементів сторінки, таких як, наприклад, зображення і стиль, не враховується).

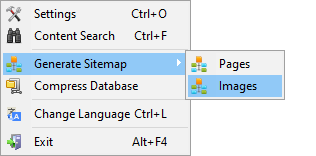

Генерація Sitemap.xml

Карта сайту генерується на основі просканованих сторінок або зображень сайту.

- При генерації карти сайту, що складається зі сторінок, в неї додаються сторінки формату "text / html".

- При генерації карти сайту, що складається із зображень, в неї додаються зображення JPG, PNG, GIF і тому подібних форматів.

Згенерувати карту сайту можна відразу після сканування сайту, через головне меню-пункт "Проекти -> Генерувати Sitemap".

Для сайтів великих обсягів, від 50 000 сторінок, є функція автоматичного розбиття "sitemap.xml" на декілька файлів (в цьому випадку основний файл містить посилання на додаткові, що містять безпосередньо посилання на сторінки сайту). Це пов'язано з вимогами пошукових систем для обробки файлів sitemap великих розмірів.

При необхідності, обсяг сторінок у файлі "sitemap.xml" можна варіювати, змінюючи значення 50 000 (встановлено за умовчанням) на потрібне значення в основних налаштуваннях програми.

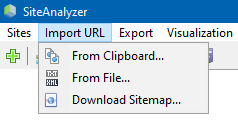

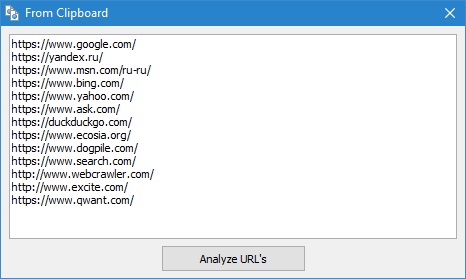

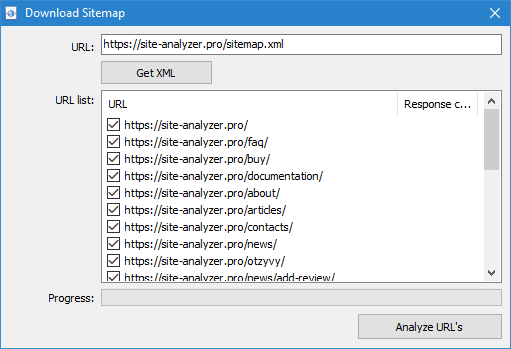

Сканування довільних URL

Пункт меню "Імпорт URL" призначений для сканування довільних списків URL, а також XML-карт сайту Sitemap.xml (в тому числі і індексних) для їх подальшого аналізу.

Сканування довільних URL можливо трьома способами:

- шляхом вставки списку URL з буфера обміну

- завантаження з жорсткого диска файлів формату *.txt і *.xml, що містять списки URL

- шляхом скачування файлу Sitemap.xml безпосередньо з сайту

Особливістю цього режиму є те, що при скануванні довільних URL сам "проект" не зберігається в програмі і дані за нього не додається в базу. Також не доступні розділи "Структура сайту" і "Дашборд".

Більш детально ознайомитись з роботою пункту "Імпорт URL" можна в цій статті: Огляд нової версії SiteAnalyzer 1.9.

Dashboard

Вкладка "Дашборд", відображає докладний звіт про поточний якості оптимізації сайту. Звіт генерується на основі даних вкладки "Статистика SEO". Крім цих даних у звіті присутня вказівка загального показника якості оптимізації сайту, розраховується за 100-бальною шкалою щодо поточної ступеня його оптимізації. Є можливість експорту даних вкладки "Дашборд" у зручний звіт у форматі PDF.

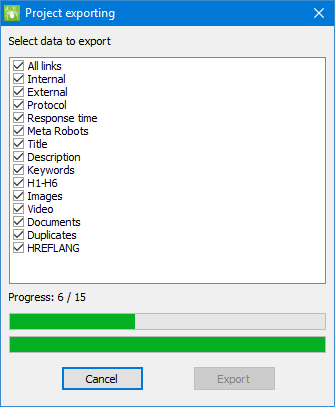

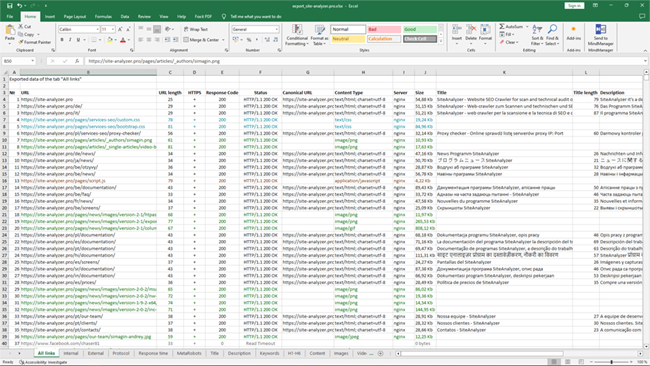

Експорт даних

Для більш гнучкого аналізу отриманих даних є можливість їх вивантаження в CSV формат (експортується поточна активна вкладка), а також генерації повноцінного звіту в Microsoft Excel з усіма вкладками в одному файлі.

При експорті даних в Excel з'являється спеціальне вікно, в якому користувач може вибрати колонки і потім згенерувати звіт з потрібними даними.

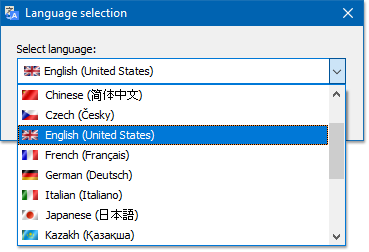

Багатомовність

У програмі є можливість вибору потрібної мови, на якому буде вестися робота.

Основні підтримувані мови: російська, англійська, німецька, італійська, іспанська, французька... На даний момент програма перекладена на більш ніж за п'ятнадцять (15) найбільш популярних мов.

Якщо ви хочете перевести програму на свою рідну мову, то для цього достатньо перевести будь-який файл "*.lng" на зацікавив мову, після чого перекладений файл потрібно відправити на адресу "support@site-analyzer.pro" (коментарі до листа повинні бути написані російською або англійською мовами) і ваш переклад буде включений в новий реліз програми.

Більш детальна інструкція по перекладу програми на мови знаходиться в дистрибутиві (файл "lcids.txt").

P.S. Якщо у вас є зауваження за якістю перекладу - відправляйте зауваження і виправлення "support@site-analyzer.ru".

Стиснення бази даних

Пункт головного меню "Стиснути базу даних" призначений для виконання операції упаковки бази даних (чистка бази від раніше видалених проектів, а також упорядкування даних (аналог дефрагментації даних на персональних комп'ютерах)).

Дана процедура ефективна в разі, коли наприклад, з програми було видалено великий проект, який містить велику кількість записів. В цілому рекомендується проводити періодичне стиснення даних для рятування від надлишкових даних і зменшення обсягу бази.

З відповідями на інші питання можна ознайомитися в розділі FAQ >>