A atribuição de programa

O programa SiteAnalyzer é projetado para analisar o seu site e identificar erros técnicos (busca de links quebrados, a duplicação de páginas inválidas de resposta do servidor), e também de erros e de falhas em SEO-otimização (vazios de meta-tags, o excesso ou ausência total de páginas de título de h1, a análise de conteúdo da página, qualidade перелинковки e muitos outros parâmetros de SEO).

Principais características

- A digitalização de todas as páginas do site, bem como imagens, scripts e documentos

- Obtendo o código de resposta do servidor para cada página do site (200, 301, 302, 404, 500, 503 etc.)

- A detecção e o conteúdo Title, Keywords, Description, H1-H6

- A busca e a exibição de "duplicatas" das páginas, meta tags e título

- Determinar se o atributo rel="canonical" para cada página do site

- Seguindo as diretivas do arquivo "robots.txt", a meta tag "robots", ou X-Robots-Tag

- Contabilidade "noindex" e "nofollow" ao rastrear as páginas do site

- Extração de dados com XPath, CSS, XQuery, RegEx

- Verificar a exclusividade do conteúdo do site

- Verificando a velocidade de carregamento da página pelo Google PageSpeed

- Análise de referência: a definição de links internos e externos para qualquer página do site

- Cálculo do PageRank interno para cada página do site

- Visualização da estrutura do site no gráfico

- Determinando o número de redirecionamentos da página (redirecionamentos)

- Varra URLs arbitrários e Sitemap.xml externo

- Sitemap "sitemap.xml" geração (com a possibilidade de dividir em vários arquivos)

- Filtrando dados por qualquer parâmetro (configuração flexível de filtros de qualquer complexidade)

- Pesquise conteúdo arbitrário no site

- A exportação de relatórios CSV, Excel e PDF

Diferenças de análogos

- Baixos requisitos de recursos do computador, pequeno consumo de memória ram

- A digitalização de sites em quase todo o volume por conta de baixos requisitos de recursos do computador

- O portátil formato (funciona sem a instalação em um PC ou directamente a partir de um meio amovível)

Tópicos

- Introdução

- Configurações do programa

- Configurações básicas

- Digitalização

- SEO

- Virtual Robots.txt new

- Yandex XML

- User-Agent

- Cabeçalhos HTTP arbitrários new

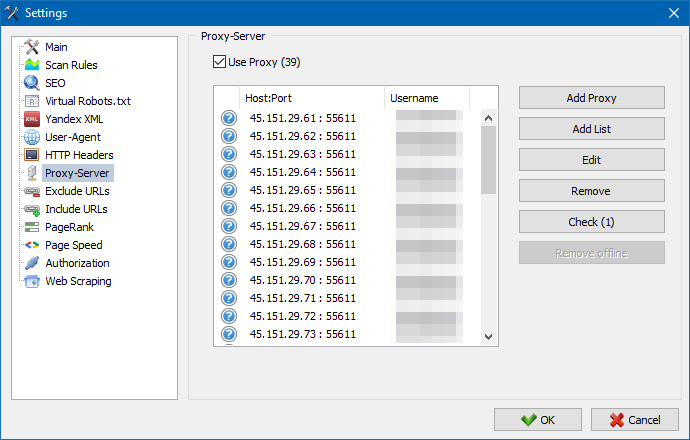

- Um servidor Proxy

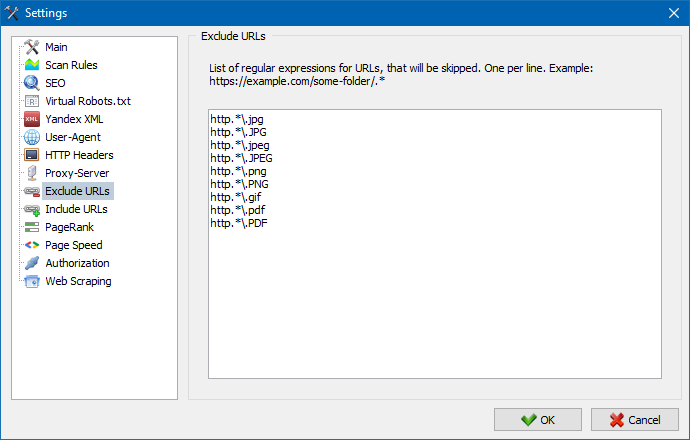

- Excluir URL

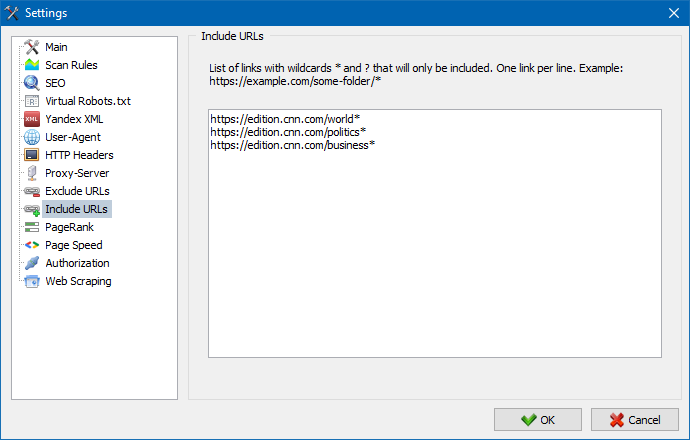

- Seguir URL

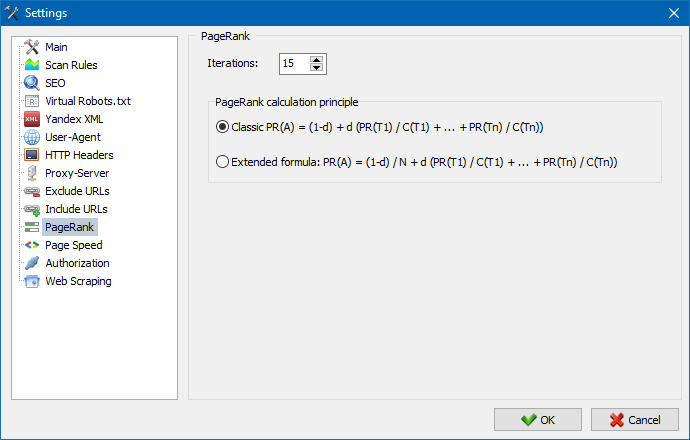

- PageRank

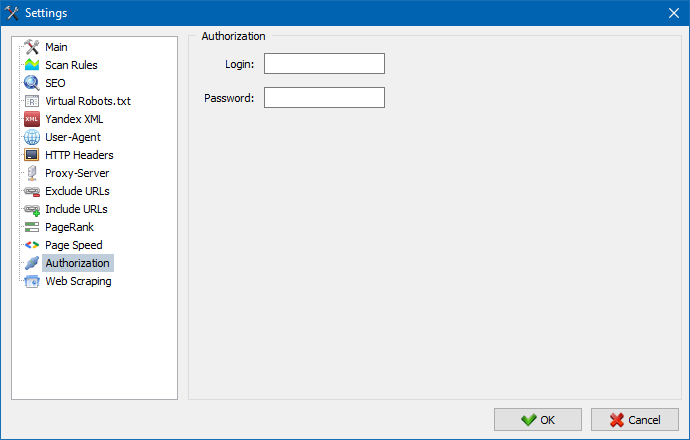

- Autorização

- O trabalho com o programa

- Configuração de colunas e guias

- A filtragem de dados

- Estatísticas do site técnico

- Estatísticas de SEO

- Custom Filters

- Custom Search

- Raspagem de dados

- Verificação de exclusividade de conteúdo

- Verificando a velocidade de carregamento da página

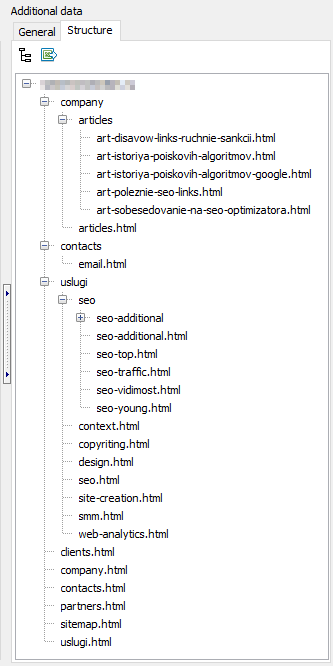

- A estrutura do site

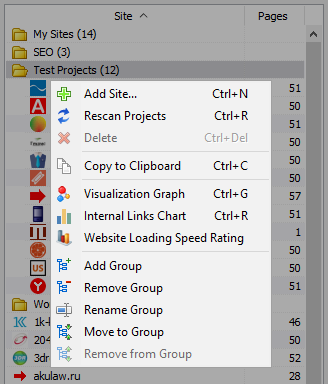

- Menu de contexto da lista de projetos

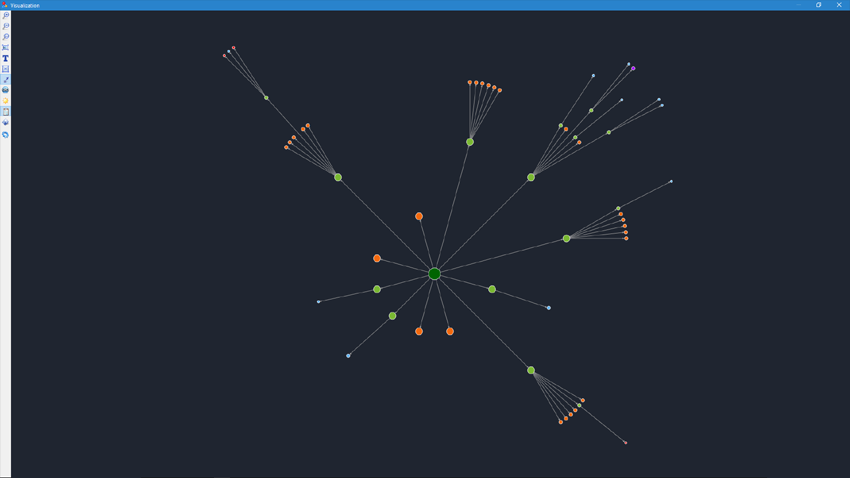

- Visualização da estrutura do site

- Gráfico de distribuição de links internos

- Gráfico de velocidade de carregamento da página

- A Geração De Sitemap.xml

- A digitalização arbitrário de URL

- Dashboard

- Exportação de dados

- Multilanguage

- Compressão de banco de dados

Introdução

Quando você executa o programa do usuário está disponível a barra de endereços para entrar com a URL analisado site (você pode inserir em qualquer página do site, assim como o robô de busca, passando através de links que a página original contornará todo o site, incluindo a página inicial, com a condição de que todas as ligações realizadas no HTML e não usam Javascript).

Após clicar em "Start", o robô começa a rastrear todas as páginas do site sobre os links internos (recursos externos, ele não fica, também não entra nos links, feita em Javascript).

Depois que o robô irá ignorar todas as páginas do site torna-se disponível o relatório, feito em forma de tabela e exibe os dados agrupados por temas guias.

Todos os projetos analisados são apresentados no lado esquerdo do programa e são salvos automaticamente no programa de banco de dados juntamente com os dados resultantes. Para remover sites, use o menu de contexto da lista de projetos.

Nota:

- ao clicar no botão "Pausar" a digitalização do projeto está suspenso, em paralelo progresso atual de digitalização é guardada na base, o que permite, por exemplo, fechar o programa e continuar a digitalização do projeto depois de reiniciar o programa com ponto de parada

- o botão "Stop" interrompe a digitalização do atual projeto, sem a possibilidade de continuar a sua exploração

Configurações do programa

A seção principal do menu "Configurações" destina-se a ajustes programa de trabalho com sites externos e contém 7 guias:

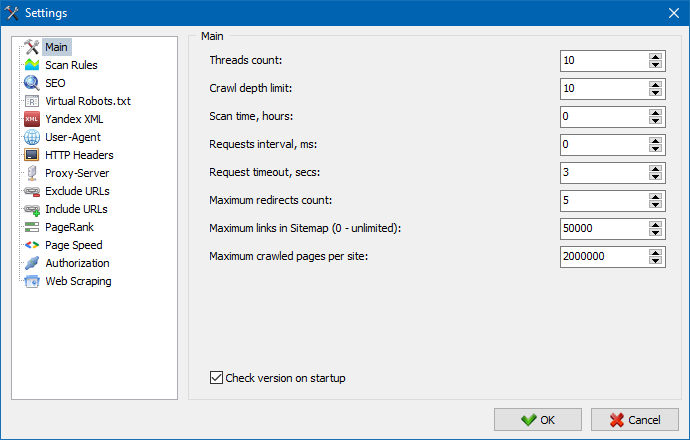

A secção definições básicas serve para informar ao usuário de directrizes, utilizados no rastreamento de um site.

Descrição dos parâmetros:

- O número de threads

- Quanto maior o número de threads, mais um URL consegue processar na unidade de tempo. Assim, é necessário considerar que um maior número de segmentos leva a um número maior de recursos do PC. Recomendamos que instale o número de threads em um intervalo de 5 a 10.

- O tempo de digitalização

- Serve para definir o limite de varredura do site em tempo. É medido em horas.

- Profundidade máxima

- Este parâmetro é usado para especificar a profundidade de digitalização do site. Página principal do website tem um nível de aninhamento = 0. Por exemplo, se você digitalizar uma página de um site do tipo "somedomain.ru/catalog.html" e "somedomain.ru/catalog/tovar.html" e, então, nesse caso, é preciso acertar o valor da profundidade máxima = 2.

- O atraso entre as solicitações

- Serve para a instalação de pausas durante as revoluções de scanner para páginas do seu site. Isso é necessário para os sites em "fracos" servidores não suportam cargas maiores e freqüentes a eles incidentes.

- Tempo limite de consulta

- Para definir o tempo limite de resposta de um site para consulta do programa. Se qualquer uma das páginas do site respondem lentamente (tempo carregadas), o rastreamento pode demorar muito tempo. Essas páginas, você pode cortar, especificando o valor, após o qual o scanner irá para a digitalização outras páginas do site e, assim, não vai atrasar o progresso comum.

- O número das páginas digitalizadas do site

- Limite máximo para o número das páginas digitalizadas. É útil se, por exemplo, você precisa analisar os N primeiros páginas do site, não são considerados de imagem, arquivos de estilo, scripts e outros tipos de arquivos).

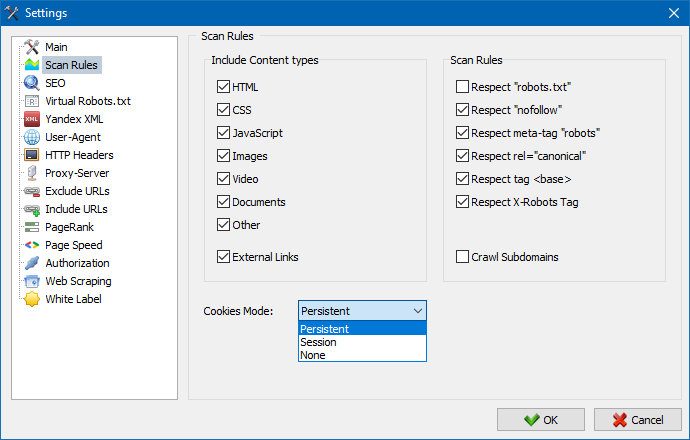

Considerar o conteúdo

- Nesta seção, você pode escolher os tipos de dados que serão contabilizados парсером ao rastrear páginas (de imagem, de vídeo, de estilos, scripts), ou eliminar o excesso de informações quando parseе.

Regras de digitalização

- Os dados de configuração relacionados com as configurações de exceções ao rastrear o website scanner usando o arquivo "robots.txt", através de links do tipo "nofollow", e também usando a directiva "meta name=robots" diretamente no código das páginas do site.

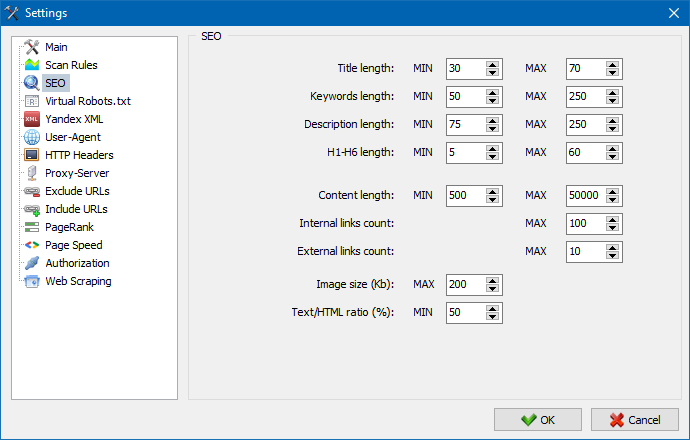

Esta secção serve para especificar o núcleo de análise de parâmetros de SEO, que posteriormente serão verificados a exatidão quando parseе páginas, depois de obtidas as estatísticas serão exibidas na guia Estatísticas de SEO" no lado direito da janela principal do programa.

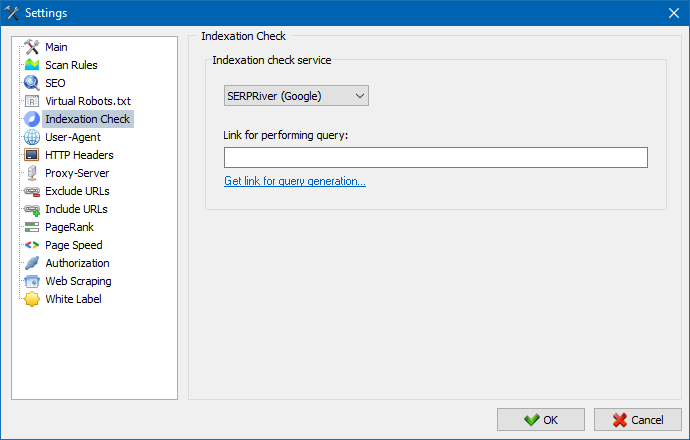

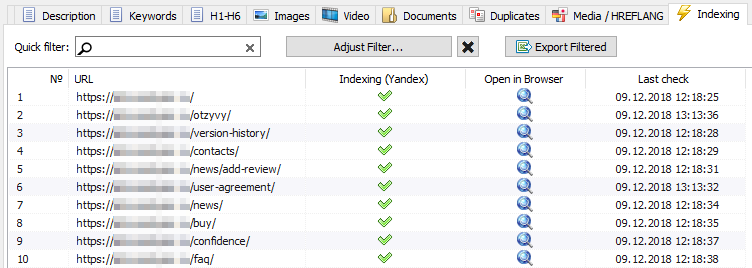

Com a ajuda destas configurações, você pode escolher um serviço através do qual você irá verificar a indexação de páginas no motor de busca Yandex. Existem duas opções para verificar a indexação: usando o serviço Yandex XML ou o serviço Majento.ru.

Ao escolher o serviço XML Yandex, você precisa levar em conta possíveis restrições (por hora ou diárias), que podem ser aplicadas ao verificar a indexação de páginas, considerando os limites existentes em sua conta Yandex, podendo haver situações em que os limites de sua conta não serão suficientes para verificar todos páginas de cada vez e para isso você tem que esperar pela próxima hora.

Ao usar o serviço Majento.ru, as restrições horárias ou diárias estão praticamente ausentes, pois seu limite literalmente se funde com o conjunto geral de limites, que não é pequeno em si, mas também tem um limite significativamente maior com restrições horárias do que qualquer uma das contas de usuário individuais no XML Yandex.

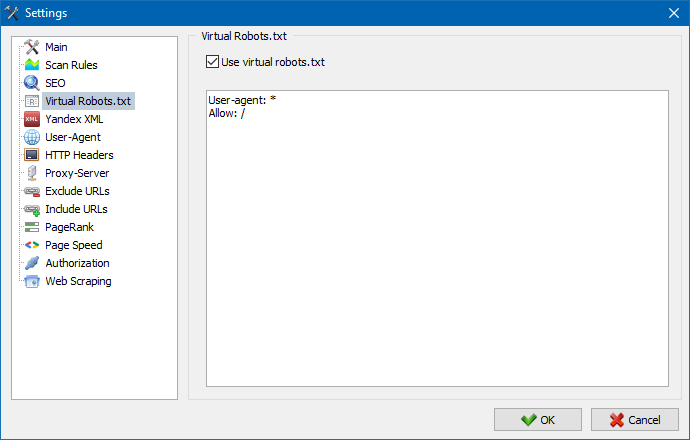

O robots.txt virtual pode ser usado em vez do robots.txt real hospedado no site.

Isso é útil ao testar um site, quando, por exemplo, você precisa rastrear certas seções do site que foram fechadas para indexação (ou vice-versa - não as leve em consideração ao rastrear), enquanto você não precisa fazer fisicamente muda para o arquivo robots.txt real e gasta o tempo do desenvolvedor nisso.

Nota: ao importar uma lista de URLs, são levadas em consideração as diretivas do robots.txt virtual (se esta opção estiver ativada), caso contrário nenhum robots.txt é levado em consideração para a lista de URLs.

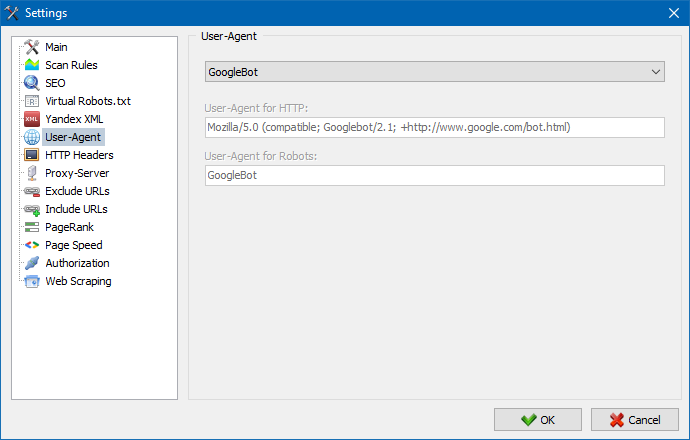

Na seção User-Agent, você pode especificar qual usuário-agente será apresentado o programa ao acessar sites externos durante a digitalização. Por умочанию, instalado usuário usuário-agente, no entanto, se for necessário, pode seleccionar uma das agentes mais freqüentemente encontrados na internet. Entre eles há como bots dos motores de busca YandexBot, GoogleBot, MicrosoftEdge, bots navegadores Chrome, Firefox, IE8, bem como os dispositivos móveis iPhone, Android e muitos outros.

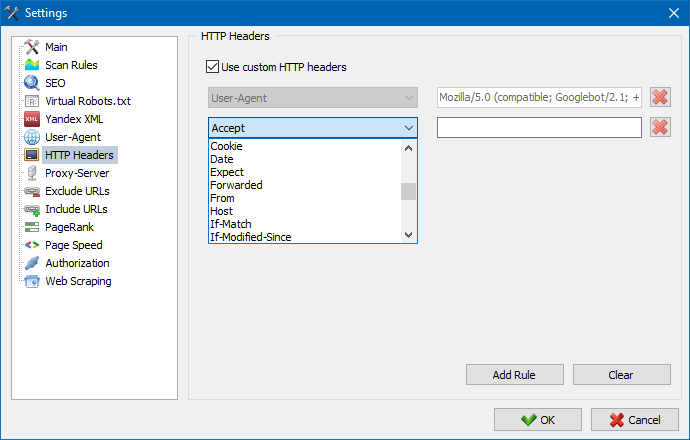

Usando esta opção, você pode analisar a reação do site e das páginas a diferentes solicitações. Por exemplo, alguém pode precisar enviar um Referer em uma solicitação, proprietários de sites multilíngues desejam transmitir Accept-Language | Charset | Encoding e alguém precisa transmitir dados incomuns nos cabeçalhos Accept-Encoding, Cache-Control e Pragma , etc. NS.

Usando esta opção, você pode analisar a reação do site e das páginas a diferentes solicitações. Por exemplo, alguém pode precisar enviar um Referer em uma solicitação, proprietários de sites multilíngues desejam transmitir Accept-Language | Charset | Encoding e alguém precisa transmitir dados incomuns nos cabeçalhos Accept-Encoding, Cache-Control e Pragma , etc. NS.

Se houver a necessidade de trabalhar através de um proxy, nesta seção, você pode adicionar uma lista de servidores proxy, que o programa irá aceder a recursos externos. Adicionalmente, existe a possibilidade de verificar o proxy de integridade, bem como a função de remover os servidores de proxy.

Esta seção destina-se a exceção de rastreamento determinadas páginas e seções do site quando parseе.

Usando os padrões de pesquisa * e ? você pode especificar quais seções do site não devem ser rastreadas pelo rastreador e, portanto, não devem ser incluídas no banco de dados do programa. Esta lista é uma lista local de exceção em tempo de varredura do site (sobre ele "global" a lista é um arquivo "robots.txt" na raiz do site).

Da mesma forma, permite adicionar URLs que devem ser rastreados. Nesse caso, todos os outros URLs fora dessas pastas serão ignorados durante a verificação. Esta opção também funciona com padrões de pesquisa * e ?

Usando o parâmetro PageRank, você pode analisar a estrutura de navegação de seus sites, bem como otimizar o sistema de links internos de um recurso da Web para transmitir o peso de referência para as páginas mais importantes.

O programa tem duas opções para calcular o PageRank: o algoritmo clássico e sua contraparte mais moderna. Em geral, para a análise da vinculação interna do site, não há muita diferença ao usar o primeiro ou o segundo algoritmo, para que você possa usar qualquer um dos dois algoritmos.

Uma descrição detalhada do algoritmo e os princípios de cálculo do PageRank podem ser encontrados no artigo "Cálculo do PageRank interno": >>

Digite o login e a senha para autorização automática nas páginas fechadas via .htpasswd e protegidas pela autorização do servidor BASIC.

O trabalho com o programa

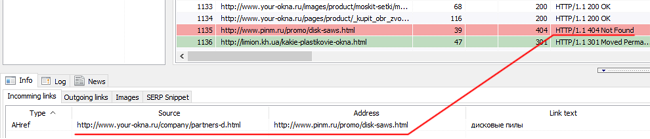

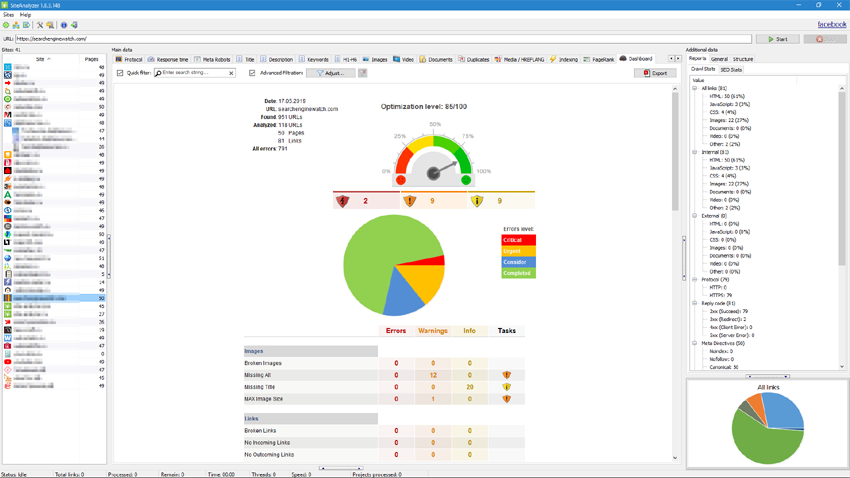

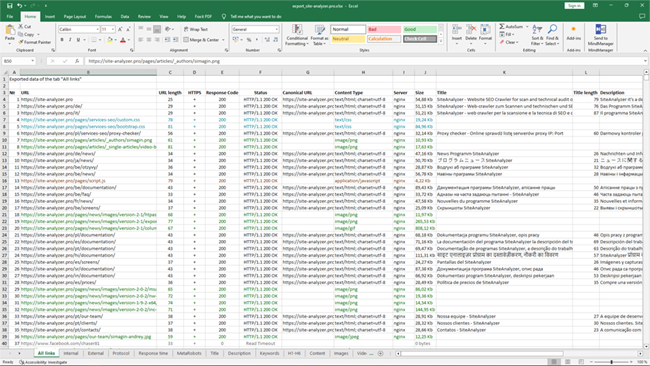

Quando a digitalização terminar, o usuário torna-se disponível as informações contidas no bloco "dados Básicos". Cada guia contém dados agrupados em relação a seus nomes (por exemplo, a guia "Title" contém o conteúdo de cabeçalhos de páginas <title></title> na aba "Imagens" - contém uma lista de todas as imagens do site e assim por diante). Com esses dados, pode-se realizar a análise de conteúdo de um site, localizar o "quebrados" links ou incorretamente preenchidos meta-tags.

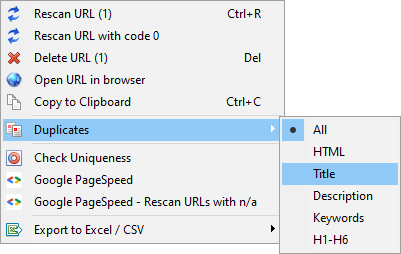

Quando necessário (por exemplo, depois de fazer alterações no site) usando o menu de contexto, existe a possibilidade de nova digitalização individuais URL para exibir as alterações no programa.

Com a ajuda deste mesmo menu, é possível exibir duplicados páginas correspondentes parâmetros (duplas title, description, keywords, h1, h2, o conteúdo de páginas).

O item "Examinar novamente a URL com o código 0" foi projetado para verificar automaticamente automaticamente todas as páginas que fornecem um código de resposta 0 (tempo limite de leitura). Esse código de resposta geralmente é fornecido quando o servidor não tem tempo para entregar o conteúdo e a conexão é fechada por tempo limite, respectivamente, a página não pode ser carregada e as informações dela não podem ser extraídas.

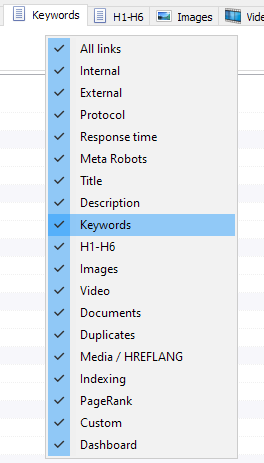

Configuração de colunas e guias

Agora você pode selecionar as guias serão exibidas na interface de dados de referência (finalmente, tornou-se possível dizer adeus com uma moral ultrapassada a guia Meta Keywords). Isso é útil se taba não cabem na tela, ou você raramente usá-los.

As colunas também pode ocultar ou mover para o lugar certo, arrastando-o.

A exibição de tabs e de colunas que você pode configurar usando a chamada do menu de atalho no painel de dados mestre. A migração das colunas é feito através do mouse.

Para facilitar a análise de estatísticas no site do programa está disponível a filtragem de dados. A filtragem é possível em duas versões:

- de qualquer campo usando o "atalho" do filtro

- com o uso de um filtro personalizado (com a ajuda de definições avançadas de seleção de dados)

Filtro rápido

É usado para a rápida para filtrar os dados e aplica-se, simultaneamente, a todos os campos da guia atual.

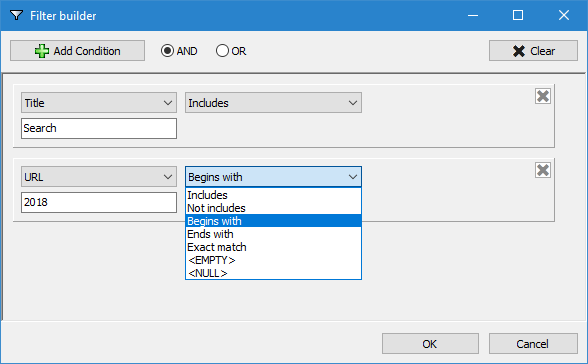

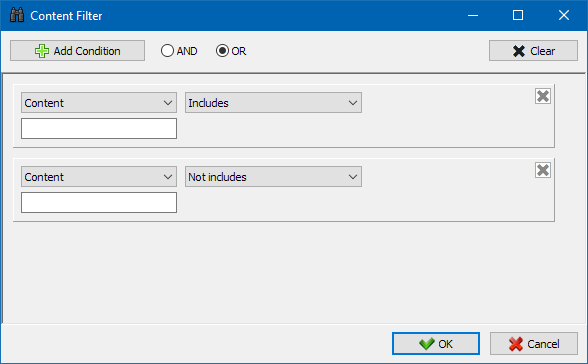

Um filtro personalizado

Projetado para detalhes de filtragem e pode conter, simultaneamente, várias condições. Por exemplo, para uma meta tag "title" você anda filtrar a página de seu comprimento, para que ele não ultrapasse 70 caracteres e, simultaneamente, continha o texto de "a notícia". Então este filtro seria:

Assim, aplicando um filtro personalizado a partir de qualquer uma das guias, você pode extrair dados de qualquer complexidade.

A guia de estatísticas técnicas do site está localizada no painel Dados adicionais e contém um conjunto de parâmetros técnicos básicos do site: estatísticas em links, metatags, códigos de resposta da página, parâmetros de indexação de página, tipos de conteúdo etc. parâmetros.

Ao clicar em um dos parâmetros, eles são automaticamente filtrados na guia correspondente dos dados cadastrais do site e, ao mesmo tempo, as estatísticas são exibidas no diagrama na parte inferior da página.

A aba de estatísticas de SEO é destinada a conduzir auditorias de site completas e contém mais de 50 parâmetros principais de SEO e identifica mais de 60 erros chave de otimização interna! O mapeamento de erros é dividido em grupos, que, por sua vez, contêm conjuntos de parâmetros e filtros analisados que detectam erros no site.

Uma descrição detalhada de todos os parâmetros verificados está neste artigo. >>

Para todos os resultados de filtragem, é possível exportá-los rapidamente para o Excel sem diálogos adicionais (o relatório é salvo na pasta do programa).

Neste separador são colocados filtros predefinidos que permitem a criação de amostragem em todos os links externos, erros 404, imagens e outros parâmetros, com todas as páginas em que eles estão presentes. Portanto, agora você pode facilmente e rapidamente obter uma lista de links externos e das páginas em que são colocados, ou selecionar todos links quebrados e ver imediatamente quais páginas eles estão localizados.

Todos os relatórios estão disponíveis no programa on-line e podem ser exibidos na guia "Custom" painel de dados mestre. Adicionalmente, há a possibilidade de exportar para Excel através do menu principal.

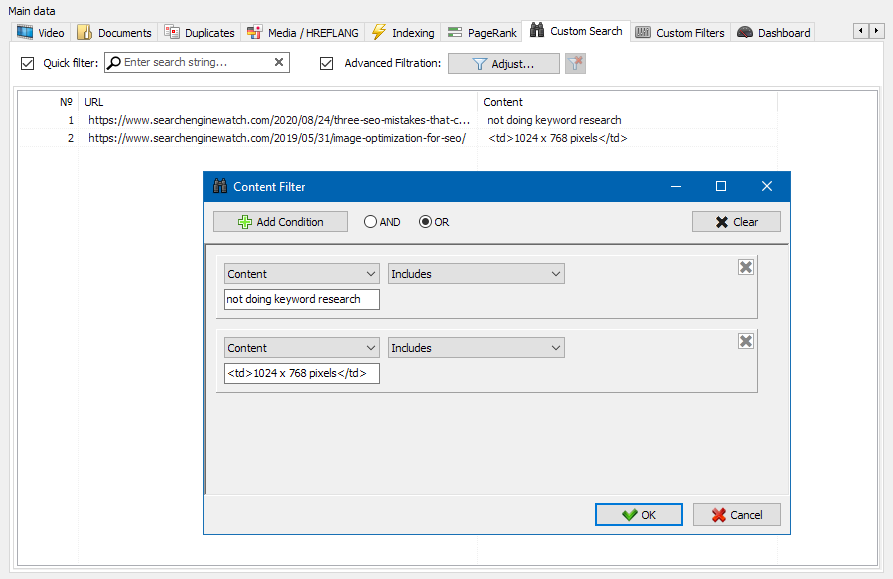

O recurso de pesquisa de conteúdo do site permite que você pesquise o código-fonte e exiba páginas da web com o conteúdo que você está procurando.

O módulo de filtros personalizados permite que você verifique a presença de micromarcações, metatags, sistemas analíticos, fragmentos de texto livre ou código HTML no site.

Na janela de configuração do filtro, existem vários parâmetros para pesquisar por determinados fragmentos de texto nas páginas do site ou, inversamente, para excluir páginas que contenham determinado texto ou fragmentos de código HTML dos resultados da pesquisa (esta função é semelhante a pesquisar conteúdo no código-fonte de uma página usando Ctrl-F) ...

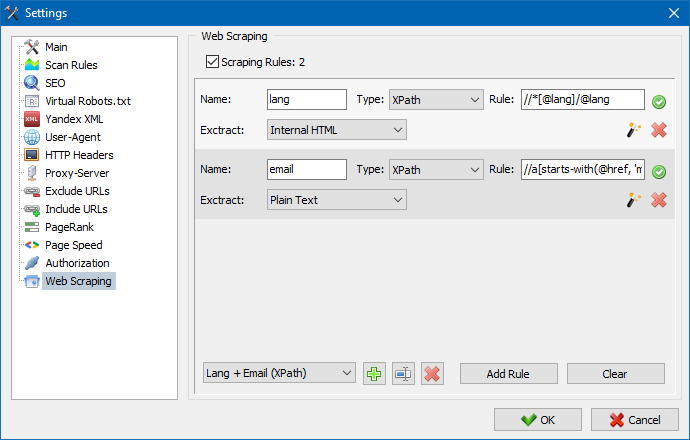

Normalmente, a raspagem é usada para resolver tarefas que são difíceis de realizar manualmente. Isso pode ser extrair descrições de produtos para criar uma nova loja online, raspando em pesquisas de marketing para monitorar preços ou para monitorar anúncios.

No SiteAnalyzer, a extração é configurada na guia Extração de dados, onde as regras de extração são configuradas. As regras podem ser salvas e, se necessário, editadas.

Também existe um módulo de teste de regra. Usando o depurador de regras integrado, você pode obter de forma rápida e fácil o conteúdo HTML de qualquer página do site e testar o trabalho das consultas e, em seguida, usar as regras depuradas para analisar dados no SiteAnalyzer.

Após finalizar a extração dos dados, todas as informações coletadas podem ser exportadas para o Excel.

Para um estudo mais detalhado da operação do módulo e uma lista das regras e expressões regulares mais comuns, consulte o artigo

Verificação de exclusividade de conteúdo

Esta ferramenta permite pesquisar páginas duplicadas e verificar a singularidade dos textos dentro do site. Em outras palavras, esta é uma verificação em lote de um grupo de URLs quanto à exclusividade entre eles.

Isso pode ser útil nos casos:

- Para pesquisar páginas duplicadas completas (por exemplo, uma página com parâmetros e a mesma página, mas na vista CNC).

- Para pesquisar correspondências parciais de conteúdo (por exemplo, duas receitas de borscht em um blog de culinária, que são 96% semelhantes entre si, o que sugere que um dos artigos deve ser excluído para se livrar de uma possível canibalização do tráfego).

- Quando em um site de artigos, você acidentalmente escreveu um artigo sobre um tópico que já havia escrito há 10 anos. Nesse caso, nossa ferramenta também detectará uma duplicata de tal artigo.

O princípio da ferramenta de verificação da singularidade do conteúdo é simples: o programa baixa o conteúdo da lista de URLs do site, recebe o conteúdo de texto da página (sem o bloco HEAD e sem tags HTML) e, a seguir, os compara com cada um outro usando o algoritmo de cascalho.

Assim, usando telhas, determinamos a exclusividade das páginas e podemos calcular duplicatas completas de páginas com 0% de exclusividade e duplicatas parciais com vários graus de exclusividade do conteúdo do texto. O programa funciona com um comprimento de telha de 5.

Você pode aprender mais sobre como o módulo funciona neste artigo.: >>

Verificando a velocidade de carregamento da página

A ferramenta PageSpeed Insights do gigante das buscas do Google permite que você verifique a velocidade de carregamento de certos elementos da página e também mostra a pontuação geral da velocidade de carregamento dos URLs de interesse para as versões desktop e móvel do navegador.

A ferramenta do Google é boa para todos, no entanto, tem uma desvantagem significativa - não permite que você crie verificações de URL de grupo, o que cria inconvenientes ao verificar muitas páginas do seu site: concorde que verificar manualmente a velocidade de download de 100 ou mais URLs em uma página é uma tarefa árdua e pode levar muito tempo.

Portanto, criamos um módulo que permite criar verificações de grupo de velocidade de carregamento de página gratuitamente por meio de uma API especial na ferramenta Google PageSpeed Insights.

Parâmetros principais analisados:

- FCP (First Contentful Paint) – hora de exibir o primeiro conteúdo.

- SI (Speed Index) – um indicador de quão rapidamente o conteúdo é exibido em uma página.

- LCP (Largest Contentful Paint) – tempo de exibição para o maior elemento da página.

- TTI (Time to Interactive) – o tempo durante o qual a página fica totalmente pronta para a interação do usuário.

- TBT (Total Blocking Time) – tempo desde a primeira renderização do conteúdo até sua prontidão para a interação do usuário.

- CLS (Cumulative Layout Shift) – mudança cumulativa de layout. Serve para medir a estabilidade visual da página.

Ao mesmo tempo, a análise da própria URL ocorre em apenas alguns cliques, após os quais um relatório pode ser baixado, incluindo as principais características dos cheques em um formato conveniente no Excel.

Tudo que você precisa para começar é obter uma chave de API.

Como fazer isso é descrito neste artigo. >>

Esta funcionalidade destina-se a criar a estrutura do site em uma base de dados recebidos. A estrutura do site é gerado com base de assentamento URL de páginas. Depois de gerar a estrutura disponível para a sua exportação para CSV-formato (Excel).

Menu de contexto da lista de projetos

- Na lista de projetos está disponível a digitalização em massa através da atribuição de sites relevantes e premir o botão "Пересканировать". Depois que todos os sites estão em fila e digitalizados, alternadamente em modo padrão.

- Também, para a conveniência de trabalhar com o programa, a eliminação em massa dos sites escolhidos também está disponível através do botão "Remover".

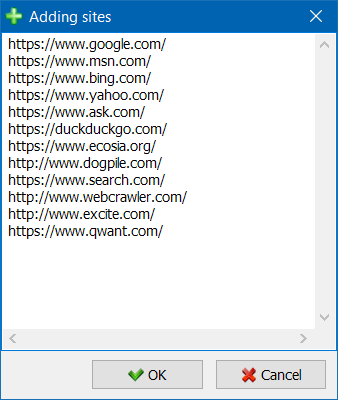

- Além da unidade de digitalização de sites, existe a possibilidade de uma massa de adicionar sites à lista de projetos utilizando o formulário especial, o usuário pode analisar o seu interesse para projetos completos.

- Para uma navegação mais conveniente pela lista de projetos, é possível agrupar sites por pastas, bem como filtrar a lista de projetos por nome.

Visualização da estrutura do site

O modo de visualização de referência de relacionamentos em um gráfico de ajuda SEO-técnico de avaliar a distribuição interna de PageRank das páginas do site, bem como compreender quais páginas recebem a maior referencial de massa (e, consequentemente, mais interno de referência de peso aos olhos dos motores de busca), e quais as páginas e seções do site não é falta de ligações internas.

Usando o modo de visualização da estrutura do site SEO-especialista será capaz de claramente avaliar como está organizado interna relink no site, bem como através da representação visual de massa PageRank atribuído a uma ou outra página, prontamente fazer ajustes no atual vinculação site e assim aumentar a relevância para o interesse de páginas.

No lado esquerdo da janela de visualização são as principais ferramentas para o trabalho com o conde:

- a mudança de escala no gráfico

- a rotação de um gráfico em qualquer ângulo

- alternar a janela de gráfico em modo de tela cheia (também funciona com a tecla F11)

- mostrar / ocultar a sites de assinaturas (Ctrl-T)

- mostrar / ocultar as setas você linhas

- mostrar / ocultar ligações externas (Ctrl-E)

- alternar o modo de esquema de cores Dia / Noite (Ctrl-D)

- mostrar / ocultar as lendas e as estatísticas do conde (Ctrl-L)

- guardar um gráfico em formato PNG (Ctrl-S)

- a janela definições de visualização (Ctrl-O)

A seção "Vista" é projetado para alterar o formato de visualização de sites em campo. No modo de desenho de sites "PageRank", dimensões de sites são definidas em relação à anteriormente calculado o índice de PageRank, resultando em um gráfico, você pode ver claramente, quais as páginas que recebem mais de referência de peso, como recebem menos de links.

No modo clássico dimensões sites estão relativamente selecionado escala do gráfico de visualização.

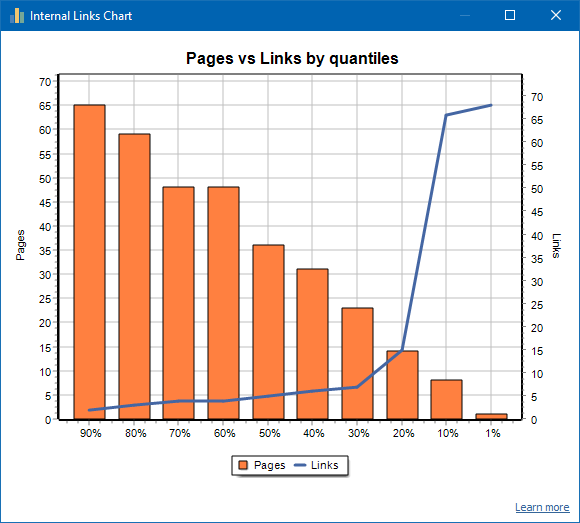

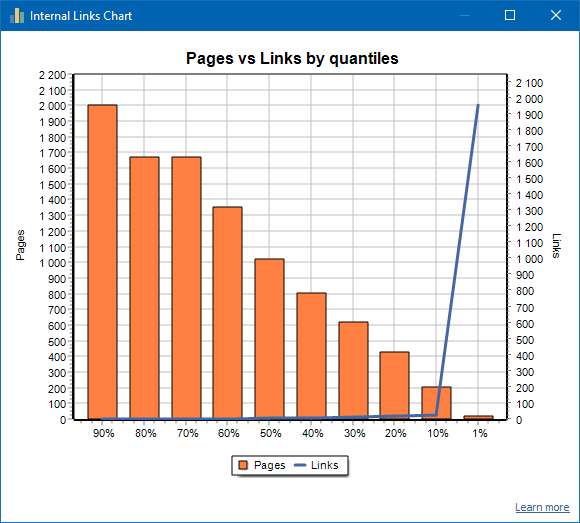

Gráfico de distribuição de links internos

Este gráfico mostra a distribuição da massa de links internos nas páginas do site (podemos dizer que se trata de uma visualização dos links de forma visual, ao invés de ser apresentada no Gráfico de Visualização). Ler mais >>

À esquerda está o número de páginas, à direita está o número de links. Abaixo estão os quantis percentuais por página. Ao desenhar um gráfico, os links duplicados são descartados (se houver 3 links da página A para a página B, então os contamos como um).

Por exemplo, com base na captura de tela acima, para um site de cerca de 70 páginas:

- 1% páginas têm ~68 links de entrada.

- 10% páginas têm ~66 links de entrada.

- 20% páginas têm ~15 links de entrada.

- 30% páginas têm ~8 links de entrada.

- 40% páginas têm ~7 links de entrada.

- 50% páginas têm ~6 links de entrada.

- 60% páginas têm ~5 links de entrada.

- 70% páginas têm ~5 links de entrada.

- 80% páginas têm ~3 links de entrada.

- 90% páginas têm ~2 links de entrada.

Ou seja, se percebermos que temos páginas para as quais levam menos de 10 links de entrada, essas páginas podem ser consideradas com links fracos e 60% das nossas páginas normalmente têm links. Com base nisso, podemos colocar mais links internos para essas páginas com links fracos (se as páginas forem importantes para promoção) ou deixar como estão, se essas páginas forem de baixa importância e baixa prioridade.

Na prática geral, as páginas com menos de 10 links internos têm menos probabilidade de serem rastreadas por mecanismos de pesquisa, em particular os bots do Google.

Portanto, se você vir um site que tem apenas 20-30% das páginas normalmente vinculadas do número total de páginas do site, faz sentido se aprofundar na configuração de vinculação ou pensar em como lidar com esses 80-70% de páginas com links fracos (excluir, ocultar de indexação, colocar redirecionamentos).

Um exemplo de site com link fraco:

Um exemplo de um site com bons links:

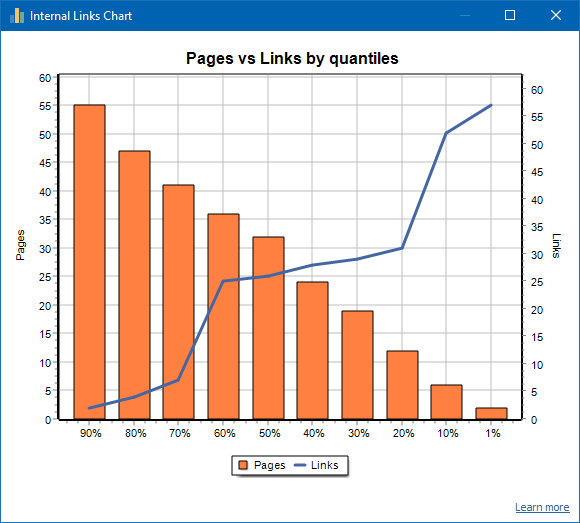

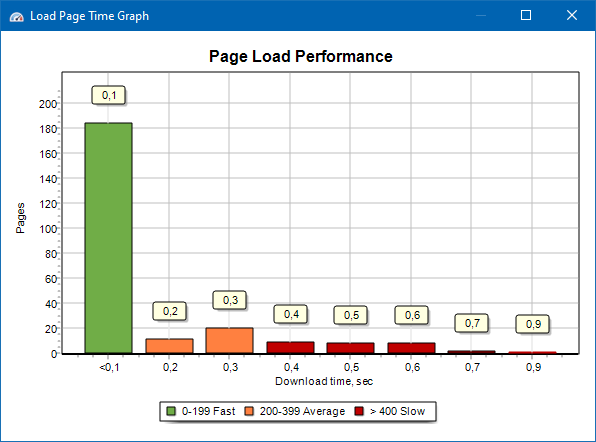

Gráfico de velocidade de carregamento da página

O gráfico de velocidade de carregamento da página permite que você avalie o desempenho do site. Para maior clareza, as páginas são divididas em grupos e intervalos de tempo com uma etapa de 100 milissegundos.

Assim, com base no gráfico, você pode determinar que proporção de páginas do site são carregadas rapidamente (em 0-100 milissegundos), em uma velocidade média (100-200 milissegundos) e quais páginas são carregadas por tempo suficiente (400 milissegundos ou mais).

Observação: o tempo mostrado é o tempo para carregar o código-fonte HTML, não o tempo para carregar totalmente as páginas (a renderização da página, bem como o carregamento dos elementos da página, como imagens e estilos, não são levados em consideração).

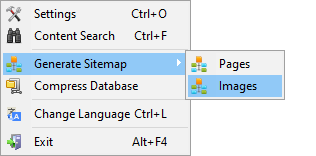

A Geração De Sitemap.xml

O mapa do site é gerado com base em páginas rastreadas ou imagens do site.

- Ao gerar um mapa do site consistindo de páginas, páginas do formato "text / html" são adicionadas a ele.

- Ao gerar um mapa do site composto de imagens, JPG, PNG, GIF e imagens semelhantes são adicionados a ele.

Para gerar o mapa do site, você pode imediatamente após a digitalização do site, através do menu principal: o ponto de "Projects -> Gerar Sitemaps".

Para sites de grande volume, de 50 000 páginas, possui uma função de auto divisão "sitemap.xml" em vários arquivos (nesse caso, o arquivo contém links para mais, contendo diretamente na página). Isto é devido aos requisitos de motores de busca para manipulação de arquivos de sitemap, de grandes dimensões.

Quando necessário, a quantidade de páginas em um arquivo "sitemap.xml" pode variar, alterando o valor de 50 000 (definição padrão) para o valor desejado em configurações básicas do programa.

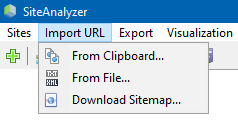

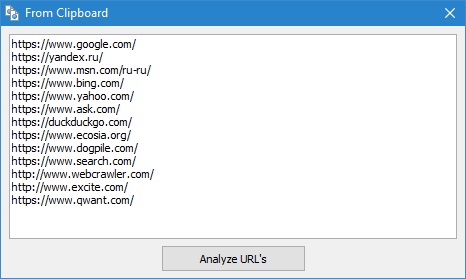

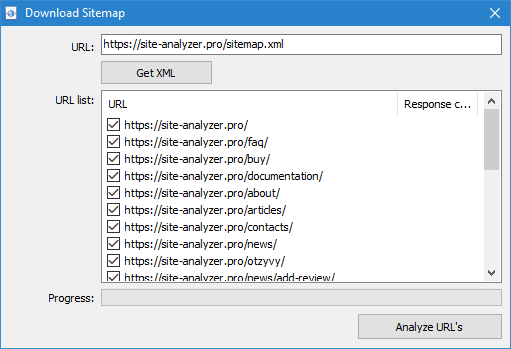

A digitalização arbitrário de URL

O item de menu "Import URL" se destina à digitalização a arbitrárias de listas de URL, e XML-mapas do site Sitemap.xml (incluindo marcas de índice) para posterior análise.

A digitalização de URL arbitrários possível de três maneiras:

- através da inserção de uma lista de URLS para a área de transferência

- a inicialização a partir do disco rígido com arquivos no formato *.txt e *.xml que contêm listas de URL

- download do arquivo Sitemap.xml diretamente com o site

A característica deste modo é que, quando a digitalização arbitrário de URL em si o "projeto" não é guardada no programa e os dados nele não é adicionado à base. Também não estão disponíveis chaves de "Estrutura do site" e "Дашборд".

Mais familiarizado com o trabalho do ponto "a Importação de URLS a este artigo: Visão geral da nova versão do SiteAnalyzer 1.9.

Dashboard

Guia "Dashboard", exibe um relatório detalhado sobre a atual como a otimização de site. O relatório será gerado com base nos dados do separador "Estatísticas de SEO". Além desses dados no relatório de presente uma indicação geral do índice de qualidade de otimização de site, calculado sobre 100-escala de pontos sobre a atual grau de otimização. Existe a possibilidade de exportação de dados da guia "Dashboard" o relatório no formato PDF.

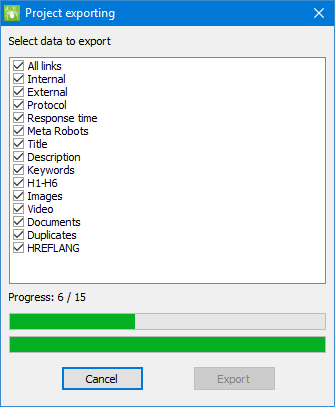

Exportação de dados

Para mais flexível da análise dos dados, existe a possibilidade de sua descarga em um formato (são exportados atual ativo separador), mas também a geração de um completo relatório no Microsoft Excel, com todos os guias em um único arquivo.

Quando exporta dados para o Excel, você receberá uma janela especial, onde o usuário pode escolher o interesse da coluna e, em seguida, gerar um relatório com os dados desejados.

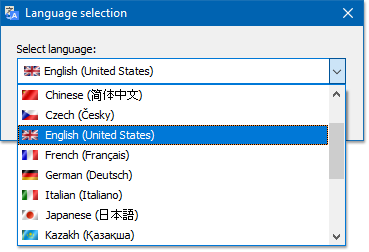

Multilinguismo

O programa tem a capacidade de seleção de idioma de preferência, o qual irá trabalhar.

Os principais idiomas suportados: português, inglês, alemão, italiano, espanhol, francês... No momento, o programa está traduzido em mais de quinze (15) mais de linguagens populares.

Se você quiser traduzir o programa em seu idioma nativo, o suficiente para traduzir a partir de qualquer arquivo "*.lng" para a sua língua, depois de traduzido, o arquivo, é preciso enviar para o endereço "support@site-analyzer.pro" (comentários ao pé da letra deve ser escrita em russo ou inglês) e a sua tradução será incluído na nova versão do programa.

Para mais instruções detalhadas sobre a tradução de programas em linguagens está na distribuição (arquivo "lcids.txt").

P.S. Se você tem comentários sobre a qualidade da tradução - envie comentários e correcções no "support@site-analyzer.ru".

Compressão de banco de dados

O item do menu principal "para Compactar o banco de dados é projetado para executar uma operação de banco de dados embalagem (limpar o banco de dados previamente excluídos do projecto, bem como a ordenação de dados (semelhante a um desfragmentador de dados em computadores pessoais)).

Este procedimento é eficaz no caso de, por exemplo, quando, a partir do programa foi removido de um grande projeto que contém um grande número de registros. Em geral, é recomendável realizar periodicamente a compressão de dados para a eliminação de dados redundantes e reduzir o tamanho do seu banco.

Com as respostas de outras perguntas, por favor consulte o FAQ >>