El nombramiento de los programas de

El programa de SiteAnalyzer está diseñada para el análisis del sitio y de identificar los errores técnicos (búsqueda de enlaces rotos, duplicados de páginas incorrectas las respuestas del servidor), así como de los errores y los defectos en la SEO-optimización (sin etiquetas meta, el exceso o la falta completa de los títulos h1, el análisis de contenido de la página, la calidad de volver a vincular y muchos otros parámetros de SEO -).

Características principales

- Escaneado todas las páginas del sitio, así como de las imágenes, scripts y documentos

- La obtención de los códigos de respuesta del servidor para cada página del sitio (200, 301, 302, 404, 500, 503 etc.)

- La determinación de la existencia y el contenido de Title, Keywords, Description, H1-H6

- La búsqueda y visualización de "duplicados", páginas, etiquetas meta y encabezados

- La determinación de la existencia de un atributo rel="canonical" para cada página del sitio

- Siguiendo las directivas del archivo "robots.txt", la metaetiqueta "robots" o X-Robots-Tag

- Contabilidad "noindex" y "nofollow" al rastrear las páginas del sitio

- Extracción de datos con XPath, CSS, XQuery, RegEx

- Comprobación de la singularidad del contenido dentro del sitio.

- Comprobación de la velocidad de carga de la página mediante Google PageSpeed

- Análisis de referencia: la definición de enlaces internos y externos para cualquier página del sitio

- Cálculo del PageRank interno para cada página del sitio

- Visualización de la estructura del sitio en el gráfico

- Determinación del número de redirecciones desde la página (redirecciones)

- Escanear URLs arbitrarias y Sitemap.xml externo

- Sitemap "sitemap.xml" generación (con la posibilidad de dividir en varios archivos)

- Filtrado de datos por cualquier parámetro (configuración flexible de filtros de cualquier complejidad)

- Buscar contenido arbitrario en el sitio.

- Exportación de informes en formato CSV, Excel y PDF

Las diferencias de los análogos de

- Los bajos requisitos de recursos del equipo, bajo consumo de memoria ram

- Análisis de los sitios de prácticamente cualquier longitud, gracias a los bajos requisitos de recursos del equipo

- Portátil de formato (funciona sin necesidad de instalación en el pc o directamente desde un disco extraíble)

De la documentación

- Inicio

- La configuración del programa

- Configuración básica

- Escaneo

- SEO

- Virtual Robots.txt new

- Yandex XML

- User-Agent

- Encabezados HTTP arbitrarios new

- Servidor Proxy

- Excluir URL

- Sigue URL

- PageRank

- Autorización

- El trabajo con el programa

- Personalización de las columnas y pestañas

- El filtrado de datos

- Estadisticas tecnicas del sitio

- Estadísticas de SEO

- Custom Filters

- Custom Search

- Raspado de datos

- Comprobación de la unicidad del contenido

- Comprobación de la velocidad de carga de la página

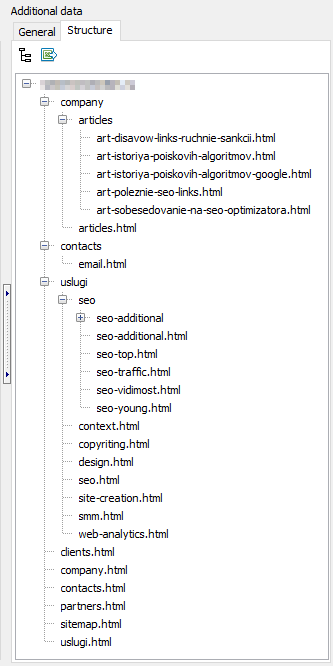

- La estructura del sitio

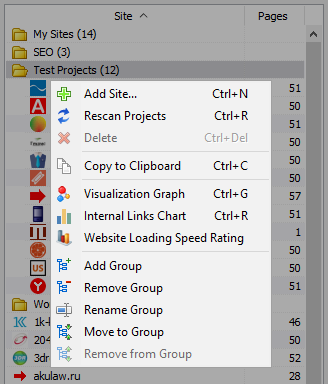

- El menú contextual de la lista de proyectos

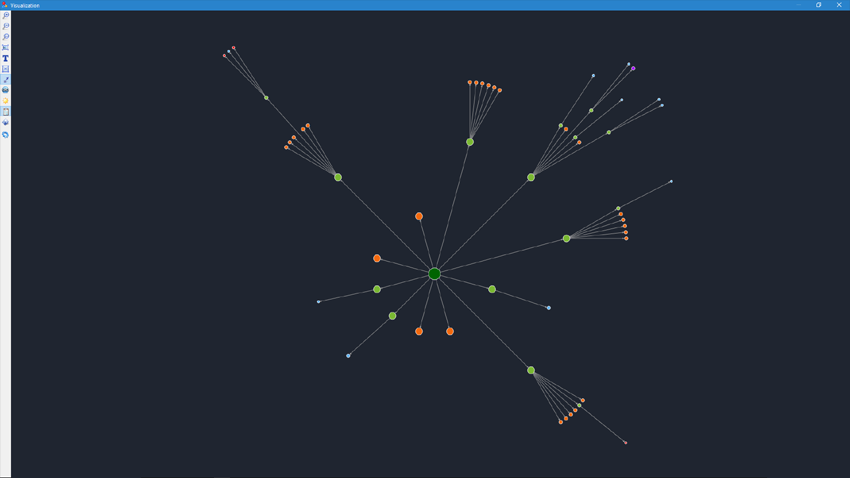

- Visualización de la estructura del sitio web

- Gráfico de distribución de enlaces internos

- Gráfico de velocidad de carga de la página

- La Generación De Sitemap.xml

- Análisis arbitrarias URL

- Dashboard

- Exportación de datos

- Multilanguage

- Compresión de base de datos

Inicio

Cuando ejecuta el programa de usuario está disponible la barra de direcciones para introducir la URL de la que se analizará el sitio (puede entrar en cualquier página de su sitio web, así como la búsqueda del robot, después de pasar a través de enlaces de la página de origen superará todo el sitio web, incluyendo la página principal, con la condición de que todas las referencias a cabo en el HTML y no se utilizan Javascript).

Después de hacer clic en el botón "Inicio", el robot comienza a rastrear todas las páginas de un sitio de enlaces internos (recursos externos él no entra, no entra en los enlaces, realizada en Javascript).

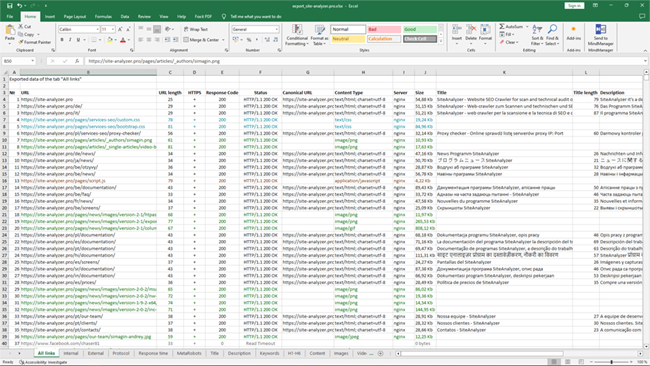

Después de que el robot se daban todas las páginas del sitio está disponible el informe, realizado en forma de tabla y muestra los datos obtenidos, agrupados por temáticas de las fichas.

Todos los proyectos analizados se muestran en la parte izquierda del programa y se guardan automáticamente en la base del programa, junto con la información obtenida. Para eliminar sitios utilice el menú contextual de la lista de proyectos.

Nota:

- al hacer clic en el botón de "Pausa" análisis del proyecto se suspende, paralela a la actual de progreso del escaneo se guarda en la base, lo que permite, por ejemplo, cerrar el programa y continuar con la exploración del proyecto después de reiniciar el programa con el lugar de la parada

- el botón de "Stop" interrumpe el proceso de análisis del proyecto actual, sin la posibilidad de continuar con su análisis

La configuración del programa

La sección del menú principal "Configuración" está diseñado para ajustes sutiles de trabajo del programa con sitios externos y contiene 7 fichas:

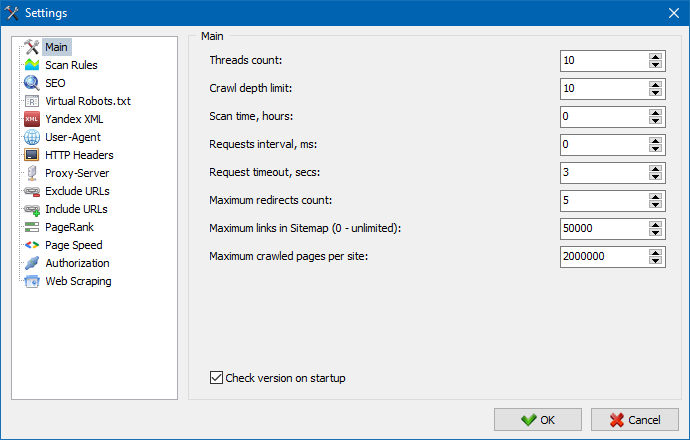

La sección de los ajustes principales, sirve para indicar al usuario de las directivas utilizadas cuando se escanea el sitio.

Descripción de los parámetros:

- El número de subprocesos

- Cuanto mayor sea el número de subprocesos, más de la URL puede procesar por unidad de tiempo. En este caso hay que tener en cuenta que un mayor número de flujos conduce a un mayor número de los recursos de la pc. Se recomienda establecer el número de subprocesos en el rango de 5-10.

- El tiempo de análisis

- Sirve para establecer el límite de escaneo del sitio en el tiempo. Se mide en horas.

- Profundidad máxima de

- Esta opción sirve para indicar la profundidad del sitio. La página principal del sitio tiene un nivel de anidamiento = 0. Por ejemplo, si desea escanear las páginas del sitio de la especie "somedomain.ru/catalog.html" y la "somedomain.ru/catalog/tovar.html" en este caso es necesario ajustar el valor de la profundidad máxima = 2.

- El retraso de entre las solicitudes

- Sirve para la instalación de una pausa cuando se hace referencia escáner a otras páginas del sitio. Esto puede ser necesario para los sitios "débiles" alojamiento gratuito, no puedan soportar grandes cargas y frecuentes a ellos trips.

- El tiempo de espera de la consulta

- Ajuste del tiempo de espera de la respuesta de sitio en la solicitud del programa. Si cualquiera de las páginas del sitio responden lentamente (mucho tiempo de carga), el escaneo de un sitio puede tardar bastante tiempo. Estas páginas se pueden recortar, indicando el valor, después de que el escáner pasará a escanear con el resto de las páginas del sitio y por lo tanto no detendrá el progreso general.

- El número de escaneados de las páginas del sitio

- La limitación en el número máximo de escaneado de páginas. Es útil si, por ejemplo, es necesario analizar las N primeras páginas del sitio (esto no se aplica a imágenes, archivos de estilos, scripts y otros tipos de archivos).

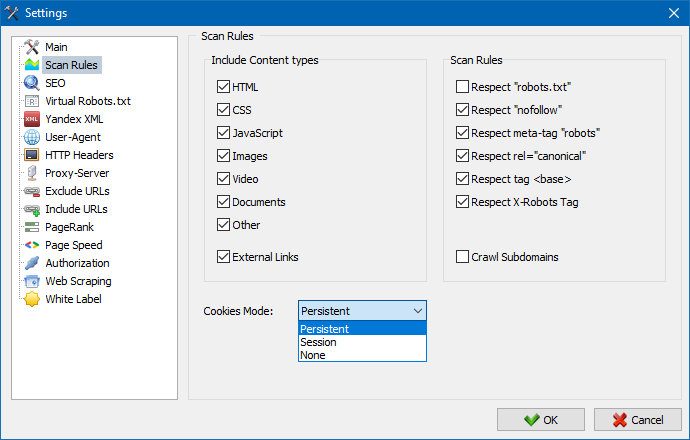

Tener en cuenta el contenido

- En esta sección, puede seleccionar los tipos de datos que se tendrán en cuenta парсером al rastrear las páginas (imágenes, vídeos, estilos, scripts), o bien excluir el exceso de información, al análisis.

Las reglas de análisis

- Los datos de configuración relacionadas con la configuración de excepciones cuando se rastrea el sitio escáner mediante un archivo "robots.txt" por el tipo de enlaces "nofollow", así como a través de la directiva "meta name= "robots "" directamente en el código fuente de las páginas del sitio.

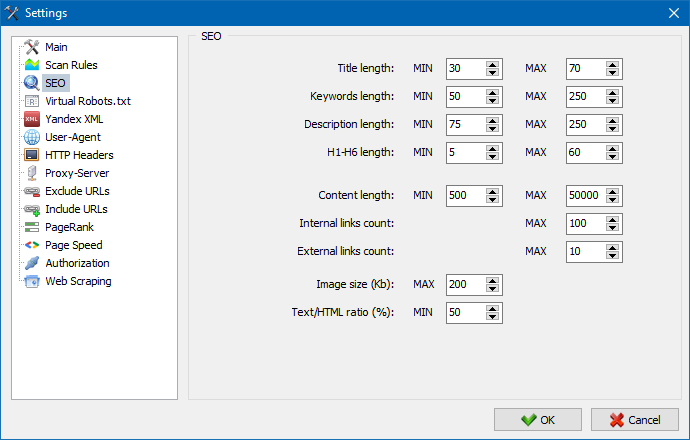

Esta sección sirve de instrucciones de los principales analizados los parámetros de SEO -, que en adelante se comprobará la corrección al análisis de páginas, después de lo cual obtenida de las estadísticas se muestra en la pestaña "Estadísticas de SEO en la parte derecha de la ventana principal del programa.

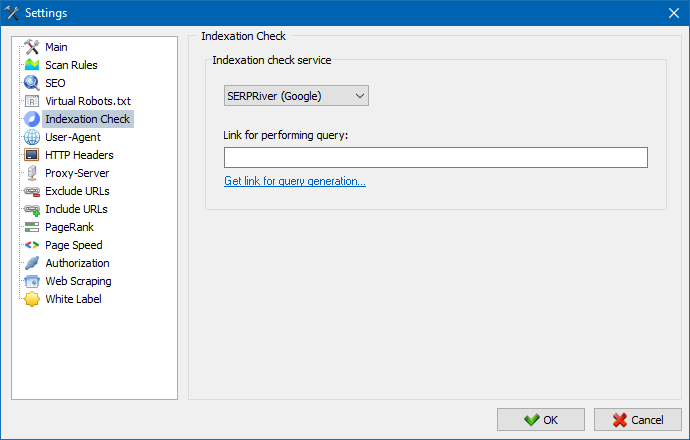

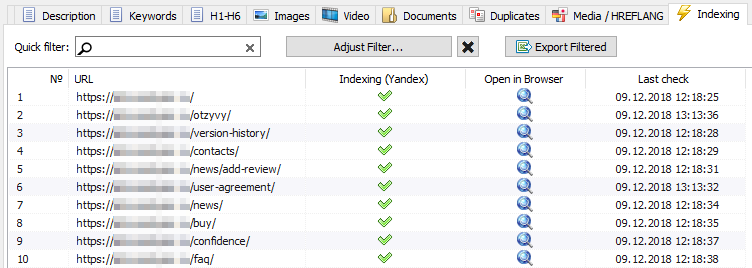

Con la ayuda de estos ajustes, puede elegir un servicio a través del cual comprobará la indexación de las páginas en el motor de búsqueda Yandex. Hay dos opciones para verificar la indexación: usar el servicio XML de Yandex o el servicio Majento.ru.

Al elegir el servicio XML de Yandex, debe tener en cuenta las posibles restricciones (por hora o diarias), que se pueden aplicar al verificar la indexación de las páginas, con respecto a los límites existentes en su cuenta de Yandex, como resultado de los cuales a menudo puede haber situaciones en las que los límites de su cuenta no son suficientes para verificar Páginas a la vez y para esto hay que esperar la siguiente hora.

Cuando se usa el servicio Majento.ru, prácticamente no existen restricciones por hora o por día, ya que su límite se fusiona literalmente con el conjunto general de límites, que no es pequeño en sí mismo, sino que también tiene un límite significativamente mayor con restricciones por hora que cualquiera de las cuentas de usuario individuales en Yandex XML.

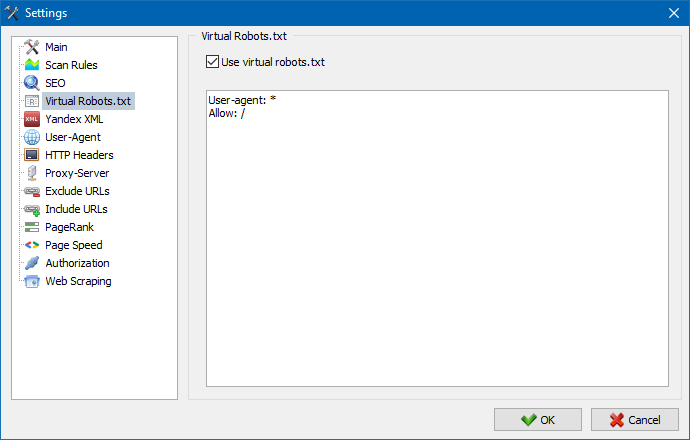

Se puede utilizar un archivo robots.txt virtual en lugar del archivo robots.txt real alojado en el sitio.

Esto es útil cuando se prueba un sitio, cuando, por ejemplo, necesita rastrear ciertas secciones del sitio que están cerradas de la indexación (o viceversa, no las tenga en cuenta al rastrear), mientras que no necesita hacer físicamente cambios en el archivo robots.txt real y dedicar el tiempo del desarrollador a esto.

Nota: al importar una lista de URL, se tienen en cuenta las directivas del robots.txt virtual (si esta opción está activada), de lo contrario no se tiene en cuenta ningún robots.txt para la lista de URL.

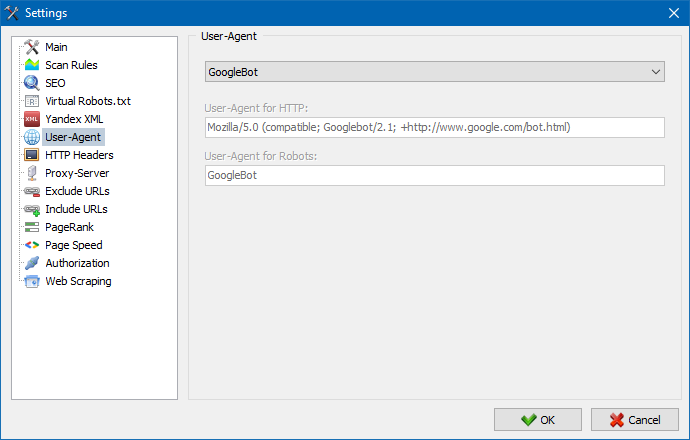

En la sección User-Agent, puede especificar qué usuario-agente, se presentará el programa cuando se accede a sitios externos en el momento de su análisis. Por predeterminados, instalado de usuario usuario-agente, sin embargo, si es necesario, puede elegir uno de los agentes más comunes en internet. Algunos de ellos, como: los bots de los motores de búsqueda YandexBot, GoogleBot, MicrosoftEdge, los bots de google Chrome, Firefox, IE8, así como de los dispositivos móviles iPhone, Android y muchos otros.

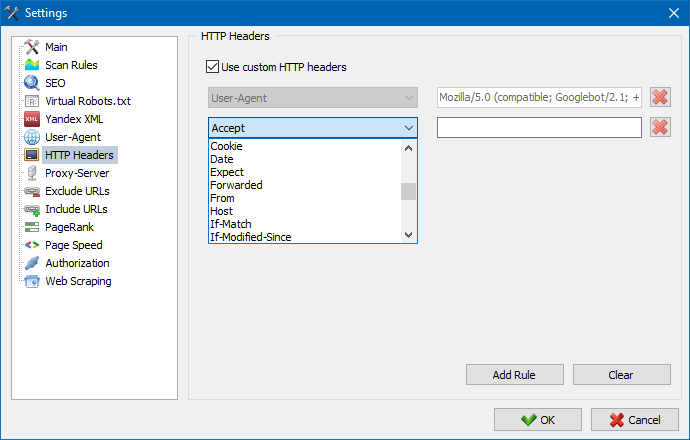

Con esta opción, puede analizar la reacción del sitio y las páginas a diferentes solicitudes. Por ejemplo, alguien puede necesitar enviar un Referer en una solicitud, los propietarios de sitios multilingües quieren transmitir Accept-Language | Charset | Encoding, y alguien necesita transmitir datos inusuales en los encabezados Accept-Encoding, Cache-Control, Pragma , etc. NS.

Con esta opción, puede analizar la reacción del sitio y las páginas a diferentes solicitudes. Por ejemplo, alguien puede necesitar enviar un Referer en una solicitud, los propietarios de sitios multilingües quieren transmitir Accept-Language | Charset | Encoding, y alguien necesita transmitir datos inusuales en los encabezados Accept-Encoding, Cache-Control, Pragma , etc. NS.

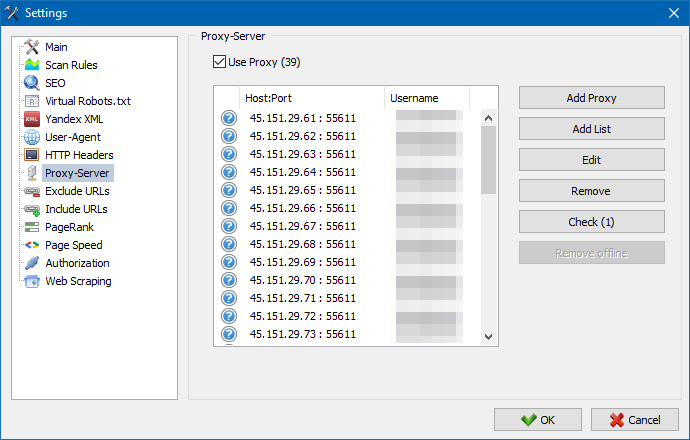

Si hay la necesidad de trabajar a través de un proxy, en esta sección, usted puede agregar una lista de servidores proxy, a través de la que el programa tendrá acceso a los recursos externos. Además, existe la posibilidad de revisar el proxy de la capacidad de trabajo, así como la función de eliminación de inactivos de servidores proxy.

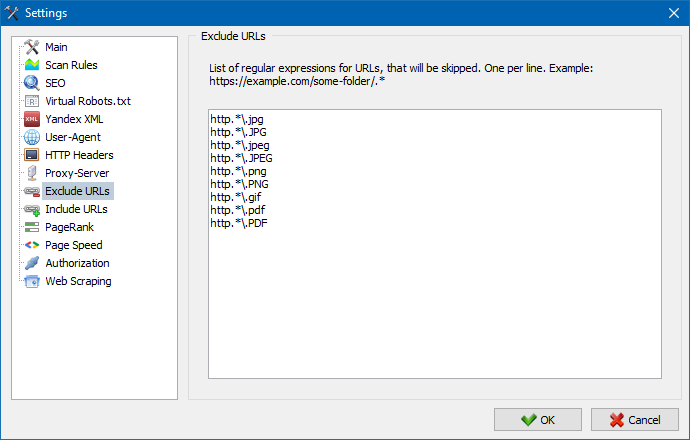

Esta sección está destinada a excepción de rastreo de ciertas páginas y secciones de la web al análisis.

Usando los patrones de búsqueda * y ? puede especificar qué secciones del sitio no deben rastrearse por el rastreador y, en consecuencia, no deben incluirse en la base de datos del programa. Esta lista es una lista local de excepciones en tiempo de análisis de la web (con respecto a ella "mundial" de la lista es el archivo "robots.txt" en la raíz del sitio).

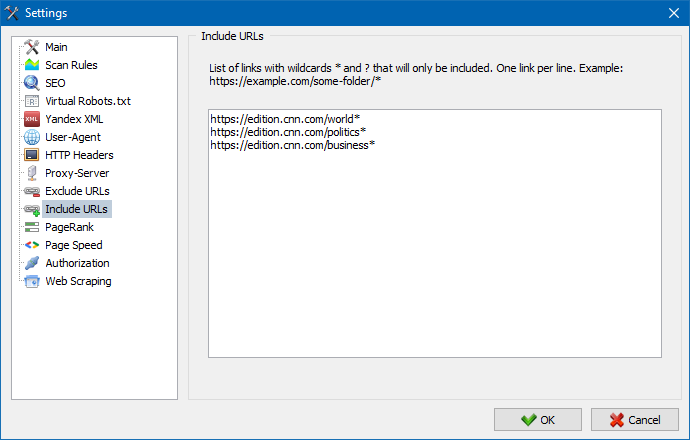

Del mismo modo, le permite agregar URL que deben rastrearse. En este caso, todas las otras URL fuera de estas carpetas serán ignoradas durante el escaneo. Esta opción también funciona con patrones de búsqueda * y ?

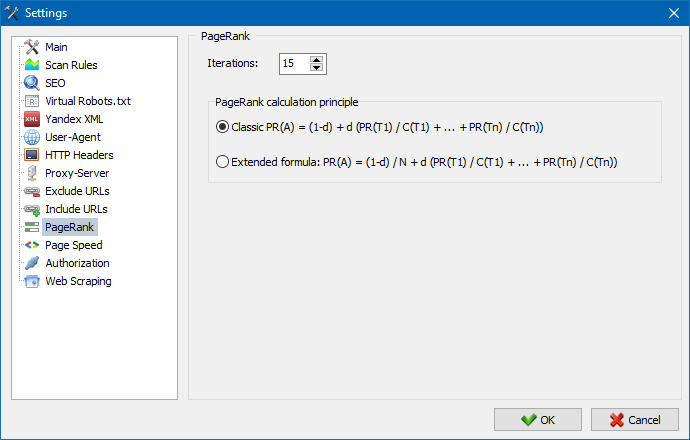

Usando el parámetro PageRank, puede analizar la estructura de navegación de sus sitios, así como optimizar el sistema de enlaces internos de un recurso web para transmitir el peso de referencia a las páginas más importantes.

El programa tiene dos opciones para calcular el PageRank: el algoritmo clásico y su contraparte más moderna. En general, para el análisis de la vinculación interna del sitio, no hay mucha diferencia cuando se usan los algoritmos primero o segundo, por lo que puede usar cualquiera de los dos algoritmos.

Una descripción detallada del algoritmo y los principios de cálculo del PageRank se pueden encontrar en el artículo "Cálculo del PageRank interno": >>

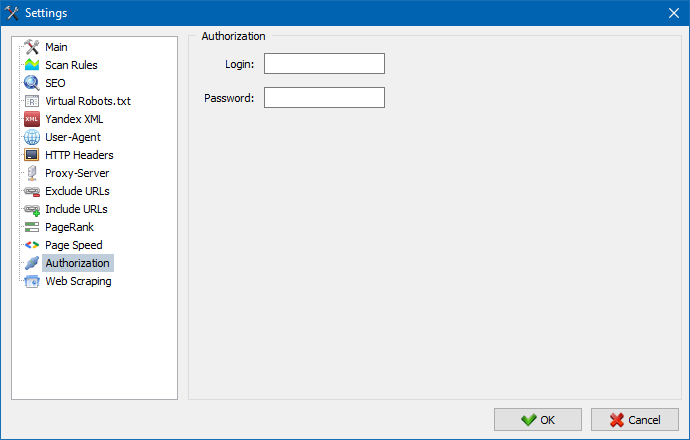

Ingrese el nombre de usuario y la contraseña para la autorización automática en las páginas cerradas a través de .htpasswd y protegidas por la autorización del servidor BASIC.

El trabajo con el programa

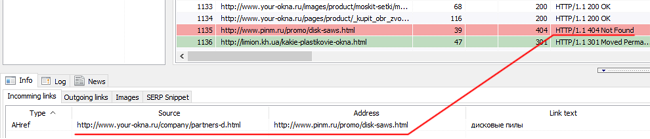

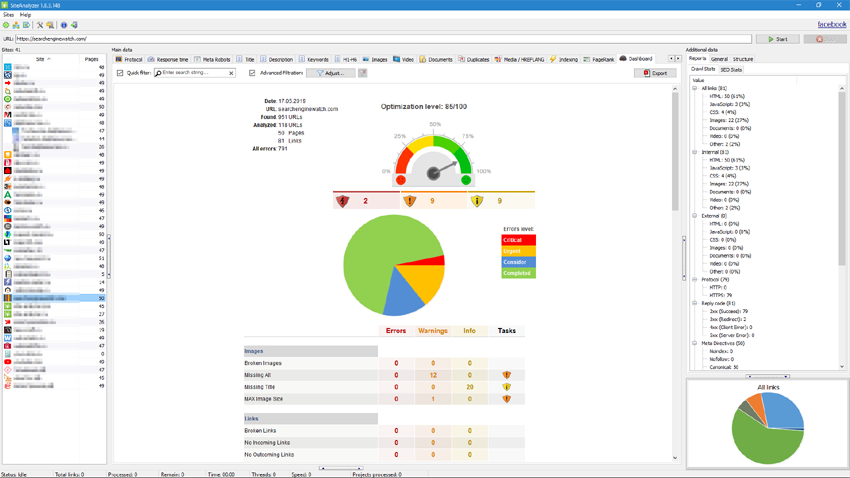

Al finalizar el escaneo, el usuario estará disponible la información publicada en el bloque "datos Básicos". Cada ficha contiene los datos agrupados sobre sus nombres (por ejemplo, la pestaña "Title" contiene el contenido del encabezado de la página <title></title> pestaña "Imagen" contiene una lista de todas las imágenes del sitio y así sucesivamente). Con estos datos se puede realizar el análisis de contenido de sitio, encontrar el "rescate" de los enlaces o incorrectamente lleno de meta-etiquetas.

Si es necesario (por ejemplo, después de realizar cambios en el sitio web mediante el menú contextual existe la posibilidad de un nuevo análisis de las URL para mostrar los cambios en el programa.

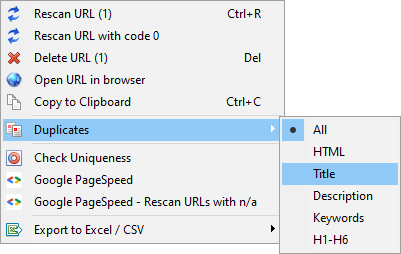

Con este menú se puede mostrar duplicados de las páginas de los respectivos parámetros (tomas title, description, keywords, h1, h2, el contenido de las páginas).

El elemento "Volver a analizar URL con código 0" está diseñado para verificar automáticamente todas las páginas que dan un código de respuesta 0 (Tiempo de espera de lectura). Este código de respuesta generalmente se proporciona cuando el servidor no tiene tiempo para entregar el contenido y la conexión se cierra por tiempo de espera, respectivamente, la página no se puede cargar y no se puede extraer información de ella.

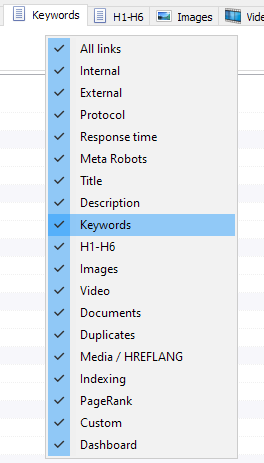

Personalización de las columnas y pestañas

Ahora puede seleccionar las fichas que se mostrará en la interfaz de datos maestros (finalmente, es posible decir adiós a la moral obsoleta de la ficha de la Meta Keywords). Esto es útil si taba no caben en la pantalla, usted rara vez los usa.

Las columnas también puede ocultar o mover a la posición deseada mediante arrastrar y soltar.

Visualización de tabs y columnas se puede configurar mediante el menú contextual de la barra de datos básicos. La migración de las columnas se realiza a través del mouse.

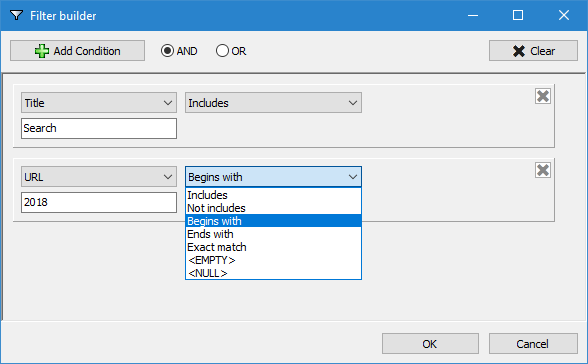

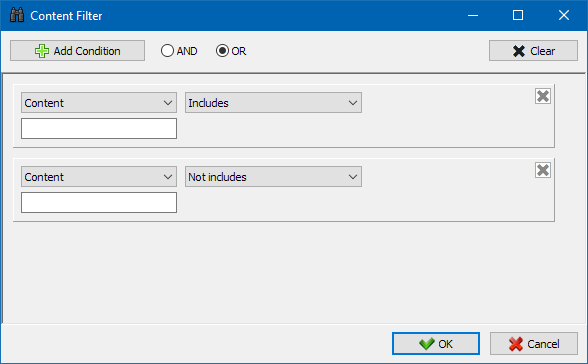

Para facilitar el análisis de las estadísticas del sitio, el programa proporciona filtrado de datos. La filtración es posible en dos versiones:

- en cualquiera de los campos con la ayuda de la "rápida" filtro

- con el uso de un filtro personalizado (con la ayuda de las opciones de configuración avanzadas de la muestra de datos)

Filtro rápido

Se utiliza para la filtración rápida de datos y se aplica a todos los campos de la ficha actual.

Un filtro personalizado

Está diseñado para más de filtración y puede contener simultáneamente varias condiciones. Por ejemplo, para la meta-etiqueta "title" usted camina filtrar las páginas de su longitud, de manera que no exceda de 70 caracteres y, al mismo tiempo contenía el texto de "noticias". Entonces este filtro se verá así:

Por lo tanto, la aplicación de un filtro personalizado a cualquiera de las fichas, usted puede recibir una muestra de datos de cualquier complejidad.

Estadisticas tecnicas del sitio

La pestaña de estadísticas técnicas del sitio se encuentra en el panel de Datos adicionales y contiene un conjunto de parámetros técnicos básicos del sitio: estadísticas de enlaces, etiquetas meta, códigos de respuesta de página, parámetros de indexación de página, tipos de contenido, etc. parámetros

Al hacer clic en uno de los parámetros, se filtran automáticamente en la pestaña correspondiente de los datos maestros del sitio y, al mismo tiempo, las estadísticas se muestran en el diagrama en la parte inferior de la página.

La pestaña de estadísticas de SEO está destinada a realizar auditorías de sitio completas y contiene más de 50 parámetros principales de SEO e identifica más de 60 errores de optimización internos clave. La asignación de errores se divide en grupos, que, a su vez, contienen conjuntos de parámetros analizados y filtros que detectan errores en el sitio.

Una descripción detallada de todos los parámetros verificados se encuentra en este artículo. >>

Para todos los resultados de filtrado, es posible exportarlos rápidamente a Excel sin diálogos adicionales (el informe se guarda en la carpeta del programa).

En esta pestaña se colocan filtros predefinidos que permiten crear de una muestra de todos los enlaces externos, errores 404, imágenes y otros parámetros con todas las páginas en las que están presentes. Por lo tanto, ahora usted puede rápida y fácilmente obtener una lista de los enlaces externos y las páginas en las que se alojan, o seleccionar todos los enlaces rotos y ver de inmediato, en las páginas que se encuentran.

Todos los informes están disponibles en el programa en el modo en línea y se muestran en la pestaña "Custom" en el panel de datos básicos. Además, existe la posibilidad de exportar a Excel, a través del menú principal.

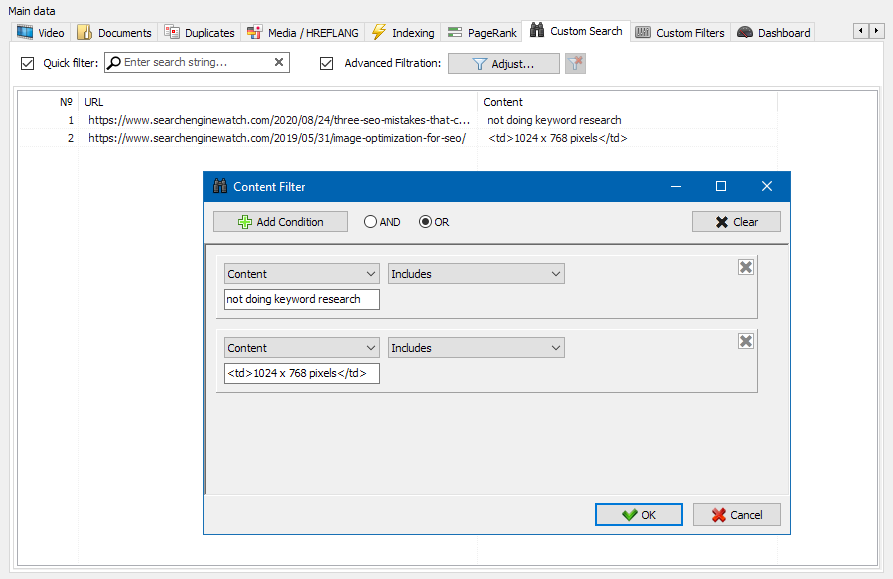

La función de búsqueda de contenido del sitio le permite buscar a través del código fuente y mostrar páginas web que contienen el contenido que está buscando.

El módulo de filtros personalizados le permite verificar la presencia de micro-marcado, meta-etiquetas, sistemas de análisis, fragmentos de texto libre o código HTML en el sitio.

En la ventana de configuración del filtro hay varios parámetros para buscar ciertos fragmentos de texto en las páginas del sitio o, a la inversa, para excluir páginas que contienen cierto texto o fragmentos de código HTML de los resultados de búsqueda (esta función es similar a buscar contenido en el código fuente de una página usando Ctrl-F) ...

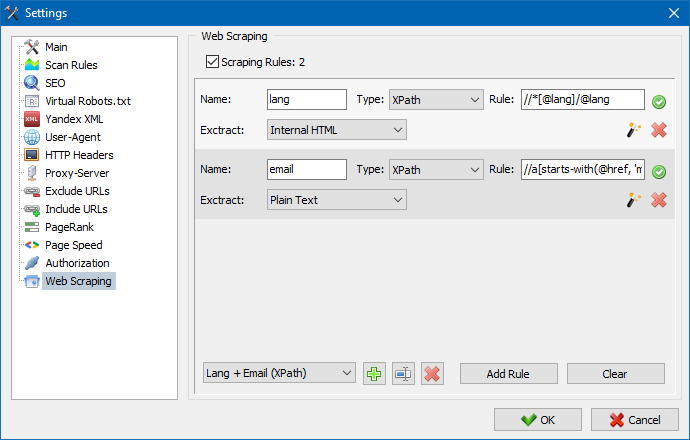

Por lo general, el raspado se usa para resolver tareas que son difíciles de manejar manualmente. Esto puede ser extraer descripciones de productos para crear una nueva tienda en línea, realizar investigaciones de mercado para monitorear precios o monitorear anuncios.

En SiteAnalyzer, el raspado se configura en la pestaña Extracción de datos, donde se configuran las reglas de extracción. Las reglas se pueden guardar y, si es necesario, editar.

También hay un módulo de prueba de reglas. Con el depurador de reglas incorporado, puede obtener rápida y fácilmente el contenido HTML de cualquier página del sitio y probar el trabajo de las consultas, y luego usar las reglas depuradas para analizar datos en SiteAnalyzer.

Una vez finalizada la extracción de datos, toda la información recopilada se puede exportar a Excel.

Para un estudio más detallado del funcionamiento del módulo y una lista de las reglas y expresiones regulares más comunes, consulte el artículo

Comprobación de la unicidad del contenido

Esta herramienta le permite buscar páginas duplicadas y verificar la singularidad de los textos dentro del sitio. En otras palabras, se trata de una verificación por lotes de un grupo de URL para determinar la unicidad entre ellas.

Esto puede resultar útil en los siguientes casos:

- Para buscar páginas completas duplicadas (por ejemplo, una página con parámetros y la misma página, pero en la vista CNC).

- Para buscar coincidencias de contenido parcial (por ejemplo, dos recetas de borscht en un blog culinario, que son 96% similares entre sí, lo que sugiere que uno de los artículos debe eliminarse para deshacerse de una posible canibalización del tráfico).

- Cuando en un sitio de artículos, accidentalmente escribiste un artículo sobre un tema que ya escribiste hace 10 años. En este caso, nuestra herramienta también detectará un duplicado de dicho artículo.

El principio de la herramienta para verificar la unicidad del contenido es simple: el programa descarga su contenido de la lista de URL del sitio web, recibe el contenido de texto de la página (sin el bloque HEAD y sin etiquetas HTML) y luego los compara con cada otros utilizando el algoritmo de tejas.

Por lo tanto, mediante el uso de tejas, determinamos la singularidad de las páginas y podemos calcular tanto los duplicados completos de páginas con un 0% de singularidad como los duplicados parciales con varios grados de singularidad del contenido del texto. El programa funciona con una longitud de teja de 5.

Puede obtener más información sobre cómo funciona el módulo en este artículo.: >>

Comprobación de la velocidad de carga de la página

La herramienta PageSpeed Insights del gigante de las búsquedas de Google le permite verificar la velocidad de carga de ciertos elementos de la página y también muestra el puntaje general de velocidad de carga de las URL de interés para las versiones de escritorio y móviles del navegador.

La herramienta de Google es buena para todos, sin embargo, tiene un inconveniente significativo: no le permite crear verificaciones grupales de URL, lo que crea inconvenientes al verificar muchas páginas de su sitio: acuerde que verificar manualmente la velocidad de descarga para 100 o más URL en una página es una tarea ardua y puede llevar mucho tiempo.

Por lo tanto, hemos creado un módulo que le permite crear verificaciones grupales de la velocidad de carga de la página de forma gratuita a través de una API especial en la herramienta Google PageSpeed Insights.

Principales parámetros analizados:

- FCP (First Contentful Paint) – tiempo para mostrar el primer contenido.

- SI (Speed Index) – un indicador de la rapidez con que se muestra el contenido en una página.

- LCP (Largest Contentful Paint) – tiempo de visualización del elemento más grande de la página.

- TTI (Time to Interactive) – el tiempo durante el cual la página está completamente lista para la interacción del usuario.

- TBT (Total Blocking Time) – tiempo desde la primera reproducción del contenido hasta su preparación para la interacción del usuario.

- CLS (Cumulative Layout Shift) – cambio de diseño acumulativo. Sirve para medir la estabilidad visual de la página.

Al mismo tiempo, el análisis de la propia URL se lleva a cabo con solo un par de clics, después de lo cual se puede descargar un informe, que incluye las principales características de los cheques en un formato conveniente en Excel.

Todo lo que necesita para comenzar es obtener una clave API.

En este artículo se describe cómo hacer esto. >>

Esta funcionalidad está diseñado para crear la estructura del sitio en base a los datos recibidos. La estructura del sitio se genera a partir de anidación de la URL de su página web. Después de la generación de la estructura está disponible para su exportación en formato CSV (Excel).

El menú contextual de la lista de proyectos

- En la lista de proyectos está disponible en masa de análisis mediante la asignación de los sitios web y pulsar el botón "volver a explorar". Después de que todos los sitios se convierten en la cola y se escanean de forma alterna en el modo estándar.

- También, para facilitar el trabajo con el programa, la eliminación masiva de los sitios elegidos también está disponible en el botón "Eliminar".

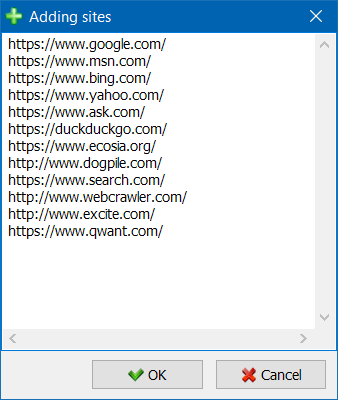

- Además de un análisis de los sitios, existe la posibilidad de agregar sitios en la lista de proyectos con una forma especial, después de lo cual, el usuario puede analizar el interés de los proyectos en su totalidad.

- Para una navegación más conveniente a través de la lista de proyectos, es posible agrupar sitios por carpetas, así como filtrar la lista de proyectos por nombre.

Visualización de la estructura del sitio web

El modo de visualización de los vínculos de referencia en el gráfico le ayudará a SEO profesional de evaluar la distribución interna el PageRank de las páginas del sitio web, así como entender las páginas que reciben la mayor referencial de la masa (y por lo tanto, más interno de referencia de peso en los ojos de los motores de búsqueda), y qué páginas y secciones de la web carece de enlaces internos.

Con el modo de visualización de la estructura del sitio SEO especialista puede ver fácilmente cómo es, cómo está organizada la vinculación interna en el sitio web, así como a través de la presentación visual de la masa de PageRank, asignada a una u otra de las páginas, para realizar ajustes en la actual vinculación sitio web y así mejorar la relevancia de interés de páginas.

En la parte izquierda de la ventana de visualización se encuentran las herramientas básicas para el trabajo con el conde:

- el cambio de escala en el gráfico

- la rotación de la columna en cualquier ángulo de la

- el cambio de la ventana del gráfico en el modo de pantalla completa (también funciona en la tecla F11)

- mostrar / ocultar descripciones de los sitios (Ctrl-T)

- mostrar / ocultar las flechas de las líneas de la

- mostrar / ocultar referencias a recursos externos (Ctrl-E)

- cambio del modo de esquema de color Día / Noche (Ctrl-D)

- mostrar u ocultar la leyenda y de las estadísticas del conde (Ctrl-L)

- guardar el gráfico en formato PNG (Ctrl-S)

- la ventana de configuración de la visualización (Ctrl-O)

La sección "Apariencia" está diseñado para cambiar el formato de visualización de los nodos en el grafo. En el modo de dibujo de nodos "PageRank", las dimensiones de los nodos se establecen en relación con los anteriormente calculado indicador de PageRank, lo que en el gráfico se puede ver las páginas que reciben más de referencia de peso y cómo perciben menos de enlaces.

En el modo clásico, el tamaño de los nodos se establecen en relación con el nivel de zoom elegido conde de la representación.

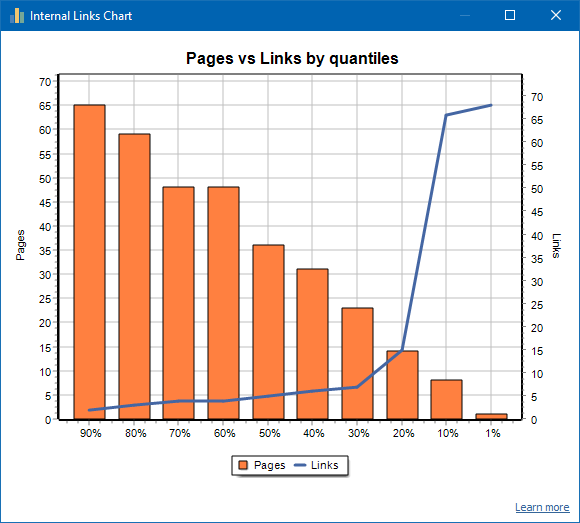

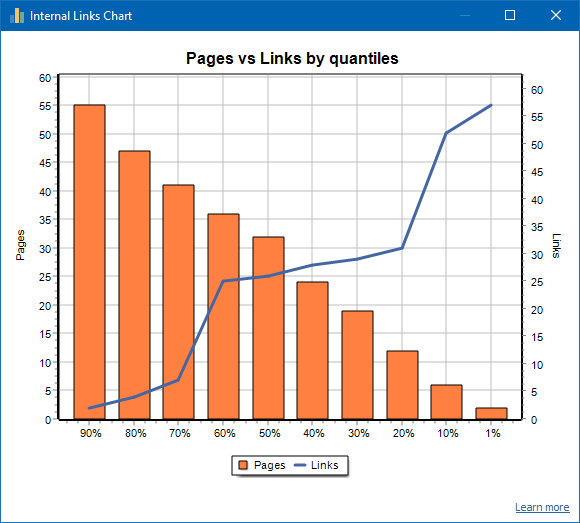

Gráfico de distribución de enlaces internos

Este gráfico muestra la distribución de la masa de enlaces internos en las páginas del sitio (podemos decir que esta es una visualización del enlace en forma visual, en lugar de presentarse en el Gráfico de visualización). Leer más >>

A la izquierda está el número de páginas, a la derecha está el número de enlaces. A continuación se muestran los cuantiles porcentuales por página. Al elaborar un gráfico, se descartan los enlaces duplicados (si hay 3 enlaces de la página A a la página B, los contamos como uno).

Por ejemplo, según la captura de pantalla anterior, para un sitio de aproximadamente 70 páginas:

- 1% las páginas tienen ~68 enlaces entrantes.

- 10% las páginas tienen ~66 enlaces entrantes.

- 20% las páginas tienen ~15 enlaces entrantes.

- 30% las páginas tienen ~8 enlaces entrantes.

- 40% las páginas tienen ~7 enlaces entrantes.

- 50% las páginas tienen ~6 enlaces entrantes.

- 60% las páginas tienen ~5 enlaces entrantes.

- 70% las páginas tienen ~5 enlaces entrantes.

- 80% las páginas tienen ~3 enlaces entrantes.

- 90% las páginas tienen ~2 enlaces entrantes.

Es decir, si vemos que tenemos páginas a las que conducen menos de 10 enlaces entrantes, entonces podemos considerar que dichas páginas están enlazadas débilmente, y tenemos el 60% de las páginas normalmente enlazadas. En base a esto, podemos poner más enlaces internos a estas páginas con enlaces débiles (si las páginas son importantes para la promoción), o dejarlo como está, si dichas páginas son de poca importancia y poca prioridad.

En la práctica general, es menos probable que los robots de los motores de búsqueda, en particular los de Google, rastreen las páginas con menos de 10 enlaces internos.

Por lo tanto, si ve un sitio que tiene solo entre el 20 y el 30% de las páginas normalmente vinculadas del número total de páginas del sitio, entonces tiene sentido profundizar en la configuración de vínculos o pensar en cómo lidiar con este 80-70% de páginas débilmente vinculadas (eliminar, ocultar de indexación, poner redireccionamientos).

Un ejemplo de un sitio débilmente vinculado:

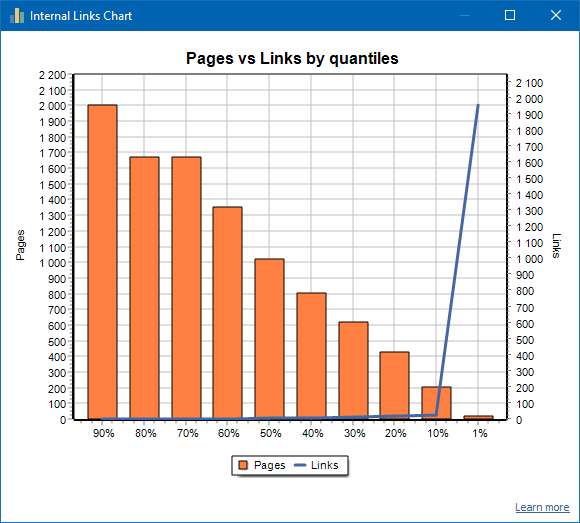

Un ejemplo de un sitio bien vinculado:

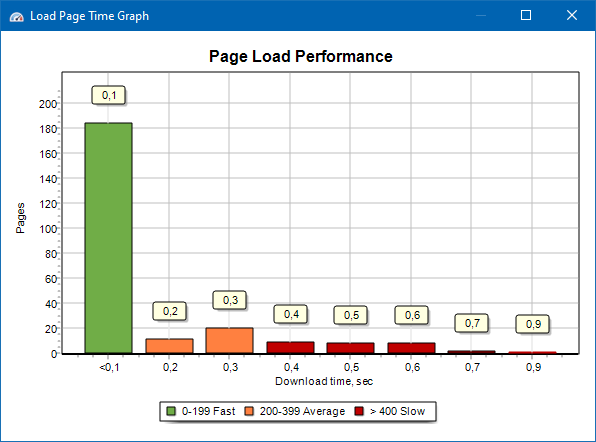

Gráfico de velocidad de carga de la página

El gráfico de velocidad de carga de la página le permite evaluar el rendimiento del sitio. Para mayor claridad, las páginas se dividen en grupos e intervalos de tiempo con un paso de 100 milisegundos.

Por lo tanto, en función del gráfico, puede determinar qué proporción de páginas del sitio se cargan rápidamente (dentro de 0-100 milisegundos), cuál a una velocidad promedio (100-200 milisegundos) y qué páginas se cargan el tiempo suficiente (400 milisegundos o más).

Nota: El tiempo que se muestra es el tiempo para cargar el código fuente HTML, no el tiempo para cargar completamente las páginas (la representación de la página, así como la carga de elementos de la página, como imágenes y estilos, no se tienen en cuenta).

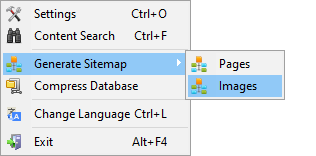

La Generación De Sitemap.xml

El mapa del sitio se genera en función de las páginas rastreadas o las imágenes del sitio.

- Al generar un mapa del sitio que consta de páginas, se le agregan páginas con el formato "texto / html".

- Al generar un mapa del sitio que consta de imágenes, se le agregan JPG, PNG, GIF e imágenes similares.

Generar el mapa del sitio puede ser inmediatamente después de la exploración del sitio, en el menú principal la opción "Proyectos -> Generar el Sitemap".

Para los sitios de grandes volúmenes de 50 000 páginas, tiene la función de dividir automáticamente "sitemap.xml" en varios archivos (en este caso, el archivo contiene vínculos a otras, contienen directamente los enlaces a páginas del sitio web. Esto se debe a las exigencias de los motores de búsqueda para el procesamiento de archivos de sitemap de grandes dimensiones.

Si es necesario, la cantidad de páginas en el archivo "sitemap.xml" se puede variar cambiando el valor de 50 000 (valor por defecto) el valor que desee en la configuración básica de un programa.

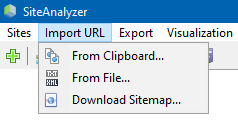

Análisis arbitrarias URL

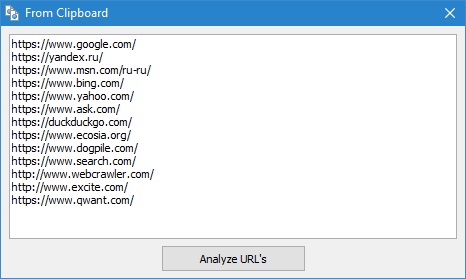

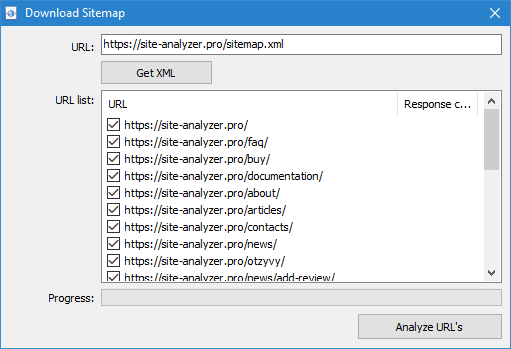

La opción de menú "Importar URL" está diseñado para escanear arbitrarias de las listas de URL, así como de mapas XML del sitio Sitemap.xml (incluyendo el índice) para su posterior análisis.

Análisis arbitrarias URL posible de tres maneras:

- mediante la inserción de una lista de URL desde el portapapeles

- el arranque de la unidad de disco duro de archivos en formato *.txt y *.xml que contienen las listas de URL

- mediante la descarga de un archivo Sitemap.xml directamente desde el sitio web

La característica de este modo es que al escanear arbitrarias URL mismo "proyecto" no se guarda en el programa y los datos en él no se agrega a la base. No están disponibles las secciones de la Estructura del sitio" y "Dashboard".

Para más información sobre la labor de la opción "Importar" URL de este artículo: Introducción a la nueva versión SiteAnalyzer 1.9.

Dashboard

Ficha "Dashboard", muestra un informe detallado sobre la calidad actual de la optimización de un sitio. El informe se genera en la base de datos en la ficha de Estadísticas de la SEO". Además de estos datos en el informe aparece la indicación de nivel de calidad general de la optimización del sitio, calculado por 100-la escala de puntos relativos a la medida de su optimización. Existe la posibilidad de exportar datos en la ficha "Dashboard" en un informe en formato PDF.

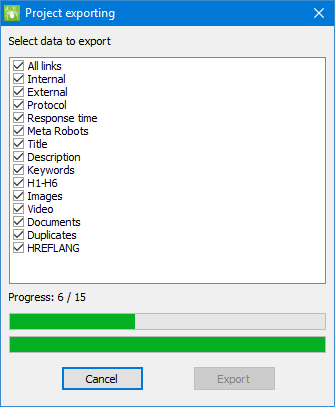

Exportación de datos

Para mayor flexibilidad en el análisis de los datos dispone de la posibilidad de su descarga en formato CSV (se exporta actual de la ficha activa), así como la generación de pleno un informe en Microsoft Excel con todas las fichas en un solo archivo.

Al exportar los datos a Excel aparece una ventana especial en la que el usuario puede seleccionar las columnas y, a continuación, generar un informe con los datos necesarios.

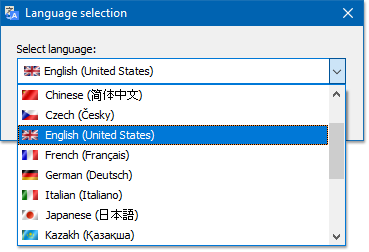

Multi

El programa tiene la posibilidad de elegir el idioma en el que desea trabajar.

Los principales idiomas: ruso, inglés, alemán, italiano, español, francés... En este momento el programa está traducido a más de quince (15) de los más populares lenguajes.

Si quieres traducir el programa en su lengua materna, para ello, basta con traducir cualquier archivo "*.lng" en su idioma, después de lo cual traducido archivo se debe enviar a la dirección "support@site-analyzer.pro" (comentarios a la carta deben ser escritos en ruso o en inglés) y su traducción será incluido en la nueva versión del programa.

Instrucciones más detalladas sobre el programa de traducción de idiomas se encuentra en la distribución (archivo lcids.txt").

P.S. Si usted tiene algún comentario sobre la calidad de la traducción - que envíe sus observaciones y correcciones a "support@site-analyzer.ru".

Compresión de base de datos

La opción del menú principal "Compactar base de datos está diseñada para realizar operaciones de embalaje de la base de datos (limpieza de la base de la anteriormente eliminados de los proyectos, así como la organización de los datos (un análogo de la desfragmentación de los datos en los ordenadores personales)).

Este procedimiento es eficaz cuando, por ejemplo, desde el programa se ha quitado un gran proyecto, que incluye una gran cantidad de registros. En general, se recomienda realizar periódicamente la compresión de datos para la eliminación de datos redundantes y reducir el volumen de la base.

Con las respuestas a otras preguntas pueden consultarse en la sección de preguntas frecuentes >>