La nomination d'un programme

Le programme SiteAnalyzer est conçu pour l'analyse de site et d'identifier les erreurs techniques (recherche de liens brisés, de pages en double, inattendues de réponse du serveur), ainsi que des erreurs et des lacunes dans l'optimisation SEO (des méta-tags, l'excès ou l'absence complète de pages de titre h1, l'analyse du contenu de la page, la qualité de relier et de nombreux autres les paramètres de SEO).

Les caractéristiques principales de

- La numérisation de toutes les pages du site, des images, des scripts et des documents

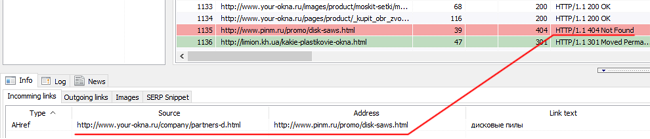

- L'obtention des codes de réponse du serveur pour chaque page du site (200, 301, 302, 404, 500, 503 etc.)

- Détermination de l'existence et du contenu de Title, Keywords, Description, H1-H6

- La recherche et l'affichage des "doublons" de page, les balises meta et les en-têtes

- Définition de l'existence de l'attribut rel="canonical" pour chaque page du site

- Suivant les directives du fichier "robots.txt", de la méta-balise "robots" ou de X-Robots-Tag

- Comptabilité "noindex" et "nofollow" lors de l'exploration des pages du site

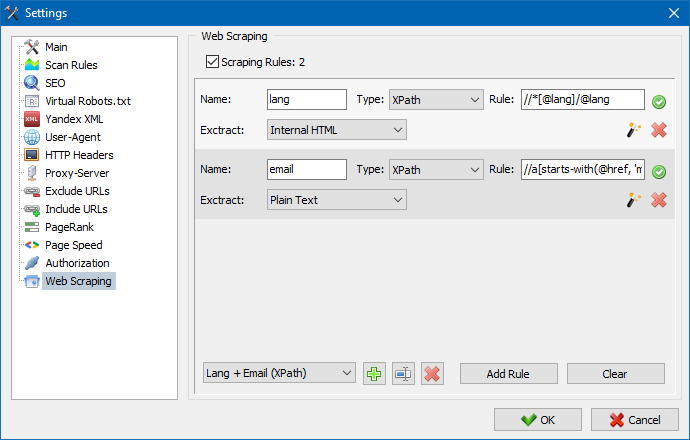

- Grattage de données avec XPath, CSS, XQuery, RegEx

- Vérification de l'unicité du contenu au sein du site

- Vérification de la vitesse de chargement des pages par Google PageSpeed

- Analyse de référence: définition de liens internes et externes pour n'importe quelle page du site

- Calcul du PageRank interne pour chaque page du site

- Visualisation de la structure du site sur le graphique

- Déterminer le nombre de redirections à partir de la page (redirections)

- Analyser les URL arbitraires et le fichier Sitemap.xml externe

- Sitemap "sitemap.xml" génération (avec possibilité de scinder en plusieurs fichiers)

- Filtrage des données par n'importe quel paramètre (configuration flexible de filtres de toute complexité)

- Recherche de contenu arbitraire sur le site

- Les rapports de l'exportation au format CSV, Excel et PDF

Les différences analogues

- Les besoins en ressources de l'ordinateur, la consommation de ram

- Analyse des sites de presque tous les volumes en raison de la baisse des exigences aux ressources de l'ordinateur

- Le format portable (fonctionne sans installation sur le PC ou directement depuis un support amovible)

Les sections de la documentation

- Le début des travaux

- Les paramètres du programme

- Les réglages de base

- Scan

- SEO

- Robots virtuels.txt new

- Yandex XML

- User-Agent

- En-têtes HTTP arbitraires new

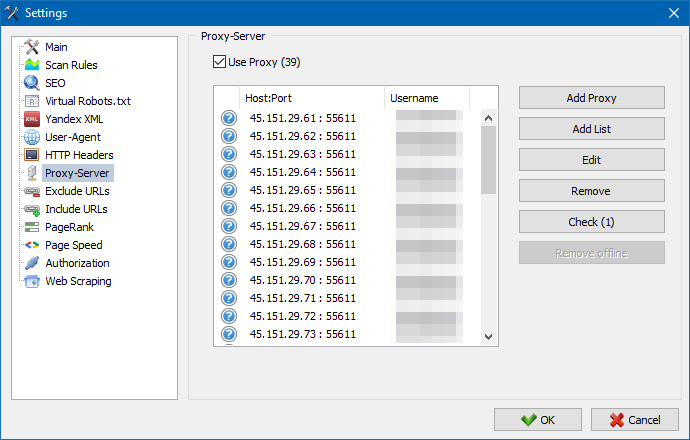

- Un serveur Proxy

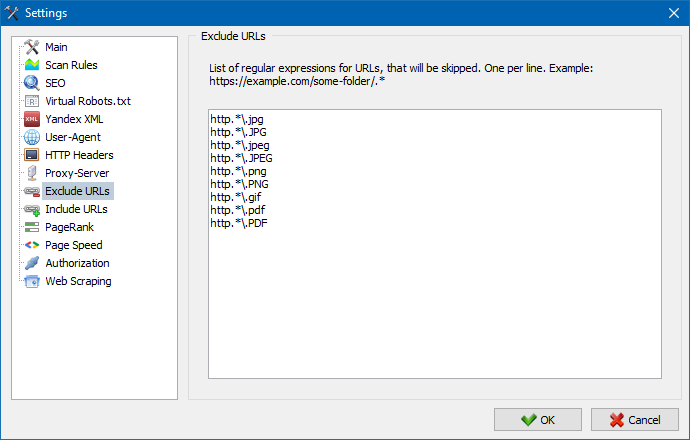

- URL d'exclusion

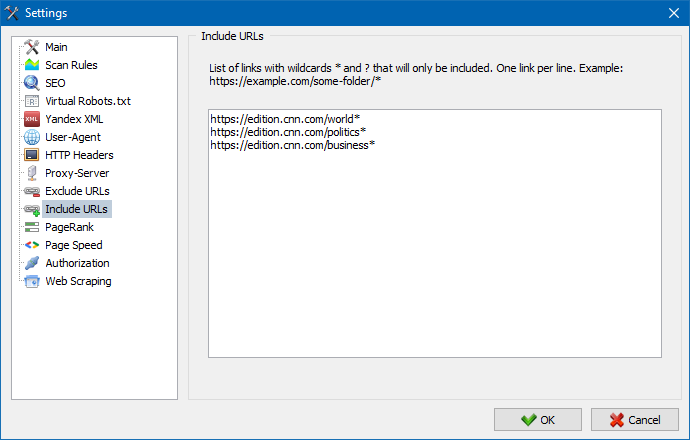

- Suivre l'URL

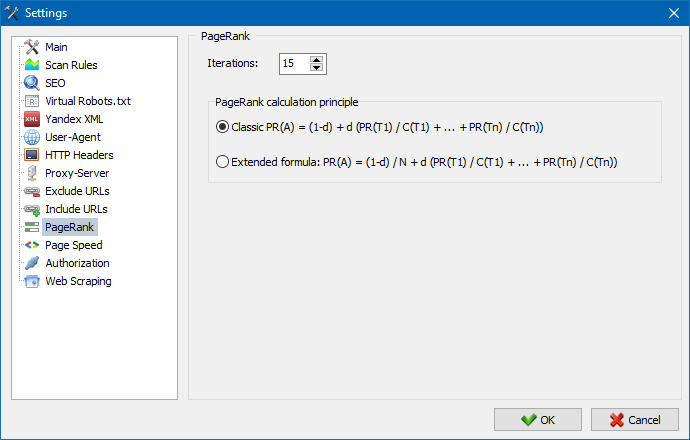

- PageRank

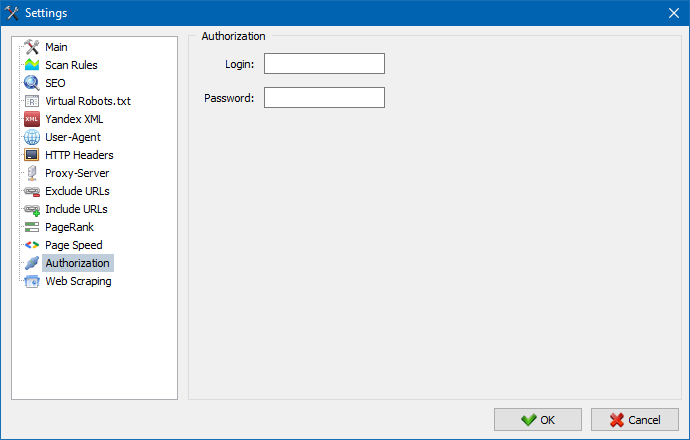

- Autorisation

- Le travail avec le programme

- Personnalisation des colonnes et des onglets

- Filtrage des données

- Statistiques du site technique

- Statistiques de référencement

- Custom Filters

- Custom Search

- Grattage de données

- Vérification de l'unicité du contenu

- Vérification de la vitesse de chargement des pages

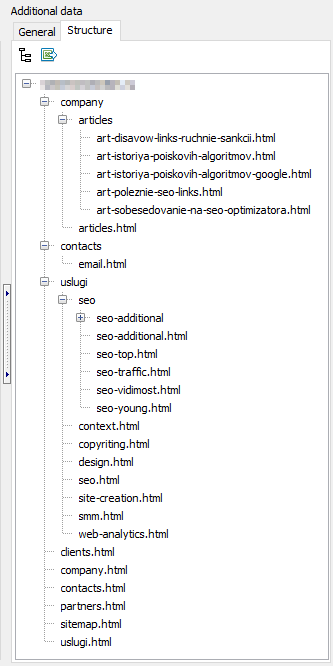

- La structure du site

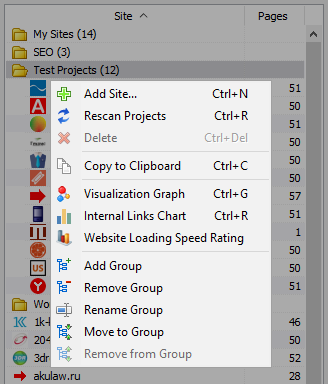

- Menu contextuel de la liste des projets

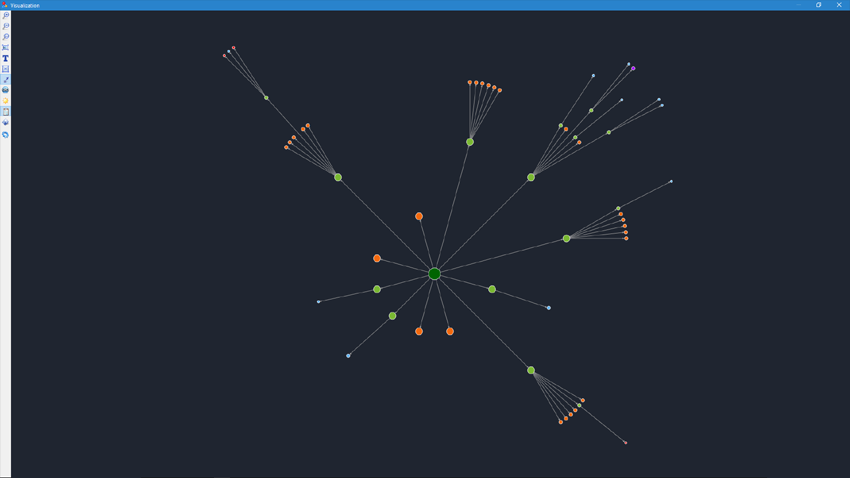

- Visualisation de la structure du site

- Graphique de distribution des liens internes

- Graphique de la vitesse de chargement de la page

- Génération Sitemap.xml

- Analyse arbitraires URL

- Dashboard

- L'exportation des données

- Multilingue

- Compression de base de données

Le début des travaux

Lorsque vous exécutez le programme est disponible à l'utilisateur de la barre d'adresse, saisissez l'URL analysé le site (vous pouvez entrer n'importe quelle page du site, de sorte que le robot de recherche, en passant par les liens de la page d'origine contournera l'ensemble du site, y compris la page d'accueil, à condition que tous les liens sont remplies dans le HTML et n'utilisent pas de Javascript).

Après avoir cliqué sur le bouton "Start", le robot commence à parcourir les pages du site sur les liens (vers des ressources externes, il ne passe pas, aussi ne passe pas sur les liens, mises en Javascript).

Après que le robot remplacera toutes les pages du site est accessible du rapport, réalisé sous la forme d'une table et affiche les données regroupées par thématiques onglets.

Tous analysées projets s'affichent dans la partie gauche du programme et sont automatiquement enregistrées dans la base du programme avec des données obtenues. Pour supprimer des sites, utilisez le menu contextuel de la liste des projets.

Remarque:

- lorsque vous appuyez sur la touche "Pause", analyse le projet est suspendu, en parallèle de l'état d'avancement de la numérisation est enregistré dans la base, ce qui permet, par exemple, de fermer le programme et de poursuivre l'analyse du projet après le redémarrage du programme avec arrêt

- le bouton "Stop" interrompt l'analyse du projet en cours sans possibilité de poursuivre son analyse

Les paramètres du programme

La section du menu principal "Réglages" est conçu pour des réglages de programme de travail avec des sites externes et contient 7 onglets:

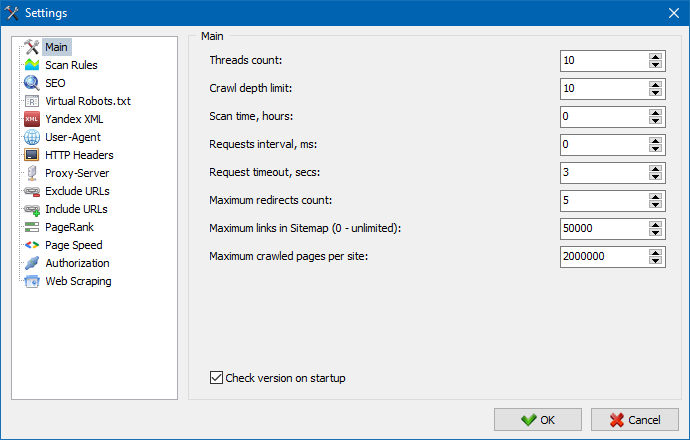

La section paramètres de base permet de spécifier le programme personnalisé de directives utilisées lors de la numérisation d'un site.

Description des paramètres:

- Le nombre de threads

- Plus le nombre de threads, plus l'URL pourra traiter par unité de temps. Ce faisant, il faut tenir compte que le plus grand nombre de threads mène à un plus grand nombre de ressources PC. Il est recommandé de définir le nombre de threads dans la gamme de 5 à 10.

- Le temps de balayage

- Permet de restreindre l'analyse du site par le temps. Mesurée en heures.

- La profondeur maximale

- Ce paramètre permet de spécifier la profondeur de l'analyse du site. Page d'accueil d'un site a un niveau d'imbrication = 0. Par exemple, si vous souhaitez analyser les pages du site, du type "somedomain.ru/catalog.html" et "somedomain.ru/catalog/tovar.html" dans ce cas, il est nécessaire d'exposer la valeur de la profondeur maximale = 2.

- Le délai entre la demande

- Sert pour l'installation des pauses lors des appels de l'analyseur de pages du site. Il est souvent nécessaire pour les sites de "faibles" hébergement, ne peuvent supporter des charges importantes et fréquentes à lui demandes.

- Délai d'attente de requête

- Réglage de la durée d'attente de la réponse du site à la demande du programme. Si certaines pages du site répondent lentement (longues à charger), l'analyse d'un site peut prendre un temps assez long. Ces pages, vous pouvez ajuster, en spécifiant la valeur, après lequel le scanner à la numérisation des autres pages du site, et donc de ne pas retarder les progrès.

- Le nombre de numériser des pages du site

- La limitation sur le nombre des pages à numériser. Il peut être utile si, par exemple, vous avez besoin de scanner les pages du site (ne tenant pas compte des images, des fichiers de style, scripts et autres types de fichiers).

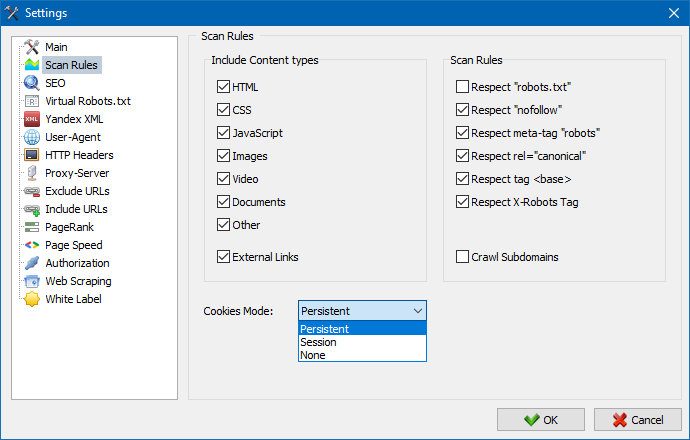

Prendre en compte le contenu

- Dans cette section, vous pouvez sélectionner les types de données qui seront prises en compte parser lors de l'analyse des pages (images, des vidéos, des styles, des scripts), ou d'expulser l'excès d'informations lors de l'analyse grammaticale.

Les règles de numérisation

- Les données de configuration liés aux paramètres d'exceptions lors de l'analyse du site сканнером utilisant le fichier "robots.txt", sur les liens de type "nofollow", et également à l'aide de la directive "meta name= "robots" directement dans le code des pages du site.

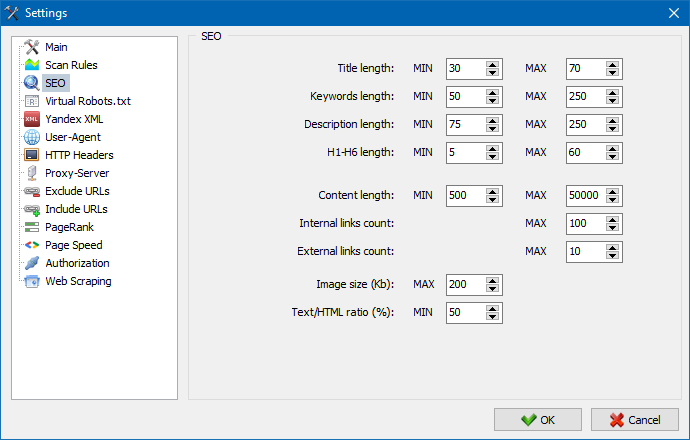

Cette section sert à indiquer les principaux analysés les paramètres de SEO, qui seront ensuite analysés à l'exactitude lors de l'analyse grammaticale de pages, après quoi obtenu les statistiques seront affichées dans l'onglet "Statistiques de RÉFÉRENCEMENT" dans la partie droite de la fenêtre principale du programme.

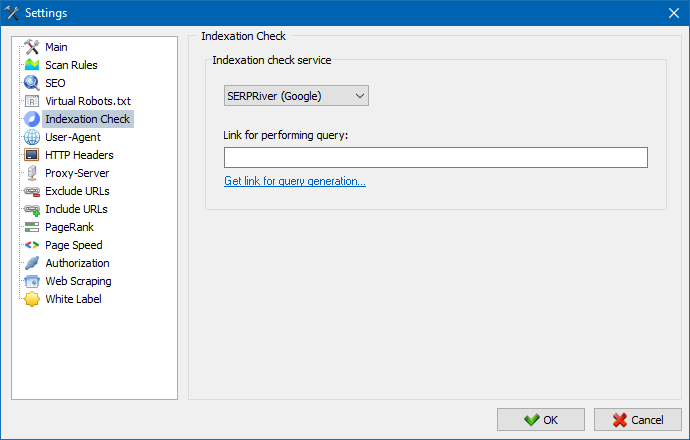

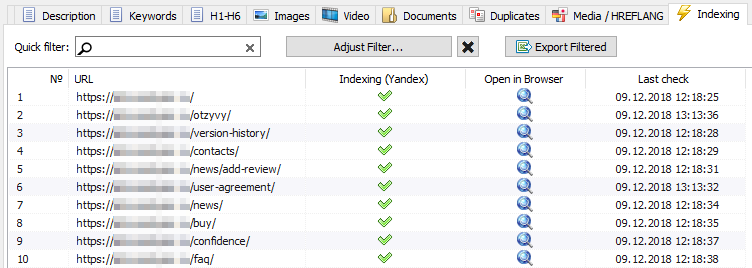

À l'aide de ces paramètres, vous pouvez choisir un service grâce auquel vous pourrez vérifier l'indexation des pages dans le moteur de recherche Yandex. Il existe deux options pour vérifier l'indexation: en utilisant le service XML Yandex ou le service Majento.ru.

Lors du choix du service Yandex XML, vous devez prendre en compte les éventuelles restrictions (horaires ou journalières) applicables lors de la vérification de l'indexation des pages concernant les limites existantes de votre compte Yandex. Il peut en résulter des situations dans lesquelles les limites de votre compte ne seront pas suffisantes. pages à la fois et pour cela, vous devez attendre la prochaine heure.

Lorsque vous utilisez le service Majento.ru, les restrictions horaires ou journalières sont pratiquement inexistantes, car votre limite se confond littéralement avec le groupe général de limites, ce qui n'est pas petit en soi, mais comporte également une limite beaucoup plus grande avec des restrictions horaires que tout compte d'utilisateur individuel sur Yandex XML.

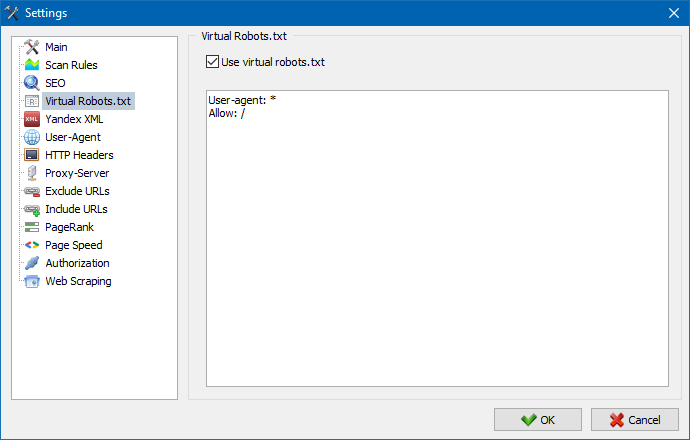

Les robots.txt virtuels peuvent être utilisés à la place du vrai robots.txt hébergé sur le site.

Ceci est utile lors du test d'un site, lorsque, par exemple, vous devez explorer certaines sections du site qui sont fermées à l'indexation (ou vice versa - ne les prenez pas en compte lors de l'exploration), alors que vous n'avez pas besoin de faire physiquement modifications apportées au vrai robots.txt et passez le temps du développeur là-dessus.

Remarque : lors de l'import d'une liste d'URL, les directives du robots.txt virtuel sont prises en compte (si cette option est activée), sinon aucun robots.txt n'est pris en compte pour la liste d'URL.

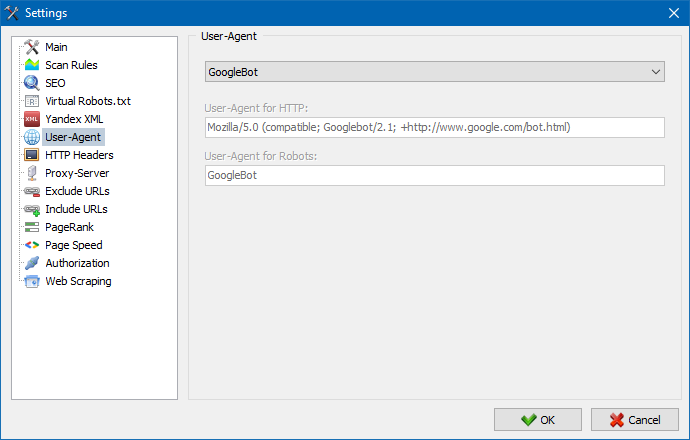

Dans la section User-Agent, vous pouvez spécifier quels uzer-l'agent sera soumis à un programme lorsque vous accédez à des sites externes lors de leur numérisation. Par умочанию, est personnalisé uzer-agent, mais si nécessaire, vous pouvez choisir l'un des agents, le plus souvent internet. Parmi eux, il y tels que: les robots des moteurs de recherche YandexBot, GoogleBot, MicrosoftEdge, les robots de google Chrome, Firefox, IE8, ainsi que les appareils mobiles iPhone, Android et bien d'autres.

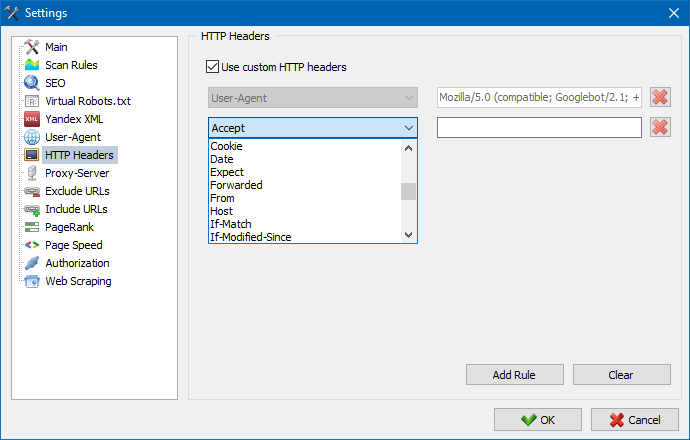

Grâce à cette option, vous pouvez analyser la réaction du site et des pages aux différentes demandes. Par exemple, quelqu'un peut avoir besoin d'envoyer un référent dans une requête, les propriétaires de sites multilingues veulent transmettre Accept-Language | Charset | Encoding, et quelqu'un a besoin de transmettre des données inhabituelles dans les en-têtes Accept-Encoding, Cache-Control, Pragma , etc.

Grâce à cette option, vous pouvez analyser la réaction du site et des pages aux différentes demandes. Par exemple, quelqu'un peut avoir besoin d'envoyer un référent dans une requête, les propriétaires de sites multilingues veulent transmettre Accept-Language | Charset | Encoding, et quelqu'un a besoin de transmettre des données inhabituelles dans les en-têtes Accept-Encoding, Cache-Control, Pragma , etc.

Si il ya une nécessité de travailler à travers un proxy, dans cette section, vous pouvez ajouter une liste de serveurs proxy, qui fera appel à des ressources externes. Avancé, il est possible de vérifier le proxy sur le fonctionnement, ainsi que la fonction de supprimer les serveurs proxy.

Cette section est conçue pour exclure le contournement de certaines pages et rubriques du site, lors de l'analyse grammaticale.

Utilisation des modèles de recherche * et ? vous pouvez spécifier quelles sections du site ne doivent pas être explorées par le robot et, par conséquent, ne doivent pas être incluses dans la base de données du programme. Cette liste est une liste locale des exceptions au cours de la numérisation d'un site rapport "global" de la liste est un fichier "robots.txt" dans la racine du site).

De même, vous permet d'ajouter des URL à analyser. Dans ce cas, toutes les autres URL en dehors de ces dossiers seront ignorées lors de l'analyse. Cette option fonctionne également avec les modèles de recherche * et ?

À l'aide du paramètre PageRank, vous pouvez analyser la structure de navigation de vos sites et optimiser le système de liens internes d'une ressource Web afin de transmettre le poids de référence aux pages les plus importantes.

Le programme dispose de deux options pour calculer le PageRank: l'algorithme classique et son équivalent plus moderne. En général, pour l’analyse des liens internes du site, l’utilisation du premier ou du second algorithme n’a guère de différence, vous pouvez donc utiliser l’un ou l’autre des algorithmes.

Une description détaillée de l'algorithme et des principes de calcul du classement PageRank se trouve dans l'article "Calcul du classement PageRank interne": >>

Entrez l'identifiant et le mot de passe pour l'autorisation automatique sur les pages fermées via .htpasswd et protégées par l'autorisation du serveur BASIC.

Le travail avec le programme

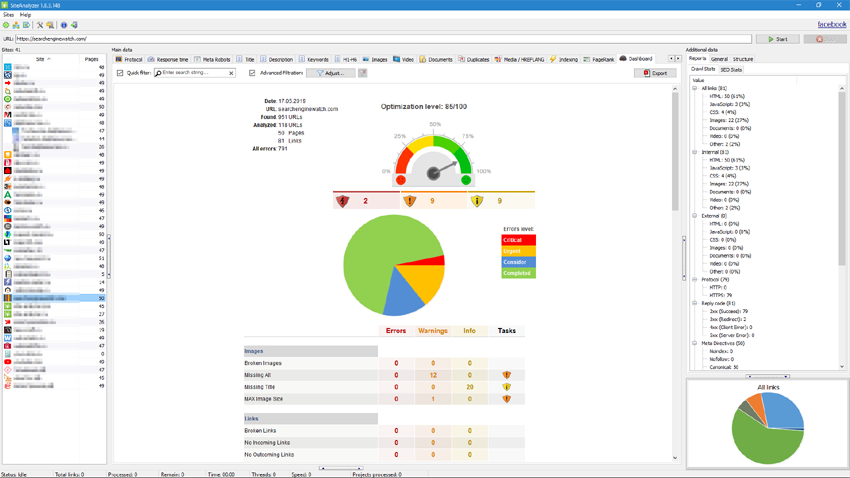

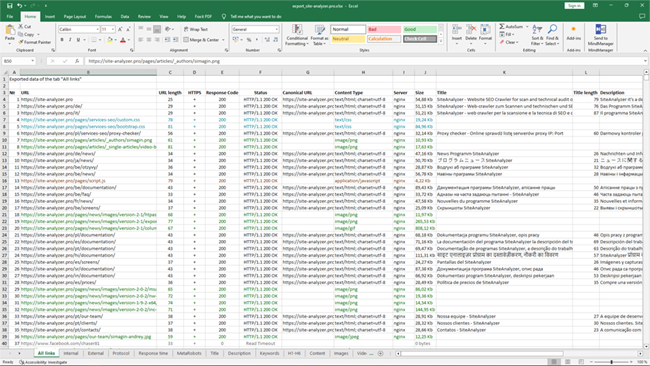

La numérisation terminée, l'utilisateur est disponible, les informations contenues dans le bloc "données de Base". Chaque onglet contient des données regroupées sur leurs noms (par exemple, l'onglet "Title" contient le contenu des en-têtes de page <title></title>, onglet "Images" contient la liste de toutes les images du site et ainsi de suite). Avec l'aide de ces données, vous pouvez procéder à une analyse de contenu de site, de trouver un "cassée" liens ou mal remplis de méta-tags.

Si nécessaire (par exemple, après avoir effectué des modifications sur le site) avec le menu contextuel de la possibilité d'une nouvelle analyse d'URL pour afficher les modifications dans le programme.

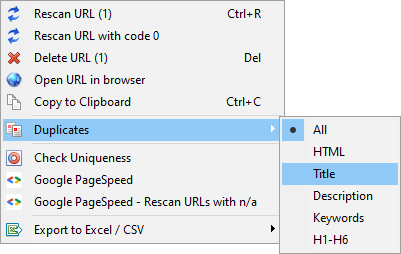

Avec l'aide de ce menu, vous pouvez afficher les doubles pages de paramètres correspondants (end title, description, keywords, h1, h2, le contenu de pages web).

L'élément "Rescan URL avec le code 0" est conçu pour revérifier automatiquement toutes les pages qui donnent un code de réponse 0 (délai de lecture). Ce code de réponse est généralement donné lorsque le serveur n'a pas le temps de fournir du contenu et que la connexion est fermée par expiration, respectivement, la page ne peut pas être chargée et les informations qui en découlent ne peuvent pas être extraites.

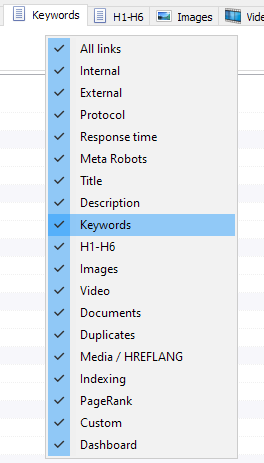

Personnalisation des colonnes et des onglets

Maintenant, vous pouvez sélectionner les onglets ne sont pas affichées dans l'interface de base de données (enfin, il est devenu possible de dire au revoir à moralement obsolète l'onglet Meta Keywords). Cette fonction est pratique si taba ne tiennent pas sur l'écran, ou vous rarement les utilisez.

Les colonnes vous pouvez également masquer ou déplacer au bon endroit en les faisant glisser.

L'affichage de la tabs et de colonnes, vous pouvez configurer à l'aide d'un menu contextuel de la barre de base de données. La migration des colonnes s'effectue par le biais de la souris.

Pour faciliter l'analyse des statistiques du site dans le programme disponible filtrage des données. Le filtrage est possible de deux façons:

- tous les champs à l'aide de "rapide" du filtre

- à l'aide d'un filtre personnalisé (à l'aide des paramètres avancés de l'échantillon de données)

Filtre rapide

Utilisé pour le filtrage rapide des données et s'applique à tous les champs de l'onglet en cours.

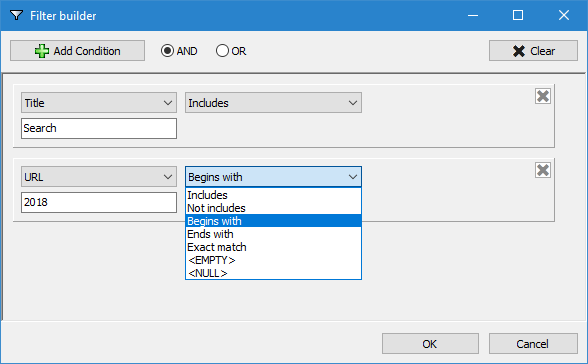

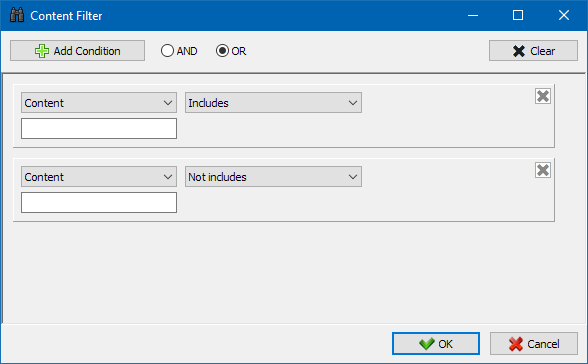

Un filtre personnalisé

Conçu pour les détails de la filtration et peut contenir plusieurs conditions. Par exemple, pour la balise meta "title" vous allez filtrer les pages de leur longueur, afin de ne pas dépasser 70 caractères et simultanément contenait le texte de "nouvelles". Alors ce filtre va ressembler:

Par conséquent, en appliquant un filtre personnalisé à n'importe quel onglet, vous pouvez recevoir un échantillon de données de n'importe quelle complexité.

Statistiques du site technique

L’onglet Statistiques techniques du site se trouve dans le panneau Données supplémentaires et contient un ensemble de paramètres techniques de base du site: statistiques sur les liens, balises méta, codes de réponse de page, paramètres d’indexation de page, types de contenu, etc. paramètres.

En cliquant sur l'un des paramètres, ils sont automatiquement filtrés dans l'onglet correspondant des données de base du site et, en même temps, des statistiques sont affichées sur le diagramme en bas de la page.

L'onglet Statistiques de référencement est destiné à la réalisation d'audits de site complets. Il contient plus de 50 paramètres principaux de référencement et identifie plus de 60 erreurs d'optimisation internes clés! Le mappage des erreurs est divisé en groupes, qui contiennent à leur tour des ensembles de paramètres analysés et des filtres qui détectent les erreurs sur le site.

Une description détaillée de tous les paramètres vérifiés se trouve dans cet article. >>

Pour tous les résultats de filtrage, il est possible de les exporter rapidement vers Excel sans dialogues supplémentaires (le rapport est enregistré dans le dossier du programme).

Sur cet onglet sont placés des filtres prédéfinis qui vous permettent de créer un échantillon de tous les liens externes, les erreurs 404, des images et d'autres paramètres de toutes les pages sur lesquelles ils sont présents. Donc, maintenant, vous pouvez facilement et rapidement pour obtenir la liste des liens externes et des pages sur lesquelles ils sont placés, soit de sélectionner tous les liens rompus et de voir immédiatement quelles sont les pages qu'ils se trouvent.

Tous les rapports sont disponibles dans le programme en ligne et s'affichent sur l'onglet "Custom" de la barre de base de données. En outre, il ya la possibilité de les exporter dans Excel via le menu principal.

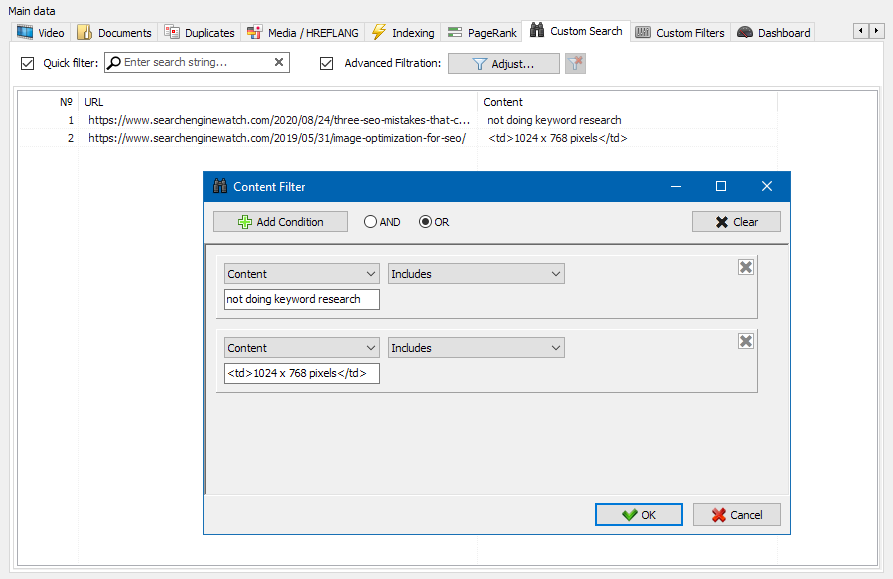

La fonction de recherche de contenu de site vous permet de rechercher dans le code source et d'afficher des pages Web contenant le contenu que vous recherchez.

Le module de filtres personnalisés vous permet de vérifier la présence de micro-balisage, de méta-balises, de systèmes d'analyse, de fragments de texte libre ou de code HTML sur le site.

Dans la fenêtre de configuration du filtre, il existe plusieurs paramètres pour rechercher certains fragments de texte sur les pages du site ou, au contraire, pour exclure les pages contenant certains fragments de texte ou de code HTML des résultats de recherche (cette fonction est similaire à la recherche de contenu dans le code source d'une page en utilisant Ctrl-F)...

En règle générale, le grattage est utilisé pour résoudre des tâches difficiles à gérer manuellement. Cela peut être l'extraction de descriptions de produits pour créer une nouvelle boutique en ligne, le grattage d'études marketing pour surveiller les prix ou pour surveiller les publicités.

Dans SiteAnalyzer, le scraping est configuré dans l'onglet Data Extraction, où les règles d'extraction sont configurées. Les règles peuvent être enregistrées et, si nécessaire, modifiées.

Il existe également un module de test de règles. À l'aide du débogueur de règles intégré, vous pouvez obtenir rapidement et facilement le contenu HTML de n'importe quelle page du site et tester le travail des requêtes, puis utiliser les règles déboguées pour analyser les données dans SiteAnalyzer.

Une fois l'extraction des données terminée, toutes les informations collectées peuvent être exportées vers Excel.

Pour une étude plus détaillée du fonctionnement du module et une liste des règles et expressions régulières les plus courantes, consultez l'article

Vérification de l'unicité du contenu

Cet outil vous permet de rechercher les pages en double et de vérifier l'unicité des textes au sein du site. En d'autres termes, il s'agit d'une vérification par lots d'un groupe d'URL pour l'unicité entre elles.

Cela peut être utile dans les cas suivants :

- Pour rechercher des pages dupliquées complètes (par exemple, une page avec des paramètres et la même page, mais dans la vue CNC).

- Pour rechercher des correspondances partielles de contenu (par exemple, deux recettes de bortsch dans un blog culinaire, qui se ressemblent à 96%, ce qui suggère que l'un des articles doit être supprimé afin de se débarrasser d'une éventuelle cannibalisation du trafic).

- Lorsque, sur un site d'articles, vous avez accidentellement écrit un article sur un sujet que vous avez déjà écrit il y a 10 ans. Dans ce cas, notre outil détectera également un doublon d'un tel article.

Le principe de l'outil de vérification de l'unicité des contenus est simple : le programme télécharge leur contenu à partir de la liste des URL du site, reçoit le contenu texte de la page (sans le bloc HEAD et sans balises HTML), puis les compare avec chacun autre en utilisant l'algorithme de shingle.

Ainsi, à l'aide de bardeaux, nous déterminons l'unicité des pages et pouvons calculer à la fois des doublons complets de pages avec 0% d'unicité et des doublons partiels avec divers degrés d'unicité du contenu du texte. Le programme fonctionne avec une longueur de bardeau de 5.

Vous pouvez en savoir plus sur le fonctionnement du module dans cet article.: >>

Vérification de la vitesse de chargement des pages

L'outil PageSpeed Insights du géant de la recherche Google vous permet de vérifier la vitesse de chargement de certains éléments de la page et affiche également le score global de vitesse de chargement des URL d'intérêt pour les versions de bureau et mobile du navigateur.

L'outil de Google est bon pour tout le monde, cependant, il présente un inconvénient important - il ne vous permet pas de créer des vérifications d'URL de groupe, ce qui crée des inconvénients lors de la vérification de nombreuses pages de votre site : acceptez que vérifier manuellement la vitesse de téléchargement pour 100 URL ou plus sur une page est une corvée et peut prendre beaucoup de temps.

Par conséquent, nous avons créé un module qui vous permet de créer gratuitement des contrôles de groupe de la vitesse de chargement des pages via une API spéciale dans l'outil Google PageSpeed Insights.

Principaux paramètres analysés :

- FCP (First Contentful Paint) – le temps d'afficher le premier contenu.

- SI (Speed Index) – un indicateur de la rapidité avec laquelle le contenu est affiché sur une page.

- LCP (Largest Contentful Paint) – temps d'affichage du plus grand élément de la page.

- TTI (Time to Interactive) – le temps pendant lequel la page devient entièrement prête pour l'interaction de l'utilisateur.

- TBT (Total Blocking Time) – entre le premier rendu du contenu et sa préparation à l'interaction avec l'utilisateur.

- CLS (Cumulative Layout Shift) – décalage de mise en page cumulatif. Sert à mesurer la stabilité visuelle de la page.

Dans le même temps, l'analyse de l'URL elle-même s'effectue en quelques clics, après quoi un rapport peut être téléchargé, comprenant les principales caractéristiques des contrôles sous une forme pratique dans Excel.

Tout ce dont vous avez besoin pour commencer est d'obtenir une clé API.

Comment faire cela est décrit dans cet article. >>

Le portail est conçu pour créer la structure d'un site sur la base des données. La structure du site est généré sur la base de l'imbrication de l'adresse de la page. Après la génération de la structure est disponible exportation en format CSV (Excel).

Menu contextuel de la liste des projets

- Dans la liste des projets est disponible à la numérisation de masse à travers l'allocation de bons sites et cliquez sur le bouton "Analyser". Après cela, tous les sites sont dans la file d'attente et sont analysés en alternance en mode standard.

- Aussi, pour le confort de travail avec le programme, la suppression en masse des sites sélectionnés est également disponible sur le bouton "Supprimer".

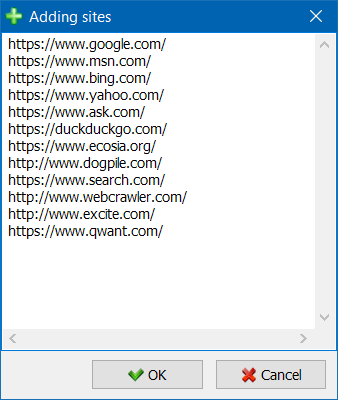

- En plus de l'unité d'analyse de sites web, il ya la possibilité de la masse pour ajouter des sites à la liste des projets à l'aide d'un formulaire spécial, après quoi l'utilisateur peut analyser vos projets entiers.

- Pour une navigation plus pratique dans la liste des projets, il est possible de regrouper les sites par dossiers, ainsi que de filtrer la liste des projets par nom.

Visualisation de la structure du site

Le mode de visualisation des liens sur le graphique vous aidera à SEO-à un expert d'évaluer la distribution interne du PageRank des pages du site, ainsi que de comprendre les pages d'obtenir la plus grande masse référentielle (et en conséquence, plus interne de référence de poids dans les yeux des moteurs de recherche), et comment les pages et les sections du site ne suffit pas de liens internes.

Grâce au mode de visualisation de la structure d'un site de RÉFÉRENCEMENT est le spécialiste sera en mesure d'évaluer clairement ce, à l'organisation interne de liaison sur le site, ainsi que par la présentation visuelle de la masse PageRank affectée à une ou l'autre des pages, faire rapidement des ajustements en cours reliant site et ainsi améliorer la pertinence des pages qui les intéressent.

Dans la partie gauche de la fenêtre de rendu, sont les outils de base pour travailler avec le comte:

- le changement d'échelle sur le graphique

- la rotation du comte de l'angle arbitraire

- la commutation de la fenêtre de graphe en mode plein écran (fonctionne également avec la touche F11)

- afficher / masquer les signatures à des sites (Ctrl-T)

- afficher / masquer les flèches dans les lignes

- afficher / masquer les liens externes (Ctrl-E)

- changement de mode de couleurs Jour / Nuit (Ctrl-D)

- afficher / masquer la légende et de la statistique du comte (Ctrl-L)

- la conservation d'un graphique dans le format PNG (Ctrl-S)

- la fenêtre des paramètres de rendu (Ctrl-O)

La section "Vue" est conçu pour modifier le format d'affichage des nœuds sur un graphique. Dans le mode de dessin d'hôtes "PageRank", les dimensions de nœuds sont installés sur leur précédemment calculé l'indicateur de PageRank, résultant sur un graphique, vous pouvez clairement voir les pages reçoivent plus de la référence du poids, et comment va le moins de liens.

Dans le mode classique dimensions sites sont configurés concernant le zoom du comte de rendu.

Graphique de distribution des liens internes

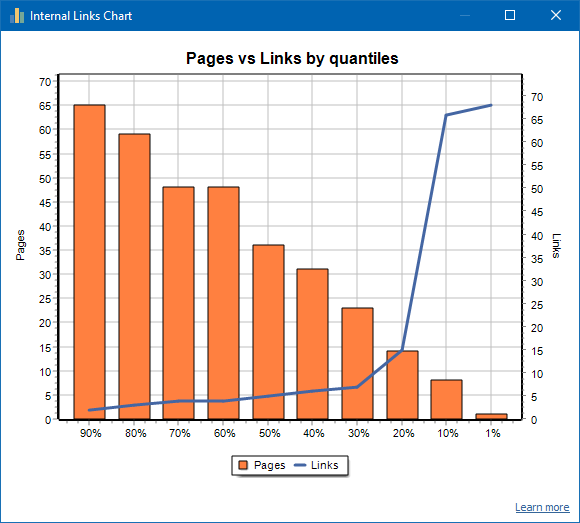

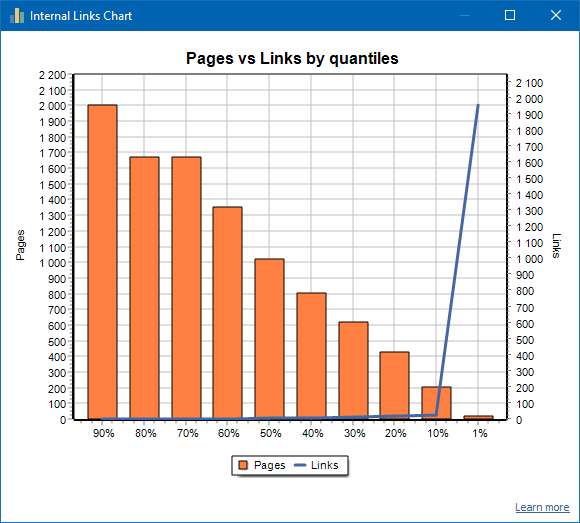

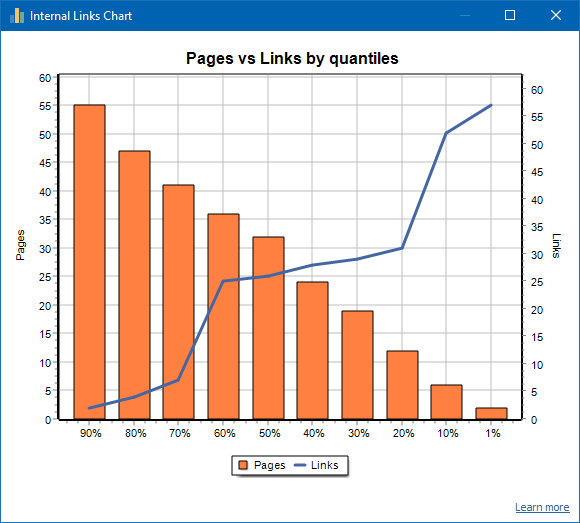

Ce graphique montre la distribution de la masse des liens internes sur les pages du site (on peut dire qu'il s'agit d'une visualisation du lien sous une forme visuelle, plutôt que d'être présenté sur le graphique de visualisation). Lire plus >>

À gauche, le nombre de pages, à droite le nombre de liens. Vous trouverez ci-dessous les quantiles de pourcentage par page. Lors de l'élaboration d'un graphique, les liens en double sont supprimés (s'il y a 3 liens de la page A à la page B, nous les comptons comme un).

Par exemple, d'après la capture d'écran ci-dessus, pour un site d'environ 70 pages:

- 1% les pages ont ~68 liens entrants.

- 10% les pages ont ~66 liens entrants.

- 20% les pages ont ~15 liens entrants.

- 30% les pages ont ~8 liens entrants.

- 40% les pages ont ~7 liens entrants.

- 50% les pages ont ~6 liens entrants.

- 60% les pages ont ~5 liens entrants.

- 70% les pages ont ~5 liens entrants.

- 80% les pages ont ~3 liens entrants.

- 90% les pages ont ~2 liens entrants.

Autrement dit, si nous voyons que nous avons des pages auxquelles mènent moins de 10 liens entrants, nous pouvons considérer ces pages comme faiblement liées, et nous avons 60% des pages normalement liées. Sur cette base, nous pouvons soit mettre plus de liens internes vers ces pages faiblement liées (si les pages sont importantes pour la promotion), soit les laisser telles quelles, si ces pages sont de faible importance et de faible priorité.

En pratique générale, les pages contenant moins de 10 liens internes sont moins susceptibles d'être explorées par les robots des moteurs de recherche, en particulier les robots Google.

Par conséquent, si vous voyez un site qui n'a que 20 à 30% de pages normalement liées par rapport au nombre total de pages sur le site, il est logique de se plonger dans le paramètre de liaison ou de réfléchir à la façon de traiter ces 80 à 70% de pages faiblement liées (supprimer, masquer de indexation, mettre des redirections).

Un exemple de site faiblement lié:

Un exemple de site bien lié:

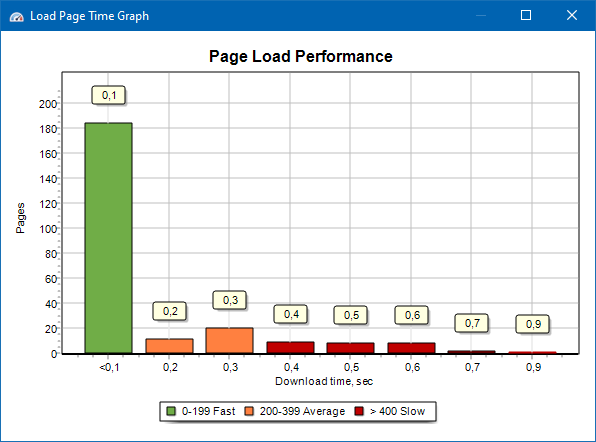

Graphique de la vitesse de chargement de la page

Le graphique de vitesse de chargement des pages vous permet d'évaluer les performances du site. Pour plus de clarté, les pages sont divisées en groupes et intervalles de temps avec un pas de 100 millisecondes.

Ainsi, sur la base du graphique, vous pouvez déterminer quelle proportion de pages de site sont chargées rapidement (entre 0 et 100 millisecondes), lesquelles à une vitesse moyenne (100 à 200 millisecondes) et quelles pages sont chargées suffisamment longtemps (400 millisecondes ou plus).

Remarque: Le temps indiqué est le temps de chargement du code source HTML, pas le temps de chargement complet des pages (le rendu de page, ainsi que le chargement des éléments de page, tels que les images et les styles, ne sont pas pris en compte).

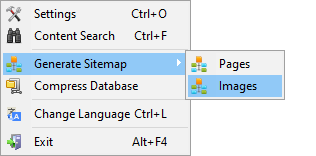

Génération Sitemap.xml

Le plan du site est généré sur la base des pages explorées ou des images du site.

- Lors de la génération d'un plan de site constitué de pages, des pages au format "texte / html" y sont ajoutées.

- Lors de la génération d'un plan de site composé d'images, des images JPG, PNG, GIF et similaires y sont ajoutées.

Générer la carte du site, vous pouvez immédiatement après la numérisation du site, via le menu principal: Projets -> Générer un Sitemap".

Pour les sites de grandes quantités de 50 000 pages, une fonction de partitionnement automatique "sitemap.xml" sur plusieurs fichiers (dans ce cas, le fichier principal contient des liens vers d'autres contenant directement les liens sur la page du site). Cela est dû aux exigences des moteurs de recherche pour le traitement des fichiers sitemap de grandes dimensions.

Le cas échéant, la quantité de pages dans le fichier "sitemap.xml" on peut varier, en modifiant la valeur de 50 000 (valeur par défaut) sur la valeur souhaitée dans les réglages de base du programme.

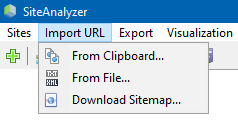

Analyse arbitraires URL

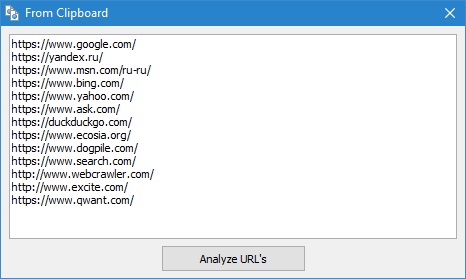

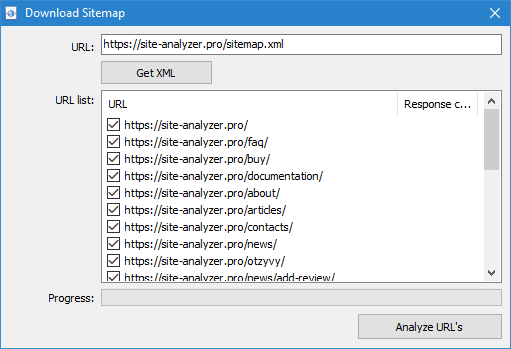

L'option de menu "Import URL" est conçu pour la numérisation arbitraires listes d'URL, ainsi que XML-carte du site Sitemap.xml (y compris index) pour leur analyse ultérieure.

Analyse arbitraires URL possible de trois manières:

- par l'insertion de la liste des URL à partir du presse-papiers

- charger à partir du disque dur les fichiers au format *.txt et *.xml contenant des listes d'URL

- par le téléchargement d'un fichier Sitemap.xml directement à partir du site

Une caractéristique de ce mode est que lors de la numérisation arbitraires URL-même "projet" n'est pas enregistré dans le programme et les données ne sont pas ajoutées à la base. Aussi ne sont pas disponibles, les sections de la Structure du site" et "Дашборд".

Se familiariser avec le travail du paragraphe "Importer une URL de cet article: Présentation de la nouvelle version de SiteAnalyzer 1.9.

Dashboard

L'onglet "Dashboard", affiche un rapport détaillé sur l'actuel comme l'optimisation du site. Le rapport est généré sur la base de données de l'onglet "Statistiques de RÉFÉRENCEMENT". Au-delà de ces données dans un rapport, une indication générale de l'indicateur de qualité de l'optimisation du site garanti calculé sur 100 points de l'échelle par rapport à la mesure de son optimisation. Il est possible d'exporter les données de l'onglet "Dashboard", dans un rapport au format PDF.

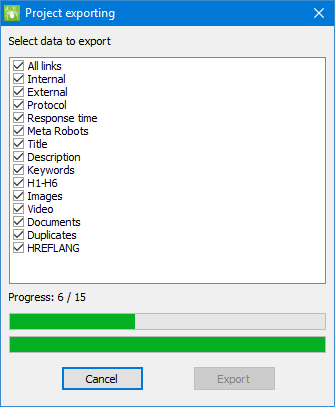

L'exportation des données

Pour plus de souplesse de l'analyse des données et la possibilité de les télécharger dans un format CSV (exporté actuelle de l'onglet actif), ainsi que la production complète d'un rapport dans Microsoft Excel avec tous les onglets dans un seul fichier.

Lorsque vous exportez des données dans Excel, vous recevez une fenêtre dans laquelle l'utilisateur peut sélectionner vos colonnes et ensuite de générer un rapport avec les données nécessaires.

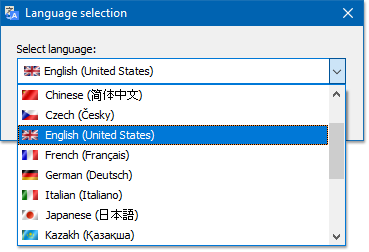

Multilingue

Le programme offre la possibilité de sélectionner la langue préférée, sur lequel sera effectué le travail.

Les principales langues prises en charge: anglais, russe, allemand, italien, espagnol, français... en ce moment le programme est traduit en plus de quinze (15) langues les plus populaires.

Si vous voulez traduire le programme dans votre langue maternelle, pour ce faire, il suffit de transférer n'importe quel fichier "*.lng" sur votre langue, après quoi traduit le fichier que vous souhaitez envoyer à l'adresse "support@site-analyzer.pro" (les commentaires à la lettre doivent être rédigés en russe ou en anglais) et votre traduction sera inclus dans la nouvelle version du programme.

Pour de plus amples instructions sur la traduction des programmes dans les langues se trouve dans la distribution (fichier "lcids.txt").

P.S. Si vous avez des remarques sur la qualité de la traduction de vos observations et des correctifs "support@site-analyzer.ru".

Compression de base de données

Le point du menu principal "Compacter une base de données" est conçu pour effectuer les opérations de conditionnement de la base de données (service de base précédemment supprimés de projets, ainsi que l'organisation des données (analogue de la défragmentation des données sur les ordinateurs personnels)).

Cette procédure est efficace dans le cas où, par exemple, du programme a été supprimé d'un grand projet, contenant un grand nombre d'enregistrements. En général, il est recommandé d'effectuer périodiquement et compression de données pour se débarrasser de la redondance des données et la réduction du volume de base.

Les réponses aux autres questions, vous pouvez consulter la section FAQ >>